Best-of-N Jailbreak: una simple transformación aleatoria de la entrada y repetidos intentos de conseguir que los sistemas de IA dominantes se salten las restricciones de seguridad para producir respuestas dañinas.

Base de conocimientos de IAActualizado hace 1 año Círculo de intercambio de inteligencia artificial 38.7K 00

En los últimos años, con el rápido desarrollo de la IA Generativa (GAI) y los Grandes Modelos Lingüísticos (LLM), las cuestiones de su seguridad y fiabilidad han atraído mucha atención. Un estudio reciente ha descubierto un nuevo tipo de LLM conocido como Lo mejor de N Jailbreak (abreviado BoN) en un método de ataque sencillo pero eficaz. Al modificar aleatoriamente el contenido de entrada e intentarlo repetidamente, los investigadores burlaron con éxito las restricciones de seguridad de varios sistemas de IA convencionales, obligándoles a generar contenidos dañinos o inapropiados. Sorprendentemente, la tasa de éxito del ataque con este método oscila entre 70% y 90%, lo que pone de manifiesto la gran vulnerabilidad de los actuales mecanismos de seguridad de la IA.

Principios básicos del enfoque de la RdD

La idea central del método Best-of-N jailbreak es encontrar gradualmente entradas que puedan romper las restricciones de seguridad del sistema realizando repetidamente pequeñas deformaciones en las entradas (texto, imágenes, audio) sin necesidad de entender la estructura interna del modelo de IA. Estas deformaciones incluyen:

- entrada de texto Cambia aleatoriamente las mayúsculas y minúsculas, reordena los caracteres o añade símbolos, etc.

- entrada de imagen : Cambia los fondos, superpon texto en diferentes fuentes.

- entrada de audio : Ajusta el tono, la velocidad de reproducción o añade ruido de fondo.

Estas deformaciones no cambian la semántica básica de la entrada, pero pueden provocar una respuesta incorrecta del sistema de IA en algunos casos. Mediante repetidos intentos, los investigadores lograron encontrar un "morph óptimo" de entrada que inducía al modelo a generar contenidos que infringían las normas de seguridad.

Éxito del ataque y cobertura

El equipo de investigación probó varios sistemas de IA convencionales utilizando la metodología BoN, y los resultados mostraron que estos sistemas mostraban en general un alto grado de vulnerabilidad a este sencillo ataque. Ejemplo:

- GPT-4 : La deformación de entrada del 89% es capaz de romper sus límites de seguridad.

- Claude 3,5 El ataque morph de 78% tuvo éxito.

- Otros sistemas convencionales vulnerabilidades similares, aunque el porcentaje exacto de éxito varía de un sistema a otro.

La tasa de éxito de los ataques BoN es significativamente superior a la de las técnicas tradicionales de fuga de IA, gracias a su aleatoriedad y escalabilidad. El método es especialmente eficaz en tareas de IA generativa, lo que sugiere que el diseño de seguridad de los sistemas de IA actuales carece de la robustez suficiente.

Escala y previsibilidad de los ataques

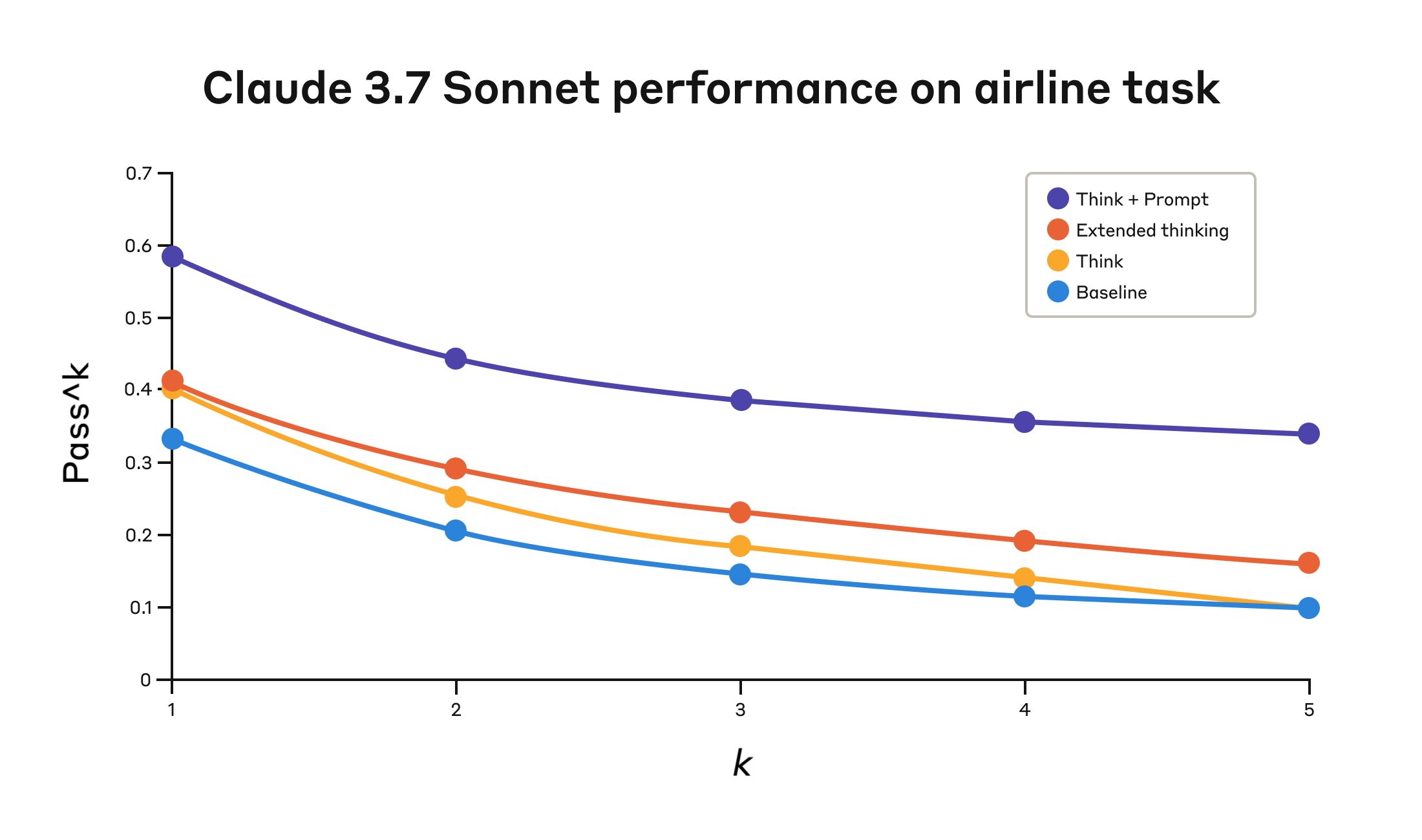

El estudio también muestra que la tasa de éxito de los ataques aumenta en una ley de potencia con el número de intentos (valor N). Esto significa que al aumentar el número de muestras o la potencia de cálculo, el método BoN es capaz de lograr mayores tasas de éxito de los ataques. Esta propiedad permite a los investigadores hacer predicciones precisas de la tasa de éxito y ajustar así la estrategia de ataque para un modelo concreto. Ejemplo:

- Para GPT-4, aumentar el número de intentos para 20% aumenta la tasa de éxito en 10%.

- Utilizando una combinación de ataques BoN y otras técnicas, el porcentaje de éxito aumenta aún más, al tiempo que se reduce el número de muestras e intentos necesarios.

Esto demuestra que el método BoN no sólo es eficiente, sino que también tiene una buena escalabilidad para lograr avances más rápidos y precisos mediante la combinación de otros métodos de ataque.

¿Por qué funciona el enfoque de la RdD?

El investigador observó que el éxito del enfoque de la RdD se debe en gran medida a lo siguiente:

- La deformación de entrada perturba el mecanismo de evaluación de la seguridad del modeloLa mayoría de los sistemas de IA se basan en características o patrones específicos de las entradas para identificar posibles amenazas. La deformación aleatoria de la BoN corrompe estas características, lo que facilita que el sistema juzgue erróneamente las entradas como seguras.

- Interacción con los modelos en modo "caja negraLa BoN no depende del conocimiento de los mecanismos internos del modelo de IA y sólo requiere una interacción externa con el sistema para llevar a cabo el ataque. Esto lo hace más operativo en la práctica.

- Aplicabilidad intermodalEl método no sólo es aplicable a la introducción de texto, sino que también es capaz de atacar modelos de lenguaje visual y modelos de procesamiento del habla. Por ejemplo, añadiendo texto a una imagen o ajustando las propiedades de un archivo de audio, los investigadores lograron burlar las normas de seguridad de estos sistemas.

Una llamada de atención sobre la seguridad de la IA

La aparición del método de fuga Best-of-N es una llamada de atención para la seguridad de los sistemas de IA. Aunque el método BoN pueda parecer sencillo, su ataque sorprendentemente eficaz demuestra que la actual protección de seguridad de los sistemas de IA sigue siendo muy vulnerable frente a amenazas no tradicionales.

Los investigadores sugieren que los desarrolladores de IA deben reforzar su seguridad de las siguientes maneras:

- Mayor robustez de entradaEl diseño de mecanismos de validación de entradas más estrictos para las deformaciones aleatorias reduce la probabilidad de que se eluda el sistema.

- Protección multimodal conjuntaCombine evaluaciones exhaustivas de texto, visuales y sonoras para mejorar la seguridad general del sistema.

- Introducción de mecanismos de prueba más avanzadosIdentificar automáticamente entradas potencialmente maliciosas mediante redes generativas adversariales (GAN) u otras técnicas avanzadas.

observaciones finales

Los resultados de la investigación sobre el método Best-of-N de fuga de la cárcel nos recuerdan que el desarrollo de la tecnología de IA no sólo debe centrarse en la mejora del rendimiento, sino que también debe hacer frente a su seguridad y fiabilidad. Solo mediante la mejora continua de los mecanismos de protección de la seguridad podrán los sistemas de IA ser realmente seguros y fiables para una amplia gama de aplicaciones.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...