Bambo: un marco ligero y flexible para organismos inteligentes, con una sencilla configuración de roles y herramientas para gestionar múltiples cargas de tareas.

Últimos recursos sobre IAPublicado hace 1 año Círculo de intercambio de inteligencia artificial 52.6K 00

Introducción general

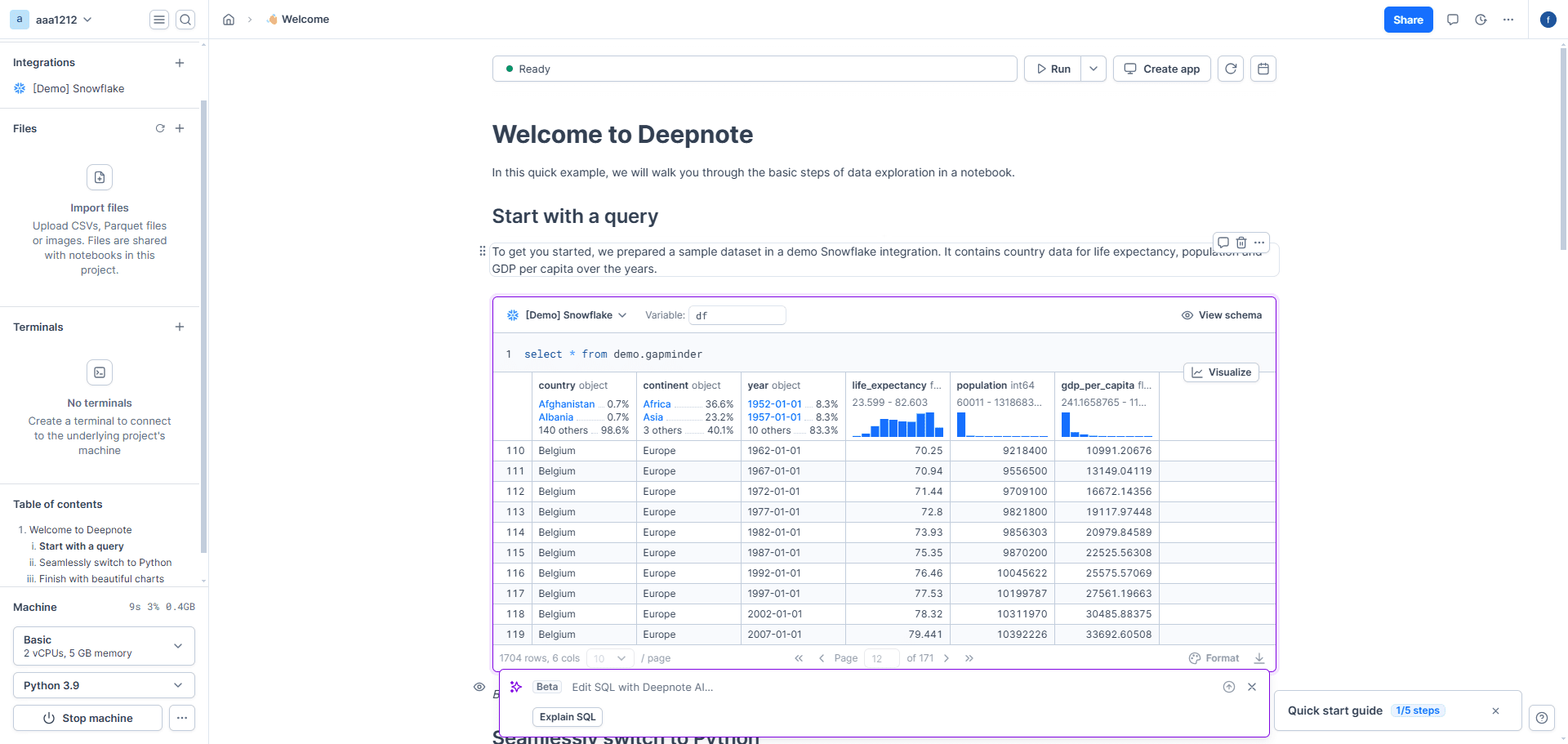

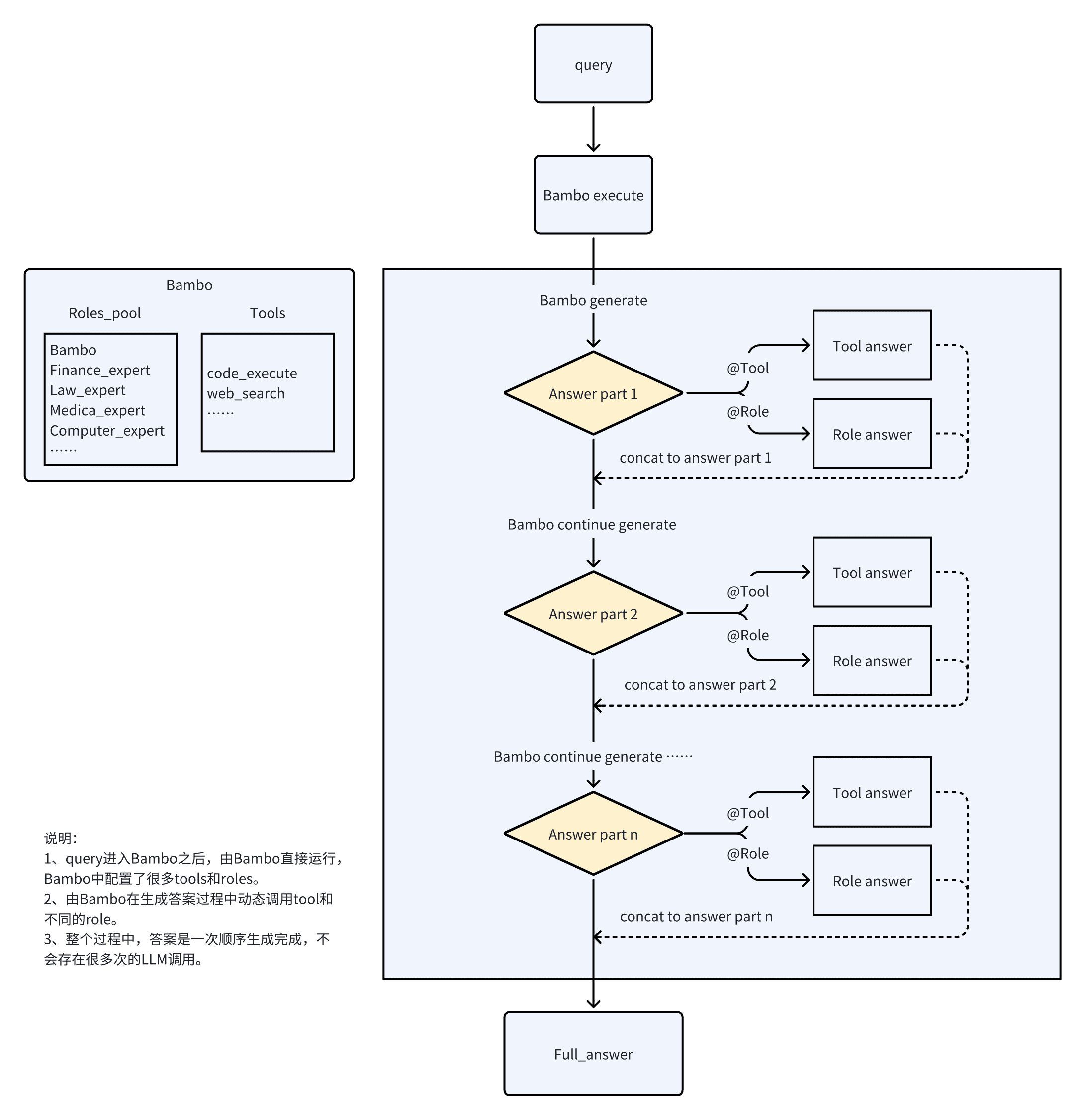

Bambo es un nuevo tipo de framework proxy más ligero y flexible que los frameworks convencionales, capaz de gestionar un amplio abanico de tareas de carga.Bambo consigue una funcionalidad proxy eficiente definiendo todas las herramientas en el catálogo de herramientas y utilizando funciones personalizadas asíncronas. Los usuarios pueden definir el modelo y los parámetros del cliente que necesitan llamar en el archivo llm_client.py y luego crear sus propios scripts de prueba en la carpeta examples.El objetivo de Bambo es proporcionar una solución proxy eficiente y flexible para una gran variedad de escenarios de aplicación.

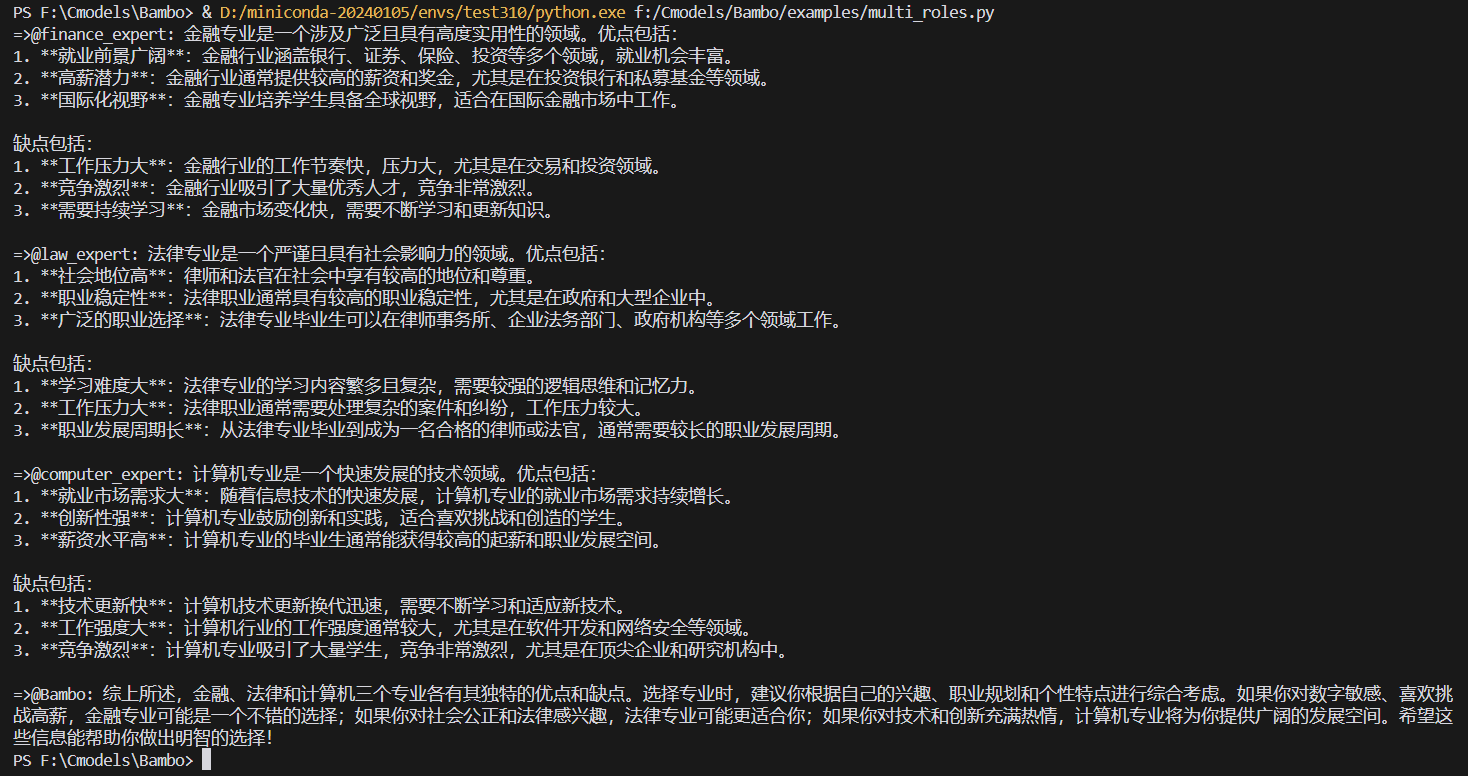

En el marco del agente tradicional, cada rol es un agente independiente, se necesita un "supervisor" para coordinar el trabajo, el cambio de rol debe pasar por un complejo proceso de traspaso, el número de llamadas LLM es relativamente alto, lo que se traduce en una velocidad de respuesta y fluidez deficientes.

Bambo resuelve este problema mediante el juego de rol. Basado en Bambo, se implementa un efecto similar de notebooklm. No hay TTS en el efecto, por lo que puedes añadir el código correspondiente en el script de prueba si es necesario.

Lista de funciones

- Marco proxy ligero y flexible

- Manejar una variedad de cargas

- Compatibilidad con funciones personalizadas asíncronas

- Definir e invocar los parámetros necesarios del modelo y del cliente

- Creación y ejecución de guiones de prueba

- Compatible con escenarios de varios caracteres

- Funciones de ejecución y análisis de código

Utilizar la ayuda

Proceso de instalación

- Almacén de clonación:

git clone https://github.com/LB-Young/Bambo.git cd Bambo - Instale la dependencia:

pip install -r requirements.txt - Instale PyTorch manualmente (si es necesario):

pip3 install torch torchvision torchaudio

Instalación y configuración

- Defina todas las herramientas en el catálogo de herramientas y asegúrese de que las funciones personalizadas sean asíncronas.

- Defina los parámetros del modelo y del cliente para las llamadas necesarias en el archivo llm_client.py.

- Cree sus propios guiones de prueba en la carpeta de ejemplos, definiendo las funciones y herramientas necesarias.

- Inicializa el objeto Bambo e introduce los parámetros necesarios:

from src.bambo import Bambo from src.llm_client import client, model from src.tools.code_execute import code_execute roles = { "finance_expert": "金融专家", "law_expert": "法律专家", "medical_expert": "医疗专家", "computer_expert": "计算机专家", } tools = {} bambo = Bambo(client=client, bambo_role=None, roles=roles, tools=tools, agents=None, model=model) query = "我是高考生,现在想要选专业,但是不知道选什么专业。请你介绍一下金融、法律和计算机三个专业分别有什么优点和缺点。" async for item in bambo.execute(query=query): print(item, end="", flush=True)

Utilizar Bambo

- Ejecuta la interfaz de Bambo:

python examples/notebooklm.py - o ejecutar el agente en segundo plano:

nohup python examples/multi_roles.py &> multi_roles.log & - El menú interactivo le guiará a través de las siguientes opciones:

- Crear/actualizar el conjunto de datos de entrenamiento

- Modelos de formación

- Agentes de ejecución

- Ejecutar un flujo de trabajo completo

- abortar

configure

Edita config.py para personalizarlo:

- Selección de modelos

- Hiperparámetros de entrenamiento

- Configuración del proxy

- Plantillas adaptativas

- Filtrado de tareas

Bambo ofrece diversas formas de filtrar las tareas gestionadas:

- Etiquetado (automático)

- Lista negra (manual)

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...