Audio-Reasoner: un modelo lingüístico a gran escala para el razonamiento profundo de audio

Últimos recursos sobre IAPublicado hace 1 año Círculo de intercambio de inteligencia artificial 47.5K 00

Introducción general

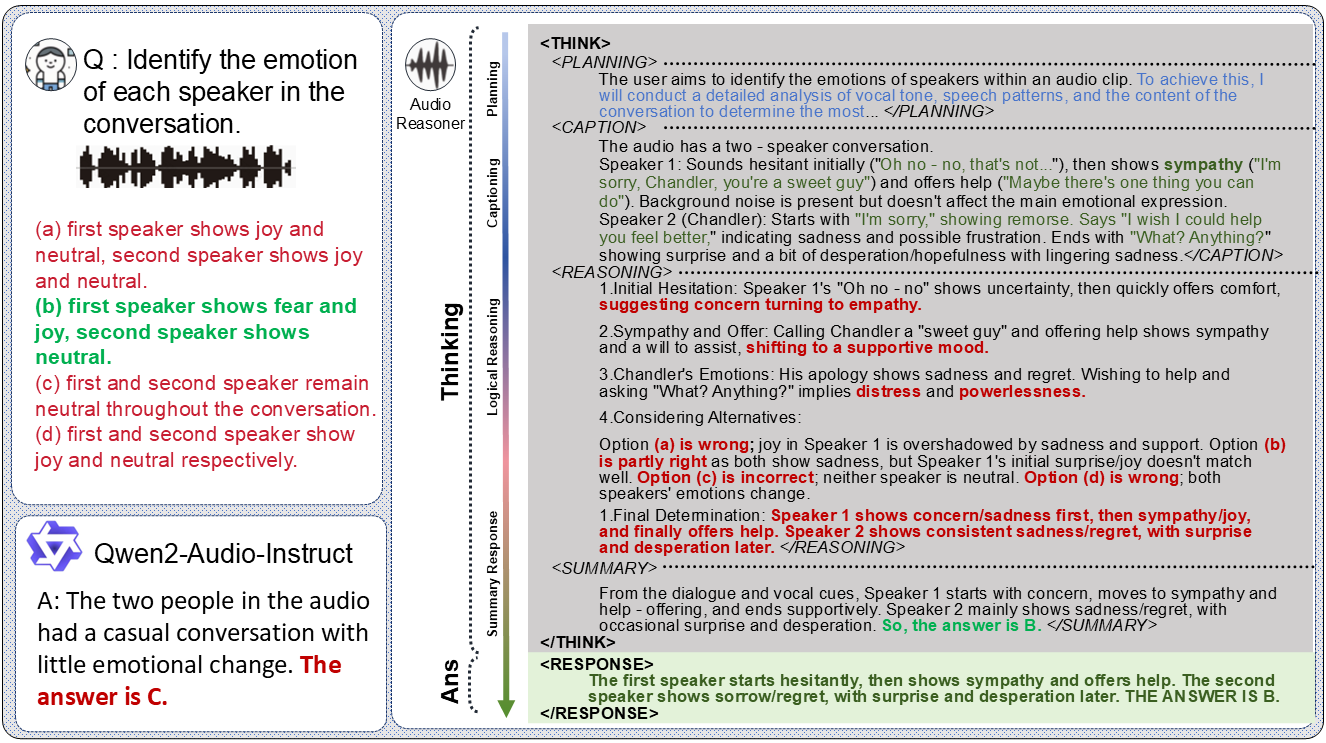

Audio-Reasoner es un proyecto de código abierto desarrollado por un equipo de la Universidad de Tsinghua y alojado en GitHub, centrado en la construcción de modelos lingüísticos a gran escala que soporten el razonamiento profundo en audio. El modelo se basa en Qwen2-Audio-Instruct, que permite el razonamiento complejo y la comprensión multimodal del contenido de audio mediante la introducción de la tecnología estructurada Chain-of-Thought (CoT). El proyecto incluye el modelo Audio-Reasoner-7B y el próximo conjunto de datos CoTA (con 1,2 millones de muestras de alta calidad), que ha logrado una mejora de rendimiento líder de 25,42% y 14,57% en las pruebas comparativas MMAU-mini y AIR-Bench-Chat, respectivamente.Audio-Reasoner Audio-Reasoner es una herramienta ideal para investigadores y desarrolladores, ya que admite el procesamiento de sonido, música, voz y otros tipos de audio, y es adecuada para escenarios de análisis de audio y comprensión de contenidos.

Lista de funciones

- Razonamiento profundo de audio: Analizar audio y generar procesos de razonamiento y resultados detallados utilizando el pensamiento en cadena estructurado.

- Apoyo multimodal a las tareasCombinación de audio y texto para tareas de comprensión y razonamiento multimodal.

- Procesamiento múltiple de audio: Admite el reconocimiento y análisis de múltiples tipos de audio, como voz, música, habla, etc.

- Modelos preentrenados de alto rendimiento: Proporciona el modelo Audio-Reasoner-7B, que destaca en varias pruebas de referencia.

- Conjunto de datos CoTAContiene 1,2 millones de muestras que permiten entrenar la inferencia estructurada y mejorar la capacidad de los modelos.

- Código de razonamiento y demostración: Proporciona código de inferencia completo y ejemplos de demostración para pruebas y desarrollo por parte del usuario.

- programa de código abiertoEn el futuro, el proceso de síntesis de datos y el código de entrenamiento se abrirán para facilitar la colaboración de la comunidad.

Utilizar la ayuda

Proceso de instalación

La instalación de Audio-Reasoner requiere la configuración del entorno Python y la descarga de los pesos del modelo, a continuación se detallan los pasos para garantizar que los usuarios puedan completar con éxito la compilación:

1. Clonación de un repositorio GitHub

Comienza clonando el proyecto Audio-Reasoner localmente. Abre un terminal y ejecuta el siguiente comando:

git clone https://github.com/xzf-thu/Audio-Reasoner.git

cd Audio-Reasoner

Esto descargará los archivos del proyecto localmente y en el directorio del proyecto.

2. Crear y activar un entorno virtual

Para evitar conflictos de dependencias, se recomienda crear un entorno Python separado utilizando Conda:

conda create -n Audio-Reasoner python=3.10

conda activate Audio-Reasoner

Este comando crea y activa un entorno basado en Python 3.10 llamado "Audio-Reasoner".

3. Instalación de paquetes de dependencia

El proyecto prevé requirements.txt que contiene las dependencias necesarias. Los pasos de instalación son los siguientes:

pip install -r requirements.txt

pip install transformers==4.48.0

Atención:transformers Es necesario instalar la versión 4.48.0 para garantizar un rendimiento estable del modelo. Instale primero las demás dependencias y, a continuación, especifique la opción transformers para evitar conflictos.

4. Descarga de las ponderaciones de los modelos

El modelo Audio-Reasoner-7B se ha publicado en HuggingFace y debe descargarse y configurarse manualmente:

- entrevistas HuggingFace Audio-Reasoner-7BDescargue el archivo del modelo.

- Rellene la ruta de punto de control descargada en el código del archivo

last_model_checkpointvariables, por ejemplo:

last_model_checkpoint = "/path/to/Audio-Reasoner-7B"

Cómo utilizarlo

Tras la instalación, los usuarios pueden ejecutar Audio-Reasoner mediante código para gestionar las tareas de audio. A continuación se muestra la guía de funcionamiento detallada:

Inicio rápido: Ejecute el código de ejemplo

El proyecto proporciona un ejemplo de inicio rápido para ayudar a los usuarios a probar la funcionalidad del modelo:

- Preparación de archivos de audio

Por defecto, utiliza el propio proyectoassets/test.wavo puedes sustituirlo por tu propio audio con formato WAV. Asegúrese de que la ruta es correcta. - Rutas de audio y problemas al editar el código

espectáculo (una entrada)inference.pyO simplemente utilice el siguiente código para establecer la ruta de audio y hacer preguntas:audiopath = "assets/test.wav" prompt = "这段音频的节奏感和拍子是怎样的?" audioreasoner_gen(audiopath, prompt) - programa de carrera

Ejecútelo en el terminal:conda activate Audio-Reasoner cd Audio-Reasoner python inference.pyEl modelo producirá resultados de inferencia estructurados, incluyendo

<THINK>(planificar, describir, razonar, resumir) y<RESPONSE>(Respuesta final).

Funciones básicas: razonamiento profundo de audio

En el corazón de Audio-Reasoner está el razonamiento de audio basado en el pensamiento en cadena, y así es como funciona:

- Audio de entrada y problemas

- utilizar

audioreasoner_genintroduciendo la ruta de audio y una pregunta concreta. Ejemplo:audiopath = "your_audio.wav" prompt = "音频中是否有鸟叫声?" audioreasoner_gen(audiopath, prompt)

- utilizar

- Ver el resultado de la inferencia

El modelo devuelve procesos de razonamiento detallados, por ejemplo:<THINK> <PLANNING>: 检查音频中的声音特征,识别是否有鸟叫声。 <CAPTION>: 音频包含自然环境音,可能有风声和动物叫声。 <REASONING>: 分析高频声音特征,与鸟类叫声模式匹配。 <SUMMARY>: 音频中可能存在鸟叫声。 </THINK> <RESPONSE>: 是的,音频中有鸟叫声。 - Ajuste de los parámetros de salida (opcional)

Si se necesita una respuesta más larga o flexible, puede modificarseRequestConfigParámetros:request_config = RequestConfig(max_tokens=4096, temperature=0.5, stream=True)

Pruebas locales de muestras preestablecidas

El proyecto incorpora audio de prueba y preguntas para una verificación rápida:

conda activate Audio-Reasoner

cd Audio-Reasoner

python inference.py

Tras la ejecución, el terminal muestra una descripción del assets/test.wav Los resultados de los análisis son adecuados para la primera experiencia.

Función: comprensión multimodal

Audio-Reasoner permite el análisis conjunto de audio y texto. Por ejemplo:

prompt = "这段音乐的情绪是否与‘悲伤’描述相符?"

audioreasoner_gen("sad_music.wav", prompt)

El modelo combinará las características del audio y la semántica del texto para producir resultados de inferencia.

Precauciones y preguntas frecuentes

- formato de audioFormato WAV recomendado, frecuencia de muestreo 16 kHz, mono.

- lentoSi va lento, compruebe que la GPU está activada (requiere PyTorch para CUDA).

- El modelo no respondeVerifica que la ruta del modelo es correcta y que las dependencias están completamente instaladas.

- Conflicto de dependenciaSi la instalación falla, intente crear un nuevo entorno e instalar las dependencias en orden estricto.

Uso avanzado

- Lógica de razonamiento personalizada:: Modificación

systemPalabras clave para ajustar el estilo de razonamiento del modelo. - archivo por lotes:: Will

max_batch_sizeEstablezca un valor más alto (por ejemplo, 128) para admitir la inferencia simultánea de varios audios. - Combinado con el conjunto de datos CoTAEl futuro conjunto de datos del CoTA podrá utilizarse para seguir entrenando o afinando el modelo cuando se publiquen.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...