Instalar Dify e integrar Ollama y Xinference

Tutoriales prácticos sobre IAPublicado hace 1 año Círculo de intercambio de inteligencia artificial 83.1K 00

Este artículo describe la instalación de Dify a través de Docker y luego la integración de la Ollama y XInference, y utilizando el Dify Cree rápidamente una aplicación basada en cuestionarios de base de conocimientos.

- I. Introducción a Dify

- Instalación de Dify

- III. Dify añade el modelo Ollama Q&A

- IV. Cuestionario basado en la base de conocimientos de Dify

- V. Enlaces de documentación

I. Introducción a Dify

Dify es una plataforma de código abierto para el desarrollo de aplicaciones de Large Language Modelling (LLM) diseñada para ayudar a los desarrolladores a construir y desplegar rápidamente aplicaciones de IA generativa. Estas son las principales características y funcionalidades de Dify [1]:

- Fusión de los conceptos Backend as Service y LLMOps Dify combina los conceptos de Backend as Service y LLMOps para permitir a los desarrolladores crear rápidamente aplicaciones de IA generativa de nivel de producción.

- Compatibilidad con varios modelos Dify es compatible con cientos de modelos LLM propios y de código abierto, como GPT, Mistral, Llama3, etc., e integra a la perfección modelos de múltiples proveedores de inferencia y soluciones autoalojadas.

- Interfaz intuitiva de orquestación de avisos Dify proporciona un IDE intuitivo para escribir prompts, comparar el rendimiento de los modelos y añadir funciones adicionales como la conversión de voz a aplicaciones basadas en chat.

- Motor RAG de alta calidad Dify dispone de una amplia gama de RAG Funciones que lo cubren todo, desde la ingesta de documentos hasta su recuperación, y admiten la extracción de texto a partir de formatos de documentos habituales como PDF, PPT, etc.

- Integración del marco de agentes El usuario puede basar la llamada a la función LLM o a la función ReAct Dify ofrece más de 50 herramientas integradas, como Google Search, DELL-E, Stable Diffusion y WolframAlpha.

- Organización flexible de los procesos Dify proporciona un potente lienzo visual para construir y probar flujos de trabajo de IA robustos, permitiendo a los desarrolladores diseñar y optimizar intuitivamente sus procesos de IA.

- Herramientas completas de seguimiento y análisis : Dify proporciona herramientas para supervisar y analizar los registros y el rendimiento de las aplicaciones, y los desarrolladores pueden mejorar continuamente las sugerencias, los conjuntos de datos y los modelos basándose en los datos de producción y las anotaciones.

- back-end como servicio Todas las características de Dify vienen con una API, por lo que es fácil integrar Dify en su propia lógica de negocio.

Instalación de Dify

Copie el código Github de Dify localmente [2].

git clone https://github.com/langgenius/dify.git

Ve al directorio docker del código fuente de dify y copia las variables de entorno.

cd dify/docker

cp .env.example .env

Instale la aplicación a través de docker compose.

docker compose up -d

Entra en el contenedor ollama e inicia elqwen2:7bModelos.

root@ip-172-31-30-167:~/dify/docker# docker pull ollama/ollama

root@ip-172-31-83-158:~/dify/docker# docker run -d --gpus=all -v ollama:/root/.ollama -p 11434:11434 --name ollama --restart always -e OLLAMA_KEEP_ALIVE=-1 ollama/ollama

root@ip-172-31-83-158:~/dify/docker# docker exec -it ollama bash

root@b094349fc98c:/# ollama run qwen2:7b

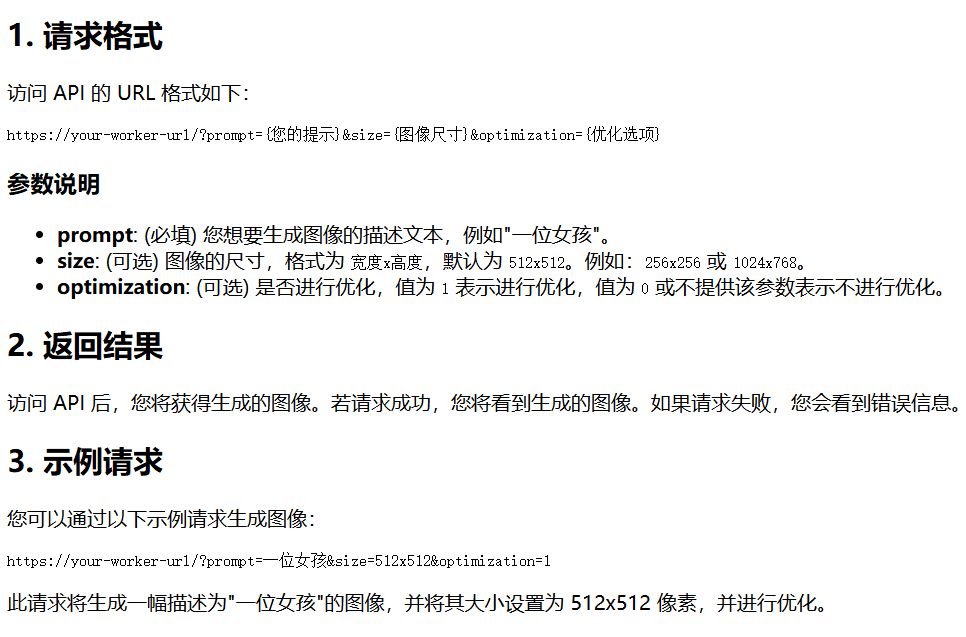

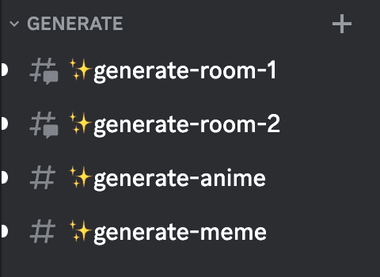

III. Dify añade el modelo Ollama Q&A

Inicie sesión en la página principal de Dify a través de la dirección IP pública de EC2 más el puerto 80 y cree una cuenta de administrador.

Inicie sesión a través de la cuenta de administrador.

Haga clic en Usuario - Configuración.

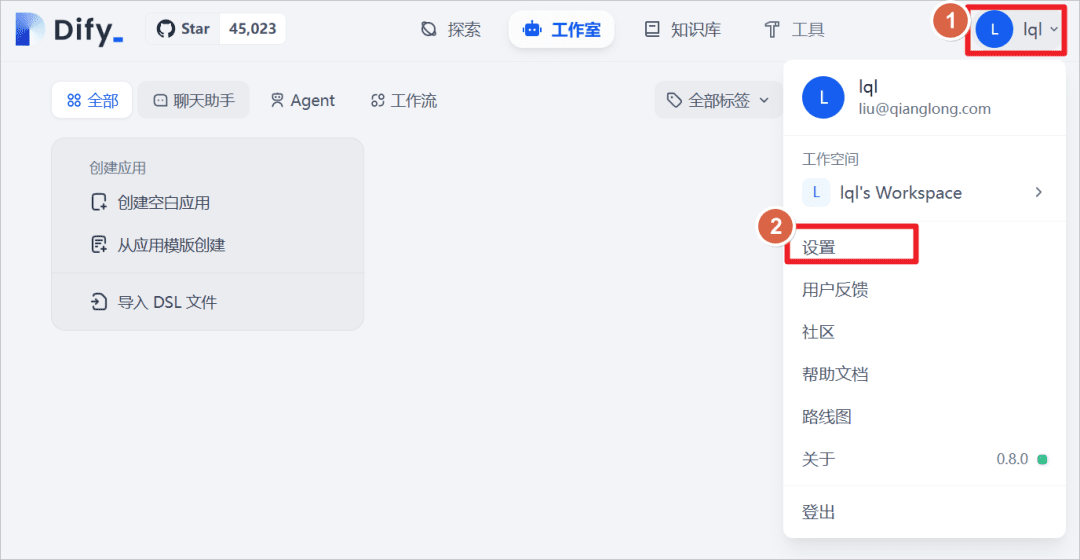

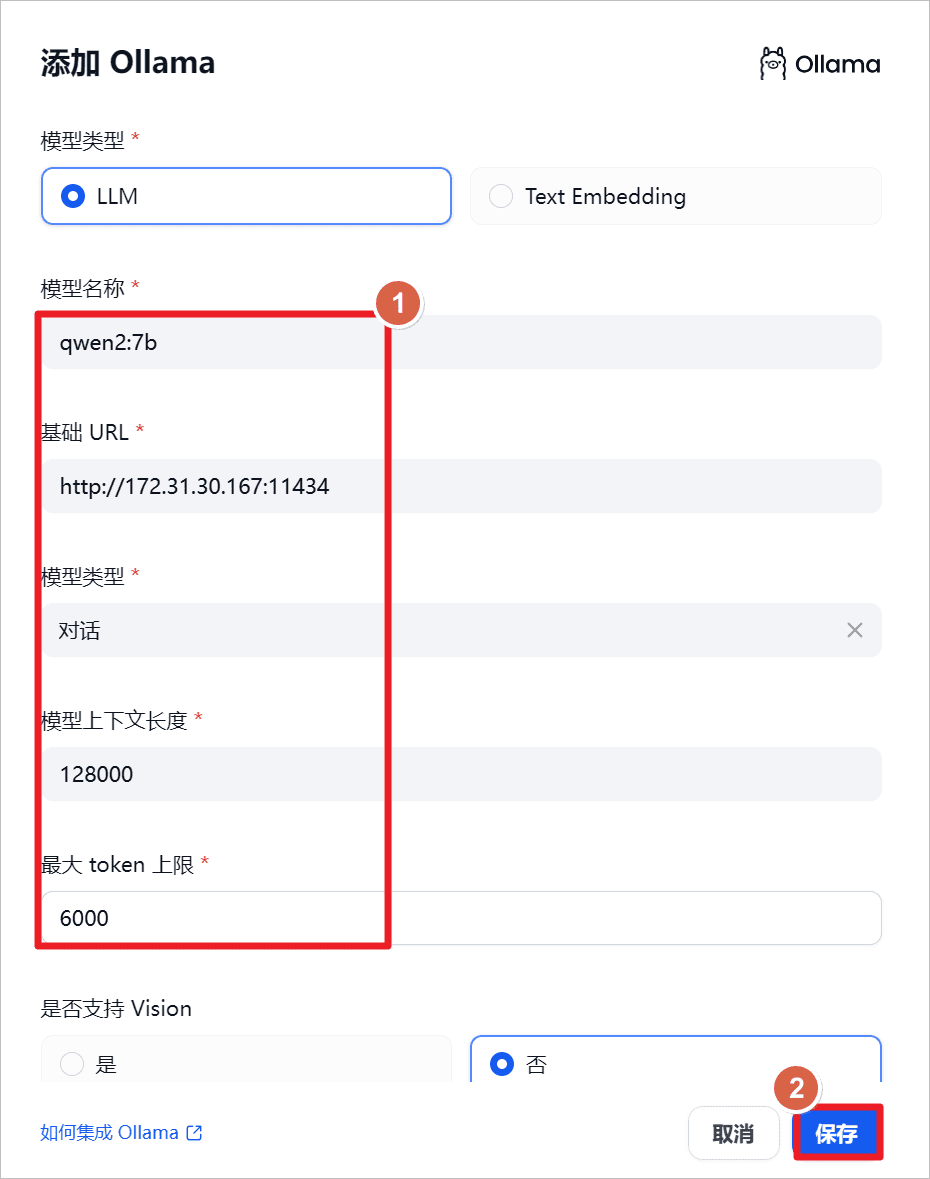

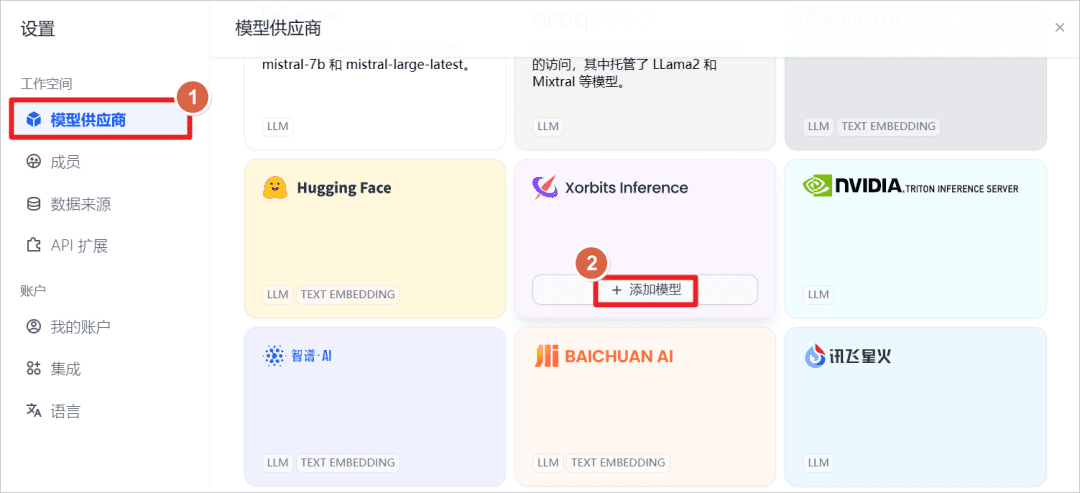

Añadir el modelo Ollama.

aumentarqwen2:7bya que Ollama se ejecuta localmente, establezca la dirección URL en la dirección IP local y el puerto en la dirección114341(matemáticas) género

"qwen2-7b-instruct admite 131.072 tokens de contextos utilizando YARN, una técnica de extrapolación de longitud de modelo aumentada, y para salvaguardar el uso normal y la salida normal, se recomienda que la API limite la entrada del usuario a 128.000 y la salida a un máximo de 6.144.[3]".

"

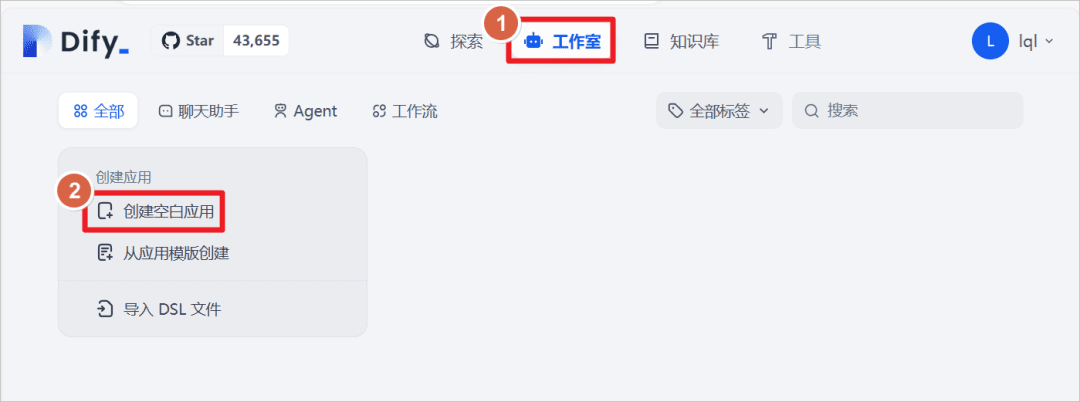

Haga clic en Estudio - Crear una aplicación en blanco

Cree una aplicación de tipo "Asistente de chat" y defina el nombre de la aplicación comoQwen2-7Bhaga clic en Crear.

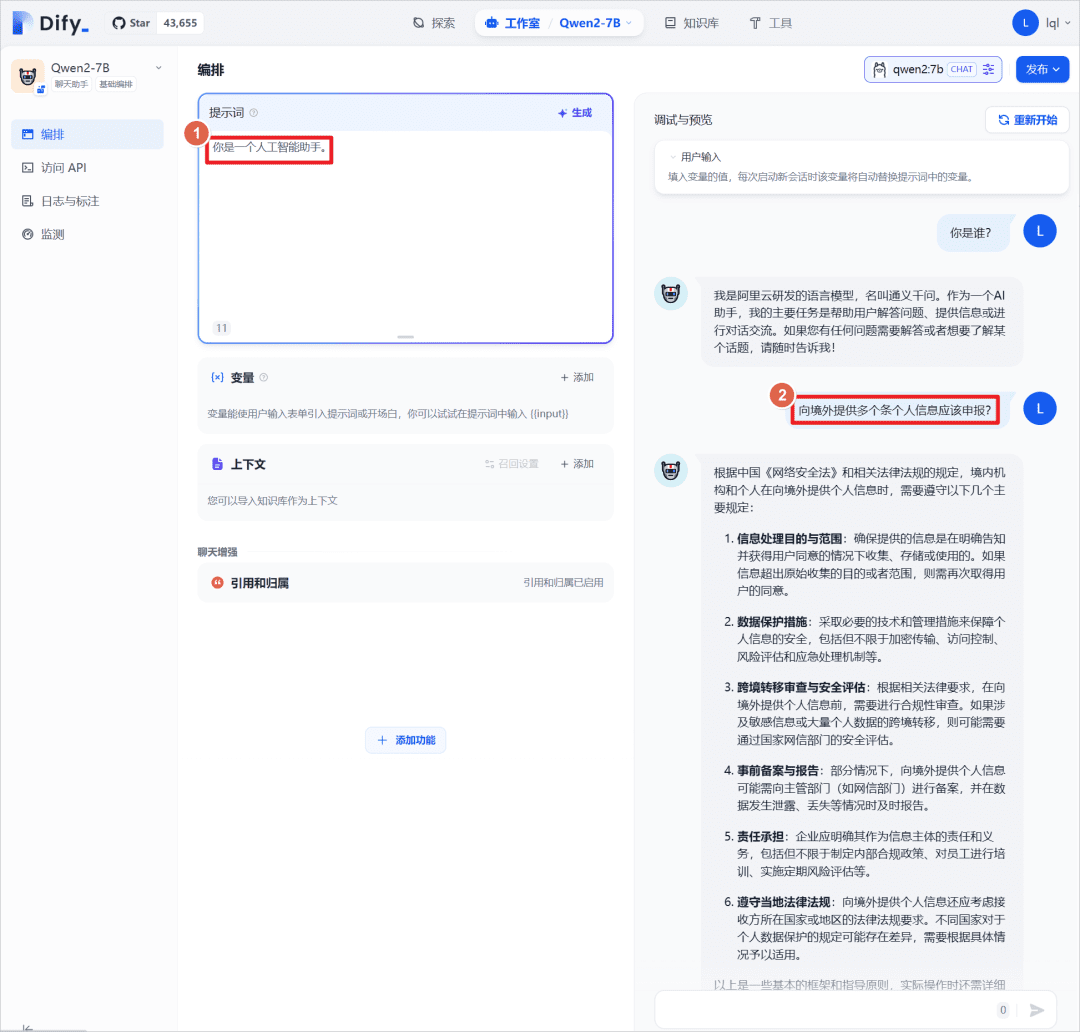

La opción "Eres un asistente de inteligencia artificial" de la aplicación puede utilizarse junto con la opciónQwen2:7BSe realizó una prueba de diálogo, aquí con el propio modelo grande, sin introducir una base de conocimiento externa, que se introducirá más adelante para comparar los resultados de las respuestas.

IV. Cuestionario basado en la base de conocimientos de Dify

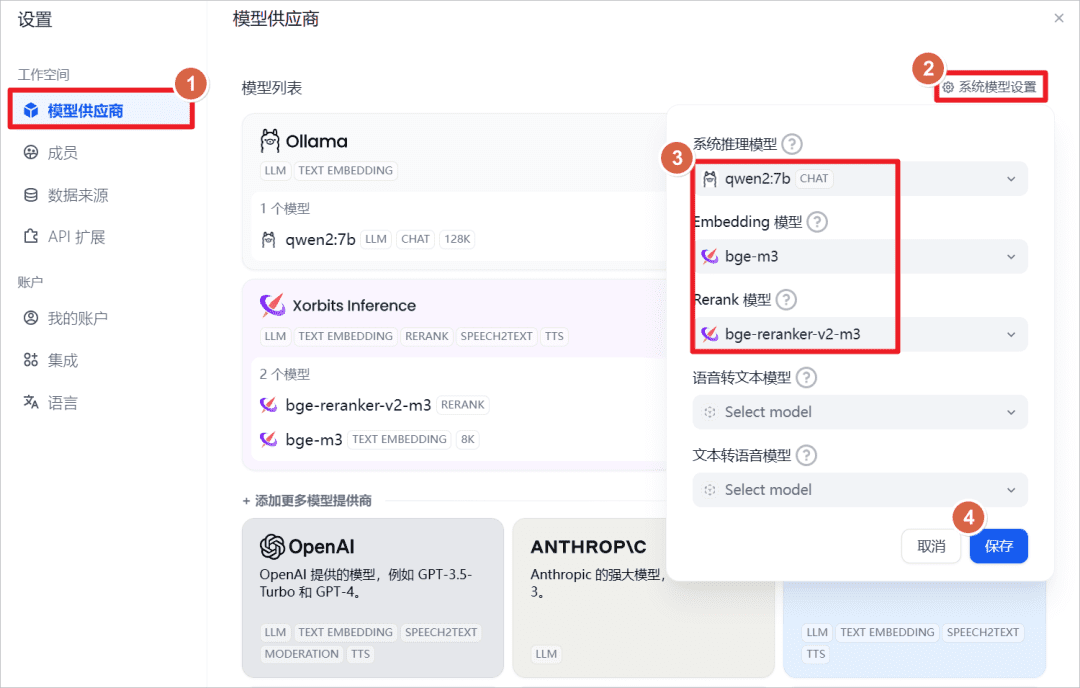

aumentarXorbits InferenceModelos proporcionados.

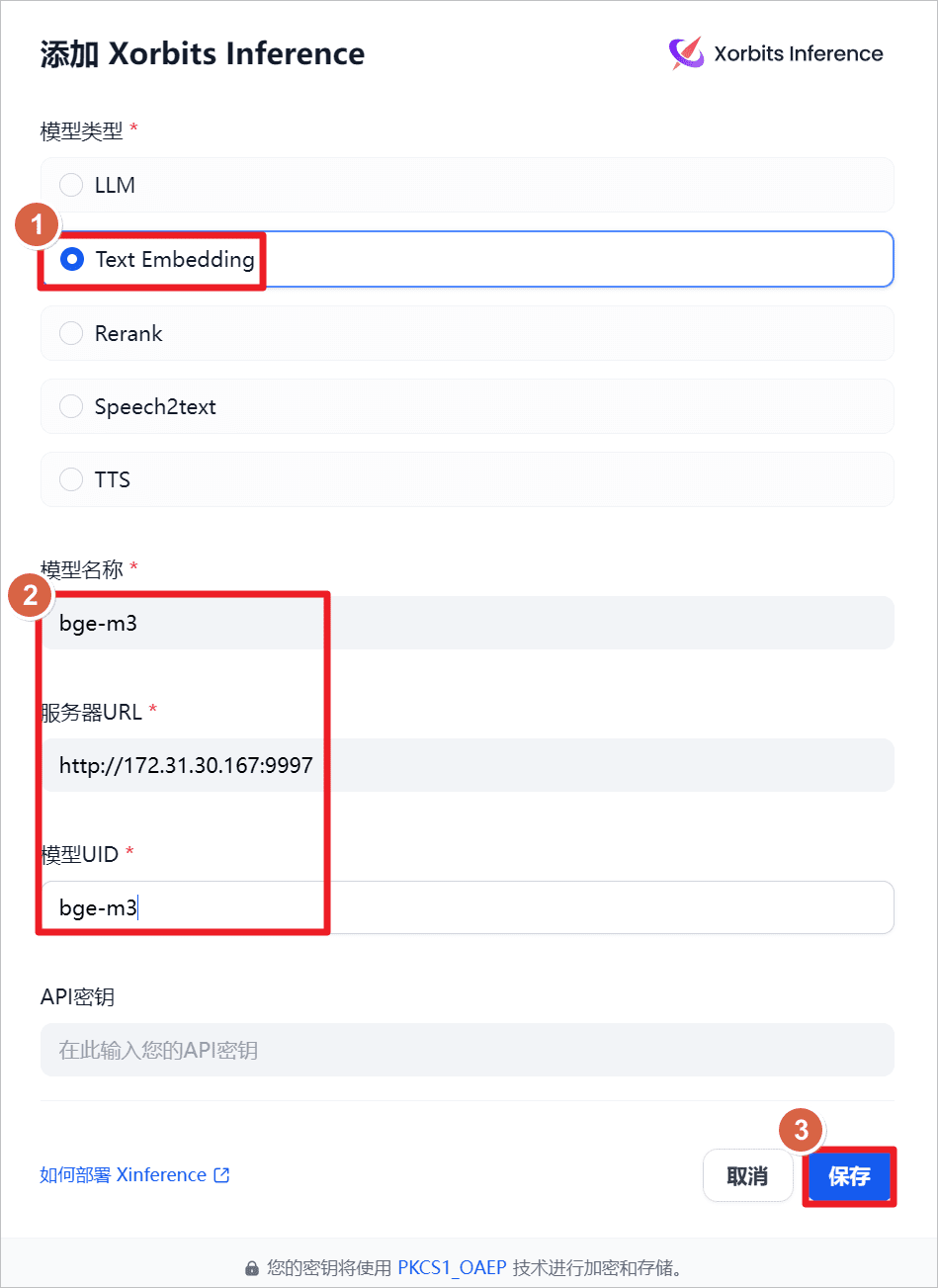

aumentarText Embeddinges decir, el modelo de incrustación de texto, el nombre del modelo esbge-m3La URL del servidor eshttp://172.31.30.167:9997(aquí está la IP de la máquina local, también puede instalarse en otras máquinas, basta con que la red y el puerto sean accesibles), ha iniciado XInference en la máquina local con antelación, y ha iniciado el programabge-m3(véase el post anterior).

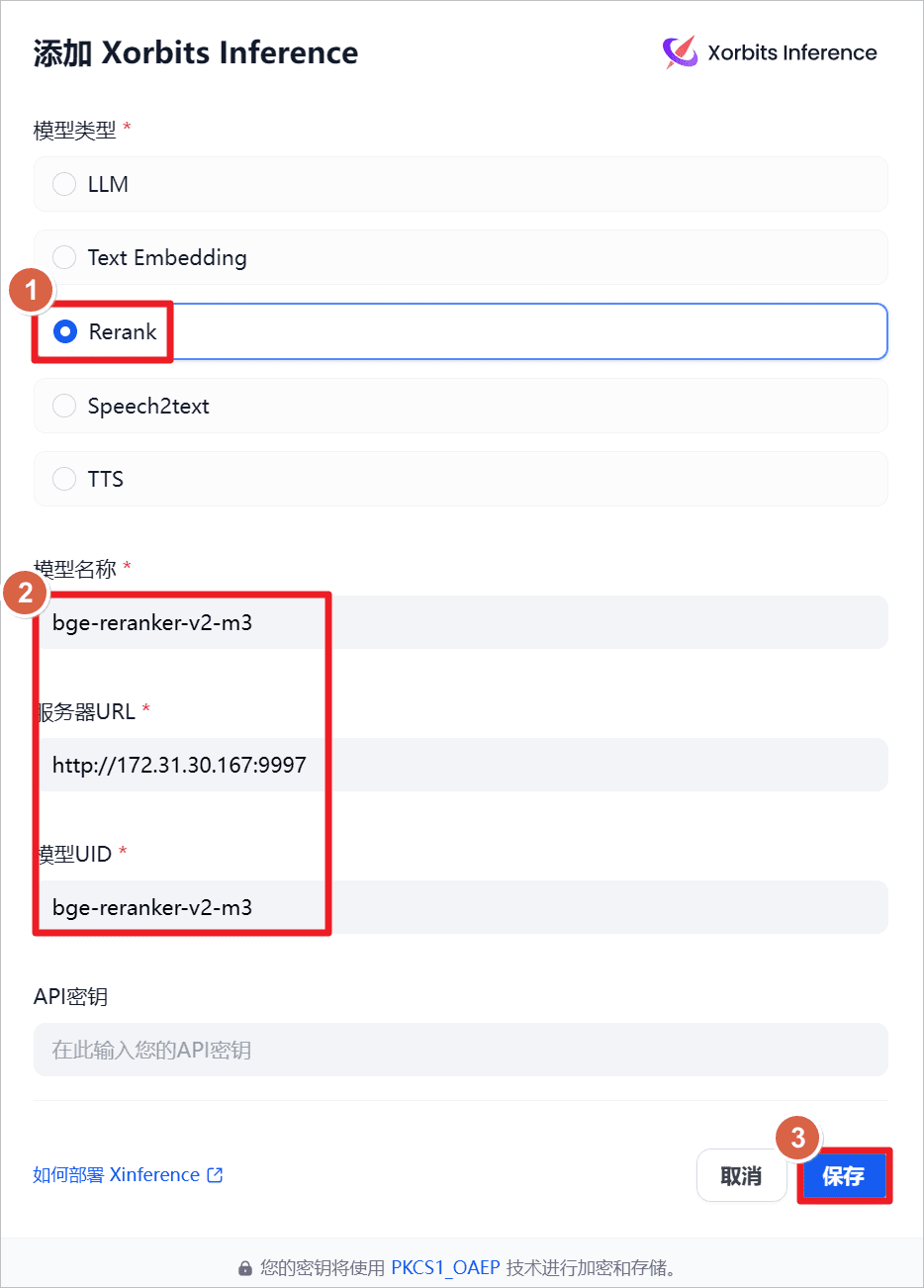

aumentarRerankes decir, el modelo de reordenación, el nombre del modelo esbge-reraker-v2-m3La URL del servidor eshttp://172.31.30.167:9997(aquí está la IP de la máquina local, también puede instalarse en otras máquinas, basta con que la red y el puerto sean accesibles), ha iniciado XInference en la máquina local con antelación, y ha iniciado el programabge-reraker-v2-m3(véase el post anterior).

Ver la configuración predeterminada del sistema.

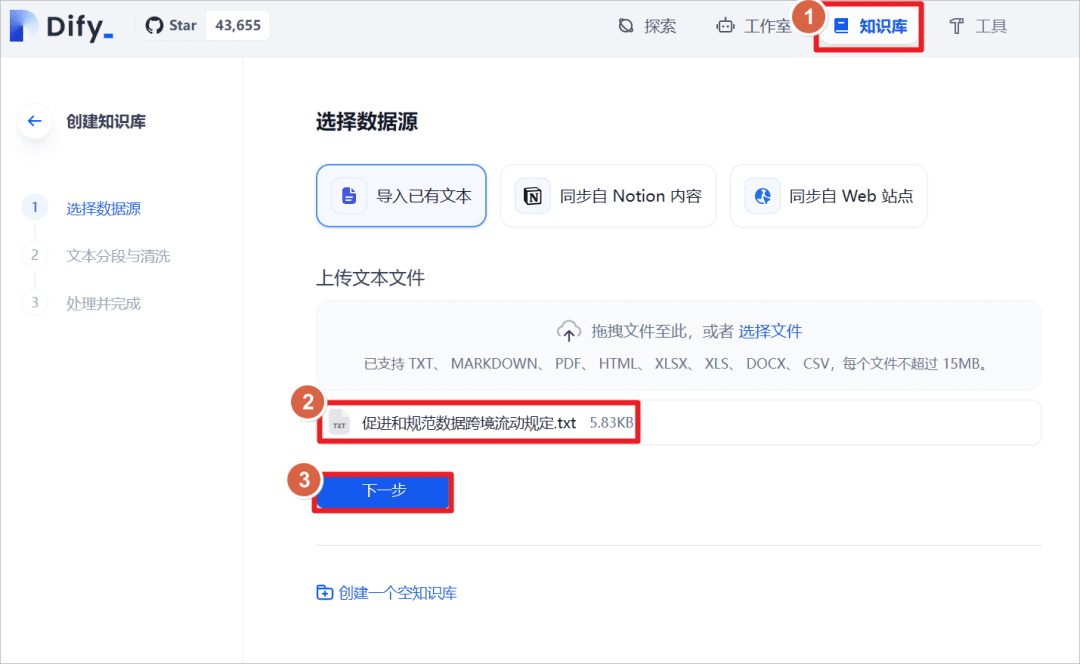

Haga clic en "Base de conocimientos" - "Importar texto existente" - "Cargar archivo de texto" - seleccione el documento "Disposiciones sobre la facilitación y regulación del flujo transfronterizo de datos".

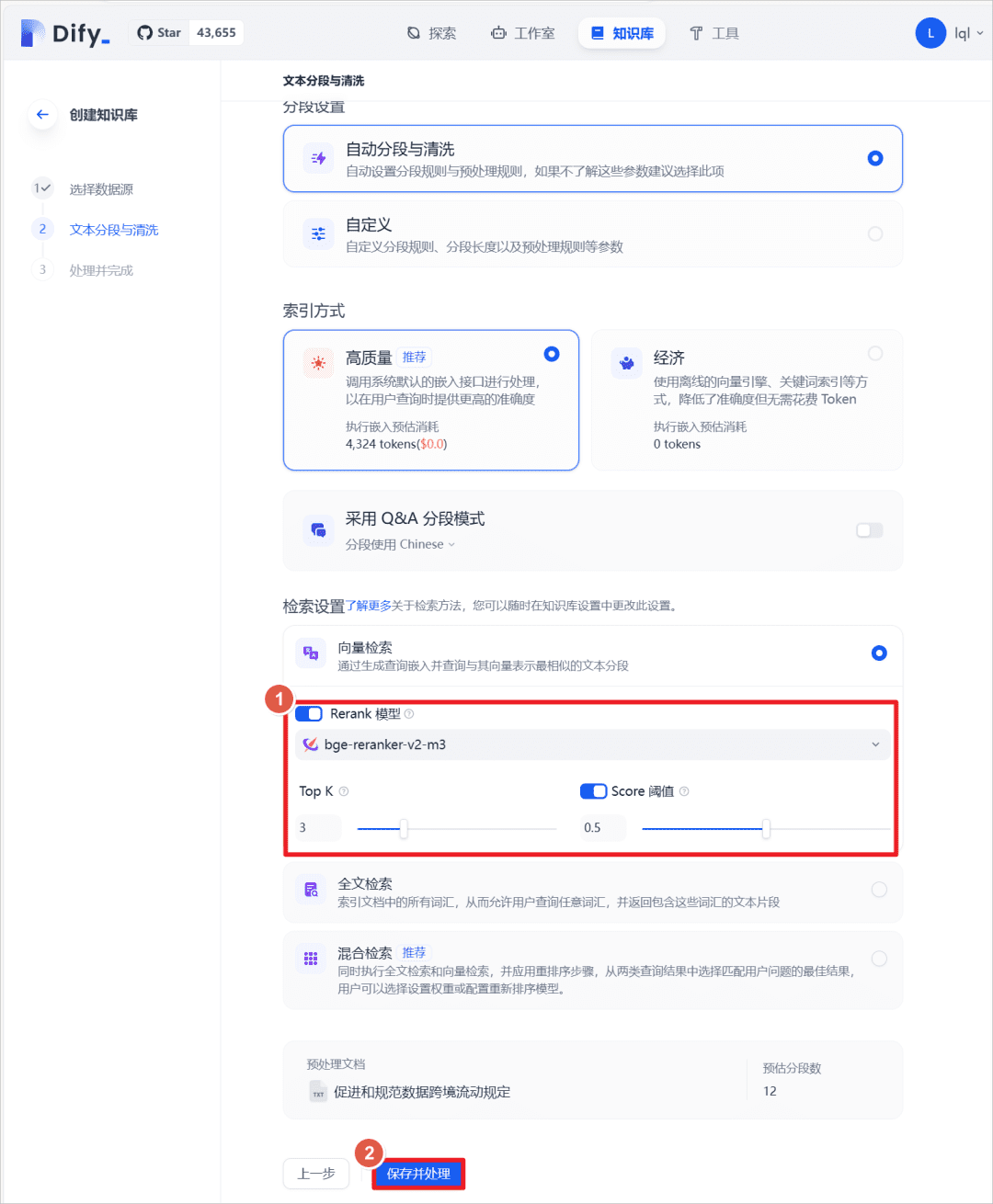

Una vez realizada la importación, configure el método de recuperación de texto y active la funciónRerankmodelo, seleccionebge-reranker-v2-m3modelo, active elScoreEl umbral es 0,5 (es decir, las coincidencias de texto por debajo de una puntuación de 0,5 no se recuerdan y no se añaden al contexto del modelo más amplio).

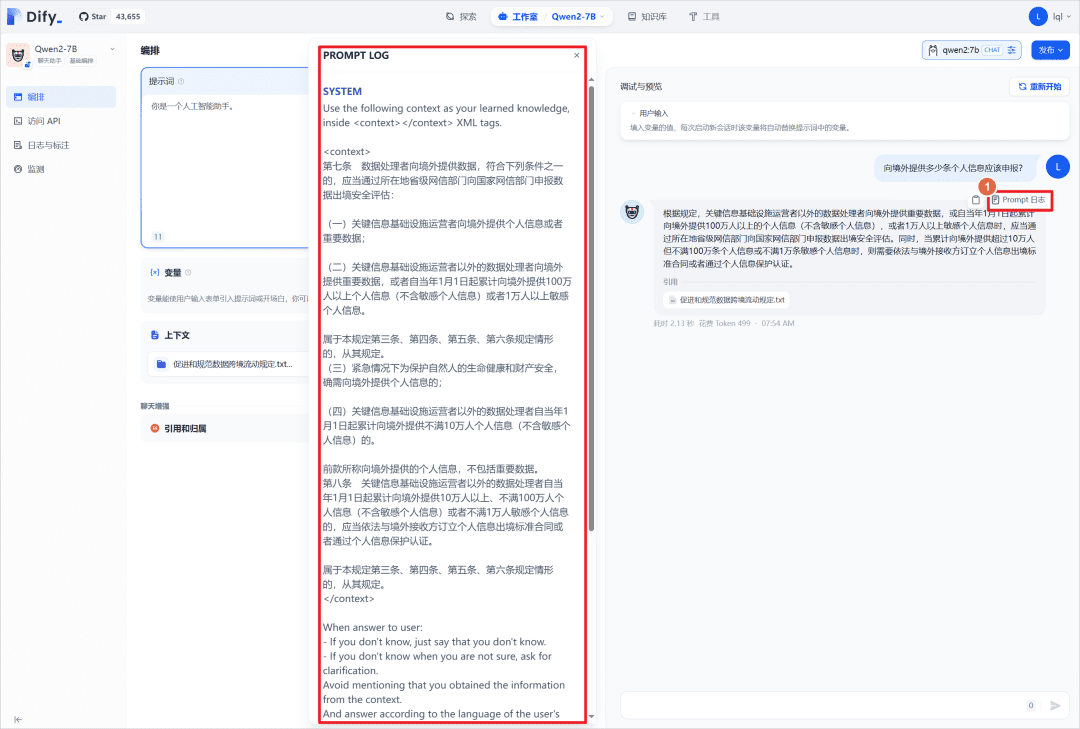

En la aplicación de chat anterior, añada la base de conocimientos creada anteriormente y vuelva a formular la misma pregunta al modelo más grande y podrá ver que el modelo ha respondido conjuntamente con la base de conocimientos.

Puede hacer clic en "Prompt Log" para ver el archivo de registro, y puede ver los avisos del sistema, que colocan el contenido de la base de conocimientos correspondiente en la carpeta<context></context>Medio.

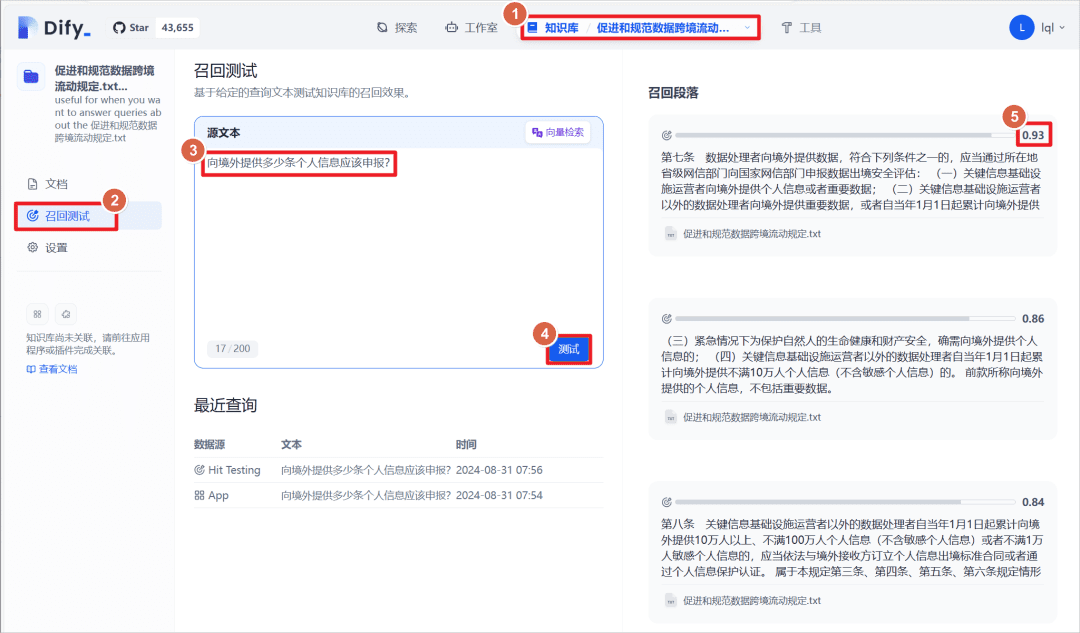

Haga clic en la base de conocimientos creada - haga clic en la "prueba de recuerdo", puede introducir un párrafo de texto para hacer coincidir el texto de la base de conocimientos con el texto coincidente, el texto coincidente tiene una puntuación de peso, el umbral establecido anteriormente es de 0,5, es decir, mayor que esta puntuación se mostrará como "párrafo de recuerdo ".

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Puestos relacionados

Sin comentarios...