Escuela Técnica Superior de Ingeniería AI: Evaluación de sistemas 2,5 RAG

Base de conocimientos de IAActualizado hace 1 año Círculo de intercambio de inteligencia artificial 36.7K 00

breve

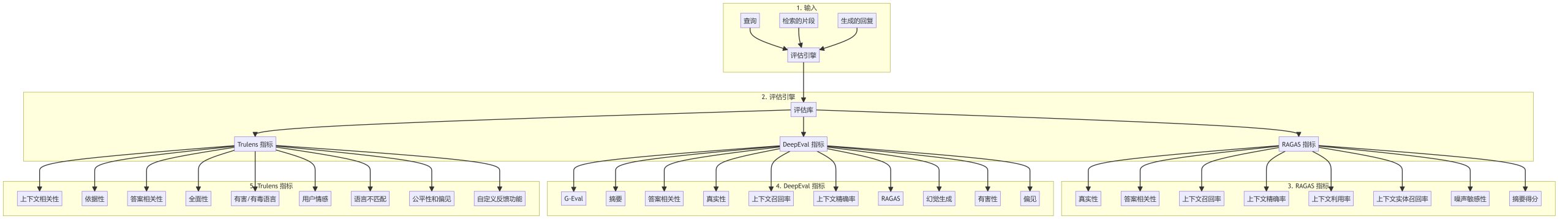

La evaluación es un componente clave en el desarrollo y optimización de los sistemas de Generación Aumentada de Recuperación (RAG). La evaluación implica una revisión de RAG Todos los aspectos del proceso se miden en cuanto a rendimiento, precisión y calidad, incluidas la pertinencia y la autenticidad, desde la eficacia de la recuperación hasta la generación de respuestas.

Importancia de la evaluación RAG

La evaluación eficaz del sistema GAR es importante porque:

- Ayuda a identificar los puntos fuertes y débiles del proceso de recuperación y generación.

- Orientar la mejora y optimización de todo el proceso GAR.

- Garantizar que el sistema cumple las normas de calidad y las expectativas de los usuarios.

- Facilita la comparación de diferentes implementaciones o configuraciones de GAR.

- Ayuda a detectar problemas como alucinaciones, prejuicios o respuestas irrelevantes.

Proceso de evaluación RAG

La evaluación de un sistema GAR suele incluir los siguientes pasos:

Indicadores básicos de evaluación

Indicadores RAGAS

- validez: Mide la coherencia de la respuesta generada con el contexto de recuperación.

- Pertinencia de las respuestas: Evalúa la pertinencia de la respuesta a la consulta.

- recuperación del contexto (informática)Evaluación: evalúa si los fragmentos recuperados cubren la información necesaria para responder a la consulta.

- Precisión contextualMedida de la proporción de información relevante en los fragmentos recuperados.

- Utilización del contextoEvalúe la eficacia con la que la respuesta generada utiliza el contexto proporcionado.

- recuerdo contextual de entidades: Evalúa si las entidades importantes del contexto están cubiertas en la respuesta.

- sensibilidad al ruido: Medida de la robustez de un sistema frente a información irrelevante o ruidosa.

- Puntuación abstracta: Evalúe la calidad del resumen en la respuesta.

Indicadores DeepEval

- G-EvalMétricas de evaluación comunes para tareas de generación de texto.

- resúmenes: Evalúe la calidad de los resúmenes de texto.

- Pertinencia de las respuestas: Una medida de lo bien que la respuesta responde a la consulta.

- validez: Evaluar la exactitud de la respuesta y la información de la fuente.

- Recall y precisión contextualesMedición de la eficacia de la recuperación contextual.

- Detección de alucinacionesIdentifica información falsa o inexacta en una respuesta.

- toxicológico: Detectar contenido potencialmente dañino u ofensivo en la respuesta.

- sesgo: Identificar preferencias o tendencias desleales en los contenidos generados.

Indicadores Trulens

- relevancia contextualEvaluación: evalúa en qué medida el contexto de recuperación coincide con la consulta.

- conectado a tierra: Una medida de si la respuesta está respaldada por la información recuperada.

- Pertinencia de las respuestas: Evalúa la calidad de la respuesta a la consulta.

- exhaustividadMide la exhaustividad de la respuesta.

- Lenguaje ofensivoIdentificar contenidos potencialmente ofensivos o peligrosos.

- sentimiento del usuario: Análisis del tono emocional en las interacciones de los usuarios.

- incompatibilidad lingüísticaDetección de incoherencias en el uso del lenguaje entre la consulta y la respuesta.

- Equidad y parcialidad: Evaluar el trato justo de los distintos grupos en el sistema.

- Funciones de respuesta personalizadasPermite el desarrollo de métricas de evaluación personalizadas para casos de uso específicos.

Buenas prácticas para la evaluación RAG

- Evaluación global: Combinación de múltiples indicadores para evaluar diferentes aspectos del sistema GAR.

- Evaluación comparativa periódica: Evaluar continuamente el sistema a medida que cambian los procesos.

- Participación humana: Un análisis exhaustivo que combina evaluaciones manuales e indicadores automatizados.

- Indicadores específicos de dominioDesarrollar métricas personalizadas relacionadas con casos de uso o dominios específicos.

- análisis de erroresAnalizar patrones en las respuestas con baja puntuación e identificar áreas de mejora.

- Evaluación comparativaComparar el sistema GAR con modelos de referencia y aplicaciones alternativas.

llegar a un veredicto

Un marco de evaluación sólido es esencial para el desarrollo y mantenimiento de un sistema GAR de alta calidad. Utilizando una amplia gama de métricas y siguiendo las mejores prácticas, los promotores pueden garantizar que su sistema RAG ofrezca respuestas precisas, pertinentes y creíbles, al tiempo que mejoran continuamente el rendimiento.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...