Tabla de clasificación de agentes: tabla de clasificación de la evaluación del rendimiento de los agentes de IA

Últimos recursos sobre IAPublicado hace 11 meses Círculo de intercambio de inteligencia artificial 67.7K 00

Introducción general

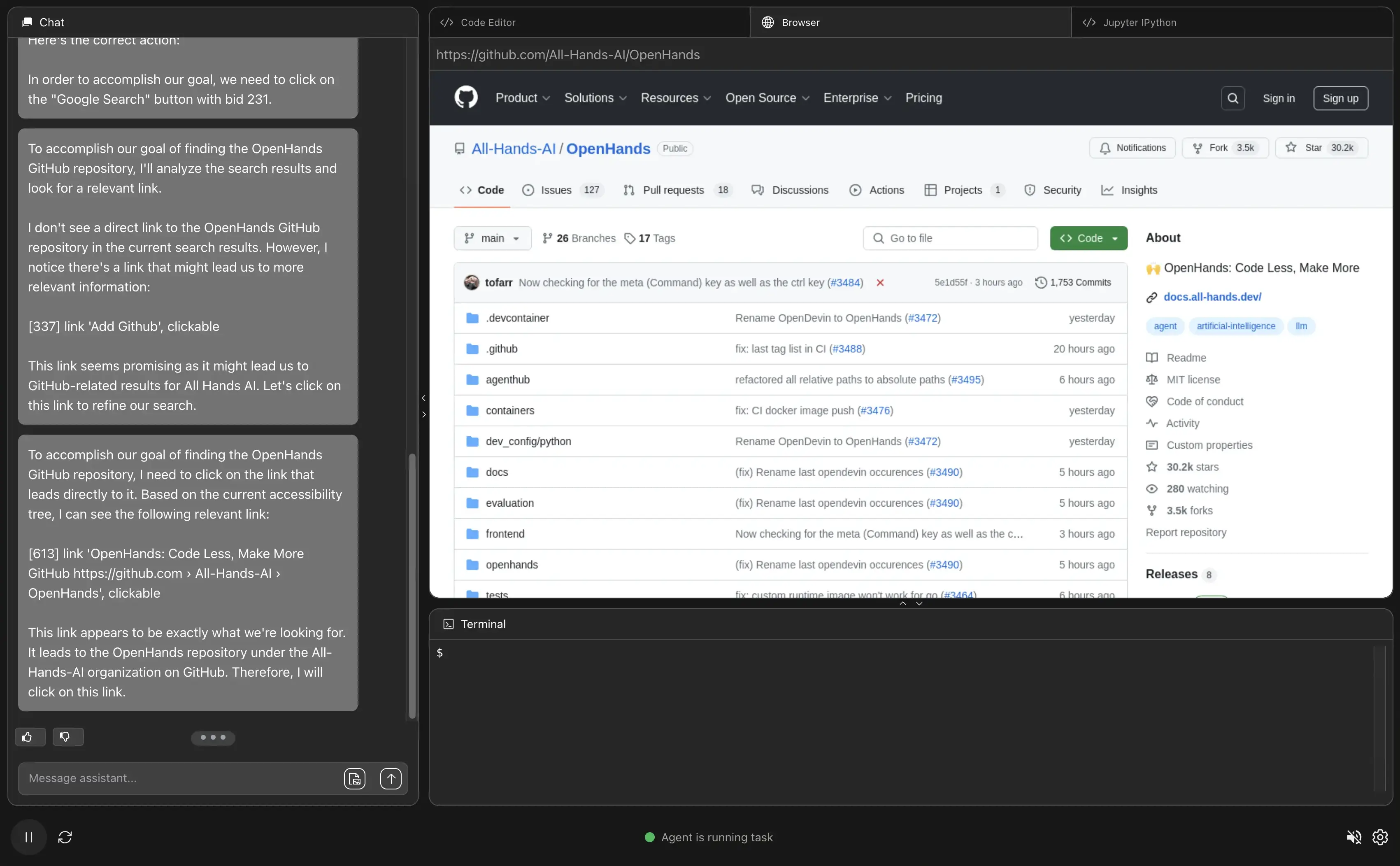

Agent Leaderboard es una herramienta en línea centrada en la evaluación del rendimiento de los agentes de IA lanzada por Galileo AI en la plataforma Hugging Face. Pone a prueba 17 grandes modelos lingüísticos (LLM), que abarcan escenarios que van desde simples llamadas a la API hasta complejas interacciones entre varias herramientas, mediante la combinación de múltiples conjuntos de datos autorizados (por ejemplo, BFCL, τ-bench, xLAM y ToolACE). El sitio web pretende responder a la pregunta "¿Cómo se comportan los agentes de IA en escenarios empresariales reales?" y ayudar a desarrolladores y empresas a elegir el modelo adecuado para sus necesidades. La tabla de clasificación se actualiza mensualmente y permite ver clasificaciones de modelos, puntuaciones, costes y otra información para equipos que necesitan construir un sistema de agentes de IA eficiente. Los usuarios pueden comparar visualmente el rendimiento de los modelos privados y de código abierto. Ver informes de análisis:Hugging Face lanza rankings de cuerpos de inteligencia de agentes: ¿quién es el líder en llamadas a herramientas?

Lista de funciones

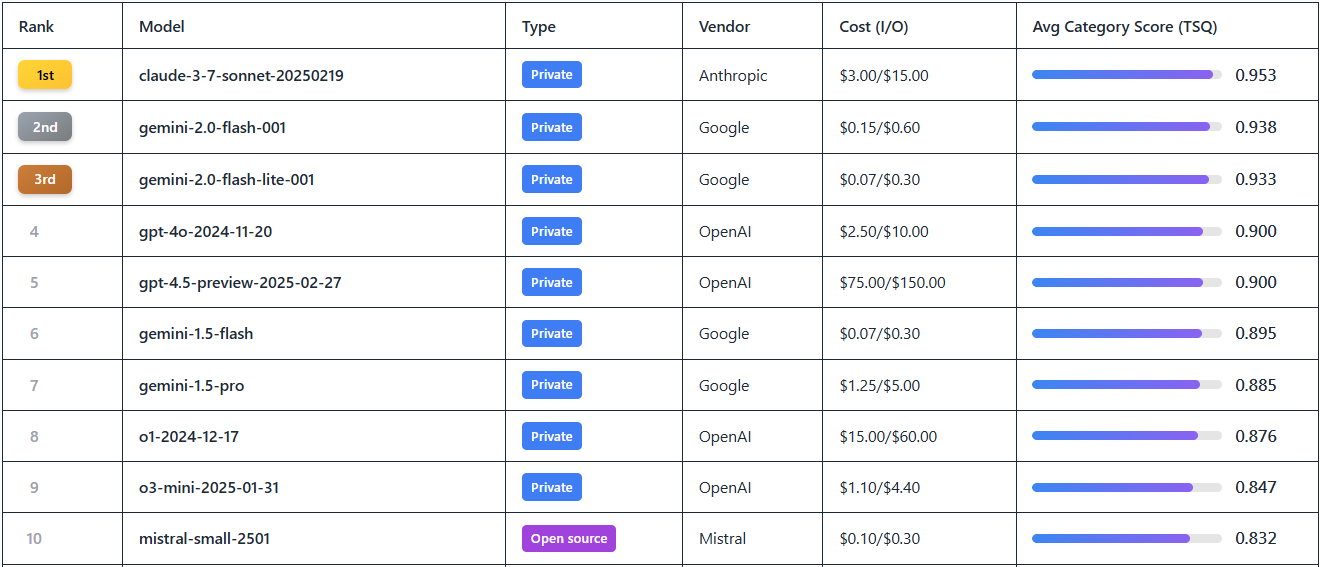

- Clasificación del rendimiento de los modelos: Muestra las clasificaciones de 17 LLM líderes, como Gemini-2.0 Flash, GPT-4o, etc., en función de las puntuaciones de Calidad de Selección de Herramientas (TSQ).

- Datos de la evaluación multidimensional: Proporciona resultados de pruebas entre dominios que abarcan más de 390 escenarios, como matemáticas, comercio minorista, aviación, interacciones con API, etc.

- Coste frente a eficiencia:: Demostración por millón para cada modelo ficha Coste (por ejemplo, Gemini-2.0 Flash $0.15 frente a GPT-4o $2.5) para el análisis de precio/rendimiento.

- Herramientas de filtrado y visualización:: Posibilidad de filtrar modelos por proveedor, estado de código abierto/privado, puntuación, etc., para localizar rápidamente la información necesaria.

- Acceso abierto a los conjuntos de datos:: Proporcionar enlaces de descarga a conjuntos de datos de prueba para que los desarrolladores puedan estudiarlos y validarlos.

- Mecanismo de actualización dinámica:: Actualizaciones mensuales de la clasificación para sincronizar los últimos lanzamientos de modelos y datos de rendimiento.

Utilizar la ayuda

Cómo acceder y utilizar

Agent Leaderboard es una herramienta en línea que no requiere instalación y permite a los usuarios simplemente abrir un navegador, visitar el https://huggingface.co/spaces/galileo-ai/agent-leaderboard Listo para usar. Cuando se carga la página, aparece una tabla de clasificación intuitiva que permite consultar todos los datos públicos disponibles sin necesidad de registrarse o iniciar sesión. Para participar en mayor profundidad (como descargar conjuntos de datos o hacer sugerencias), puede registrarse para obtener una cuenta de Hugging Face.

flujo de trabajo

- Navegar por los gráficos

- Al abrir la página, la página de inicio muestra por defecto los 17 principales modelos LLM actuales.

- Las columnas de la tabla incluyen "Rango", "Modelo", "Proveedor", "Puntuación", "Coste" y "Tipo (código abierto/privado)". Puntuación", "Coste" y "Tipo (código abierto/privado)".

- Ejemplo: El número 1 del ranking Gemini-2.0 Flash con una puntuación de 0,9+ y un coste de $0,15/millón de fichas.

- Modelos de selección y comparación

- Haga clic en los cuadros de filtro de la parte superior de la tabla para seleccionar "Proveedor" (por ejemplo, Google, OpenAI), "Tipo" (Código abierto o Privado) o "Rango de puntuación".

- Por ejemplo, al escribir "OpenAI", la página filtrará modelos como GPT-4o, o1, etc., para que puedas comparar fácilmente su rendimiento.

- Para ver la rentabilidad, ordene por la columna "Coste" para encontrar la opción menos cara.

- Ver datos detallados de la evaluación

- Al hacer clic en el nombre de cualquier modelo (por ejemplo, Gemini-1.5-Pro), aparecerá un informe de rendimiento específico.

- El informe incluye el rendimiento del modelo en diferentes conjuntos de datos, por ejemplo, la puntuación del escenario minorista en τ-bench, la puntuación de la interacción API en ToolACE, etc.

- Los datos se presentan en forma de gráfico para visualizar los puntos fuertes y débiles del modelo en tareas multiherramienta o escenarios de contexto largo.

- Descargar conjuntos de datos de código abierto

- En la parte inferior de la página hay un enlace "Dataset", haga clic en él para ir a

https://huggingface.co/datasets/galileo-ai/agent-leaderboard. - Los usuarios pueden descargar conjuntos de datos de pruebas completos (por ejemplo, bancos de preguntas de matemáticas para BFCL, datos de dominios cruzados para xLAM) para análisis locales o desarrollo secundario.

- Para descargarla, tienes que iniciar sesión en tu cuenta de Hugging Face. Si no tienes cuenta, puedes registrarte haciendo clic en "Registrarse" en la esquina superior derecha de la página, es un proceso sencillo que sólo requiere la verificación del correo electrónico.

- En la parte inferior de la página hay un enlace "Dataset", haga clic en él para ir a

- Obtener actualizaciones

- La tabla de clasificación promete actualizarse mensualmente. Siga el blog oficial de Galileo AI (enlace al final de la página) para recibir notificaciones sobre las últimas incorporaciones de modelos.

- Por ejemplo, las peticiones recientes de los usuarios de la comunidad para unirse a Claude 3.7 Soneto y Grok 3, las respuestas oficiales se añadirán una vez que la API esté disponible.

Funciones destacadas

- Interpretación de las puntuaciones de calidad de la selección de herramientas (TSQ)

- TSQ es la métrica de evaluación principal de Agent Leaderboard que mide la precisión del modelo en el uso de la herramienta.

- Ejemplo de operación: seleccione GPT-4o y vea su puntuación TSQ de 0,9, con partidas que muestran que rinde bien en tareas colaborativas multiherramienta, pero es ligeramente más débil en escenarios de contexto largo.

- Consejo de uso: Si su proyecto implica flujos de trabajo complejos, elija un modelo con un TSQ superior a 0,85.

- Análisis de los resultados de las pruebas multidominio

- Haz clic en "Detalles de la evaluación" para ver el rendimiento del modelo en 14 pruebas de referencia.

- Ejemplo: Gemini-2.0 Flash obtuvo una puntuación de 0,92 en BFCL (Matemáticas y Educación) y de 0,89 en ToolACE (Interacción API).

- Escenario de uso: los equipos que necesiten tratar datos de aviación pueden consultar los resultados de τ-bench para seleccionar modelos especializados en este ámbito.

- Toma de decisiones con optimización de costes

- Consulte el precio de entrada/salida por millón de fichas en la columna "Coste" de la tabla.

- Ejemplo: Filtre "Coste < $1" y el resultado muestra Mistral-small-2501 ($0,5/millón de tokens), que es adecuado para proyectos con presupuesto limitado.

- Consejo: Equilibre rendimiento y gastos combinando puntuación y coste.

advertencia

- Tiempo de actualización de datos: Los datos actuales corresponden a febrero de 2025, por lo que se recomienda visitar la página con regularidad para conocer las clasificaciones más actualizadas.

- Comentarios de la comunidadSi necesitas un modelo nuevo (por ejemplo, Grok 3), deja un mensaje en la página de Hugging Face y la respuesta oficial se basará en la disponibilidad de la API.

- requisito técnico: La página web tiene pocos requisitos de red, pero se requiere una conexión estable para descargar el conjunto de datos, y se recomienda el uso de ordenadores de sobremesa.

Con estos pasos, los usuarios pueden empezar rápidamente a utilizar Agent Leaderboard, una herramienta que proporciona ayuda práctica tanto si buscan modelos de alto rendimiento como si investigan los detalles técnicos de los agentes de IA.

© declaración de copyright

Derechos de autor del artículo Círculo de intercambio de inteligencia artificial Todos, por favor no reproducir sin permiso.

Artículos relacionados

Sin comentarios...