Agent AI: Exploring the Frontier World of Multimodal Interaction [Fei Fei Li - Lecturas clásicas obligatorias].

Base de conocimientos de IAActualizado hace 1 año Círculo de intercambio de inteligencia artificial 85K 00

Agent AI: Surveying the Horizons of Multimodal Interaction.

Original: https://ar5iv.labs.arxiv.org/html/2401.03568

resúmenes

Es probable que los sistemas de IA multimodal sean omnipresentes en nuestra vida cotidiana. Un enfoque prometedor para que estos sistemas sean más interactivos consiste en implementarlos como inteligencias en entornos físicos y virtuales. En la actualidad, los sistemas utilizan los modelos de base existentes como elementos básicos para crear inteligencias incorporadas. Integrar las inteligencias en esos entornos contribuye a la capacidad del modelo para procesar e interpretar datos visuales y contextuales, lo que es fundamental para crear sistemas de IA más complejos y conscientes del contexto. Por ejemplo, un sistema capaz de percibir el comportamiento del usuario, el comportamiento humano, los objetos del entorno, las representaciones sonoras y la emoción colectiva de una escena puede utilizarse para informar y guiar la respuesta de un organismo inteligente en un entorno determinado. Para acelerar el estudio de las inteligencias basadas en la inteligencia multimodal, definimos la "IA de agente" como una clase de sistemas interactivos que pueden percibir estímulos visuales, entradas lingüísticas y otros datos basados en el entorno, y pueden producir comportamientos corporales significativos. En concreto, exploramos sistemas que pretenden mejorar la predicción de inteligencias basadas en el siguiente comportamiento encarnado mediante la integración de conocimientos externos, entradas multisensoriales y retroalimentación humana. Argumentamos que la ilusión de los grandes modelos de base y su tendencia a producir resultados ambientalmente incorrectos también pueden mitigarse desarrollando sistemas de IA corporal inteligente en entornos aterrizados. El campo emergente de la "IA de agentes" abarca los aspectos corporales e inteligentes más amplios de la interacción multimodal. Además de las inteligencias que actúan e interactúan en el mundo físico, prevemos un futuro en el que las personas puedan crear fácilmente cualquier escenario de realidad virtual o simulación e interactuar con inteligencias integradas en el entorno virtual.

![Agent AI: 探索多模态交互的边界-1 Agent AI: 探索多模态交互的前沿世界[李飞飞-经典必读]](https://aisharenet.com/wp-content/uploads/2025/01/6dbf9ac2da09ee1.png)

Figura 1: Visión general de un sistema de IA agente que puede percibir y actuar en diferentes dominios y aplicaciones.La IA agente se perfila como una vía prometedora hacia la Inteligencia Artificial General (IAG).El entrenamiento de la IA agente ha demostrado la capacidad de realizar una comprensión multimodal en el mundo físico. Proporciona un marco para el entrenamiento independiente de la realidad aprovechando la IA generativa y múltiples fuentes de datos independientes. Cuando se entrenan con datos de realidad cruzada, los grandes modelos base entrenados para inteligencias y tareas relacionadas con la acción pueden aplicarse tanto a mundos físicos como virtuales. Mostramos una visión general de un sistema de IA agente que puede percibir y actuar en muchos dominios y aplicaciones diferentes, sirviendo potencialmente como vía hacia la AGI utilizando el paradigma del cuerpo inteligente.

directorio (en el disco duro del ordenador)

- 1 introducción

- 1.1 locomotora

- 1.2 contextos

- 1.3 esbozado

- 2 Integración de la IA en los agentes

- 2.1 Inteligencia artificial infinita

- 2.2 IA de agentes mediante modelos de base a gran escala

- 2.2.1 producto de la imaginación

- 2.2.2 Prejuicios e inclusión

- 2.2.3 Privacidad y uso de los datos

- 2.2.4 Interpretabilidad y descriptividad

- 2.2.5 Mejora del razonamiento

- 2.2.6 supervisor

- 2.3 IA de agentes para capacidades emergentes

- 3 Paradigma de IA agente

- 3.1 Grandes modelos lingüísticos y modelos lingüísticos visuales

- 3.2 Definición de transformador corporal inteligente

- 3.3 Creación de transformadores corporales inteligentes

- 4 Agente AI Aprendizaje

- 4.1 Estrategias y mecanismos

- 4.1.1 Aprendizaje por refuerzo (RL)

- 4.1.2 Aprendizaje por imitación (AI)

- 4.1.3 RGB convencional

- 4.1.4 Aprendizaje situacional

- 4.1.5 Optimización en sistemas corporales inteligentes

- 4.2 Sistemas corporales inteligentes (cero y pocos niveles de muestra)

- 4.2.1 Módulo de carrocería inteligente

- 4.2.2 Infraestructura corporal inteligente

- 4.3 Modelo de base corporal inteligente (niveles de preentrenamiento y perfeccionamiento)

- 4.1 Estrategias y mecanismos

- 5 Clasificación de la IA de los agentes

- 5.1 Dominio de Inteligencia General

- 5.2 inteligencia corporal

- 5.2.1 inteligencia móvil

- 5.2.2 inteligencia interactiva

- 5.3 Simulación e inteligencias ambientales

- 5.4 inteligencia generativa

- 5.4.1 AR/VR/Realidad mixta Cuerpo inteligente

- 5.5 Inteligencia intelectual y razonamiento lógico

- 5.5.1 Unidad de Inteligencia Intelectual (KIU)

- 5.5.2 inteligencia lógica

- 5.5.3 Inteligencia para el razonamiento emocional

- 5.5.4 Unidad de Inteligencia Neurosimbólica (NSI)

- 5.6 Grandes Inteligencias de Modelización del Lenguaje y Modelización Visual del Lenguaje

- 6 Tareas de aplicación de la IA de los agentes

- 6.1 Cuerpos inteligentes para el juego

- 6.1.1 Comportamiento de los PNJ

- 6.1.2 Interacción Persona-NPC

- 6.1.3 Análisis inteligente del juego basado en el cuerpo

- 6.1.4 Para la composición de escenas de juego

- 6.1.5 Experimentos y resultados

- 6.2 Robótica

- 6.2.1 Grandes inteligencias de modelos lingüísticos/modelos lingüísticos visuales para la robótica.

- 6.2.2 Experimentos y resultados.

- 6.3 atención sanitaria

- 6.3.1 Capacidad actual de asistencia sanitaria

- 6.4 inteligencia multimodal

- 6.4.1 Comprensión y generación de imágenes

- 6.4.2 Comprensión y generación de vídeo y lenguaje

- 6.4.3 Experimentos y resultados

- 6.5 Vídeo - Experimento lingüístico

- 6.6 Intelligentsia para el procesamiento del lenguaje natural

- 6.6.1 Inteligencia de Big Language Modelling

- 6.6.2 Inteligencia universal de modelización de grandes lenguajes (ULM)

- 6.6.3 Modelo Intelligentsia de seguimiento de comandos en lenguas grandes

- 6.6.4 Experimentos y resultados

- 6.1 Cuerpos inteligentes para el juego

- 7 Inteligencia artificial de agentes en distintas modalidades, ámbitos y realidades

- 7.1 Inteligencia para la comprensión intermodal

- 7.2 Inteligencia para la comprensión entre dominios

- 7.3 Inteligencia interactiva para la intermodalidad y la interrealidad

- 7.4 Migración de la simulación a la realidad

- 8 Mejora continua y automática de la IA de los agentes

- 8.1 Datos basados en la interacción humana

- 8.2 Datos generados por el modelo base

- 9 Conjuntos de datos y tablas de clasificación de Smartbody

- 9.1 El conjunto de datos "CuisineWorld" para juegos multiinteligencia

- 9.1.1 patrón de referencia

- 9.1.2 mandatos

- 9.1.3 Indicadores y juicios

- 9.1.4 valoración

- 9.2 Conjunto de datos de preaprendizaje de audio-vídeo-lenguaje.

- 9.1 El conjunto de datos "CuisineWorld" para juegos multiinteligencia

- 10 Declaración de impacto más amplia

- 11 consideraciones éticas

- 12 Declaración sobre la diversidad

- A GPT-4V Alerta corporal inteligente Detalles

- B GPT-4V para Bleeding Edge

- C GPT-4V para Microsoft Flight Simulator

- D GPT-4V para Assassin's Creed Odyssey

- E GPT-4V para GEARS of WAR 4

- F GPT-4V para Starfield

1 Introducción

1.1 Motivación

Históricamente, los sistemas de IA se definieron en la Conferencia de Dartmouth de 1956 como "formas de vida artificial" capaces de recoger información del entorno e interactuar con él de forma útil. Inspirándose en esta definición, el grupo de Minsky en el MIT construyó en 1970 un sistema robótico denominado Demostración de Réplica, que observaba un escenario de "mundo de bloques" y reconstruía con éxito la estructura poliédrica de bloques observada. El sistema incluía módulos de observación, planificación y manipulación, lo que reveló que cada subproblema suponía un reto y requería más investigación. El campo de la IA está fragmentado en subcampos especializados que han hecho grandes progresos en la resolución de estos y otros problemas, pero la simplificación excesiva oscurece los objetivos generales de la investigación en IA.

Para superar el statu quo, es necesario volver a los fundamentos de la IA impulsados por el holismo aristotélico. Afortunadamente, las recientes revoluciones en el modelado de grandes lenguajes (LLM/Large Language Model) y el modelado de lenguajes visuales (VLM/Visual Language Model) han hecho posible la creación de nuevos tipos de inteligencias de IA que se ajustan a los ideales holísticos. Aprovechando esta oportunidad, este artículo explora modelos que integran la competencia lingüística, la cognición visual, la memoria contextual, el razonamiento intuitivo y la adaptabilidad. Explora el potencial de utilizar grandes modelos lingüísticos y modelos lingüísticos visuales para lograr esta síntesis holística. En nuestra exploración, también revisamos el diseño de sistemas basados en la "causa intencionada" de Aristóteles, es decir, la "razón de ser del sistema" teleológica, que puede haberse descuidado en anteriores desarrollos de IA.

El renacimiento del procesamiento del lenguaje natural y de la visión por ordenador se ha visto catalizado por la aparición de potentes modelos lingüísticos de gran tamaño preentrenados y modelos lingüísticos visuales. Los grandes modelos lingüísticos demuestran ahora una asombrosa capacidad para descifrar los matices de los datos lingüísticos del mundo real, a menudo igualando o incluso superando la pericia humana OpenAI (2023). Recientemente, los investigadores han demostrado que los grandes modelos lingüísticos pueden ampliarse para actuar en diversos entornos comocuerpo inteligenteque llevan a cabo acciones y tareas complejas cuando se combinan con conocimientos y módulos específicos del dominio Xi et al. (2023). Estos escenarios se caracterizan por un razonamiento complejo, la comprensión de las funciones de las inteligencias y sus entornos, y la planificación en varios pasos, poniendo a prueba la capacidad de las inteligencias para tomar decisiones muy matizadas y complejas dentro de las limitaciones de su entorno Wu et al. (2023); Meta Fundamental AI Research Diplomacy Team et al. (2022) Meta Fundamental AI Research Diplomacy Team (FAIR), Bakhtin, Brown, Dinan, Farina, Flaherty, Fried, Goff, Gray, Hu, et al. (FAIR).

Sobre la base de estos esfuerzos iniciales, la comunidad de la IA se encuentra en la cúspide de un importante cambio de paradigma que se aleja de la creación de modelos de IA para su uso en tareas pasivas y estructuradas, y se acerca a modelos capaces de asumir el papel de cuerpos dinámicos e inteligentes en entornos diversos y complejos. Con este telón de fondo, este artículo investiga el gran potencial del uso de grandes modelos lingüísticos y modelos lingüísticos visuales como inteligencias, haciendo hincapié en los modelos que combinan la competencia lingüística, la cognición visual, la memoria contextual, el razonamiento intuitivo y la adaptabilidad. El uso de grandes modelos lingüísticos y modelos lingüísticos visuales como inteligibles, sobre todo en ámbitos como los juegos, la robótica y la atención sanitaria, no sólo proporciona una plataforma rigurosa para la evaluación de los sistemas de IA más avanzados, sino que también presagia el impacto transformador que la IA centrada en los inteligibles tendrá en la sociedad y la industria. Cuando se utilicen plenamente, los modelos corporales inteligentes pueden redefinir la experiencia humana y elevar los estándares operativos. El potencial de automatización total de estos modelos anuncia un cambio drástico en la industria y la dinámica socioeconómica. Estos avances se entrelazarán con tablas de clasificación polifacéticas, no sólo desde el punto de vista tecnológico, sino también ético, como desarrollaremos en la sección 11. Profundizamos en los dominios superpuestos de estos subcampos de la IA del cuerpo inteligente e ilustramos su interconexión en la Figura 1.

1.2 Antecedentes

A continuación presentaremos trabajos de investigación relevantes que apoyan el concepto, los fundamentos teóricos y las implementaciones modernas de la Inteligencia Artificial para Cuerpos Inteligentes.

Modelos de base a gran escala.

Los grandes modelos lingüísticos y los modelos lingüísticos visuales han impulsado los esfuerzos para desarrollar máquinas inteligentes de propósito general (Bubeck et al., 2023; Mirchandani et al., 2023). Aunque se entrenan utilizando grandes corpus de texto, sus capacidades superiores de resolución de problemas no se limitan al dominio canónico del procesamiento del lenguaje. Los grandes modelos lingüísticos tienen el potencial de manejar tareas complejas que antes se consideraban dominio exclusivo de los expertos humanos o de algoritmos específicos del dominio, desde el razonamiento matemático (Imani et al., 2023; Wei et al., 2022; Zhu et al., 2022) hasta la respuesta a cuestiones jurídicas especializadas (Blair-Stanek et al., 2023; Choi et al.) 2023; Nay, 2022). Investigaciones recientes han demostrado que es posible generar planes complejos para IA robóticas y de juegos utilizando grandes modelos lingüísticos (Liang et al., 2022; Wang et al., 2023a, b; Yao et al., 2023a; Huang et al., 2023a), lo que marca un hito importante en el uso de grandes modelos lingüísticos como inteligencias inteligentes de propósito general.

IA incorporada.

Algunos trabajos han utilizado grandes modelos lingüísticos para realizar la planificación de tareas (Huang et al., 2022a; Wang et al., 2023b; Yao et al., 2023a; Li et al., 2023a), en particular el conocimiento del dominio a escala de la World Wide Web y las capacidades emergentes de cero muestras incorporadas de grandes modelos lingüísticos para realizar la planificación y el razonamiento de tareas complejas. La investigación robótica reciente también ha utilizado grandes modelos de lenguaje para realizar la planificación de tareas (Ahn et al., 2022a; Huang et al., 2022b; Liang et al., 2022) descomponiendo los comandos de lenguaje natural en una serie de subtareas (ya sea en forma de lenguaje natural o de código Python), que luego se ejecutan utilizando un controlador de bajo nivel. Además, incorporan retroalimentación del entorno para mejorar el rendimiento de la tarea (Huang et al., 2022b), (Liang et al., 2022), (Wang et al., 2023a) e (Ikeuchi et al., 2023).

Aprendizaje interactivo:

Las inteligencias artificiales diseñadas para el aprendizaje interactivo funcionan mediante una combinación de técnicas de aprendizaje automático e interacción con el usuario. Inicialmente, las inteligencias IA se entrenan con un gran conjunto de datos. Este conjunto de datos contiene varios tipos de información, dependiendo de la función prevista de las inteligencias. Por ejemplo, una IA diseñada para una tarea lingüística se entrenaría con un gran corpus de datos de texto. El entrenamiento implica el uso de algoritmos de aprendizaje automático, que pueden incluir modelos de aprendizaje profundo (por ejemplo, redes neuronales). Estos modelos de entrenamiento permiten a la IA reconocer patrones, hacer predicciones y generar respuestas basadas en los datos sobre los que se ha entrenado. Las inteligencias artificiales también pueden aprender de las interacciones en tiempo real con los usuarios. Este aprendizaje interactivo puede producirse de varias maneras: 1) Aprendizaje basado en la retroalimentación: la IA ajusta sus respuestas basándose en la retroalimentación directa del usuario Li et al. (2023b); Yu et al. (2023a); Parakh et al. (2023); Zha et al. (2023); Wake et al. (2023a, b, c). Por ejemplo, si el usuario corrige la respuesta de la IA, ésta puede utilizar esta información para mejorar futuras respuestas Zha et al. (2023); Liu et al. (2023a). 2) Aprendizaje observacional: la IA observa las interacciones del usuario y aprende implícitamente. Por ejemplo, si un usuario hace preguntas similares con frecuencia o interactúa con la IA de una manera determinada, la IA puede adaptar sus respuestas para ajustarse mejor a estos patrones. Permite a las inteligencias IA comprender y procesar el lenguaje humano, los entornos multimodales, interpretar situaciones de realidad cruzada y generar respuestas de los usuarios humanos. Con el tiempo, el rendimiento de las inteligencias IA suele seguir mejorando gracias a una mayor interacción y retroalimentación de los usuarios. Este proceso suele estar supervisado por un operador o desarrollador humano que se asegura de que la IA está aprendiendo adecuadamente y no está desarrollando sesgos o patrones incorrectos.

1.3 Panorama general

La IA de agente multimodal (MAA/Multimodal Agent AI) es un conjunto de sistemas que generan acciones eficaces en un entorno determinado basándose en la comprensión de entradas sensoriales multimodales. Con la aparición del Modelo de Lenguaje Amplio (LLM/Large Language Model) y el Modelo de Lenguaje Visual (VLM/Visual Language Model), se han propuesto varios sistemas de IA de agentes multimodales en ámbitos que van desde la investigación básica hasta las aplicaciones. Aunque estas áreas de investigación están evolucionando rápidamente a través de la integración con técnicas tradicionales en cada dominio (por ejemplo, el interrogatorio visual y la navegación mediante lenguaje visual), comparten intereses comunes como la recopilación de datos, la evaluación comparativa y las perspectivas éticas. En este artículo, nos centramos en algunas áreas de investigación representativas de la IA para inteligencias multimodales, a saber, la multimodalidad, los juegos (VR/AR/MR), la robótica y la asistencia sanitaria, y nuestro objetivo es proporcionar un conocimiento exhaustivo sobre las preocupaciones comunes que se debaten en estas áreas. Así, queremos aprender los fundamentos de la IA para las inteligencias multimodales y obtener conocimientos para seguir avanzando en su investigación. Los resultados específicos del aprendizaje incluyen:

- Una visión general de la Inteligencia Artificial para la Inteligencia Multimodal: una mirada en profundidad a sus principios y su papel en las aplicaciones contemporáneas, que proporciona a los investigadores una comprensión exhaustiva de su importancia y sus usos.

- METODOLOGÍA: Estudios de casos de juegos, robótica y atención sanitaria detallan cómo los modelos de macrolenguaje y los modelos de lenguaje visual pueden mejorar la inteligencia artificial de las inteligencias multimodales.

- Evaluación del rendimiento: guía para evaluar inteligencias multimodales AI utilizando conjuntos de datos pertinentes, centrándose en su eficacia y capacidad de generalización.

- Consideraciones éticas: debate sobre las implicaciones sociales y las clasificaciones éticas del despliegue de IA en cuerpos inteligentes, destacando las prácticas de desarrollo responsable.

- Tendencias emergentes y gráficos de futuro: clasifica los últimos avances en cada área y analiza las orientaciones futuras.

Las inteligencias de acción y generalistas basadas en el ordenador (AG/Agente Generalista) son útiles para muchas tareas. Para que un Cuerpo Inteligente Generalista sea realmente valioso para sus usuarios, debe poder interactuar de forma natural y generalizarse a una amplia gama de contextos y modalidades. Nuestro objetivo es fomentar un vibrante ecosistema de investigación dentro de la comunidad de la IA del cuerpo inteligente y crear un sentido compartido de identidad y propósito. La IA corporal inteligente multimodal tiene potencial para aplicarse a una amplia gama de contextos y modalidades, incluida la entrada de datos humanos. Por lo tanto, creemos que este campo de la IA corporal inteligente puede atraer a una gran variedad de investigadores, fomentando así una comunidad dinámica de IA corporal inteligente y objetivos compartidos. Dirigido por expertos de renombre del mundo académico y de la industria, esperamos que este trabajo sea una experiencia interactiva y enriquecedora, que incluya tutoriales sobre el cuerpo inteligente, estudios de casos, sesiones de tareas y debates experimentales, garantizando una experiencia de aprendizaje completa y atractiva para todos los investigadores.

El objetivo de este documento es proporcionar un conocimiento general y exhaustivo de la investigación actual en el campo de la inteligencia artificial para la intelligentsia. Para ello, el resto del documento se organiza como sigue. La sección 2 esboza cómo la IA para inteligencias corporales puede beneficiarse de la integración con tecnologías emergentes relevantes, en particular los modelos de base a gran escala. La sección 3 describe el nuevo paradigma y marco que proponemos para el entrenamiento de la IA corporal inteligente. La sección 4 ofrece una visión general de los métodos más utilizados para el entrenamiento de la IA corporal inteligente. La sección 5 clasifica y analiza varios tipos de inteligibles. La Sección 6 describe las aplicaciones de la IA de cuerpo inteligente en los juegos, la robótica y la atención sanitaria. La Sección 7 explora los esfuerzos de la comunidad investigadora para desarrollar una IA de cuerpo inteligente de propósito general que pueda aplicarse a diversas modalidades y dominios, y salvar la brecha entre simulación y realidad. La sección 8 analiza el potencial de una IA corporal inteligente que no sólo se base en modelos preentrenados, sino que aprenda y mejore continuamente aprovechando las interacciones con el entorno y el usuario. La sección 9 describe nuestro nuevo conjunto de datos diseñado para entrenar la IA corporal inteligente multimodal. La sección 11 analiza el candente tema de las inteligencias de IA, las limitaciones y las consideraciones éticas de las implicaciones sociales de nuestro trabajo.

2 Cuerpo inteligente Integración de la inteligencia artificial

Como se ha sugerido en estudios anteriores, los modelos subyacentes basados en modelos de macrolenguaje y modelos de lenguaje visual siguen mostrando un rendimiento limitado en el campo de la IA incorporada, especialmente a la hora de comprender, generar, editar e interactuar en entornos o escenas invisibles Huang et al. (2023a); Zeng et al. (2023). Como resultado, estas limitaciones conducen a un rendimiento subóptimo de las inteligencias de IA. Los enfoques actuales del modelado de IA centrado en la inteligencia se centran en datos directamente accesibles y bien definidos (por ejemplo, representaciones textuales o de cadenas del estado del mundo) y suelen utilizar patrones independientes del dominio y del entorno aprendidos a partir de su preentrenamiento a gran escala para predecir los resultados de las acciones en cada entorno Xi et al. (2023); Wang et al. (2023c); Gong et al. (2023a); Wu et al. (2023). En (Huang et al., 2023a), investigamos la tarea de colaboración guiada por el conocimiento y la generación interactiva de escenas mediante la combinación de grandes modelos de base, y mostramos resultados prometedores que sugieren que las inteligencias basadas en el conocimiento de grandes modelos de lenguaje pueden mejorar el rendimiento de la comprensión, generación y edición de escenas 2D y 3D, así como otras interacciones entre humanos y ordenadores Huang et al. (2023a). ). Al integrar el marco de IA del cuerpo inteligente, el modelo de base grande es capaz de comprender las entradas del usuario con mayor profundidad, lo que da lugar a sistemas de interacción persona-ordenador complejos y adaptativos. Las capacidades emergentes de los grandes modelos de lenguaje y los modelos de lenguaje visual desempeñan un papel inédito en la interacción persona-ordenador para la IA generativa, la IA corporizada, el aumento del conocimiento para el aprendizaje multimodal, la generación de realidad mixta, la edición de texto a visión y la simulación 2D/3D en juegos o tareas de robótica. Los recientes avances en la modelización fundamental de la IA corporal inteligente proporcionan un catalizador inminente para desbloquear la inteligencia genérica en las inteligencias corporales. Los modelos de acción a gran escala o los modelos de lenguaje visual de las inteligencias abren nuevas posibilidades para los sistemas corporales genéricos, como la planificación, la resolución de problemas y el aprendizaje en entornos complejos. La IA incorporada inteligente da nuevos pasos en el metauniverso y señala el camino hacia las primeras versiones de la IA de propósito general.

![Agent AI: 探索多模态交互的世界[李飞飞-经典必读]-1 Agent AI: 探索多模态交互的前沿世界[李飞飞-经典必读]](https://aisharenet.com/wp-content/uploads/2025/01/2dd99ca44577ecf.png)

Fig. 2: Inteligencia Artificial Multimodal Smartbody para la generación 2D/3D encarnada y la edición de interacciones a través de la realidad.

2.1 Inteligencia artificial infinita

Las inteligencias artificiales tienen la capacidad de interpretar, predecir y responder basándose en su entrenamiento y en los datos de entrada. Aunque estas capacidades son avanzadas y están mejorando, es importante reconocer sus limitaciones y el impacto de los datos subyacentes sobre los que se entrenan. Los sistemas de inteligencia artificial suelen tener las siguientes capacidades: 1) Modelización predictiva: las inteligencias artificiales pueden predecir resultados probables o sugerir pasos posteriores basándose en datos históricos y tendencias. Por ejemplo, pueden predecir la continuación de un texto, la respuesta a una pregunta, la siguiente acción de un robot o la solución a un escenario.2) Toma de decisiones: en algunas aplicaciones, las inteligencias IA pueden tomar decisiones basadas en sus inferencias. Normalmente, las inteligencias tomarán decisiones basándose en lo que tiene más probabilidades de alcanzar el objetivo especificado. En el caso de aplicaciones de IA como los sistemas de recomendación, las inteligencias pueden decidir qué productos o contenidos recomendar basándose en sus inferencias sobre las preferencias del usuario.3) Tratamiento de la ambigüedad: las inteligencias de IA a menudo pueden tratar entradas ambiguas deduciendo la interpretación más probable basándose en el contexto y el entrenamiento. Sin embargo, su capacidad para hacerlo está limitada por el alcance de sus datos y algoritmos de entrenamiento.4) Mejora continua: aunque algunas inteligencias de IA tienen la capacidad de aprender de nuevos datos e interacciones, muchos grandes modelos lingüísticos no actualizan continuamente su base de conocimientos o representaciones internas después del entrenamiento. Sus inferencias suelen basarse únicamente en los datos disponibles en el momento de la última actualización del entrenamiento.

En la Figura 2 mostramos inteligencias interactivas aumentadas para la integración multimodal y agnóstica entre realidades con mecanismos emergentes. Los inteligibles de inteligencia artificial requieren la recopilación de grandes cantidades de datos de entrenamiento para cada nueva tarea, lo que puede resultar costoso o imposible para muchos dominios. En este estudio, desarrollamos un cuerpo inteligente infinito que aprende a transferir información en memoria desde un modelo base de propósito general (por ejemplo, GPT-X, DALL-E) a nuevos dominios o escenarios para la comprensión, generación y edición interactiva de escenarios en un mundo físico o virtual.

Una aplicación de estas inteligencias infinitas en robótica es RoboGen Wang et al. (2023d). En este estudio, los autores presentan un sistema para ejecutar de forma autónoma ciclos de sugerencia de tareas, generación de entornos y aprendizaje de habilidades.

2.2 Inteligencia artificial para inteligencias con grandes modelos de base

Investigaciones recientes han demostrado que los modelos base a gran escala desempeñan un papel crucial en la creación de datos que actúan como puntos de referencia para determinar las acciones de un cuerpo inteligente dentro de las restricciones impuestas por el entorno. Algunos ejemplos son el uso de modelos base para la manipulación de robots Black et al. (2023); Ko et al. (2023) y la navegación Shah et al. (2023a); Zhou et al. (2023a). Para ilustrarlo, Black et al. emplean un modelo de edición de imágenes como planificador de alto nivel para generar imágenes de submetas futuras que guíen la estrategia de bajo nivel Black et al. (2023). Para la navegación robótica, Shah et al. proponen un sistema que emplea un modelo de macrolenguaje para reconocer puntos de referencia a partir de texto y un modelo de lenguaje visual para asociar estos puntos de referencia con entradas visuales, mejorando así la navegación mediante comandos de lenguaje natural Shah et al. (2023a).

También existe un interés creciente por generar movimientos humanos condicionados y adaptados a factores lingüísticos y ambientales. Se han propuesto varios sistemas de IA para generar movimientos y acciones personalizados a órdenes lingüísticas específicas Kim et al. (2023); Zhang et al. (2022); Tevet et al. (2022) y adaptados a una variedad de escenas 3D Wang et al. (2022a). Estas investigaciones ponen de relieve la creciente capacidad de los modelos generativos para mejorar la adaptabilidad y la capacidad de respuesta de las inteligencias artificiales en diversos escenarios.

2.2.1 Alucinaciones

Las inteligencias que generan texto suelen ser propensas a las alucinaciones, es decir, situaciones en las que el texto generado carece de sentido o no coincide con el contenido fuente proporcionado Raunak et al. (2021); Maynez et al. (2020). Las alucinaciones pueden dividirse en dos categorías.ilusión interiorresponder cantandoilusión externa Ji et al. (2023). Las ilusiones intrínsecas son las que contradicen el material fuente, mientras que las extrínsecas son los casos en los que el texto generado contiene información adicional no incluida inicialmente en el material fuente.

Algunas vías prometedoras para reducir la tasa de ilusiones en la generación de lenguaje incluyen el uso de la recuperación para mejorar la generación Lewis et al. (2020); Shuster et al. (2021) u otros enfoques que apoyan la salida de lenguaje natural a través de la recuperación de conocimiento externo Dziri et al. (2021); Peng et al. (2023). Normalmente, estos enfoques pretenden mejorar la generación del lenguaje recuperando otro material fuente y proporcionando mecanismos para comprobar si existen contradicciones entre la respuesta generada y el material fuente.

En el contexto de los sistemas corporales inteligentes multimodales, también se ha demostrado que los modelos de lenguaje visual producen alucinaciones Zhou et al. (2023b). Una causa común de alucinaciones en la generación de lenguaje basado en lo visual es una dependencia excesiva de la co-ocurrencia de objetos y pistas visuales en los datos de entrenamiento Rohrbach et al. (2018). Las inteligencias de IA que dependen exclusivamente de modelos de macrolenguaje o lenguaje visual preentrenados y utilizan un ajuste fino limitado específico del contexto pueden ser particularmente propensas a las alucinaciones porque dependen de la base de conocimiento interno del modelo preentrenado para generar acciones y pueden no comprender con precisión la dinámica del estado del mundo en el que se despliegan.

2.2.2 Prejuicios e inclusión

Las inteligencias artificiales basadas en grandes modelos lingüísticos (LLM) o grandes modelos multimodales (LMM) están sesgadas debido a múltiples factores inherentes a su diseño y proceso de formación. A la hora de diseñar estas inteligencias AI, debemos tener presente la inclusión y ser conscientes de las necesidades de todos los usuarios finales y partes interesadas. En el contexto de las inteligencias IA, lano exclusividad se refiere a las medidas y principios adoptados para garantizar que las respuestas e interacciones de los organismos inteligentes sean inclusivas, respetuosas y sensibles a una amplia gama de usuarios de orígenes diversos. A continuación expondremos los aspectos clave de la parcialidad y la inclusividad de los organismos inteligentes.

- Datos de formaciónLos modelos subyacentes se entrenan a partir de grandes cantidades de datos textuales recogidos de Internet, incluidos libros, artículos, sitios web y otras fuentes textuales. Estos datos suelen reflejar prejuicios que existen en la sociedad humana, que el modelo puede aprender y reproducir inadvertidamente. Esto incluye estereotipos, prejuicios y opiniones sesgadas relacionadas con la raza, el sexo, la etnia, la religión y otros atributos personales. En particular, al entrenarse con datos de Internet, y a menudo utilizando sólo texto en inglés para el entrenamiento, los modelos aprenden implícitamente las normas culturales de las sociedades occidentales, educadas, industrializadas, ricas y democráticas (WEIRD) Henrich et al. ( 2010 ), que tienen una presencia desproporcionada en Internet. Sin embargo, es importante reconocer que los conjuntos de datos creados por humanos no pueden estar completamente libres de prejuicios, ya que a menudo reflejan prejuicios sociales, así como los de las personas que originalmente generaron y/o recopilaron los datos.

- Prejuicios históricos y culturalesLos modelos de IA se entrenan con grandes conjuntos de datos de contenido diverso. Como tales, los datos de entrenamiento incluyen a menudo textos históricos o materiales de diferentes culturas. En particular, los datos de entrenamiento procedentes de fuentes históricas pueden contener lenguaje ofensivo o despectivo que represente las normas culturales, actitudes y prejuicios de una sociedad concreta. Esto puede dar lugar a modelos que perpetúen estereotipos anticuados o que no comprendan plenamente los cambios y matices culturales contemporáneos.

- Limitaciones lingüísticas y contextualesLos modelos lingüísticos pueden tener dificultades para comprender y representar con precisión los matices del lenguaje, como la ironía, el humor o las alusiones culturales. Esto puede dar lugar a malentendidos o respuestas sesgadas en algunos casos. Además, muchos aspectos del lenguaje hablado no quedan reflejados en los datos de texto, lo que puede provocar una desconexión entre la forma en que los humanos entienden el lenguaje y la forma en que lo entienden los modelos.

- Políticas y directricesLas inteligencias artificiales se rigen por políticas y directrices estrictas para garantizar la equidad y la inclusión. Por ejemplo, al generar imágenes, existen normas para diversificar la representación de personajes y evitar estereotipos asociados a la raza, el sexo y otros atributos.

- sobregeneralizaciónEstos modelos tienden a generar respuestas basadas en patrones observados en los datos de entrenamiento. Esto puede llevar a la sobregeneralización y los modelos pueden generar respuestas que parecen estereotipar a ciertos grupos o hacer suposiciones generales.

- Seguimiento y actualización continuosEl sistema de IA se supervisa y actualiza continuamente para abordar cualquier problema de parcialidad o inclusión que pueda surgir. Los comentarios de los usuarios y la investigación en curso sobre ética de la IA desempeñan un papel fundamental en este proceso.

- Ampliar la visión dominanteComo los datos de entrenamiento suelen contener más contenidos de la cultura o el grupo dominante, el modelo puede estar más sesgado a favor de estas opiniones y, por tanto, puede subestimar o distorsionar las opiniones de los grupos minoritarios.

- Diseño ético e integradorLas herramientas de IA deben diseñarse teniendo en cuenta consideraciones éticas y la inclusión como principios básicos. Esto incluye respetar las diferencias culturales, promover la diversidad y garantizar que la IA no perpetúe estereotipos perjudiciales.

- Guía del usuarioLos usuarios también reciben instrucciones sobre cómo interactuar con la IA de forma que se fomente la inclusión y el respeto. Esto incluye evitar peticiones que puedan dar lugar a resultados sesgados o inapropiados. Además, puede ayudar a mitigar situaciones en las que el modelo aprenda material perjudicial de las interacciones de los usuarios.

A pesar de estas medidas, persisten los sesgos en las inteligencias de IA. Los esfuerzos actuales en investigación y desarrollo de IA para Intelligentsia se centran en reducir aún más estos sesgos y mejorar la inclusividad y equidad de los sistemas de IA para Intelligentsia. Esfuerzos para reducir los sesgos:

- Datos de formación diversos e inclusivos: Se están realizando esfuerzos para incluir fuentes más diversas e inclusivas en los datos de formación.

- Detección y corrección de sesgosLa investigación en curso se centra en la detección y corrección de sesgos en las respuestas de los modelos.

- Directrices y políticas éticasLos modelos suelen estar sujetos a directrices y políticas éticas destinadas a mitigar los prejuicios y garantizar interacciones respetuosas e integradoras.

- Representación diversaGarantizar que los contenidos generados o las respuestas proporcionadas por las inteligencias artificiales representen una amplia gama de experiencias, culturas, etnias e identidades humanas. Esto es especialmente relevante en escenarios como la generación de imágenes o la construcción de narrativas.

- Mitigación de sesgosTrabajar activamente para reducir los prejuicios en las respuestas de IA. Esto incluye los prejuicios relacionados con la raza, el sexo, la edad, la discapacidad, la orientación sexual y otras características personales. El objetivo es ofrecer una respuesta justa y equilibrada, no perpetuar estereotipos o prejuicios.

- Sensibilidad cultural: Los diseños de AI tienen en cuenta las diferencias culturales y reconocen y respetan la diversidad de normas, prácticas y valores culturales. Esto incluye comprender y responder adecuadamente a las referencias y matices culturales.

- accesibilidadGarantizar que las inteligencias artificiales sean accesibles a usuarios con distintas capacidades, incluidos los discapacitados. Esto puede implicar la incorporación de características que faciliten la interacción a personas con deficiencias visuales, auditivas, motoras o cognitivas.

- Inclusión lingüísticaProporcionar soporte para múltiples idiomas y dialectos para una base de usuarios global y ser sensible a los matices y variaciones intralingüísticos Liu et al. ( 2023b ).

- Interacción ética y respetuosaLa inteligencia está programada para interactuar de forma ética y respetuosa con todos los usuarios, evitando respuestas que puedan considerarse ofensivas, dañinas o irrespetuosas.

- Comentarios de los usuarios y adaptaciónIncorporar las opiniones de los usuarios para mejorar continuamente el carácter integrador y la eficacia de las inteligencias artificiales. Esto incluye aprender de las interacciones para comprender y atender mejor a una base de usuarios diversa.

- Cumplimiento de las directrices de inclusiónCumplir las directrices y normas establecidas para la inclusión de las inteligencias artificiales, que a menudo son fijadas por grupos industriales, comités de ética u organismos reguladores.

A pesar de estos esfuerzos, es importante ser consciente de la posibilidad de sesgos en las respuestas y pensar de forma crítica a la hora de interpretarlas. Las continuas mejoras en la tecnología de las inteligencias de IA y las prácticas éticas pretenden reducir estos sesgos con el tiempo. Cuerpos inteligentes Uno de los objetivos generales de la inclusión de la IA es crear un cuerpo inteligente que sea respetuoso y accesible para todos los usuarios, independientemente de su origen o identidad.

2.2.3 Privacidad y uso de los datos

Una consideración ética clave para las inteligencias de IA implica comprender cómo estos sistemas procesan, almacenan y potencialmente recuperan los datos de los usuarios. A continuación analizamos algunos aspectos clave:

Recogida, uso y finalidad de los datos.

Al utilizar los datos de los usuarios para mejorar el rendimiento de los modelos, los desarrolladores de modelos tienen acceso a los datos recopilados por las inteligencias artificiales en producción y al interactuar con los usuarios. Algunos sistemas permiten a los usuarios ver sus datos a través de su cuenta de usuario o haciendo una solicitud a un proveedor de servicios. Es importante saber qué datos recogen las inteligencias artificiales durante estas interacciones. Estos datos pueden incluir entradas de texto, patrones de uso del usuario, preferencias personales y, a veces, información personal más delicada. Los usuarios también deben entender cómo se utilizan los datos recogidos de sus interacciones. Si, por alguna razón, la IA tiene información incorrecta sobre un individuo o grupo concreto, debe haber un mecanismo para que el usuario ayude a corregir el error una vez que se haya reconocido. Esto es importante para la precisión y el respeto de todos los usuarios y grupos. Entre los usos habituales de la recuperación y el análisis de los datos de los usuarios figuran la mejora de la interacción con ellos, la personalización de las respuestas y la optimización de los sistemas. Es importante que los desarrolladores se aseguren de que los datos no se utilizan para fines para los que los usuarios no han dado su consentimiento (por ejemplo, marketing no solicitado).

Almacenamiento y seguridad.

Los desarrolladores deben saber dónde se almacenan los datos de interacción de los usuarios y las medidas de seguridad que se aplican para protegerlos de accesos no autorizados o de su divulgación. Esto incluye el cifrado, los servidores seguros y los protocolos de protección de datos. Es importante determinar si los datos del cuerpo inteligente se comparten con terceros y en qué condiciones. Esto debe ser transparente y normalmente requiere el consentimiento del usuario.

Supresión y conservación de datos.

También es importante que los usuarios entiendan cuánto tiempo se almacenan los datos de los usuarios y cómo pueden solicitar que se eliminen sus datos. Muchas leyes de protección de datos otorgan a los usuarios el derecho a ser olvidados, lo que significa que pueden solicitar que se eliminen sus datos.AI Intelligentsia debe cumplir leyes de protección de datos como el GDPR de la UE o la CCPA de California. Estas leyes regulan las prácticas de tratamiento de datos y los derechos de los usuarios sobre sus datos personales.

Portabilidad de datos y política de privacidad.

Además, los desarrolladores deben crear una política de privacidad para las inteligencias artificiales que documente y explique a los usuarios cómo se tratarán sus datos. Esta política debe detallar la recogida, el uso y el almacenamiento de los datos, así como los derechos de los usuarios. Los desarrolladores deben asegurarse de obtener el consentimiento del usuario para la recopilación de datos, especialmente para la información sensible. Por lo general, los usuarios pueden optar por excluirse o restringir los datos que facilitan. En algunas jurisdicciones, los usuarios pueden incluso tener derecho a solicitar una copia de sus datos en un formato que pueda transferirse a otro proveedor de servicios.

Anonimización.

En el caso de los datos utilizados en análisis más amplios o en el entrenamiento de IA, lo ideal sería anonimizarlos para proteger las identidades individuales. Los desarrolladores deben comprender cómo sus inteligencias artificiales recuperan y utilizan los datos históricos de los usuarios durante las interacciones. Esto puede ser para la personalización o para mejorar la relevancia de una respuesta.

En resumen, entender la privacidad de los datos para las inteligencias de IA incluye comprender cómo se recopilan, utilizan, almacenan y protegen los datos de los usuarios, y garantizar que los usuarios conozcan sus derechos de acceso, corrección y eliminación de sus datos. Comprender los mecanismos de recuperación de datos de los usuarios y de las inteligencias de IA también es fundamental para comprender plenamente la privacidad de los datos.

2.2.4 Interpretabilidad y descriptividad

Aprendizaje por imitación → desacoplamiento

Las inteligencias suelen entrenarse mediante bucles de retroalimentación continua en el aprendizaje por refuerzo (RL) o el aprendizaje por imitación (IL), partiendo de una estrategia inicializada aleatoriamente. Sin embargo, este enfoque se enfrenta a cuellos de botella a la hora de obtener recompensas iniciales en entornos desconocidos, especialmente cuando las recompensas son escasas o sólo están disponibles al final de interacciones de pasos largos. Por lo tanto, una solución superior es utilizar inteligencias de memoria infinita entrenadas mediante aprendizaje por imitación, que pueden aprender estrategias a partir de datos de expertos, lo que conduce a una mejor exploración y utilización del espacio del entorno no visto, así como de las infraestructuras emergentes, como se muestra en la figura 3. Con características expertas para ayudar a las inteligencias a explorar y explotar mejor los espacios ambientales invisibles. La IA corporal inteligente puede aprender estrategias y procesos de nuevos paradigmas directamente a partir de datos expertos.

El aprendizaje por imitación tradicional permite a las inteligencias aprender estrategias imitando el comportamiento de un demostrador experto. Sin embargo, aprender directamente las estrategias de un experto puede no ser siempre el mejor enfoque, ya que el cuerpo inteligente puede no generalizar bien a situaciones no vistas. Para resolver este problema, proponemos aprender un cuerpo inteligente con pistas contextuales o funciones de recompensa implícitas que capten aspectos clave del comportamiento del experto, como se muestra en la Figura 3. Esto equipa al cuerpo inteligente de infinito-método con una función de recompensa implícita. Esto equipa a las inteligencias de memoria infinita con datos de comportamiento del mundo físico aprendidos de demostraciones de expertos para la ejecución de tareas. Esto ayuda a superar los inconvenientes del aprendizaje por imitación existente, como la necesidad de grandes cantidades de datos de expertos y el potencial de error en tareas complejas. La idea clave de la IA del Cuerpo Inteligente tiene dos componentes: 1) el Cuerpo Inteligente Infinito, que recoge las demostraciones de expertos del mundo físico como pares de estado-acción, y 2) el entorno virtual del Generador de Imitación del Cuerpo Inteligente. El Cuerpo Inteligente de Imitación genera acciones que imitan el comportamiento del experto, mientras que el Cuerpo Inteligente aprende una política de asignación de estados a acciones reduciendo la función de pérdida de la diferencia entre las acciones del experto y las acciones generadas por la política de aprendizaje.

Desacoplamiento → Generalización

En lugar de basarse en funciones de recompensa específicas de la tarea, el cuerpo inteligente aprende de demostraciones de expertos que proporcionan un conjunto diverso de pares estado-acción que cubren varios aspectos de la tarea. A continuación, el cuerpo inteligente aprende una estrategia para asignar estados a acciones imitando el comportamiento del experto. La disociación en el aprendizaje por imitación se refiere a la separación del proceso de aprendizaje de la función de recompensa específica de la tarea, permitiendo así que las estrategias se generalicen a través de diferentes tareas sin depender explícitamente de la función de recompensa específica de la tarea. Mediante el desacoplamiento, un inteligente puede aprender de las demostraciones de los expertos y aprender una estrategia que pueda adaptarse a diversas situaciones. El desacoplamiento permite el aprendizaje por transferencia, en el que una estrategia aprendida en un dominio puede adaptarse a otros con un ajuste mínimo. Al aprender una estrategia generalizada que no está vinculada a una función de recompensa específica, un organismo inteligente puede utilizar los conocimientos que ha adquirido en una tarea para rendir bien en otras tareas relacionadas. Como el organismo inteligente no depende de una función de recompensa específica, puede adaptarse a los cambios en la función de recompensa o en el entorno sin necesidad de un reentrenamiento exhaustivo. Esto hace que las estrategias aprendidas sean más robustas y generalizables en distintos entornos. En este contexto, la disociación se refiere a la separación de dos tareas en el proceso de aprendizaje: el aprendizaje de la función de recompensa y el aprendizaje de la política óptima.

![Agent AI: 探索多模态交互的边界-3 Agent AI: 探索多模态交互的前沿世界[李飞飞-经典必读]](https://aisharenet.com/wp-content/uploads/2025/01/3cc0593b0703242.png)

Figura 3: Ejemplo de un mecanismo de interacción emergente que utiliza inteligencias para identificar texto relacionado con imágenes a partir de texto candidato. La tarea consiste en integrar información del mundo exterior utilizando inteligencias de IA multimodales de la red y muestras de interacción de conocimiento etiquetadas manualmente.

Generalización → comportamiento emergente

La generalización explica cómo pueden surgir propiedades o comportamientos emergentes a partir de componentes o reglas más simples. La idea clave es identificar los elementos básicos o reglas que controlan el comportamiento del sistema, como neuronas individuales o algoritmos básicos. Así, observando cómo estos componentes o reglas simples interactúan entre sí. Las interacciones de estos componentes conducen a menudo a la aparición de comportamientos complejos que no pueden predecirse examinando únicamente los componentes individuales. La generalización a través de distintos niveles de complejidad permite al sistema aprender principios genéricos que se aplican a estos niveles, dando lugar a propiedades emergentes. Esto permite al sistema adaptarse a nuevas situaciones, lo que demuestra la aparición de comportamientos más complejos a partir de reglas más simples. Además, la capacidad de generalizar entre distintos niveles de complejidad facilita la transferencia de conocimientos de un dominio a otro, lo que ayuda a que surjan comportamientos complejos en nuevos entornos a medida que el sistema se adapta.

2.2.5 Mejora del razonamiento

La capacidad de razonamiento de las inteligencias artificiales reside en su habilidad para interpretar, predecir y responder basándose en datos de entrada y de entrenamiento. Aunque estas capacidades son avanzadas y están mejorando, es importante reconocer sus limitaciones y el impacto de los datos subyacentes sobre los que se entrenan. En particular, en el contexto de los grandes modelos lingüísticos (LLM), se refiere a su capacidad para sacar conclusiones, hacer predicciones y generar respuestas basadas en los datos con los que se han entrenado y en las entradas que reciben.El aumento del razonamiento en las inteligencias IA se refiere al uso de herramientas, técnicas o datos adicionales para aumentar las capacidades de razonamiento natural de una IA con el fin de mejorar su rendimiento, precisión y utilidad. Esto es especialmente importante en escenarios complejos de toma de decisiones o cuando se trata de contenidos matizados o especializados. A continuación se enumeran fuentes especialmente importantes de mejora del razonamiento:

Riqueza de datos.

Incorporar fuentes de datos adicionales (a menudo externas) para proporcionar más contexto o antecedentes puede ayudar a las inteligencias IA a hacer inferencias más informadas, especialmente en áreas en las que sus datos de entrenamiento pueden ser limitados. Por ejemplo, las inteligencias artificiales pueden inferir significados a partir del contexto de un diálogo o un texto. Analizan la información dada y la utilizan para comprender la intención y los detalles relevantes de la consulta de un usuario. Estos modelos son buenos reconociendo patrones en los datos. Utilizan esta capacidad para inferir información sobre el lenguaje, el comportamiento del usuario u otros fenómenos relevantes basándose en patrones aprendidos durante el entrenamiento.

Mejora algorítmica.

Mejorar los algoritmos subyacentes de la IA para mejorar el razonamiento. Esto puede implicar el uso de modelos de aprendizaje automático más avanzados, la integración de distintos tipos de IA (por ejemplo, combinar el procesamiento del lenguaje natural (PLN) con el reconocimiento de imágenes) o la actualización de algoritmos para manejar mejor tareas complejas. El razonamiento en el modelado del lenguaje implica comprender y generar el lenguaje humano. Esto incluye captar el tono, la intención y los matices de las distintas estructuras lingüísticas.

Human in the Loop (HITL).

Involucrar a humanos para aumentar el razonamiento de la IA puede ser especialmente útil en áreas en las que el juicio humano es crítico (por ejemplo, consideraciones éticas, tareas creativas o escenarios ambiguos). Los humanos pueden orientar, corregir errores u ofrecer ideas que la inteligencia no puede deducir por sí sola.

Integración de información en tiempo real.

El uso de información en tiempo real procedente del usuario o del entorno para aumentar el razonamiento es otro enfoque prometedor para mejorar el rendimiento durante el razonamiento. Por ejemplo, una IA puede ajustar sus recomendaciones basándose en las respuestas del usuario en tiempo real o en las condiciones cambiantes de un sistema dinámico. Alternativamente, si la IA realiza una acción que viola ciertas reglas en un entorno simulado, se puede proporcionar información dinámica a la IA para ayudarla a corregirse a sí misma.

Transferencia de conocimientos interdisciplinarios.

Utilizar conocimientos o modelos de un ámbito para mejorar el razonamiento en otro resulta especialmente útil cuando se generan resultados en disciplinas especializadas. Por ejemplo, las técnicas desarrolladas para la traducción de idiomas podrían aplicarse a la generación de códigos, o los conocimientos de diagnóstico médico podrían mejorar el mantenimiento predictivo de la maquinaria.

Personalización para casos de uso específicos.

Adaptar las capacidades de razonamiento de una IA a una aplicación o sector específicos puede implicar entrenar a la IA en conjuntos de datos especializados o ajustar su modelo para que se adapte mejor a una tarea concreta, como el análisis jurídico, el diagnóstico médico o la previsión financiera. Dado que el lenguaje o la información específicos de un dominio pueden contrastar con el lenguaje de otros dominios, puede ser beneficioso afinar las inteligencias en conocimientos específicos del dominio.

Consideraciones éticas y de sesgo.

Es importante garantizar que el proceso de mejora no introduzca nuevos sesgos o problemas éticos. Para ello, hay que tener muy en cuenta el impacto sobre la imparcialidad y la transparencia de las fuentes de datos adicionales o de los nuevos algoritmos de mejora del razonamiento. En ocasiones, las inteligencias artificiales deben responder a consideraciones éticas a la hora de razonar, especialmente sobre temas delicados. Esto incluye evitar estereotipos perjudiciales, respetar la privacidad y garantizar la equidad.

Aprendizaje y adaptación continuos.

Actualice y perfeccione periódicamente las capacidades de la IA para mantenerse al día de los nuevos avances, los cambios en el panorama de los datos y la evolución de las necesidades de los usuarios.

En resumen, el aumento del razonamiento en las inteligencias artificiales implica métodos para aumentar sus capacidades de razonamiento natural con datos adicionales, algoritmos mejorados, aportaciones humanas y otras técnicas. Dependiendo del caso de uso, estas mejoras suelen ser fundamentales para gestionar tareas complejas y garantizar la precisión de los resultados de las inteligencias.

2.2.6 Reglamento

Recientemente, se han producido avances significativos en la IA corporal inteligente y su integración con sistemas corporales ha abierto nuevas posibilidades para interactuar con cuerpos inteligentes a través de experiencias más inmersivas, dinámicas y atractivas. Para acelerar este proceso y aliviar la ardua tarea que supone el desarrollo de la IA corporal inteligente, proponemos el desarrollo de un canal de interacción corporal inteligente de nueva generación basado en la IA. Desarrollar un sistema de colaboración hombre-máquina que permita a humanos y máquinas comunicarse e interactuar de forma significativa. El sistema podría aprovechar las capacidades conversacionales y la amplia gama de acciones de un Modelo de Lenguaje Amplio (LLM) o un Modelo de Lenguaje Visual (VLM) para hablar con los actores humanos e identificar sus necesidades. A continuación, realizaría las acciones adecuadas para ayudar al jugador humano según fuera necesario.

Cuando se utilizan modelos lingüísticos amplios (LLM)/modelos lingüísticos visuales (VLM) para sistemas de colaboración humano-robot, es importante tener en cuenta que estos modelos funcionan como cajas negras y producen resultados impredecibles. Esta incertidumbre puede llegar a ser crítica en entornos físicos (por ejemplo, manejando un robot real). Una forma de abordar este reto es limitar el enfoque del Modelo de Lenguaje Amplio (LLM)/Modelo de Lenguaje Visual (VLM) mediante la ingeniería de pistas. Por ejemplo, cuando se planifican tareas robóticas basadas en instrucciones, se ha observado que proporcionar información ambiental en las pistas produce resultados más estables que basarse únicamente en el texto, como en el caso de Gramopadhye y Szafir (2022). Este informe está respaldado por la teoría del marco de IA de Minsky Minsky (1975), que sugiere que el espacio del problema que debe resolver el Modelo de Lenguaje Amplio (LLM)/Modelo de Lenguaje Visual (VLM) está definido por la instrucción dada. Otro enfoque consiste en diseñar las instrucciones de forma que el Modelo de Lenguaje Extenso (LLM)/Modelo de Lenguaje Visual (VLM) contenga un texto explicativo que permita al usuario comprender en qué se centra o qué reconoce el modelo. Además, la implementación de un nivel superior que permita la validación y modificación previa a la ejecución guiada por el ser humano puede facilitar el funcionamiento de los sistemas que trabajan bajo dicha guía (Figura 4).

![Agent AI: 探索多模态交互的边界-4 Agent AI: 探索多模态交互的前沿世界[李飞飞-经典必读]](https://aisharenet.com/wp-content/uploads/2025/01/6ffe2854665853e.png)

Figura 4: Sistema de enseñanza de robótica desarrollado en Wake et al. (2023c). (Izquierda) Flujo de trabajo del sistema. El proceso consta de tres pasos: planificación de tareas, que ChatGPT Planificación de tareas robóticas basadas en instrucciones e información del entorno; Demostración, en la que el usuario demuestra secuencias de acciones visualmente. Todos los pasos son revisados por el usuario y, si alguno falla o presenta defectos, pueden revisarse los pasos anteriores según sea necesario. (derecha) Una aplicación web que permite cargar datos de demostración e interactuar entre el usuario y ChatGPT.

2.3 Inteligencia Artificial para capacidades emergentes

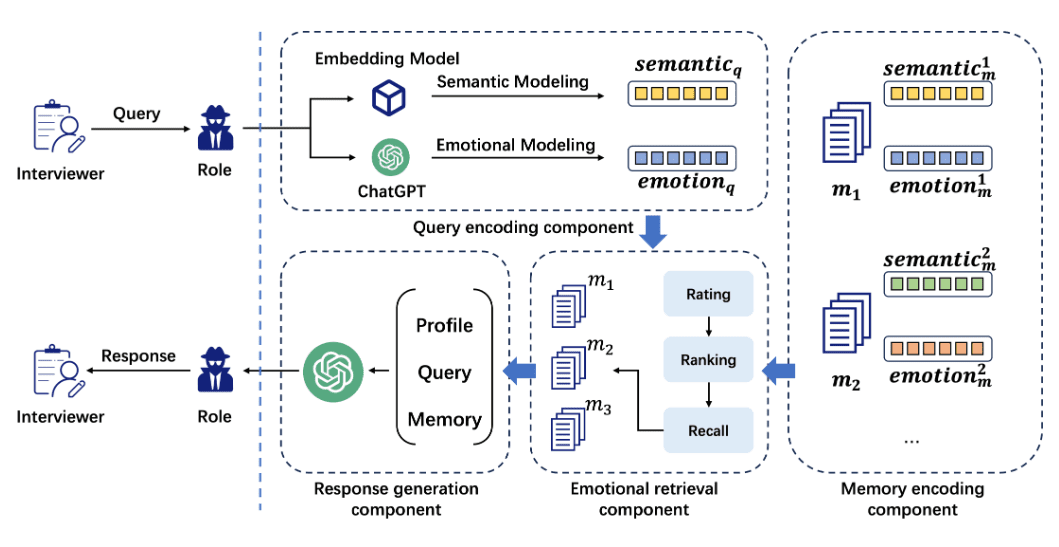

A pesar de la creciente adopción de sistemas de inteligencia artificial interactivos, la mayoría de los enfoques propuestos siguen enfrentándose a retos en términos de rendimiento de la generalización en entornos o escenarios desconocidos. Las prácticas actuales de modelización exigen que los desarrolladores preparen grandes conjuntos de datos para cada dominio con el fin de afinar/preentrenar los modelos; sin embargo, este proceso es costoso o incluso imposible si el dominio es nuevo. Para abordar este problema, construimos inteligencias interactivas que utilizan la memoria de conocimientos de modelos base genéricos (ChatGPT, Dall-E, GPT-4, etc.) para nuevos escenarios, en particular para generar espacios de colaboración entre humanos e inteligencias. Identificamos un mecanismo emergente -que denominamos realidad mixta con interacciones conocimiento-razonamiento- que facilita la colaboración con humanos para resolver tareas desafiantes en entornos complejos del mundo real, y la capacidad de explorar entornos no visibles para adaptarse a la realidad virtual. Para este mecanismo, las inteligencias aprenden i) micro-respuestas a través de las modalidades: recopilando conocimiento individual relevante para cada tarea de interacción a partir de fuentes de red explícitas (por ejemplo, para comprender escenarios no vistos) e infiriéndolo implícitamente a partir de salidas de modelos preentrenados; ii) macro-comportamientos de forma independiente de la realidad: refinando las dimensiones y los patrones de interacción en los dominios lingüístico y multimodal y razonando sobre el papel de las representaciones, sobre determinadas variables objetivo, sobre la realidad mixta y sobre la diversidad de influencias de la información colaborativa en el Gran Modelo Lingüístico (LLM) para realizar cambios. Investigamos la tarea de las sinergias de interacción guiadas por el conocimiento para la generación de escenarios en colaboración con varios modelos OpenAI y mostramos cómo el sistema Interactive Intelligentsia puede mejorar aún más los prometedores resultados de los modelos base a gran escala en nuestra configuración. Integra y mejora la profundidad de generalización, el conocimiento y la interpretabilidad de sistemas complejos de IA adaptativa.

3 Cuerpo inteligente Paradigma de la IA

En esta sección, analizamos un nuevo paradigma y marco para el entrenamiento de IA para inteligencias. Esperamos alcanzar varios objetivos con el marco propuesto:

- -

Utilizando los modelos y estrategias de preentrenamiento existentes, nuestras inteligencias son guiadas eficazmente para comprender modalidades importantes, como las entradas textuales o visuales. - -

Apoyar una capacidad adecuada de planificación de misiones a largo plazo. - -

Introducir un marco mnemotécnico que permita codificar el aprendizaje y recuperarlo posteriormente. - -

Permite utilizar la retroalimentación del entorno para entrenar eficazmente a las inteligencias para que aprendan qué acciones deben realizar.

En la figura 5 mostramos un diagrama de alto nivel de la neointeligentsia, en el que se esbozan los submódulos importantes de un sistema de este tipo.

![Agent AI: 探索多模态交互的边界-5 Agent AI: 探索多模态交互的前沿世界[李飞飞-经典必读]](https://aisharenet.com/wp-content/uploads/2025/01/893a5d2140b345e.png)

Fig. 5: Nuestra propuesta de nuevo paradigma de cuerpo inteligente para inteligencias multimodales de propósito general. Como se muestra, hay 5 módulos principales: 1) entorno y percepción, incluida la planificación de tareas y la observación de habilidades; 2) aprendizaje corporal inteligente; 3) memoria; 4) acción corporal inteligente; y 5) cognición.

3.1 Grandes modelos lingüísticos y modelos lingüísticos visuales

Podemos utilizar un Modelo de Lenguaje Extenso (LLM) o un Modelo de Lenguaje Visual (VLM) para crear los componentes de un cuerpo inteligente, como se muestra en la Figura 5. En particular, los Modelos de Lenguaje Extenso han demostrado un buen rendimiento en la planificación de tareas Gong et al. En concreto, se ha demostrado que los modelos de lenguaje de gran tamaño funcionan bien en la planificación de tareas Gong et al. (2023a), contienen una gran cantidad de conocimiento del mundo Yu et al. (2023b) y muestran un razonamiento lógico impresionante Creswell et al. (2022). Además, los modelos de lenguaje visual como CLIP Radford et al. (2021) proporcionan un codificador visual de propósito general alineado con el lenguaje, además de ofrecer capacidades de reconocimiento visual de muestra cero. Por ejemplo, los modelos multimodales de código abierto más avanzados, como LLaVA Liu et al. (2023c) e InstructBLIP Dai et al. (2023), se basan en el modelo CLIP congelado como codificador visual.

![Agent AI: 探索多模态交互的边界-4 Agent AI: 探索多模态交互的前沿世界[李飞飞-经典必读]](https://aisharenet.com/wp-content/uploads/2025/01/bbe6faec7c0ecfb.png)

Figura 6: Mostramos el paradigma actual para crear inteligencias de IA multimodales combinando grandes modelos lingüísticos (LLM) con grandes modelos visuales (LVM). Normalmente, estos modelos reciben entradas visuales o lingüísticas y utilizan modelos visuales y lingüísticos preentrenados y congelados para aprender a conectar y tender puentes entre subredes más pequeñas de modalidades. Algunos ejemplos son Flamingo Alayrac et al. (2022), BLIP-2 Li et al. (2023c), InstructBLIP Dai et al. (2023) y LLaVA Liu et al.

3.2 Definición de transformador de cuerpo inteligente

Además de utilizar modelos de macrolenguaje congelado y modelos de lenguaje visual como inteligencias de IA, se puede utilizar una única inteligencia Transformador modelo, que combina Ficha y lingüístico Token como inputs, de forma similar a Gato Reed et al. (2022). Además de visual y lingüístico, añadimos un tercer tipo genérico de entrada, que denotamos comocuerpo inteligente Ficha: Conceptualmente, una ficha de cuerpo inteligente se utiliza para reservar un subespacio específico para los comportamientos del cuerpo inteligente en el espacio de entrada y salida de un modelo. Para robots o juegos, esto puede representarse como el espacio de acción de entrada del controlador. El token de cuerpo inteligente también puede utilizarse cuando se entrena a un cuerpo inteligente para que utilice una herramienta específica, como un modelo de generación o edición de imágenes, o para otras llamadas a la API, como se muestra en la figura 7, donde podemos combinar el token de cuerpo inteligente con el token visual y lingüístico para generar una interfaz unificada para el entrenamiento de IA multimodal de cuerpo inteligente. El uso del Transformador de Cuerpo Inteligente tiene varias ventajas sobre el uso de un gran modelo lingüístico propietario como cuerpo inteligente. En primer lugar, el modelo puede personalizarse fácilmente para tareas muy específicas del cuerpo inteligente que pueden ser difíciles de representar en lenguaje natural (por ejemplo, entradas de controlador u otras acciones específicas). Así, las inteligencias pueden aprender de las interacciones con el entorno y de los datos específicos del dominio para mejorar su rendimiento. En segundo lugar, al acceder a las probabilidades de un token de un organismo inteligente, puede ser más fácil entender por qué un modelo realiza o no una acción concreta. En tercer lugar, algunos ámbitos (por ejemplo, la sanidad y el derecho) tienen requisitos estrictos en materia de privacidad de datos. Por último, un transformador de organismo inteligente relativamente pequeño puede resultar mucho más barato que un modelo de lenguaje propietario de mayor tamaño.

![Agent AI: 探索多模态交互的边界-5 Agent AI: 探索多模态交互的前沿世界[李飞飞-经典必读]](https://aisharenet.com/wp-content/uploads/2025/01/b415bfaf197bc30.png)

Fig. 7: Modelo Transformer multimodal unificado para inteligencias. En lugar de conectar submódulos congelados y utilizar los modelos base existentes como bloques de construcción, proponemos un paradigma unificado de formación de extremo a extremo para sistemas corporales inteligentes. Podemos seguir inicializando submódulos utilizando el gran modelo de lenguaje y el gran modelo de visión de la figura 6, pero también podemos utilizar tokens SmartBody, que son tokens especializados utilizados para entrenar modelos que realicen comportamientos SmartBody en dominios específicos (por ejemplo, robótica.) Para más detalles sobre los tokens SmartBody, véase la sección 3.2.

3.3 Creación de un transformador

Como se muestra en la figura 5, podemos utilizar el nuevo paradigma del cuerpo inteligente con cuerpos inteligentes guiados por modelos de lenguaje de gran tamaño y modelos de lenguaje visual, y utilizar los datos generados por el modelo de base de gran tamaño para entrenar al modelo transformador del cuerpo inteligente para que aprenda a realizar objetivos específicos. En el proceso, los modelos de cuerpo inteligente se entrenan para adaptarse específicamente a tareas y dominios concretos. Este enfoque permite aprovechar características y conocimientos aprendidos de modelos base preexistentes. A continuación mostramos una visión simplificada del proceso en dos pasos:

Definir objetivos dentro del dominio.

Para entrenar a un transformador de cuerpo inteligente, es necesario definir explícitamente el espacio de objetivos y acciones del cuerpo inteligente en cada entorno concreto. Esto incluye identificar qué tareas o acciones específicas deben realizar las inteligencias y asignar tokens de inteligencia únicos a cada tarea o acción. Además, cualquier regla o procedimiento automatizado que pueda utilizarse para reconocer la finalización satisfactoria de una tarea puede aumentar significativamente la cantidad de datos disponibles para el entrenamiento. En caso contrario, se necesitarán datos generados por el modelo base o datos anotados manualmente para entrenar el modelo. Una vez recogidos los datos y evaluado el rendimiento de las inteligencias, puede iniciarse el proceso de mejora continua.

Mejora continua.

La supervisión continua del rendimiento del modelo y la recogida de reacciones son pasos fundamentales del proceso. Los comentarios deben utilizarse para perfeccionar y actualizar el modelo. También es vital garantizar que el modelo no perpetúe resultados sesgados o poco éticos. Para ello es necesario examinar los datos de entrenamiento, comprobar periódicamente si hay sesgos en los resultados y, si es necesario, entrenar el modelo para identificar y evitar los sesgos. Una vez que el modelo alcanza un rendimiento satisfactorio, puede desplegarse en la aplicación prevista. La supervisión continua sigue siendo fundamental para garantizar que el modelo funciona como se espera y facilitar los ajustes necesarios. Para más detalles sobre este proceso, las fuentes de datos de entrenamiento y el aprendizaje continuo de la IA para las inteligencias, véase la sección 8.

4 Cuerpo de Inteligencia AI Aprendizaje

4.1 Estrategias y mecanismos

Las estrategias para la IA interactiva en distintos dominios extienden el paradigma de utilizar inteligencias entrenadas que buscan activamente recoger comentarios del usuario, información sobre acciones, conocimientos útiles para la generación e interacción para invocar grandes modelos base. A veces, no es necesario volver a entrenar el gran modelo de lenguaje/modelo de lenguaje visual, y mejoramos el rendimiento de las inteligencias proporcionándoles pistas contextuales mejoradas en el momento de la prueba. Por otro lado, siempre se trata de modelar las interacciones conocimiento/razonamiento/sentido común/razonamiento mediante una combinación de sistemas ternarios: un sistema realiza la recuperación de conocimientos a partir de consultas multimodelo, el segundo realiza la generación de interacciones a partir de las inteligencias pertinentes y el último entrena de forma mejorada nuevos entrenamientos o preentrenamientos autosupervisados ricos en información, incluido el aprendizaje por refuerzo o el aprendizaje por imitación.

4.1.1 Refuerzo del aprendizaje (RL)

Existe una larga historia de utilización del aprendizaje por refuerzo (RL) para entrenar inteligencias interactivas que muestren un comportamiento inteligente. El aprendizaje por refuerzo es un método de aprendizaje de la relación óptima entre estados y acciones basado en las recompensas (o castigos) recibidas por sus acciones. El aprendizaje por refuerzo es un marco altamente escalable que se ha aplicado a una amplia gama de aplicaciones, entre ellas la robótica. Sin embargo, suele enfrentarse a varios problemas de clasificación y los grandes modelos de lenguaje/visual han demostrado su potencial para mitigar o superar algunas de estas dificultades:

- Diseño de recompensasLa eficacia del aprendizaje de estrategias depende en gran medida del diseño de la función de recompensa. El diseño de una función de recompensa requiere no sólo una comprensión del algoritmo de aprendizaje por refuerzo, sino también un conocimiento profundo de la naturaleza de la tarea, por lo que suele ser necesario diseñar la función basándose en la experiencia de expertos. Varios estudios han explorado el uso de grandes modelos de lenguaje/modelos de lenguaje visual para diseñar funciones de recompensa Yu et al. (2023a); Katara et al. (2023); Ma et al.

- Recogida de datos y eficacia Dada su naturaleza exploratoria, el aprendizaje de estrategias basado en el aprendizaje por refuerzo requiere grandes cantidades de datos Padalkar et al. (2023). La necesidad de grandes cantidades de datos se hace especialmente evidente cuando la estrategia implica la gestión de secuencias largas o la integración de operaciones complejas. Esto se debe a que estos escenarios requieren una toma de decisiones más matizada y el aprendizaje de una gama más amplia de situaciones. En estudios recientes, se han realizado esfuerzos por mejorar la generación de datos para apoyar el aprendizaje de estrategias Kumar et al. (2023); Du et al. Además, en algunos estudios, estos modelos se han integrado en funciones de recompensa para mejorar el aprendizaje de estrategias Sontakke et al. (2023). Paralelamente a estos avances, otro estudio se centró en lograr la eficiencia de los parámetros en el proceso de aprendizaje utilizando modelos de lenguaje visual Tang et al. (2023); Li et al. (2023d) y un gran modelo de lenguaje Shi et al. (2023).

- paso longitudinal En cuanto a la eficiencia de los datos, el aprendizaje por refuerzo se vuelve más difícil a medida que aumenta la longitud de las secuencias de acciones. Esto se debe a la relación poco clara entre acciones y recompensas (conocida como el problema de la asignación de créditos), así como al aumento del número de estados que hay que explorar, lo que requiere una cantidad significativa de tiempo y datos. Un enfoque típico para tareas largas y complejas es descomponerlas en una serie de submetas y aplicar estrategias preentrenadas para resolver cada submeta (por ejemplo, Takamatsu et al. (2022)). Esta idea pertenece al marco Task and Motion Planning (TAMP) de Garrett et al. (2021). La planificación de tareas y movimientos consta de dos componentes principales: la planificación de tareas, que implica la identificación de secuencias de operaciones de alto nivel, y la planificación de movimientos, que implica la búsqueda de trayectorias físicamente coherentes y libres de colisiones para alcanzar los objetivos del plan de tareas. Los modelos de lenguaje de gran tamaño son muy adecuados para la planificación de tareas y movimientos, y las investigaciones recientes han adoptado normalmente el enfoque de que la planificación de tareas de alto nivel se lleva a cabo utilizando modelos de lenguaje de gran tamaño, mientras que el control de bajo nivel se aborda mediante estrategias basadas en el aprendizaje por refuerzo Xu et al. (2023); Sun et al. (2023a); Li et al. (2023b); Parakh et al. (2023b). Las características avanzadas de los grandes modelos de lenguaje les permiten descomponer eficazmente instrucciones abstractas en submetas Wake et al. (2023c), contribuyendo así a mejorar la comprensión del lenguaje en los sistemas robóticos.

4.1.2 Aprendizaje por imitación (AI)

Mientras que el aprendizaje por refuerzo pretende entrenar estrategias basadas en la exploración de comportamientos y la maximización de las recompensas de interactuar con el entorno, el aprendizaje por imitación (AI) pretende utilizar datos de expertos para imitar los comportamientos de inteligencias experimentadas o expertos. Por ejemplo, uno de los principales marcos para el aprendizaje basado en la imitación en robótica es la clonación conductual (BC). La clonación conductual es un método de entrenamiento de un robot para imitar las acciones de un experto mediante la copia directa. En este enfoque, se graban las acciones de un experto en la realización de una tarea específica y se entrena al robot para que reproduzca estas acciones en situaciones similares. Los enfoques recientes basados en la clonación de comportamientos suelen combinar técnicas de grandes modelos de lenguaje/modelos de lenguaje visual, que permiten modelos más avanzados de extremo a extremo. Por ejemplo, Brohan et al. presentan RT-1 Brohan et al. (2022) y RT-2 Brohan et al. (2023), modelos basados en Transformer que toman una serie de imágenes y lenguaje como entrada y secuencias de salida de acciones de la base y el brazo. Estos modelos muestran un alto rendimiento de generalización debido a que han sido entrenados con una gran cantidad de datos de entrenamiento.

4.1.3 RGB tradicional

El aprendizaje del comportamiento corporal inteligente mediante la entrada de imágenes ha sido de interés durante muchos años Mnih et al. (2015). El reto inherente al uso de datos RGB es la catástrofe dimensional. Para abordar este problema, los investigadores han utilizado más datos Jang et al. (2022); Ha et al. (2023) o han introducido un sesgo inductivo en el diseño del modelo para mejorar la eficiencia de la muestra. En particular, los autores integran estructuras 3D en la arquitectura del modelo utilizado para la manipulación Zeng et al. (2021); Shridhar et al. (2023); Goyal et al. (2023); James y Davison (2022). Para la navegación robótica, los autores Chaplot et al. (2020a, b) utilizan mapas como representación. Los mapas pueden aprenderse mediante redes neuronales que agregan todas las entradas RGB anteriores, así como mediante métodos de reconstrucción 3D como los campos de radiación neuronales Rosinol et al. (2022).

Para obtener más datos, los investigadores han utilizado simuladores gráficos para sintetizar datos sintéticos Mu et al. (2021); Gong et al. (2023b) y han intentado cerrar la brecha sim2real Tobin et al. (2017); Sadeghi y Levine (2016); Peng et al. (2018). Recientemente, se han realizado esfuerzos concertados para curar conjuntos de datos a gran escala con el objetivo de abordar la escasez de datos Padalkar et al. (2023); Brohan et al. Por otra parte, también se han investigado ampliamente técnicas de mejora de datos para aumentar la complejidad de las muestras Zeng et al. (2021); Rao et al. (2020); Haarnoja et al. (2023); Lifshitz et al.

4.1.4 Aprendizaje contextual