OpenAI schiebt o3-mini neues Modell an, geschoben von DeepSeek? Preislich immer noch nicht zu schlagen

Hochwertige KI-Inferenzmodelle werden immer beliebter.

Heute Morgen hat OpenAI ein neues Inferenzmodell veröffentlichto3-mini.

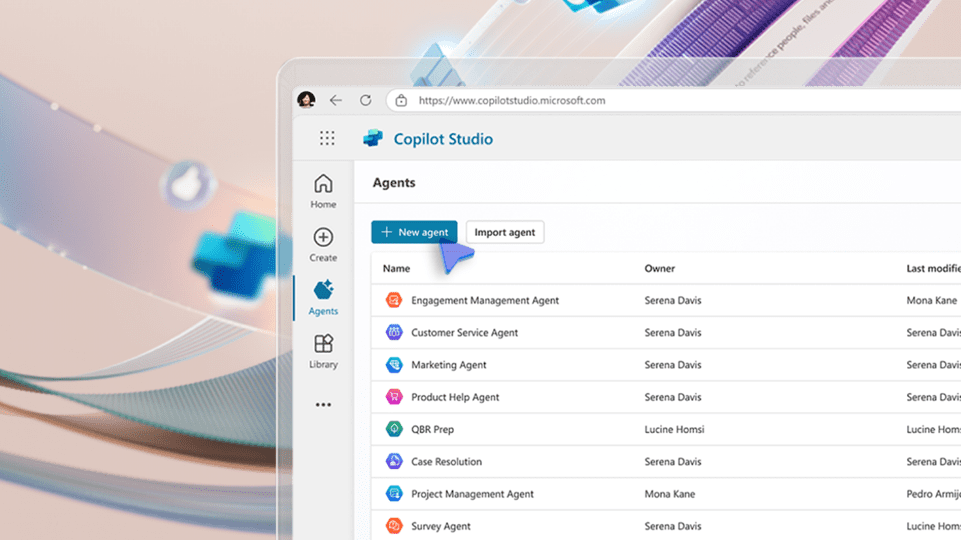

OpenAI behauptet, dass dies sein kosteneffizientestes Inferenzmodell ist, mit deutlich verbesserten komplexen Inferenz- und Dialogfähigkeiten, die das Vorgängermodell o1 in den Bereichen Wissenschaft, Mathematik, Programmierung usw. übertreffen, während die niedrigen Kosten und die geringe Latenzzeit von o1-mini beibehalten werden, undKann in Verbindung mit der Netzwerk-Suchfunktion verwendet werden.

o3-mini ist bereits in ChatGPT und API verfügbar, und der Enterprise-Zugang wird in Kürze verfügbar sein.eine WocheStart.

Offenbar hat der Aufstieg von DeepSeek an die Spitze der kostenlosen Charts des US-App-Stores Druck auf OpenAI ausgeübt.

Heute.Zum ersten Mal bietet ChatGPT kostenlose Inferenzmodelle für alle Benutzer anBenutzer können o3-mini ausprobieren, indem sie die Schaltfläche "Reason" in ChatGPT auswählen.

ChatGPT Pro-Benutzer könnenUnbeschränkter ZugangDas Tariflimit für Plus- und Team-Nutzer wurde von 50 Nachrichten pro Tag für o1-mini auf 50 Nachrichten pro Tag für o3-mini verdreifacht.150 Meldungen.

Kostenpflichtige Abonnenten haben auch die Möglichkeit, eine intelligentere Version zu erhalten.o3-mini-high". Bei dieser Version dauert es länger, bis eine Antwort erzeugt wird.

Wie das Modell o1 hat auch das Modell o3-mini eine Wissensabgrenzung vonOktober 2023Das Kontextfenster beträgt 200.000 Token bei einer maximalen Ausgabe von 100.000 Token. o3-mini ist in niedrigen, mittleren und hohen Versionen erhältlich, die Entwickler für ihre spezifischen Anwendungsfälle optimieren können.

Der o3-mini unterstützt derzeit keine visuellen Funktionen, so dass Entwickler weiterhin den o1 für visuelle Argumentationsaufgaben verwenden müssen.

Ab sofort ist o3-mini in der Chat Completions API, der Assistants API und der Batch API verfügbar. openAI behauptet, dass der Preis pro Token im Vergleich zur Einführung von GPT-4 um 95% gesenkt wurde, während die Top-Tier-Inferenz beibehalten wurde. Die API-Preise von o3-mini sind jedoch immer noch höher als die des DeepSeek-Modells.

OpenAI-Modell vs. DeepSeek-Modell API-Preisvergleich

In Bezug auf die Sicherheit stellte OpenAI fest, dass o3-mini GPT-4o in Bezug auf anspruchsvolle Sicherheit und Jailbreaking deutlich übertrifft.

01. Detail o3-mini: Weiterentwicklung wissenschaftlich-mathematischer Programmierfunktionen mit deutlich geringerer Latenzzeit

Vollständiger Text:OpenAI o3-mini Systemhandbuch (Chinesisch)

OpenAI hat einen detaillierten 37-seitigen Bericht über o3-mini veröffentlicht, der eine breite Palette von Aspekten abdeckt, wie z.B. Einführung in das Modell, Daten und Training, Umfang der Tests, Sicherheitsherausforderungen und Bewertung, externe Red-Team-Tests, Bewertung des Vorbereitungsrahmens, mehrsprachige Leistung und Schlussfolgerungen.

Der o3-mini wurde für naturwissenschaftliche, mathematische und programmiertechnische Aufgaben optimiert und ist zudem reaktionsschneller. Das Modell erzielte 0,77, 0,80 und 2036 Punkte bei den Benchmarks GPQA Diamond (Naturwissenschaften, Chemie und Biologie), AIME 2022-2024 (Mathematik) und Codeforces ELO (Programmieren). o3-mini entspricht oder übertrifft das o1-Modell für logisches Denken.

Der o3-mini übertrifft den o1-mini in der MMLU-Testreihe in 14 Sprachen signifikant, was seine Fortschritte beim mehrsprachigen Verstehen demonstriert.

Die Bewertung durch externe Experten ergab, dass der o3-mini genauere und klarere Antworten und eine bessere Argumentation lieferte als der o1-mini. Bei der Bewertung der menschlichen Präferenzen bevorzugten die Tester die Antworten des o3-mini gegenüber 561 TP3T und beobachteten eine Verringerung der signifikanten Fehler bei schwierigen realen Problemen um 391 TP3T. o3-mini schnitt bei einigen der anspruchsvollsten Bewertungen des logischen Denkens und der Intelligenz (einschließlich des AIME und des GPQA) im Bereich der mittleren logischen Fähigkeiten vergleichbar mit o1 ab.

Die Intelligenz des o3-mini ist mit der des o1 vergleichbar und bietet eine schnellere Leistung und höhere Effizienz. Das Modell zeichnet sich auch bei zusätzlichen mathematischen und faktischen Bewertungen im Rahmen der mittleren Argumentationsfähigkeit aus. In A/B-Tests beantwortete der o3-mini 241 TP3T schneller als der o1-mini, mit einer durchschnittlichen Antwortzeit von 7,7 Sekunden im Vergleich zu 10,16 Sekunden für den o1-mini.

In Mathematik schneidet o3-mini bei geringer Denkfähigkeit vergleichbar mit o1-mini ab, während o3-mini bei mittlerer Denkfähigkeit vergleichbar mit o1 abschneidet. Bei hoher Denkleistung übertrifft o3-mini hingegen o1-mini und o1.

Der o3-mini mit hoher logischer Leistung übertrifft seinen Vorgänger in FrontierMath. Im FrontierMath-Test löste der o3-mini mit hoher Argumentationsfähigkeit mehr als 321 TP3T der Probleme beim ersten Versuch, darunter mehr als 281 TP3T der anspruchsvollen (T3) Probleme.

o3-mini erreicht mit zunehmender Denkfähigkeit immer höhere Elo-Werte, die allesamt besser sind als o1-mini. Bei mittlerer Denkfähigkeit schneidet es vergleichbar mit o1 ab.

o3-mini ist das leistungsstärkste Modell von OpenAI in der SWE-Bench-Validierung.

Weitere Daten zu den SWE-Bench-Validierungsergebnissen sind unten aufgeführt. o3-mini (Tools) hatte die beste Leistung mit 611 TP3T. o3-mini listing candidate, der Agentless anstelle der internen Tools verwendet, erzielte 391 TP3T. o1 war das zweitbeste Modell mit einer Punktzahl von 481 TP3T.

Im LiveBench-Programmiertest schnitt der o3-mini mit hoher Rechenleistung durchweg besser ab als der o1-high.

02. mehrere Sicherheitsbewertungen übersteigen GPT-4o

OpenAI hat auch die Leistung von o3-mini in verschiedenen Sicherheitsbewertungen detailliert beschrieben und festgestellt, dass o3-mini in den anspruchsvollen Sicherheits- und Jailbreak-Bewertungen deutlich besser abschnitt als GPT-4o. o3-mini schnitt in der standardmäßigen Verweigerungsbewertung und der anspruchsvollen Verweigerungsbewertung in der Bewertung für nicht zugelassene Inhalte im Vergleich zu GPT-4o ähnlich ab, war aber im XSTest etwas schlechter .

In der Jailbreak-Evaluierung schneidet o3-mini im Vergleich zu o1-mini ähnlich gut ab wie Produktions-Jailbreaks, Jailbreak-erweiterte Beispiele, StrongReject und von Menschen erstellte Jailbreaks.

Bei der Beurteilung von Halluzinationen unter Verwendung des PersonQA-Datensatzes hatte der o3-mini eine Genauigkeitsrate von 21,71 TP3T und eine Halluzinationsrate von 14,81 TP3T, was einer vergleichbaren oder besseren Leistung im Vergleich zum GPT-4o und o1-mini entspricht.

Bei der Bewertung von Fairness und Voreingenommenheit schnitt der o3-mini ähnlich gut ab wie der o1-mini bei der BBQ-Bewertung, allerdings mit einem leichten Rückgang der Genauigkeit bei mehrdeutigen Fragen.

Externe Red-Team-Tests ergaben, dass der o3-mini im Vergleich zum o1 vergleichbare Leistungen erbrachte, wobei beide den GPT-4o deutlich übertrafen.

Im Gray Swan Arena Jailbreak-Test hatte o3-mini eine durchschnittliche Erfolgsquote von 3,61 TP3T, was im Vergleich zu o1-mini und GPT-4o etwas höher ist. Die Bewertung des Bereitschaftsrahmens umfasste vier Risikokategorien: Cybersicherheit, CBRN (chemische, biologische, radiologische und nukleare Bedrohungen), Überredungskunst und Modellautonomie. o3-mini wurde als "geringes Risiko" für Cybersicherheit, "mittleres Risiko" für CBRN, Überredungskunst und Modellautonomie und "mittleres Risiko" für biologische Bedrohungen eingestuft. o3-mini wurde als "geringes Risiko" eingestuft und erfüllte den Schwellenwert für "mittleres Risiko" bei der Entwicklung biologischer Bedrohungen, verfügte aber nur über begrenzte Fähigkeiten bei der Entwicklung nuklearer und radiologischer Waffen.

Entsprechend ihrer Bewertung können nur Modelle mit einer Abschwächungsquote von "mittel" oder weniger eingesetzt werden, und Modelle mit einer Quote von "hoch" oder weniger können weiter entwickelt werden.

03. o3-Benchmarking kann über 30 Mio. $ kosten, OpenAI in Gesprächen über 290 Mrd. $ an neuen Mitteln

OpenAI hat seine Inferenzmodelle seit der Veröffentlichung von o1 im letzten September weiterentwickelt, und das Ende letzten Jahres veröffentlichte o3-Modell ist die neueste Generation von KI-Inferenzmodellen. Die High-End-Version des o3-Modells zielt auf rechenintensive Anwendungen ab, während das o3-mini-Modell auf Benutzer ausgerichtet ist, die sowohl kostengünstig als auch effizient sein müssen. Dies spiegelt die Strategie von OpenAI wider, ein Gleichgewicht zwischen Zugänglichkeit und kostenpflichtigen Premium-Angeboten zu schaffen.

In den letzten zwei Tagen, ich weiß nicht, ob es von DeepSeek vorangetrieben wurde oder um den o3-mini aufzuwärmen, war OpenAI-Mitbegründer Sam Altman auf Social-Media-Plattformen sehr aktiv, lobte DeepSeek R1 erneut als beeindruckend, sagte, dass OpenAI bessere Modelle liefern wird, und betonte, dass mehr Berechnungen wichtig sind.

Gestern machte er eine große AnkündigungErster kompletter 8-Rack GB200 NVL72-Serverläuft auf Microsoft Azure für OpenAI.

Der am Freitag veröffentlichte Bericht der indischen Regierung zum Wirtschaftsbericht 2024-2025 legt nahe, dass OpenAI über30 Millionen Dollarum sein neuestes KI-Inferenzmodell, o3, zu testen. Der Bericht schreibt, dass der Durchbruch bei der Rechenleistung des OpenAI o3-Modells einen sehr hohen Preis hatte. Das ARC-AGI-Benchmarking gilt als eine der anspruchsvollsten KI-Aufgaben, und das ineffizient konfigurierte Modell von OpenAI führte zu den$200,000Die Kosten für ein effizientes Modell sind sogar höher als die Kosten für ein ineffizientes Modell. Die Kosten für ein effizientes Modell sind sogar höher als die Kosten für ein ineffizientes Modell172 MalDas ist ungefähr34,4 Millionen Dollar.

Altman postete neulich auch ein Foto mit dem Microsoft-Vorsitzenden und CEO Satya Nadella, auf dem zu sehen ist, dass die nächste Phase der Partnerschaft zwischen Microsoft und OpenAI viel besser sein wird, als man es sich hätte vorstellen können.

Aber Microsofts Ruf als größter Investor in OpenAI könnte von der japanischen SoftBank Group weggenommen werden. Der Gründer und CEO der SoftBank Group, Masayoshi Son, hat sich in letzter Zeit Altman angenähert und letzte Woche angekündigt, dass sie sich zusammentun würden, um ein KI-Megaprojekt namens "Stargate" ins Leben zu rufen und in den nächsten vier Jahren 500 Milliarden US-Dollar (etwa 3,6 Billionen Yuan) in den Aufbau der KI-Infrastruktur zu investieren, und gestern wurde bekannt, dass er die neue Finanzierungsrunde von OpenAI leiten würde. Die neue Finanzierungsrunde von OpenAI.

Ausländischen Medienberichten zufolge befindet sich OpenAI in Vorgesprächen, um in einer Finanzierungsrunde bis zu40 Milliarden US$ (etwa 290,1 Milliarden RMB)Die Bewertung wird300 Milliarden US$ (etwa 2,18 Billionen RMB). Die japanische SoftBank-Gruppe wird die Runde anführen und verhandelt über eine Investition15 Milliarden bis 25 Milliarden DollarDie restlichen Mittel werden von anderen Investoren stammen. Die verbleibenden Mittel werden von anderen Investoren stammen, zusätzlich zu dem Betrag, den SoftBank bereits in Stargate investiert hat.Über $15 MilliardenSchließlich könnte SoftBank in eine Partnerschaft mit OpenAI investieren.Über 40 Milliarden Dollar. Dies wird eine der größten Investitionen von SoftBank sein.

04. schlussfolgerung: wild zusammengewürfeltes Preis-/Leistungsverhältnis, qualitativ hochwertige KI-Schlussfolgerungsmodelle werden immer beliebter

In der Vergangenheit haben Musk und andere Technologieführer öffentlich in Frage gestellt, wie sie die enormen Kosten für den Bau des "Stargate" aufbringen können. Unter dem Einfluss des leistungsstarken und kostengünstigen Open-Source-Modells von DeepSeek sind die KI-Industrie in den USA und die Investoren an der Wall Street noch skeptischer gegenüber den großen Ausgabenstrategien anderer KI-Entwickler in den USA wie OpenAI.

Die jüngste Markteinführung von OpenAI, o3-mini, wird auch als jüngster Schritt gesehen, um den Ansturm der DeepSeek-Modelle abzuwehren, der für die Branche von besonderem Interesse ist.

In einer Pressemitteilung erklärte OpenAI, dass die Veröffentlichung des o3-mini einen weiteren Schritt in Richtung der Mission des Unternehmens darstellt, die Grenzen kostengünstiger Intelligenz zu verschieben und qualitativ hochwertige KI zugänglicher zu machen, und dass OpenAI sich verpflichtet hat, bei der Entwicklung von Modellen im großen Maßstab, die Intelligenz, Effizienz und Sicherheit in Einklang bringen, an vorderster Front zu stehen.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...