Verbesserte Generierung von Wissensgraphen Retrieval-Erweiterungen für Kundenservice-Quizzing

Adresse des Papiers: https://arxiv.org/abs/2404.17723

Wissensgraphen können Entitätsbeziehungen nur gezielt extrahieren, und solche stabil extrahierbaren Entitätsbeziehungen können verstanden werden alsAnnäherung an strukturierte Daten.

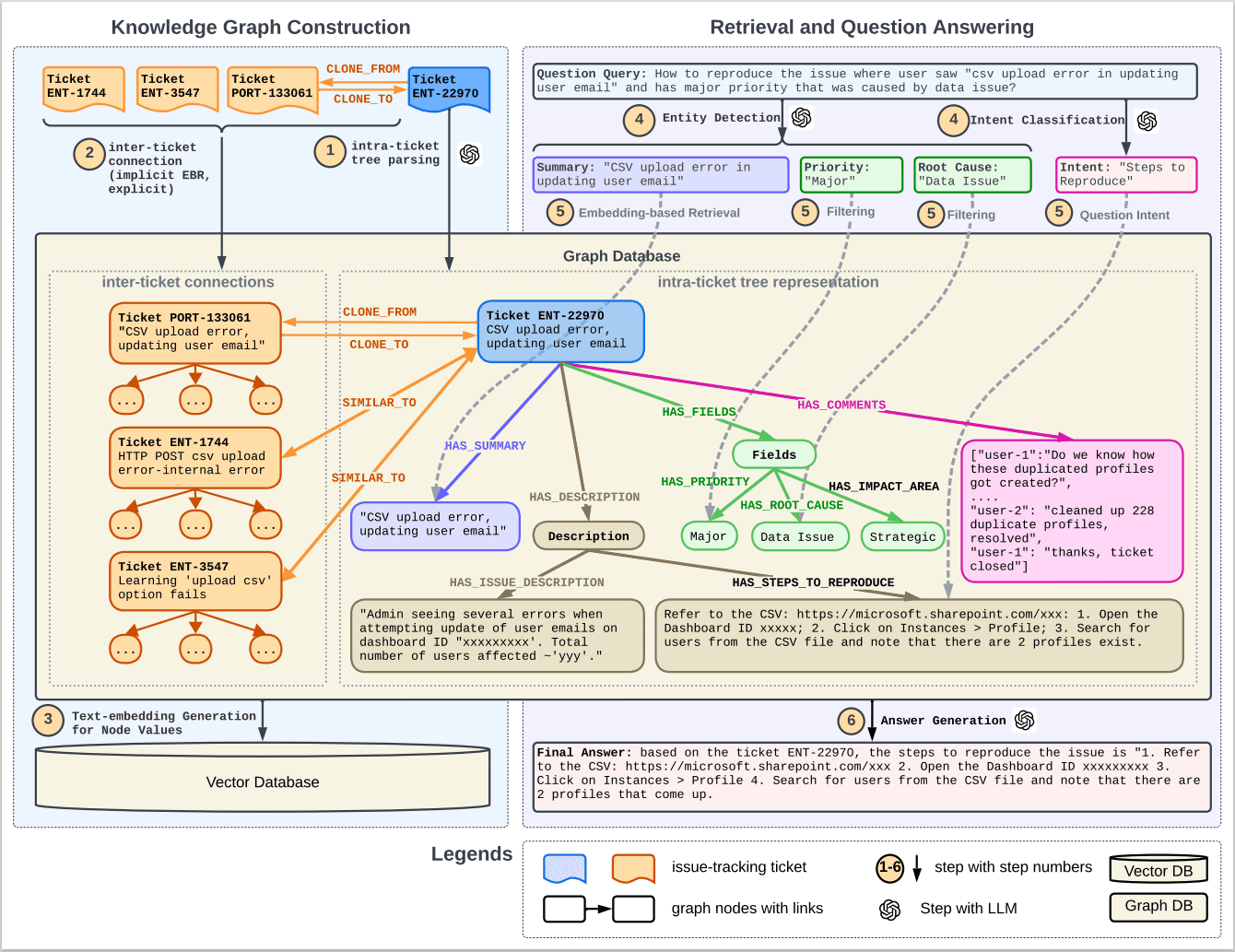

Abbildung 1 veranschaulicht den Arbeitsablauf eines Q&A-Systems für den Kundenservice, das Knowledge Graph (KG) und Retrieval Augmented Generation (RAG) kombiniert. Der Prozess wird im Folgenden zusammengefasst:

1. wissensbasiertes Mapping: Das System erstellt eine umfassende Wissenskarte auf der Grundlage historischer Kundenservice-Tickets und umfasst zwei Hauptschritte:

- Innere Ticket-Baumdarstellung: Jedes Ticket wird als Baumstruktur geparst, wobei die Knoten verschiedene Teile des Tickets darstellen (z. B. Zusammenfassung, Beschreibung, Priorität usw.).

- Inter-Ticket-Verknüpfung: Verbindung einzelner Ticket-Bäume zu einem vollständigen Graphen auf der Grundlage expliziter Verknüpfungen in Tickets zur Problemverfolgung und impliziter Verknüpfungen, die durch semantische Ähnlichkeit abgeleitet werden.

2. die Erzeugung von Einbettungen: Generierung von Einbettungsvektoren für Knoten im Graphen unter Verwendung von vortrainierten Text-Einbettungsmodellen (z.B. BERT oder E5) und Speicherung dieser Einbettungen in einer Vektordatenbank.

3. die Suche und das Frage-und-Antwort-Verfahren:

- Einbettung von Frageabsichten: Analyse von Benutzeranfragen zur Identifizierung von benannten Entitäten und Absichten.

- Einbettungsbasierte Suche: Verwendung von Entitäten zum Auffinden der relevantesten Tickets und Herausfiltern relevanter Teilgraphen.

- Filterung: weitere Überprüfung und Identifizierung der wichtigsten Informationen.

4) Abgerufene Tickets: Das System ruft bestimmte Tickets ab, die mit der Abfrage des Benutzers in Zusammenhang stehen, z. B. ENT-22970, PORT-133061, ENT-1744 und ENT-3547, und zeigt die Klon- (CLONE_FROM/CLONE_TO) und Ähnlichkeitsbeziehungen (SIMILAR_TO) zwischen ihnen an.

5) Antwortgenerierung: Schließlich wird das System die abgerufenen Informationen und die ursprüngliche Benutzeranfrage synthetisieren, um mit Hilfe eines großen Sprachmodells (LLM) eine Antwort zu generieren.

Graphdatenbank und Vektordatenbank: Während des gesamten Prozesses wird die Graphdatenbank verwendet, um die Knoten und Links im Atlas zu speichern und zu verwalten, während die Vektordatenbank verwendet wird, um die Texteinbettungsvektoren der Knoten zu speichern und zu verwalten.

7. schritte bei der Verwendung von LLM: In mehreren Schritten werden große Sprachmodelle verwendet, um Text zu analysieren, Anfragen zu generieren, Teilgraphen zu extrahieren und Antworten zu generieren.

Dieses Flussdiagramm gibt einen Überblick darüber, wie die Effizienz und Genauigkeit automatisierter Frage-Antwort-Systeme für den Kundenservice durch die Kombination von Techniken zur Erstellung von Wissensgraphen und Retrieval-Erweiterungen verbessert werden kann.

Die linke Seite dieser Abbildung zeigt den Aufbau des Wissensgraphen; die rechte Seite zeigt den Abruf- und Frage-Antwort-Prozess.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...