Es wird gezeigt, dass:RL die SFT beim Erlernen von verallgemeinerungsfähigem Wissen übertrifft, insbesondere bei multimodalen Aufgaben, die eine stärkere Fähigkeit zum logischen Denken und zur visuellen Erkennung aufweisen

kurz

Auf dem Gebiet der künstlichen Intelligenz.Grundmodell(z. B. groß angelegte Sprachmodelle und visuelle Sprachmodelle) sind zu einer zentralen Triebkraft des technologischen Fortschritts geworden. Wie können diese Modelle jedoch effektiv verbessert werden?VerallgemeinerungsfähigkeitEs ist immer noch eine große Herausforderung, sie an verschiedene komplexe und sich verändernde reale Szenarien anzupassen. Derzeit.Überwachtes Fine-Tuning (SFT) und Verstärkungslernen (RL)sind zwei weit verbreitete Post-Training-Methoden, aber ihre spezifische Rolle und Wirkung bei der Verbesserung der Generalisierungsfähigkeit von Modellen ist nach wie vor unklar.

Diese These wird unterstützt durch eineEingehende vergleichende StudieWir untersuchen systematisch die Auswirkungen von SFT und RL auf die Verallgemeinerungsfähigkeit des zugrunde liegenden Modells. Wir konzentrieren uns auf die folgenden zwei Schlüsselaspekte:

- Textuelle regelbasierte Generalisierung: Wir haben ein System entwickelt, das AllgemeinePunkte eines arithmetischen Kartenspiels, bei dem die Leistung des Modells unter verschiedenen Regelvarianten bewertet wird.

- Visuelle Verallgemeinerung: Wir haben die V-IRL Aufgabe, eine Navigationsumgebung, die auf realem visuellem Input basiert, um die Fähigkeit des Modells zu testen, sich an Veränderungen des visuellen Inputs anzupassen.

Durch eine Reihe vonStrenge Experimente und Analysensind wir zu den folgenden wichtigen Schlussfolgerungen gelangt:

- RL übertrifft SFT sowohl bei der Regel- als auch bei der visuellen Generalisierung: RL ist in der Lage, neue Regeln effizient zu erlernen und anzuwenden und gleichzeitig eine gute Leistung bei Variationen des visuellen Inputs beizubehalten. Im Gegensatz dazu neigt SFT dazu, sich Trainingsdaten zu merken und hat Schwierigkeiten, sich an ungesehene Varianten anzupassen.

- RL verbessert die visuelle Erkennung: Bei der visuellen Sprachmodellierung (VLM) verbessert RL nicht nur das logische Denken, sondern auch die visuelle Erkennung, während SFT die visuelle Erkennung reduziert.

- SFT ist entscheidend für die RL-Ausbildung: SFT ist ein Schlüsselfaktor für den Erfolg des RL-Trainings, wenn das Backbone-Modell den Anweisungen nicht gut folgen kann. Sie stabilisiert das Ausgabeformat des Modells, so dass RL seine Leistung voll ausschöpfen kann.

- Die Erweiterung der Anzahl der Verifikationsiterationen verbessert die RL-Generalisierung: Beim RL-Training kann eine Erhöhung der Anzahl der Validierungsiterationen die Generalisierung des Modells weiter verbessern.

Diese ErkenntnisseLiefert wertvolle Erkenntnisse für künftige KI-Forschung und -AnwendungenIn dieser Studie wird gezeigt, dass RL mehr Potenzial bei komplexen multimodalen Aufgaben hat. Unsere Studie zeigt nicht nur die unterschiedlichen Rollen von SFT und RL auf, sondern liefert auch neue Ideen, wie diese beiden Ansätze effektiver kombiniert werden können, um leistungsfähigere und zuverlässigere zugrunde liegende Modelle zu konstruieren.

Ob Sie nun ein KI-Forscher, ein Ingenieur oder ein Leser sind, der sich für die Zukunft der KI interessiert, dieses Papier wird Ihnen Einblicke und praktische Hinweise geben. Lassen Sie uns tiefer in die Geheimnisse von SFT und RL eindringen, um den kritischen Pfad zur Verallgemeinerung des zugrundeliegenden Modells aufzuzeigen.

Ursprünglicher Text:https://tianzhechu.com/SFTvsRL/assets/sftvsrl_paper.pdf

Schnelllesen

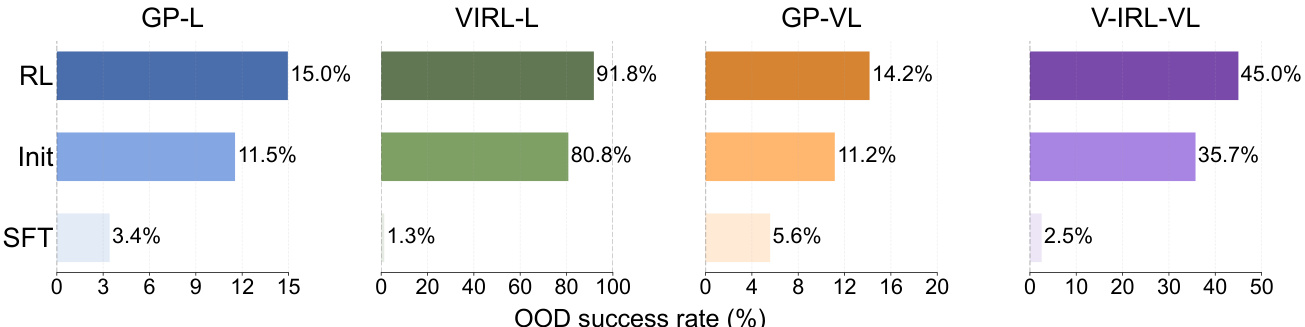

1. RL übertrifft SFT bei der Regelverallgemeinerung

Schlussfolgerung:

RL ist in der Lage, textbasierte Regeln effizient zu erlernen und zu verallgemeinern, während SFT dazu neigt, sich Trainingsdaten zu merken und Schwierigkeiten hat, sich an unbekannte Regelvarianten anzupassen.

Beispiel:

RL übertrifft SFT bei der Out-of-Distribution (OOD)-Leistung sowohl bei GeneralPoints als auch bei V-IRL-Aufgaben.

- GeneralPoints (GP-L):

- RL. Die Erfolgsquote lag bei 15,01 TP3T, was einen Anstieg gegenüber 11,51 TP3T am ersten Kontrollpunkt bedeutet. +3.5%.

- SFT. Die Erfolgsquote lag bei 3,41 TP3T, ein Rückgang gegenüber 11,51 TP3T am ersten Kontrollpunkt. -8.1%.

- V-IRL (V-IRL-L):

- RL. Die Genauigkeit pro Schritt betrug 91,8%, was eine Verbesserung gegenüber dem anfänglichen Kontrollpunkt von 80,8% darstellt. +11.0%.

- SFT. Die Genauigkeit pro Schritt betrug 1,31 TP3T, gegenüber 80,81 TP3T am ersten Kontrollpunkt. -79.5%.

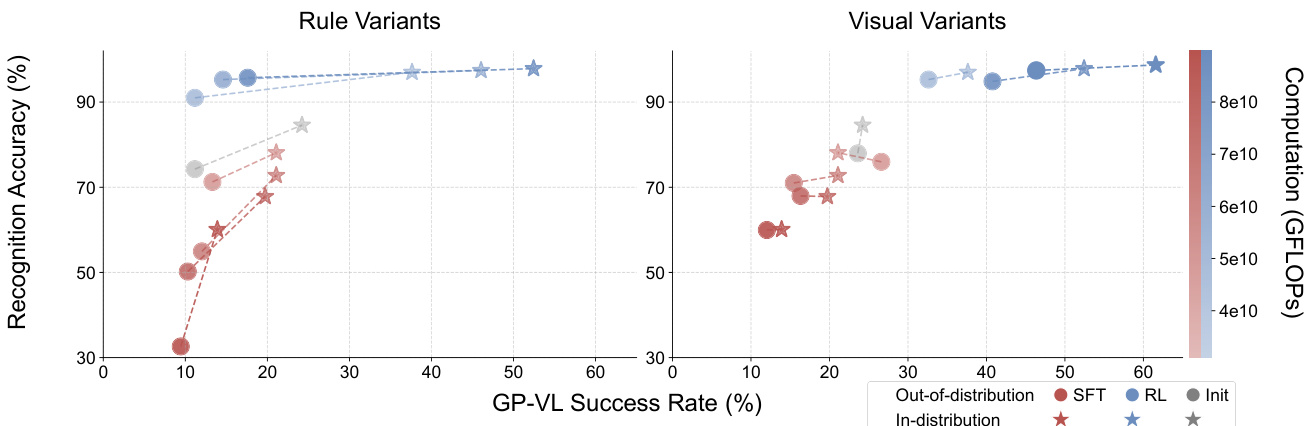

Abbildung 6: Für jeden Teilgraphen werden RL und SFT mit dem gleichen Rechenaufwand trainiert, und ihr gemeinsamer Anfangskontrollpunkt (mit Init bezeichnet) wird als Grundlinie festgelegt. Siehe Anhang C.3 für detaillierte Einstellungen.

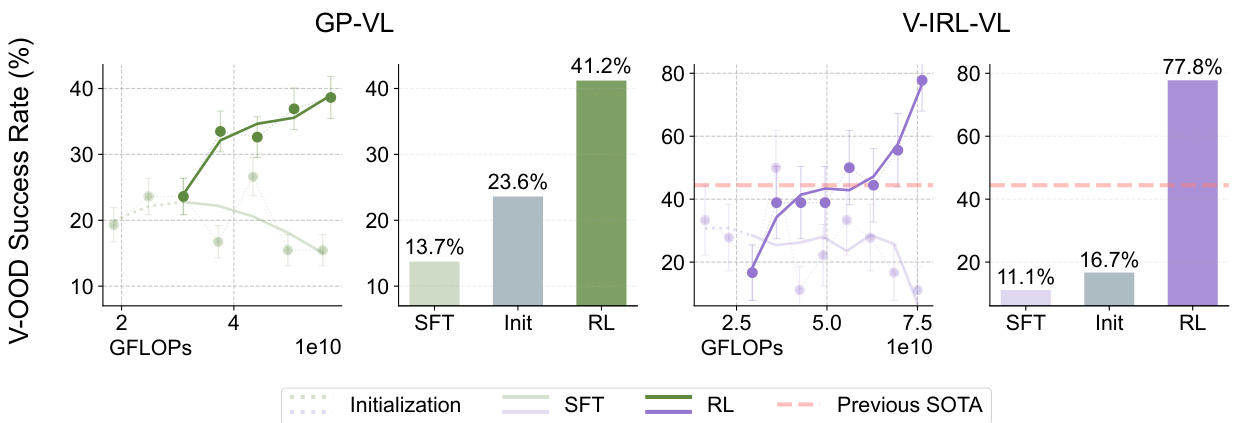

2. RL verallgemeinert sich auch bei visuellen OOD-Aufgaben, während SFT schlecht abschneidet.

Schlussfolgerung:

Selbst bei Aufgaben, die visuelle Modalitäten enthalten, ist RL immer noch in der Lage, auf unbekannte visuelle Varianten zu verallgemeinern, während SFT eine Leistungsverschlechterung erleidet.

Beispiel:

Bei den Aufgaben GeneralPoints-VI und V-IRL-VL:

- GeneralPoints-VI (GP-VI):

- RL. Die Erfolgsquote lag bei 41,21 TP3T, was einen Anstieg gegenüber 23,61 TP3T am ersten Kontrollpunkt bedeutet. +17.6%.

- SFT. Die Erfolgsquote lag bei 13,71 TP3T, gegenüber 23,61 TP3T am ersten Kontrollpunkt. -9.9%.

- V-IRL-VL (V-IRL-VL):

- RL. Die Genauigkeit pro Schritt betrug 77,81 TP3T, eine Verbesserung gegenüber den 16,71 TP3T am ersten Kontrollpunkt. +61.1%.

- SFT. Die Genauigkeit pro Schritt betrug 11,11 TP3T, gegenüber 16,71 TP3T am ersten Kontrollpunkt. -5.6%.

Abbildung 7: Ähnlich wie in den Abbildungen 5 und 6 zeigen wir die Leistungsdynamik (als Linien dargestellt) und die endgültige Leistung (als Balken dargestellt), die außerhalb der visuellen Verteilung bewertet wurde. Der bisherige Stand der Technik beim kleinen V- IRL VLN-Benchmarktest (Yang et al., 2024a) ist orange markiert. Siehe Anhang C.3 für den detaillierten Bewertungsaufbau (und die Kurvenglättung).

3. RL verbessert die visuelle Erkennung von VLMs

Schlussfolgerung:

RL verbessert nicht nur die Inferenz des Modells, sondern auch die visuelle Erkennung, während SFT die visuelle Erkennung reduziert.

Beispiel:

In der Aufgabe GeneralPoints-VI:

- RL. Mit zunehmendem Trainingsaufwand verbessern sich sowohl die visuelle Erkennungsgenauigkeit als auch die allgemeine Erfolgsquote.

- SFT. Mit zunehmendem Trainingsaufwand sinken sowohl die visuelle Erkennungsgenauigkeit als auch die allgemeine Erfolgsquote.

Abbildung 8: Vergleich der Erkennungsrate und Erfolgsrate von Reinforcement Learning (RL) und Supervised Fine Tuning (SFT) unter verschiedenen Varianten von GP-VL. Die Diagramme zeigen die Erkennungsrate (y-Achse) und die Erfolgsrate für einen Bildschirm (x-Achse), jeweils für die Daten innerhalb der Verteilung (rot) und die Daten außerhalb der Verteilung (blau). Die Transparenz der Datenpunkte (Farbbalken) stellt den Umfang der Trainingsberechnungen dar. Datenpaare, die durch Linien (⋆-◦ ) verbunden sind, werden mit denselben Kontrollpunkten bewertet. Die Ergebnisse zeigen, dass Reinforcement Learning (RL) sowohl die Erkennungsrate als auch die Gesamtgenauigkeit verbessert, wenn der Umfang der Nachtrainingsberechnungen zunimmt, während Supervised Fine-Tuning (SFT) den entgegengesetzten Trend zeigt.

Abbildung 8: Vergleich der Erkennungsrate und Erfolgsrate von Reinforcement Learning (RL) und Supervised Fine Tuning (SFT) unter verschiedenen Varianten von GP-VL. Die Diagramme zeigen die Erkennungsrate (y-Achse) und die Erfolgsrate für einen Bildschirm (x-Achse), jeweils für die Daten innerhalb der Verteilung (rot) und die Daten außerhalb der Verteilung (blau). Die Transparenz der Datenpunkte (Farbbalken) stellt den Umfang der Trainingsberechnungen dar. Datenpaare, die durch Linien (⋆-◦ ) verbunden sind, werden mit denselben Kontrollpunkten bewertet. Die Ergebnisse zeigen, dass Reinforcement Learning (RL) sowohl die Erkennungsrate als auch die Gesamtgenauigkeit verbessert, wenn der Umfang der Nachtrainingsberechnungen zunimmt, während Supervised Fine-Tuning (SFT) den entgegengesetzten Trend zeigt.

4. SFT ist für die RL-Ausbildung notwendig

Schlussfolgerung:

SFT ist für das RL-Training notwendig, wenn das Backbone-Modell keine gute Befehlsfolge hat.

Beispiel:

Alle Experimente, in denen End-to-End-RL direkt auf Llama-3.2 ohne SFT-Initialisierung angewendet wurde, endeten mit einem Fehlschlag.

- Fallstudien zum Scheitern:

- Das Modell generiert langatmige, abschweifende und unstrukturierte Antworten, die die mit dem RL-Training verbundenen Informationen und Belohnungen nicht abrufen können.

- So versucht das Modell beispielsweise, das 24-Punkte-Spiel durch das Schreiben von Code zu lösen, kann die Codegenerierung aber nicht abschließen, was zu einem Validierungsfehler führt.

![]()

Abbildung 20: Wir haben die Reaktionen des Modells mit ähnlichen Hinweisen wie in Abbildung 11 aufgezeichnet. Die Ergebnisse zeigen, dass Llama-3.2-Vision-11B die Anweisungen nicht korrekt befolgt. Wir haben lange Antworten weggelassen, die versuchten, das Rätsel durch Code zu lösen, aber innerhalb der begrenzten Kontextlänge nicht fertig wurden.

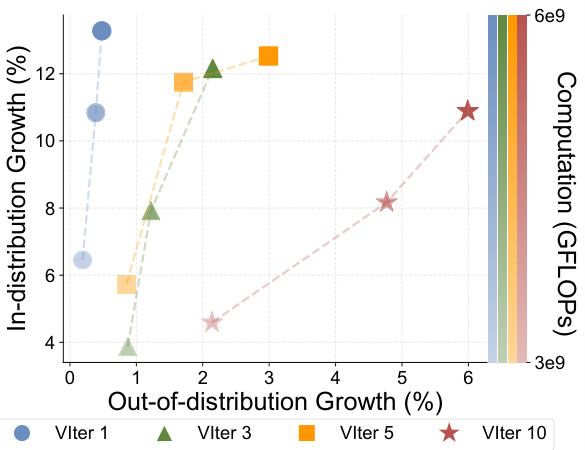

5. Die Ausweitung der Anzahl der Validierungsiterationen verbessert die Generalisierungsfähigkeit von RL

Schlussfolgerung:

Beim RL-Training verbessert eine Erhöhung der Anzahl der Validierungsiterationen die Generalisierung des Modells.

Beispiel:

In der GeneralPoints-Language (GP-L) Aufgabe:

- 1 Validierungsiteration. Die OOD-Leistung wird nur verbessert durch +0.48%.

- 3 Validierungswiederholungen. Die OOD-Leistung wird verbessert +2.15%.

- 5 Validierungswiederholungen. Die OOD-Leistung wird verbessert +2.99%.

- 10 Validierungswiederholungen. Die OOD-Leistung wird verbessert +5.99%.

Abbildung 10: Wir haben RL-Experimente mit einer unterschiedlichen Anzahl von Validierungsiterationen (VIter) aufgezeichnet, um den Umfang der Trainingsberechnungen zu erhöhen (farbliche Transparenz).

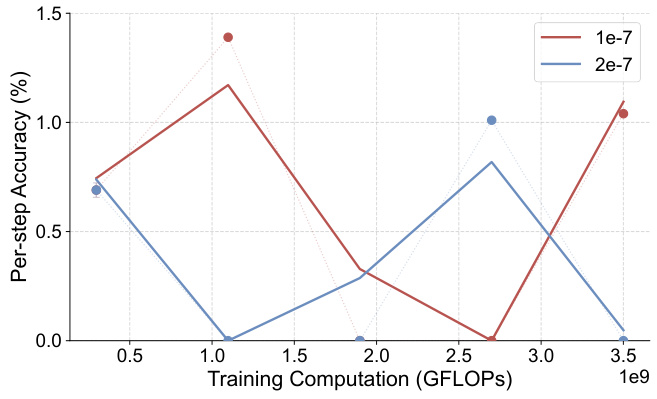

6. SFT passt sich zu stark an Inferenzmarker an und ignoriert Erkennungsmarker

Schlussfolgerung:

Die SFT neigt zu einer Überanpassung an abgeleitete Marker und zu einer Unterausrichtung auf identifizierte Marker, was möglicherweise auf die hohe Häufigkeit abgeleiteter Marker zurückzuführen ist.

Beispiel:

Bei der Aufgabe GeneralPoints-VI konnte SFT auch nach Anpassung der Hyperparameter keine mit RL vergleichbare Intraverteilungsleistung erzielen.

- SFT-Ablationsstudie.

- Nach Bereinigung um die Lernrate und andere anpassbare Komponenten lag keine der SFT-Erfolgsraten über 30% und zeigte keinen steigenden Trend.

Abbildung 16: Ablationsstudie von GeneralPoints-VL SFT. Wir haben Ablationsexperimente zur Lernrate durchgeführt und geben die Erfolgsrate (%) für alle Experimente innerhalb der Verteilung auf einem Bildschirm an. Keines der Experimente hatte Erfolgsraten über 30% und zeigte keinen steigenden Trend.

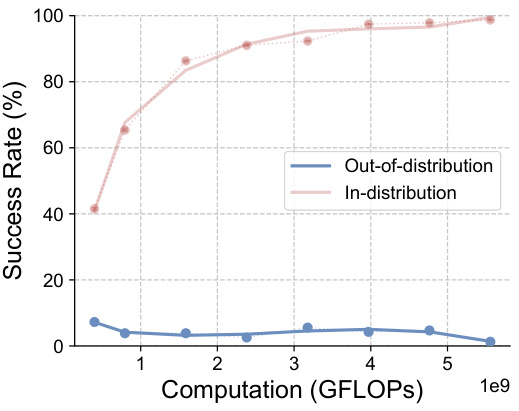

7. RL kann die OOD-Leistung von überangepassten Kontrollpunkten nicht wiederherstellen

Schlussfolgerung:

Bei der Initialisierung von einem überangepassten Prüfpunkt konnte RL die OOD-Leistung des Modells nicht wiederherstellen.

Beispiel:

In der Aufgabe V-IRL-VL:

- RL-Initialisierung aus überangepassten Kontrollpunkten: die

- Die anfängliche Genauigkeit pro Schritt ist niedriger als 1% und RL kann die OOD-Leistung nicht verbessern.

Abbildung 19: Außerhalb der Verteilung liegende Einzelschrittgenauigkeit (%) - GFLOPs: V-IRL-VL-Modell unter regulären Varianten (mit überangepassten anfänglichen Prüfpunkten). Siehe Anhang C.3 für Einzelheiten zu den Bewertungsmaßstäben.

Zusammenfassungen

Durch eine Reihe von Experimenten und Analysen zeigt diese Arbeit die Vorteile von RL beim Erlernen von verallgemeinerungsfähigem Wissen und die Tendenz von SFT, sich an Trainingsdaten zu erinnern. Die Arbeit unterstreicht auch die Bedeutung von SFT für das RL-Training und die positiven Auswirkungen einer Erhöhung der Anzahl von Validierungsiterationen auf die Generalisierungsfähigkeit von RL. Diese Ergebnisse liefern wertvolle Erkenntnisse für den Aufbau robusterer und zuverlässigerer Basismodelle in der Zukunft.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...