XTuner V1 - Shanghai AI Lab Open-Source-Trainingsmaschine für große Modelle

Was ist XTuner V1?

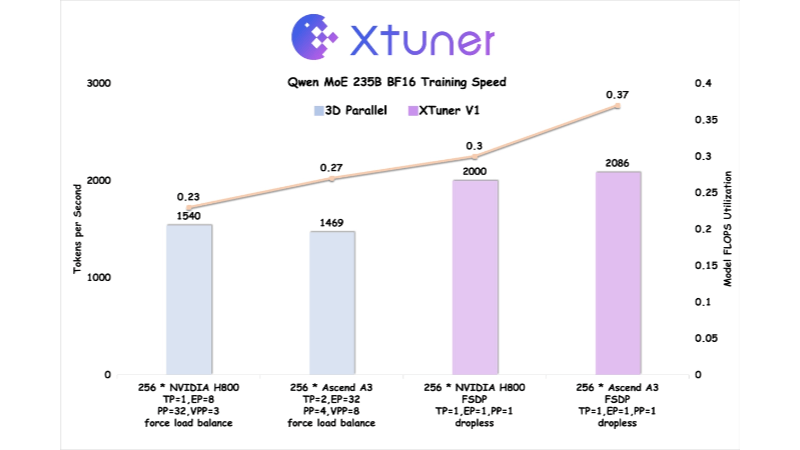

XTuner V1 ist eine neue Generation von Trainings-Engine für große Modelle, die vom Shanghai Artificial Intelligence Laboratory zur Verfügung gestellt wird und für das Training von spärlichen Mixed Expert (MoE)-Modellen in extrem großem Maßstab konzipiert wurde. XTuner V1 wurde auf der Grundlage von PyTorch FSDP entwickelt und erreicht Hochleistungs-Training durch mehrdimensionale Optimierung von Speicher, Kommunikation und Last usw. XTuner V1 unterstützt das Training von MoE-Modellen mit bis zu 1 Billion Parametern und übertrifft zum ersten Mal die traditionelle parallele 3D-Lösung in Bezug auf den Trainingsdurchsatz bei Modellen mit mehr als 200 Milliarden Skalen. Er unterstützt das Training von 64k langen Sequenzen ohne Sequenzparallelitätstechnologie, was die Abhängigkeit von Expertenparallelität erheblich reduziert und die Effizienz des Trainings langer Sequenzen verbessert.

Eigenschaften von XTuner V1

- zerstörungsfreie AusbildungMoE-Modelle im Umfang von 200 Milliarden können ohne Expertenparallelität trainiert werden, und 600-Milliarden-Modelle erfordern nur knoteninterne Expertenparallelität.

- Unterstützung langer SequenzenUnterstützt 64k Sequenzlänge Training von 200 Milliarden MoE-Modellen ohne Sequenzparallelität.

- hoher WirkungsgradUnterstützt MoE-Modell-Training mit 1 Billion Parametern und einem Durchsatz von mehr als 200 Milliarden Modell-Training im Vergleich zu herkömmlicher 3D-Parallelität.

- Optimierung des VideospeichersReduziert Grafikspeicher-Spitzen durch automatischen Chunk-Loss-Mechanismus und Async Checkpointing Swap-Technologie.

- KommunikationsabdeckungDie Kommunikationszeit wird durch Speicheroptimierung und Intra-Node-Domino-EP-Technologie reduziert.

- DP-LastausgleichEntschärfung des Problems der leeren Rechenblasen, das durch Aufmerksamkeit mit variabler Länge verursacht wird, und Aufrechterhaltung des Lastausgleichs in der parallelen Dimension der Daten.

- Hardware-Ko-OptimierungOptimiert auf dem Ascend A3 NPU Supernode in Zusammenarbeit mit Huawei Rise, übertrifft die Trainingseffizienz den NVIDIA H800.

- Open-Source- und Toolchain-UnterstützungXTuner V1, DeepTrace und ClusterX sind Open Source und bieten eine umfassende Unterstützung.

Die wichtigsten Vorteile von XTuner V1

- Effiziente AusbildungUnterstützt MoE-Modelltraining für bis zu 1 Billion Parameter mit einem Trainingsdurchsatz, der herkömmliche parallele 3D-Lösungen für 200+ Milliarden Modelle übertrifft.

- Verarbeitung langer Sequenzen64k Sequenzlänge Training von 200 Milliarden MoE-Modellen ohne Sequenzparallelität, geeignet für lange Textverarbeitungsszenarien wie Reinforcement Learning.

- geringer Ressourcenbedarf200 Milliarden parametrische Modelle erfordern keine Expertenparallelität, und 600 Milliarden Modelle erfordern nur Expertenparallelität in den Knoten, was den Bedarf an Hardware-Ressourcen reduziert.

- Optimierung des VideospeichersDie neueste Ergänzung des Systems ist eine neue Technologie, die Speicherspitzen durch automatischen Chunk Loss und Async Checkpointing Swap deutlich reduziert, wodurch größere Modelle trainiert werden können.

- Optimierung der KommunikationReduzierung der Auswirkungen des Kommunikations-Overheads auf die Trainingseffizienz durch Maskierung des Kommunikationszeitverbrauchs durch Speicheroptimierung und Intra-Node-Domino-EP-Techniken.

- LastausgleichEntschärfung des rechnerischen Nullblasenproblems, das durch Aufmerksamkeit mit variabler Länge verursacht wird, Gewährleistung des Lastausgleichs in der parallelen Dimension der Daten und Verbesserung der Trainingseffizienz.

Was ist die offizielle Website für XTuner V1

- Projekt-Website:: https://xtuner.readthedocs.io/zh-cn/latest/

- GitHub-Repository:: https://github.com/InternLM/xtuner

Personen, für die XTuner V1 bestimmt ist

- Große ModellforscherFür Forscher, die sehr große, spärliche Mixed-Expertise-Modelle (MoE) trainieren müssen, bietet XTuner V1 eine leistungsstarke Trainings-Engine, die das Training von Modellen mit bis zu 1 Billion Parametern unterstützt.

- Deep Learning-IngenieurFür Ingenieure, die an einem umfangreichen verteilten Training arbeiten, bietet XTuner V1 optimierte Kommunikations- und Speicherverwaltungsfunktionen, die die Trainingseffizienz erheblich verbessern.

- KI-Infrastruktur-EntwicklerFür Entwickler, die sich auf Hardware-Ko-Optimierung und High-Performance-Computing konzentrieren, arbeitet XTuner V1 mit dem Rise-Technologie-Team von Huawei zusammen, um tiefgreifende hardwarespezifische Optimierungen zu ermöglichen.

- Mitwirkende der Open-Source-GemeinschaftDer offene Quellcode von XTuner V1 bietet eine Fülle von Entwicklungs- und Optimierungsmöglichkeiten für Entwickler, die an Open-Source-Projekten interessiert sind und einen Beitrag leisten wollen.

- KI-Team für UnternehmenXTuner V1 bietet benutzerfreundliche und leistungsstarke Toolchain-Unterstützung für Unternehmensteams, die eine effiziente, niedrigschwellige Lösung für das Training großer Modelle benötigen.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...