Die Ergebnisse der Code-Generierung auf Projektebene liegen vor! o3/Claude 3.7 ist führend, R1 ist in der Spitzengruppe!

Am 26. Februar 2025 veröffentlichte SuperCLUE die erste Liste von Benchmarks für die Codegenerierung auf Projektebene (SuperCLUE-Project).

Für das Bewertungsprogramm siehe: Project-level Code Generation Evaluation Benchmark Release. Auf der Grundlage der Zusammenarbeit mit dem "Richtergremium" für große Modelle wird in dieser Bewertung die Fähigkeit von 12 großen Modellen aus dem In- und Ausland zur Codegenerierung auf Projektebene bewertet, die 5 Kategorien von Anwendungsszenarien abdecken, darunter Spieleentwicklung, Werkzeuge und Verwaltungssysteme. Im Folgenden finden Sie den ausführlichen Bewertungsbericht.

Zusammenfassung der Code-Messungen auf Projektebene

Zusammenfassung 1: o3-mini-high und Claude-3.7-Sonnet-Reasoning liegen in Führung

In dieser Bewertung erreichte das von OpenAI herausgegebene o3-mini-high eine Gesamtpunktzahl von 82,08 und das von Anthropic neu herausgegebene Argumentationsmodell Claude-3.7-Sonnet-Reasoning eine Gesamtpunktzahl von 81,63, wobei die beiden Hand in Hand die Liste anführten.

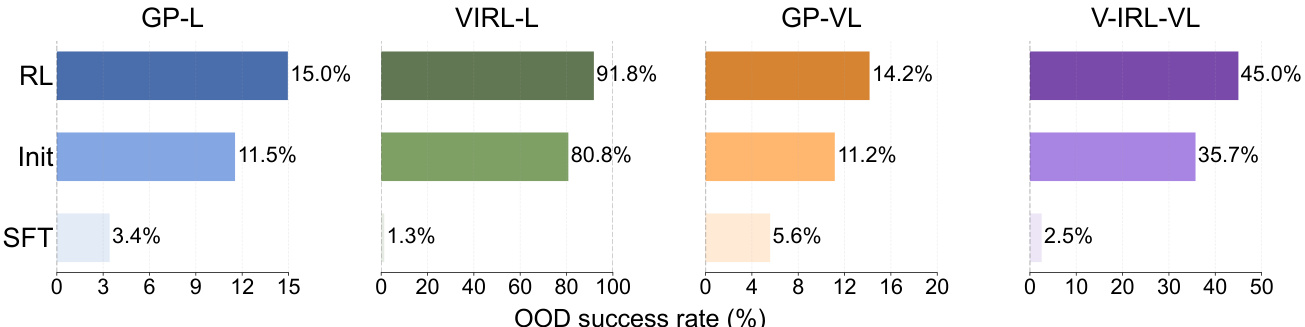

Zusammenfassung 2: DeepSeek-R1 führt inländische Modelle an und zählt zu den Spitzenreitern der Branche

Aus den Bewertungsergebnissen geht hervor, dass der Punkteabstand zwischen DeepSeek-R1 und den Spitzenmodellen der Branche wie o3-mini-high, Claude-3.5-Sonnet/3.7-Sonnet-Reasoning und Gemini-2.0-pro extrem gering ist und in einigen Anwendungsszenarien sogar eine gewisse Führungsposition erreicht.

Zusammenfassung 3: Jede hat ihre eigenen Stärken. r1 ist auf die Entwicklung von Spielen spezialisiert, o3/Step Step R auf die Bearbeitung von Multimedia-Inhalten, und mehrere sind auf Webanwendungen spezialisiert.

Die 12 Modelle, die an der Bewertung teilgenommen haben, zeigen die unterschiedlichen Fähigkeiten in verschiedenen Anwendungsszenarien, z. B. ist DeepSeek-R1 herausragend im Bereich der "Spieleentwicklung", Claude-3.5-Sonnet, Beanbag 1.5pro und Tongyiqianqian Max sind mehr auf die Entwicklung von "Webanwendungen" spezialisiert usw. Claude-3.5-Sonnet, Beanbag 1.5pro und Tongyi Qianqian Max sind eher auf die Entwicklung von "Webanwendungen" spezialisiert, während StepStar Step R-mini einen einzigartigen Vorteil bei der Entwicklung von "Multimedia-Bearbeitungswerkzeugen" usw. hat.

Zusammenfassung 4: Die verschiedenen Modelle unterscheiden sich erheblich in der Wahl der Methoden und der Gestaltung der Schnittstellen

Der Vergleich der Modellantworten zeigt, dass verschiedene Modelle bei gleichen Benutzeranforderungen sehr unterschiedliche Programmiersprachen wählen, Bibliotheken/Module aufrufen und der Ästhetik der Schnittstelle große Aufmerksamkeit schenken, was bis zu einem gewissen Grad die Unterschiede in den Fähigkeiten, Präferenzen und Konzepten der Modelle widerspiegelt.

Überblick über die Liste

SuperCLUE-Projektbewertungssystem

SuperCLUE-Project ist ein chinesischer Code-Evaluierungs-Benchmark, der entwickelt wurde, um die Fähigkeit großer Modelle zu untersuchen, die Anforderungen der Benutzer auf Projektebene in Code-Implementierungen umzusetzen.

Das SuperCLUE-Projekt konzentriert sich auf die tatsächlichen Bedürfnisse der Benutzergruppe der Nicht-Programmierer, deckt 5 Dimensionen der ersten Ebene und 18 Dimensionen der zweiten Ebene ab und erstellt die Fragensätze in natürlicher chinesischer Sprache. In Anbetracht der Charakteristika der Nicht-Programmierer-Gemeinschaft betonen wir beim Themenentwurf nur die funktionale Ebene der Anforderungsbeschreibung und setzen die Effizienz, Sicherheit, Lesbarkeit und andere Indikatoren als unabhängige Fähigkeiten der großen Modellakteure ein, die in der Bewertungssitzung bewertet werden.

Darüber hinaus haben die Benchmarks drei Schwierigkeitsgrade (leicht - mittel - komplex), die für denselben Themenkomplex ganzheitlich skaliert sind, um einen tieferen Einblick in die Code-Implementierungsfähigkeiten der Modelle auf Projektebene zu ermöglichen.

Methodik

In Anlehnung an den feinkörnigen SuperCLUE-Bewertungsansatz wird die Bewertung nach folgendem Verfahren durchgeführt:

1) Aufbau des Messsatzes

1. in Anbetracht der Dynamik des großen Bereichs der modellgestützten Low-Code/Null-Code-Entwicklung die Anforderungen an Code-Projekte von Nicht-Programmierern sammeln und zusammenstellen

2. einfache Code-Bewertungssätze auf Projektebene schreiben

3. das Format und die Anzahl der Wörter zu kontrollieren, um die Bewertung auf mittlere/komplexe Schwierigkeitsgrade zu erweitern

4. die Prüfung und manuelle Kalibrierung

2) Scoring-Verfahren

1. die Vorbereitung der Bewertungsregeln --->

2. kleine Tests zur manuellen Überprüfung der Konsistenz der Bewertungen des Schiedsrichtermodells mit denen der menschlichen Experten --->

3. iterative Abstimmung der Bewertungsregeln auf der Grundlage von Konsistenzrückmeldungen --->

4. den vollständigen Satz der zu prüfenden Modellantworten und Bewertungsregeln an die beiden Schiedsrichtermodelle weitergeben, um jeweils die vollständigen Bewertungen zu erhalten --->

5. als Endergebnis den Mittelwert der Punktzahlen der beiden Bewertungsmodelle in jeder Dimension berechnen

3) Analyse der menschlichen Kohärenz

Eine geschichtete Stichprobe der Messreihe wurde durchgeführt, um die Konsistenz der Bewertung des Schiedsrichtermodells mit der des menschlichen Experten zu prüfen, indem der Korrelationskoeffizient innerhalb der Gruppe berechnet und diese Leistung angegeben wurde.

Im Vergleich zu früheren Benchmarks werden beim SuperCLUE-Projekt zum ersten Mal sowohl inländische als auch ausländische Modelle (Gemini-2.0-flash und Qwen-Max) als Schiedsrichter bei der Durchführung der Bewertung eingesetzt, was die Verzerrungs- und Präferenzprobleme des großen Modells durch die Zusammenarbeit des "Schiedsrichterteams" weiter verringert. (Durch die Zusammenarbeit des "Schiedsrichterteams" werden die Probleme der Verzerrung und Bevorzugung des großen Modells weiter verringert.

Um die Zuverlässigkeit des Schiedsrichtermodells zu überprüfen, führt SuperCLUE-Project zum ersten Mal den Intra-Klassen-Korrelationskoeffizienten (ICC) ein und berechnet die bidirektionalen gemischten Effekte der Bewertungen von menschlichen Experten, Qwen-Max und Gemini-2.0-flash ( ICC(3,k))-Indizes wurde eine hohe Übereinstimmung des Schiedsrichtermodells mit den menschlichen Bewertungen festgestellt. Verglichen mit der bisherigen prozentualen Zuverlässigkeit überwindet diese Methode wirksam die schwankenden Auswirkungen von Zufallsfehlern.

(*Anmerkung: Der gruppeninterne Korrelationskoeffizient (ICC) ist einer der Reliabilitätskoeffizienten zur Messung und Bewertung der Inter-Beobachter-Reliabilität und der Test-Retest-Reliabilität und wurde erstmals 1966 von Bartko zur Messung und Bewertung des Ausmaßes der Zuverlässigkeit verwendet. Variabilität dividiert durch die Gesamtvariabilität. In diesem Experiment wurde der Index mit zwei gemischten Effekten als Konsistenzindex gewählt, da wir nur die Konsistenz zwischen dem ausgewählten Schiedsrichtermodell und den Bewertungen des menschlichen Experten betrachten und nicht auf andere Bewerter ausweiten müssen).

Bewertungskriterien

- Funktionale Integrität (60%): stellt sicher, dass der Code alle in den Benutzeranweisungen beschriebenen Funktionen vollständig implementiert.

- Codequalität (28%): Bewertet die Codeleistung in Bezug auf Effizienz, Lesbarkeit und Sicherheit. Umfasst insbesondere:

a. Effizienz (12%): ob der Code in Bezug auf Ressourcennutzung, DOM-Manipulation, Umgang mit Datenbanken/großen Datensätzen, Berechnungen oder API-Aufrufe ausreichend optimiert ist.

b. Lesbarkeit (8%): Ob der Code (1) die Verwendung klarer Bezeichnungen und konsistenter Formatierung, (2) die logische Aufteilung der Codebasis in Module und (3) die Beibehaltung einer klaren Projektstruktur implementiert.

c. Sicherheit (8%): Ob der Code (1) keine offensichtlichen Sicherheitslücken aufweist; und (2) grundlegende Ausnahmen effektiv behandeln kann.

- User Experience (12%): Bewertet die Qualität des Designs und der Ästhetik der Benutzeroberfläche, einschließlich der ordnungsgemäßen Funktion interaktiver Elemente (z. B. Schaltflächen, Formulare) und der grundlegenden Ästhetik der gesamten Oberfläche.

Im Vergleich zur bisherigen Gestaltung der Bewertungskriterien hat das SuperCLUE-Projekt den relativ ausgewogenen Bewertungsmechanismus geändert und die Gewichtung des Aspekts der funktionalen Umsetzung, der auch für den normalen Benutzer am wichtigsten ist, deutlich erhöht.

Darüber hinaus ist in den Bewertungskriterien des SuperCLUE-Projekts der Bewertungsmodus des Punktabzugssystems festgelegt, d. h. auf der Grundlage der standardmäßig vergebenen Gesamtpunktzahl wird auf der Grundlage des Vergleichs zwischen den Fragen und den entsprechenden Codeimplementierungen der Teil der Punktzahl abgezogen, der die Anforderungen der Fragen nicht erfüllt. Bei dieser Art von individueller Bewertungsmethode für jede einzelne Frage gleicht das Punktabzugssystem bis zu einem gewissen Grad die Unzulänglichkeiten des großen Modellreferenten bei der Prüfung der relativen Qualität von Mehrfachantworten aus und mildert die Nachteile der großen ModellbewertungStochastik.

Teilnehmende Modelle

Um den aktuellen Stand der Fähigkeit inländischer und ausländischer Großmodelle zur Lösung von Code-Anforderungen auf Projektebene umfassend zu messen, wurden sieben inländische Modelle und fünf ausländische Modelle mit hoher Repräsentativität für diese Bewertung ausgewählt.

Ergebnisse der Bewertung

Gesamtliste

Liste der Anwendungsszenarien

Überprüfung und Analyse der menschlichen Konsistenz

Um die Konsistenz der SuperCLUE-Project-Benchmarks mit menschlichen Experten wissenschaftlich zu bewerten, wählen wir aus den Bewertungsergebnissen die drei Modelle mit der besten, durchschnittlichen und schlechteren Gesamtleistung aus, schichten 33 Frage-Antwort-Paare, führen eine manuelle unabhängige Bewertung und eine Frage-für-Frage-Bewertung durch die beiden Schiedsrichtermodelle durch und berichten über die prozentuale Konsistenz der Gesamtbewertungen der drei, die Korrelationskoeffizienten der Gruppe und untersuchen wissenschaftlich die Professionalität der großen Modelle. Die Professionalität der Bewertung durch das "Schiedsrichter-Panel" wurde wissenschaftlich untersucht.

Hinweis: Ein ICC-3k-Wert von 0,75 oder höher gilt im Allgemeinen als Hinweis auf eine hohe Übereinstimmung zwischen den Beurteilern.

Bewertung Fälle

Beispiel 1 Spielentwicklung (Puzzle, schwierig)

Aufforderung:Schreiben Sie einen Code, um ein Connect-the-dots-Spiel zu implementieren, bei dem zufällig mehrfarbige, eng beieinander liegende m * n kleine Würfel erscheinen (m, n werden vom Benutzer vor Beginn des Spiels angegeben und sind ganze Zahlen größer als 5), der Benutzer klickt auf zwei Würfel, wenn die Farbe die gleiche ist und die verbundenen Pfade (nur in horizontaler und vertikaler Richtung) nicht mehr als zwei Umdrehungen haben, dann werden die beiden Würfel eliminiert; wenn die Eliminierungsregel nicht erfüllt ist, dann werden die beiden Würfel, auf die geklickt wurde Dreimal blinken. Der Spieler hat drei Chancen, die Anordnung der vorhandenen Quadrate zu stören. Gelingt es ihm, innerhalb von 3 Sekunden zwei Quadrate hintereinander zu eliminieren, wird "Combo!" auf dem Bildschirm angezeigt.

Großes Modell Ref 1 (Gemini-2.0-flash):

用户指令中包含的需求 (基于独立分析) 1.创建游戏界面: 创建一个m*n的方块网格,m和n由用户指定(大于5的整数)。 2.方块颜色随机化: 随机生成多种颜色的方块,并确保每种颜色出现偶数次,以便可以两两消除。 3.消除规则: 当用户点击两个颜色相同的方块,且它们之间可以通过不多于两次转弯的路径连接时,消除这两个方块。 4.错误提示: 如果用户点击的两个方块不满足消除规则,则点击的方块闪烁三次。 5.打乱功能: 允许玩家打乱方块排列,总共有三次机会。 6.连击奖励: 如果用户在3秒内连续成功消除两次,则显示 "Combo!"。 对代码缺陷的总体点评 该代码实现了一个基本的连连看游戏,实现了方块的随机生成、消除规则、错误提示、打乱功能和连击奖励。但是,代码在用户体验和效率方面存在一些不足。例如,方块闪烁效果不够流畅,消除方块后的界面更新不够及时。 各项标准的评分 -- 功能完整性:[[15]] 分 (实现了所有功能,包括随机生成方块、消除规则、打乱功能和连击奖励。所有核心功能均已实现,因此不扣分。) -- 代码质量:[[5]] 分,其中: 效率:[[2]] 分 (代码在生成棋盘时,先创建了一个包含所有颜色的列表,然后进行随机打乱。这种做法在m和n较大时,可能会影响效率。此外,在判断两个方块是否可以消除时,使用了广度优先搜索算法。虽然该算法可以找到最短路径,但在大规模棋盘上,可能会比较耗时。因此,扣1分。) 可读性:[[2]] 分 (代码的命名基本清晰,但部分代码块的注释不足,例如,对于广度优先搜索算法的解释不够详细。代码的整体结构良好,但可以进一步模块化,例如,将游戏逻辑和界面绘制分离。因此,不扣分。) 安全性:[[1]] 分 (代码没有明显的安全漏洞,但是,对于用户输入的m和n,只做了简单的数值范围检查,没有考虑其他异常情况,例如,用户输入非整数。因此,扣1分。) -- 用户体验:[[1]] 分 (游戏界面基本可以运行,但是,方块闪烁效果不够流畅,消除方块后的界面更新不够及时。此外,游戏缺少音效和动画效果,用户体验有待提升。因此扣2分。) 综上所述,该代码实现的总体得分为 <<21>> 分。

Großer Modell-Schiedsrichter 2 (Qwen-Max):

用户指令中包含的需求 (基于独立分析) 1. 游戏界面应随机出现多种颜色的、紧密排列的m*n个小方块,其中m和n由用户指定且均为大于5的整数。 2. 用户点击两个方块,如果颜色相同且相连接路径(仅允许水平和垂直两个方向)不多于两次转弯,则消除两方块。 3. 如果不满足消除规则,则点击的两个方块闪烁三下。 4. 玩家有三次机会可以打乱现有方块的排列。 5. 如果用户在3秒内连续成功消除两次,则在屏幕上显示"Combo!"。 对代码缺陷的总体点评 代码实现了基本的游戏逻辑,包括生成游戏板、检测方块是否相连以及处理玩家输入等。 代码结构较为清晰,但部分地方可以进一步优化以提高可读性和效率。 各项标准的评分 -- 功能完整性:[[15]] 分 该代码实现完全符合用户指令中的所有功能要求: 生成了m*n的小方块,且m和n由用户指定且均为大于5的整数。 用户点击两个方块,如果颜色相同且相连接路径不多于两次转弯,则消除两方块。 不满足消除规则时,点击的两个方块闪烁三下。 玩家有三次机会可以打乱现有方块的排列。 用户在3秒内连续成功消除两次时,在屏幕上显示"Combo!"。 -- 代码质量:[[5]] 分,其中: 效率:[[3]] 分 代码整体上对资源利用合理,没有明显的性能瓶颈。但由于未考虑极端情况下可能出现的问题,故保持满分。 可读性:[[1]] 分 虽然变量命名较清晰,但函数is_connected中的逻辑稍显复杂,不易理解。此外,主循环内的逻辑也可以通过更合理的模块化来改善。 安全性:[[1]] 分 代码缺乏对用户输入的有效验证,比如确保输入的是正整数。同时,对于某些潜在错误(如文件操作失败)也没有相应的处理机制。 -- 用户体验:[[2]] 分 游戏界面基本美观,交互元素工作正常。但是,由于方块闪烁次数符合要求,用户体验的一致性较好。 综上所述,该代码实现的总体得分为 <<22>> 分。

Gesamtbewertung: [21.5/25]

# Beispiel 2 Spielentwicklung (Shooter, Schwierig)

Aufforderung: Schreiben Sie Code, um ein einfaches Luftkampfspiel zu implementieren. Der Spieler verwendet die linke und rechte Pfeiltaste, um das Flugzeug am unteren Rand der Oberfläche zu manövrieren, um Hindernissen auszuweichen, die von oben herabfliegen, und drückt die Leertaste, um feindliche Flugzeuge von oben abzuschießen, die sich zufällig nach links und rechts bewegen und feuern. Der anfängliche Lebenswert beträgt 3. Jedes Mal, wenn du auf ein Hindernis triffst oder von einem feindlichen Flugzeug getroffen wirst, verringert sich dein Lebenswert um 1, und das Spiel endet, wenn dein Lebenswert 0 erreicht. Es gibt 3 feindliche Flugzeuge im ersten Level und 3 weitere in jedem folgenden Level. Es gibt zwei Feuermodi für das Flugzeug des Spielers: Modus A (Standard) kann nur vor das gegnerische Flugzeug feuern und zerstört es mit einem Treffer; Modus B feuert in mehrere Richtungen und erfordert zwei Treffer, um das gegnerische Flugzeug zu zerstören. Drücken Sie die Taste "Q", um zwischen Modus A und B zu wechseln.

[o3-mini-high code effect demo]:

Gesamtbewertung: [22/25]

# Beispiel 3 Quick Tools (Daily Office, Medium)

Aufforderung:Schreiben Sie Code, um ein englisches Textverarbeitungswerkzeug zu implementieren. Der Benutzer gibt den Text ein, das Werkzeug kann schnell die Anzahl der Wörter statistisch erfassen, die Worthäufigkeit sortieren, Groß- und Kleinschreibung umwandeln, Leerzeichen und Zeilenumbrüche entfernen, Zeilennummern hinzufügen und andere Operationen durchführen. Darüber hinaus kann das Tool mehrere benutzerdefinierte Ersetzungsregeln speichern und diese einheitlich ausführen. Die Benutzer können den Text in ihren Favoriten speichern und den Titel anpassen.

Gesamtbewertung: [20.5/25]

Beispiel 4 Webanwendung (Web Vision, schwierig)

Aufforderung:Schreiben Sie Code, um eine Website zur Präsentation von Mode mit mehreren (vom Benutzer hochgeladenen) Bildern zu implementieren, die sich automatisch drehen, wobei sich die Miniaturbilder am unteren Rand der Seite befinden. Die Bilder werden mit Hilfe eines visuellen Card-Flip-Effekts umgeschaltet. Wenn man mit dem Mauszeiger über ein Bild fährt, wird eine Lupe verwendet, um die Details anzuzeigen. In der oberen rechten Ecke der Seite befindet sich eine Schaltfläche "Licht ausschalten". Standardmäßig ist der Hintergrund weiß, wenn Sie auf "Licht ausschalten" klicken, wird der Hintergrund schwarz und die Schaltfläche wird zu "Licht einschalten". Der Hintergrund der Seite wirkt wie langsam fallende Blütenblätter. In der oberen linken Ecke befindet sich eine Schaltfläche mit dem Start-/Pause-Symbol, um den Start und die Pause der Bildrotation zu steuern; in der unteren rechten Ecke jedes rotierenden Bildes befindet sich ein weißes Herz-Symbol, das sich rosa färbt, wenn Sie darauf klicken, und auf der rechten Seite wird angezeigt, wie oft Sie das Herz angeklickt haben.

Gesamtbewertung: [23/25]

Beispiel 5 Webanwendung (Pädagogisches Lernen, Schwierigkeitsgrad)

Aufforderung:Schreiben Sie einen Code, um eine Website zum Auswendiglernen von Vokabeln zu implementieren, die dem Benutzer das Wort und vier Umschreibungsoptionen anzeigt; wählt der Benutzer die richtige Option, springt er/sie zum nächsten Wort; wählt er/sie die falsche Option, wird er/sie vor dem Sprung nach der richtigen Option gefragt. Jede Gruppe besteht aus fünf Wörtern, also insgesamt drei Gruppen. Nach dem Ende jeder Gruppe kann der Benutzer wählen, ob er die Studie beenden oder eine andere Gruppe von Wörtern lernen möchte. Nach Beendigung der Studie wird die Gesamtrichtigkeitsquote dieser Studie angezeigt. Die falschen Antworten des Benutzers werden automatisch aufgezeichnet, und der Benutzer kann oben auf der Benutzeroberfläche auf "Zum Überprüfungsmodus wechseln" klicken, um die falschen Fragen erneut zu beantworten. Die Reihenfolge der Fragen ist zufällig, d. h. die Reihenfolge der Fragen ist in der Regel jedes Mal anders, wenn Sie die Website aufrufen.

[Qwen-Max-Code-Effekt-Demo]:

Gesamtbewertung: [19/25]

Evaluierungsanalyse und Schlussfolgerung

1. o3-mini-high mit Claude-3.7-Sonnet-Reasoning in Führung

In dieser Bewertung erreichte das von OpenAI veröffentlichte o3-mini-high eine Gesamtpunktzahl von 82,08, während das neu veröffentlichte Inferenzmodell Claude-3.7-Sonnet-Reasoning von Anthropic eine Gesamtpunktzahl von 81,63 erreichte, und die beiden führten die Liste Hand in Hand an.

2. der DeepSeek-R1 führt die inländischen Modelle an und gehört zur Spitzengruppe der Branche

Aus den Bewertungsergebnissen geht hervor, dass DeepSeek-R1 einen sehr geringen Punkteabstand zu den Spitzenmodellen der Branche wie o3-mini-high, Claude-3.5-Sonnet/3.7-Sonnet-Reasoning, Gemini-2.0-pro usw. aufweist und seine Leistung insbesondere in den Anwendungsszenarien "Spieleentwicklung" und "Netzwerkanwendung" hervorragend ist. Die Leistung ist vor allem in den Anwendungsszenarien "Spieleentwicklung" und "Netzanwendung" herausragend und übertrifft oder erreicht das Niveau von Claude-3.5-Sonnet, Gemini-2.0-pro und anderen Modellen.

3 Jede hat ihre eigenen Stärken: R1 ist auf die Entwicklung von Spielen spezialisiert, o3/Step R auf die Bearbeitung von Multimediainhalten, und mehrere sind auf Webanwendungen spezialisiert.

Die 12 Modelle, die an der Bewertung teilgenommen haben, zeigen die unterschiedlichen Fähigkeiten in verschiedenen Anwendungsszenarien. Unter ihnen ist DeepSeek-R1 herausragend im Bereich "Spieleentwicklung", Claude-3.5-Sonnet, Beanbag 1.5pro, Smart Spectrum GLM-Zero-preview und Tongyi Qianqian Max sind geschickter bei der Gestaltung von "Webanwendungen", o3-mini-high und Step Star Step R-mini sind besser bei der Gestaltung von "Webanwendungen". Claude-3.5-Sonnet, Beanbag 1.5pro, GLM-Zero-preview und Max sind eher auf das Design von "Webanwendungen" spezialisiert, während o3-mini-high und Step R-mini einen einzigartigen Vorteil bei der Entwicklung von "Multimedia-Bearbeitungswerkzeugen" haben.

4. die verschiedenen Modelle unterscheiden sich erheblich in der Wahl der Methoden und der Gestaltung der Schnittstellen.

Der Vergleich der Modellantworten zeigt, dass die verschiedenen Modelle bei gleichen Benutzeranforderungen sehr unterschiedliche Programmiersprachen wählen, Bibliotheken/Module aufrufen und der Ästhetik der Benutzeroberfläche große Aufmerksamkeit schenken, was bis zu einem gewissen Grad die Unterschiede in den Fähigkeiten, Präferenzen und Konzepten der Modelle widerspiegelt. Insgesamt schneiden die Modelle aus Übersee bei der Gestaltung der Benutzeroberfläche besser ab.

Entsprechende Beispiele sind im Folgenden aufgeführt:

Frage eins:

Schreiben Sie Code, um eine einfache Online-Bestellung von Lebensmitteln Website, Unterstützung für das Hinzufügen von Gerichten in den Warenkorb, durch die "+" und "-", um die Anzahl der Gerichte zu ändern, Echtzeit-Anzeige des Gesamtpreises der Gerichte in den Warenkorb, und die Fähigkeit zu klicken, um eine Bestellung aufzugeben. Nach der Bestellung wird der Warenkorb geleert und der Kunde wird gefragt, ob er das Essen einpacken möchte. Für jede 100 $ des Gesamtbetrags sollte es einen Rabatt von 10 $ geben.

Frage zwei:

Schreiben Sie Code, um ein Basketball-Shooting-Spiel zu implementieren, Mausbewegung, um die Richtung des Basketballs zu steuern, drücken Sie die Maus, um Energie zu speichern, den Basketball in den Korb, um Punkte zu erzielen, aufeinanderfolgende Körbe haben zusätzliche Punkte, nicht in den Korb dreimal, dann beenden Sie das Spiel. Bei der Wahl der Richtung und der Akkumulation von Energie müssen Sie die beabsichtigte Flugbahn mit einer gepunkteten Linie markieren; nachdem Sie den Basketball geworfen haben, müssen Sie seine Flugbahn deutlich zeigen. Vor dem Schießen können Sie die linke und rechte Pfeiltaste verwenden, um die Ausgangsposition des Basketballs zu verschieben. Für Schüsse aus kurzer Entfernung gibt es 2 Punkte, für Schüsse über eine bestimmte Entfernung 3 Punkte. Es besteht die Möglichkeit, den Rand zu treffen und in den Ball abzuprallen.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...