X-Dyna: Still Portrait Reference Video Pose Generation Video um Missys Fotos tanzen zu lassen

Allgemeine Einführung

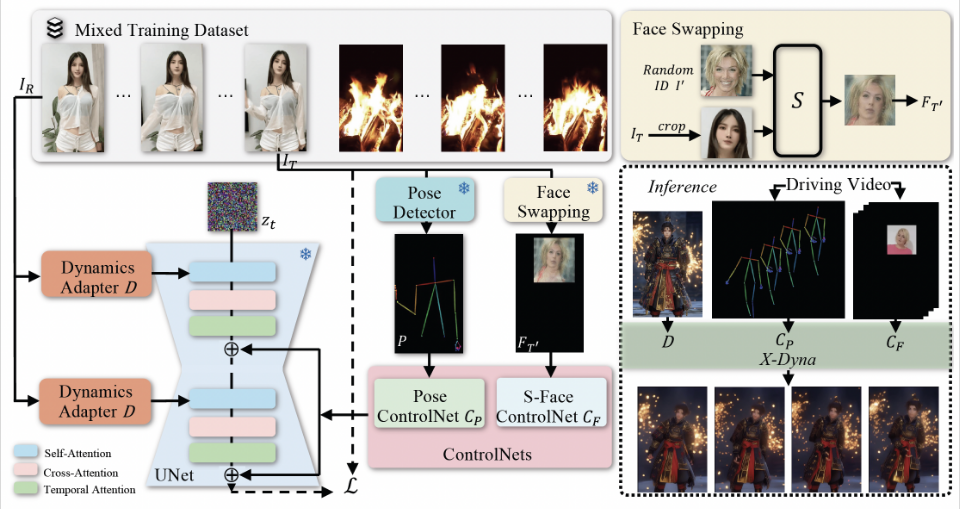

X-Dyna ist ein Open-Source-Projekt, das von ByteDance entwickelt wurde, um dynamische Porträtanimationen durch Zero-Sample-Diffusionstechniken zu erzeugen. Das Projekt nutzt Gesichtsausdrücke und Körperbewegungen im Fahrvideo, um einzelne Porträtbilder zu animieren und so realistische und kontextbewusste Animationen zu erzeugen. x-Dyna verbessert die Lebendigkeit und Detailgenauigkeit von Porträt-Videoanimationen durch die Einführung eines dynamischen Adaptermoduls, das den Erscheinungskontext des Referenzbildes nahtlos in die räumliche Aufmerksamkeit des Diffusions-Backbone-Netzwerks integriert.

Verwandte Empfehlung:StableAnimator: Erzeugt qualitativ hochwertige Videoanimationen, bei denen die Charaktereigenschaften erhalten bleiben. undDisPose: Erstellung von Videos mit präziser Kontrolle der menschlichen Körperhaltung, Erstellung von tanzenden Damen undMOFA Video: Motion Field Adaptation Technologie konvertiert Standbilder in Video

Funktionsliste

- Generierung dynamischer Porträtanimationen: Generieren Sie realistische dynamische Porträtanimationen mit Gesichtsausdrücken und Körperbewegungen im Laufwerksvideo.

- Zero-Sample-Diffusion-Technik: erzeugt hochwertige Animationen ohne vorherige Trainingsdaten.

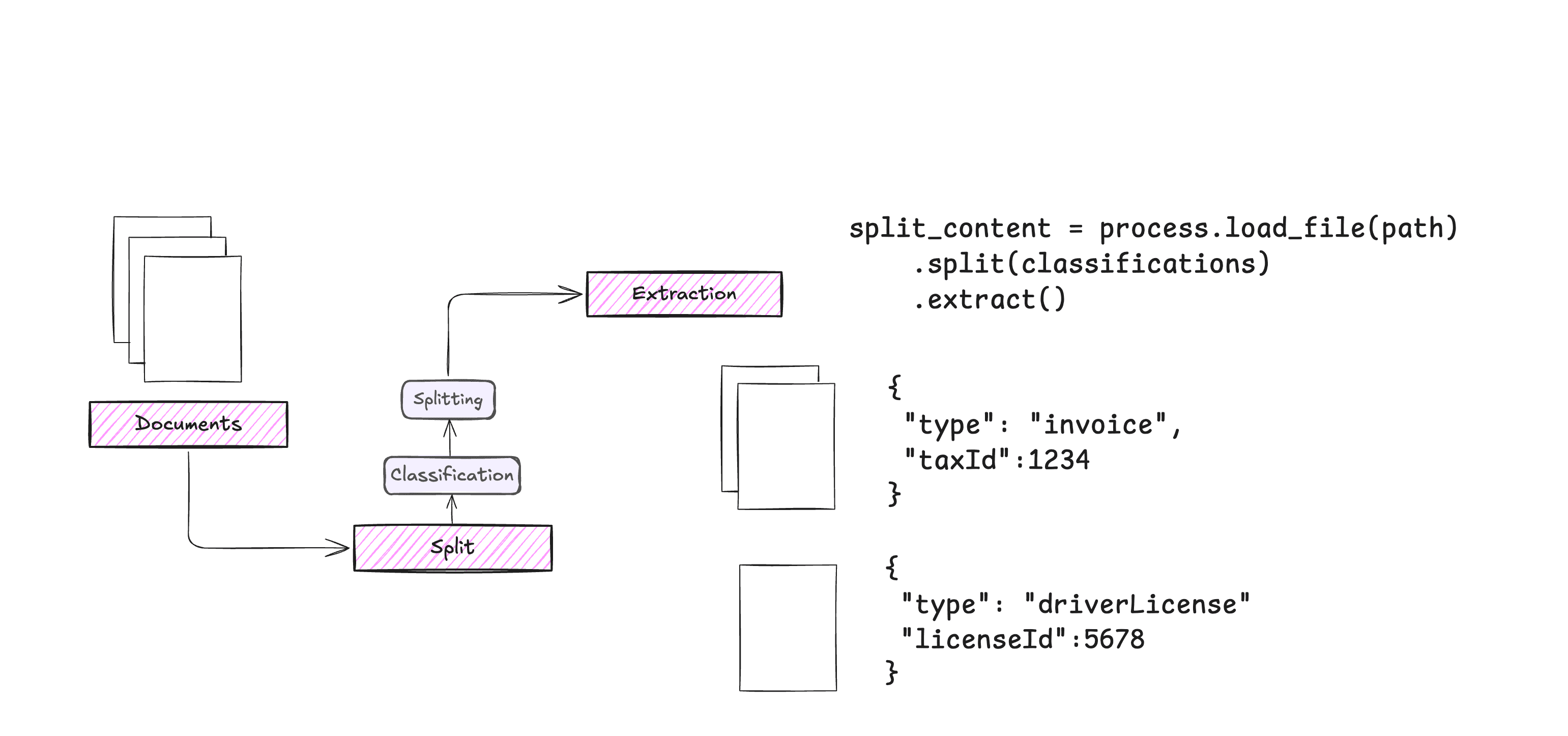

- Dynamic Adapter Module: Integration von Referenzbildkontext zur Verbesserung der Detailtreue und Lebendigkeit von Animationen.

- Übertragung des Gesichtsausdrucks: Erfassen Sie den Gesichtsausdruck durch ein lokales Steuermodul für eine präzise Ausdrucksübertragung.

- Bewertungscodes: Bieten Sie eine Vielzahl von Bewertungsmetriken (z. B. DTFVD, Face-Cos, Face-Det, FID usw.) zur Beurteilung der Animationsqualität.

- Open-Source-Code und -Modelle: Der vollständige Inferenzcode und die vortrainierten Modelle werden für eine einfache Nutzung und Weiterverarbeitung bereitgestellt.

Hilfe verwenden

Einbauverfahren

- Klonen des Projektlagers:

git clone https://github.com/bytedance/X-Dyna.git

cd X-Dyna

- Installieren Sie die Abhängigkeit:

pip install -r requirements.txt

- Installieren Sie die PyTorch 2.0 Umgebung:

bash env_torch2_install.sh

Verwendung

- Bereiten Sie das Eingangsbild und das Laufwerksvideo vor:

- Eingabebild: Ein einzelnes Porträtbild.

- Drive Video: Ein Video, das die Gesichtsausdrücke und Körperbewegungen der Zielperson enthält.

- Führen Sie den Inferenzcode aus, um die Animation zu erzeugen:

python inference_xdyna.py --input_image path_to_image --driving_video path_to_video

- Bewerten Sie die Qualität der erzeugten Animation:

- Die Qualität der erzeugten Animationen wurde anhand des mitgelieferten Evaluierungscodes und Datensatzes bewertet.

python evaluate.py --generated_video path_to_generated_video --metrics DTFVD,Face-Cos,Face-Det,FID

Detaillierte Funktionsabläufe

- Dynamische Porträtanimation erzeugen::

- Wählen Sie ein statisches Porträtbild als Eingabe.

- Wählen Sie ein Laufwerksvideo aus, das die Bewegungen und Ausdrücke der Zielperson enthält.

- Führen Sie den Inferenzcode aus, um eine dynamische Porträtanimation zu erzeugen.

- Übertragung der Mimik::

- Erfassen Sie mit dem Local Control Module Gesichtsausdrücke in Fahrvideos.

- Übertragen Sie den erfassten Ausdruck auf das Eingabebild, um eine präzise Ausdrucksanimation zu ermöglichen.

- Dynamisches Adaptermodul::

- Das dynamische Adaptermodul integriert den Erscheinungskontext des Referenzbildes nahtlos in die räumliche Aufmerksamkeit des Diffusions-Backbone-Netzwerks.

- Auf diese Weise behält die erzeugte Animation mehr Details und Lebendigkeit.

- Bewertungscode::

- Zur Beurteilung der Qualität der erzeugten Animationen stehen verschiedene Bewertungsmaßstäbe (z.B. DTFVD, Face-Cos, Face-Det, FID, etc.) zur Verfügung.

- Die Benutzer können die erzeugten Animationen auf der Grundlage dieser Metriken vollständig bewerten.

- Offener Quellcode und Modellierung::

- Das Projekt stellt einen vollständigen Inferenzcode und vortrainierte Modelle zur Verfügung, die von den Nutzern leicht für sekundäre Entwicklungen und maßgeschneiderte Anwendungen verwendet werden können.

Häufig gestellte Fragen.

- Animation ist nicht flüssig: Versuchen Sie, die

num_mixoder Anpassungenddim_steps. - Unausgewogenheit der Mimik: Stellen Sie sicher, dass die Wahl der

best_frameentspricht dem Bild im Laufwerksvideo, das dem Quellbild am ähnlichsten ist.

Erweiterte Verwendung.

- Leistung optimierenDie Geschwindigkeit der Generierung kann verbessert werden, indem die Anzahl der Inferenzschritte durch die Verwendung des LCM LoRA-Modells reduziert wird.

- Kundenspezifische ModelleWenn Sie spezielle Anforderungen haben, können Sie das Modell entsprechend der Anleitung in der README modifizieren oder erweitern.

Wenn Sie diese Schritte befolgen, können Sie mit X-Dyna auf einfache Weise hochwertige dynamische Porträtanimationen erstellen und die erstellten Animationen vollständig auswerten und optimieren.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...