Privater Einsatz ohne lokale GPUs DeepSeek-R1 32B

in Bezug auf DeepSeek-R1 Für den täglichen Gebrauch im Büro, direkt auf der offiziellen Website ist die beste Wahl, wenn Sie andere Bedenken oder besondere Bedürfnisse haben... Es muss in der verwendet werden Lokale Bereitstellung von DeepSeek-R1 (mit Ein-Klick-Installer)Die weißen Tutorials hier sind perfekt für Sie.

Wenn Sie einen schlecht konfigurierten Computer haben, aber trotzdem mit privatem DeepSeek-R1 arbeiten wollen ... Dann erwägen Sie die Verwendung von freien GPUs, lehrte jeder vor Jahren Online-Einsatz des Open-Source-Modells DeepSeek-R1 mit kostenloser GPU-LeistungAllerdings gibt es einen fatalen Nachteil, das heißt, die kostenlose GPU kann nur 14B installieren, die Installation von 32B wird sehr Karte, aber nach dem Testen nur installieren DeepSeek-R1 32B oder mehr Ausgabequalität, um die Bedürfnisse der täglichen Arbeit zu erfüllen.

Also ... Was wir tun werden, ist freie GPUs in den effizient laufenden Quantitative Version von DeepSeek-R1 32B. Er kommt!

In der freien GPU kann in der Ausgabe von 2 bis 6 Wörter pro Sekunde (je nach Komplexität des Problems Ausgabegeschwindigkeit schwankt) durchgeführt werden, der Nachteil dieser Methode ist, dass Sie auf den Dienst von Zeit zu Zeit zu drehen müssen.

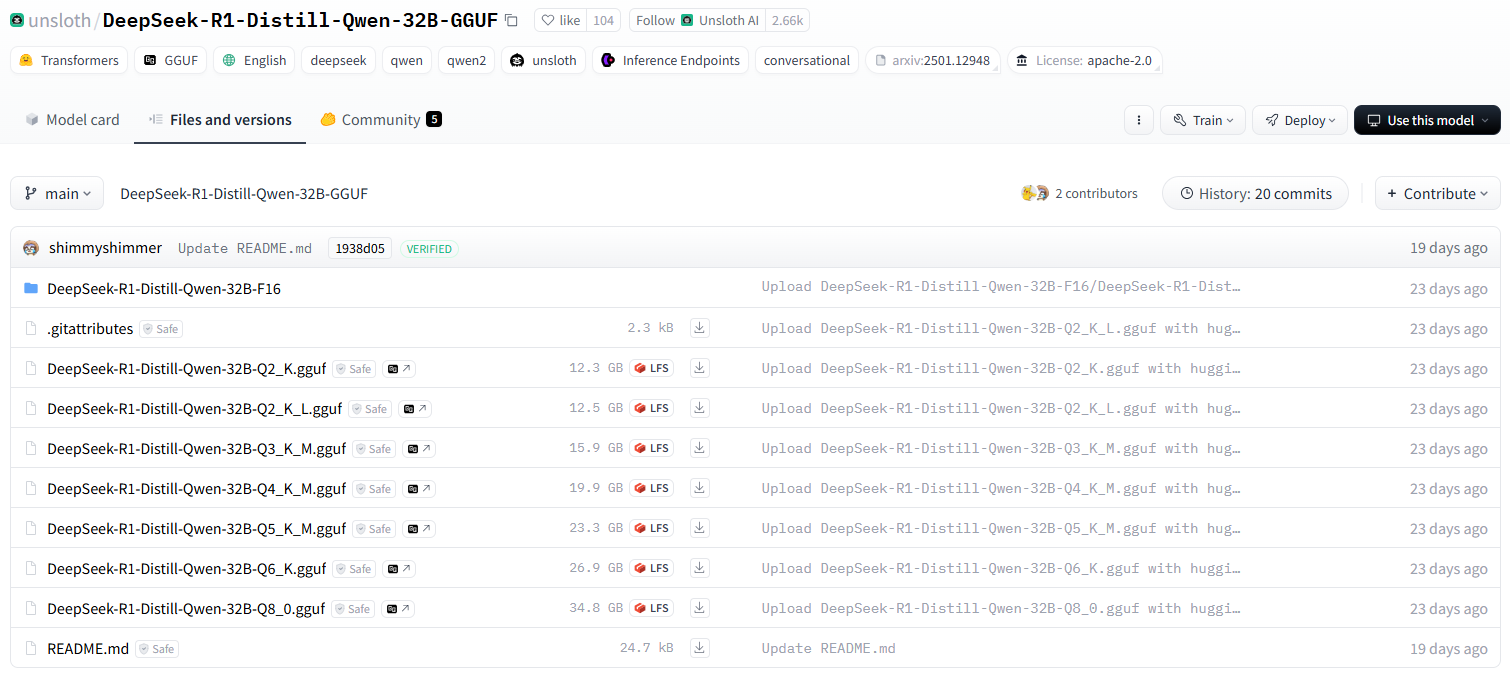

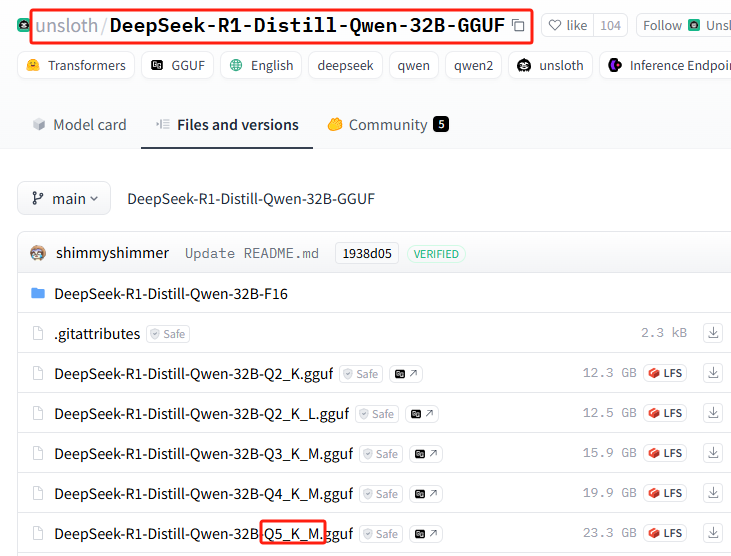

unsloth-Team quantisierte Version DeepSeek-R1

unsloth Die mitgelieferte Version von Qwen-32B-Q4_K_M ist auf 20 GB komprimiert, was bereits auf einer Consumer-Grade-Einzelkarte möglich ist..

Kurze Zusammenfassung der Anforderungen an die Computerleistung für die quantisierte Version

DeepSeek-R1-Distill-Qwen-32B-GGUFBeschreibung der verschiedenen quantitativen Versionen des Modells

Das Suffix jeder Datei (z.B. Q2_K_L, Q4_K_M, usw.) steht für eine andere Quantisierung. Hier sind die Hauptunterschiede:

q2_k_l, q3_k_m, q4_k_m, q5_k_m, q6_k, q8_0

Q2undQ3undQ4undQ5undQ6undQ8bezeichnet die Anzahl der zu berechnenden Bits (z. B.Q4(Zeigt eine 4-Bit-Berechnung an).KnebenMEs könnte sich um eine andere quantitative Strategie oder ein anderes Genauigkeitsniveau handeln.Q8_0Typischerweise 8-Bit-Quantisierung, nahe der FP16-Präzision, mit den höchsten Rechenanforderungen, aber besserer Inferenzqualität.

DeepSeek-R1-Distill-Qwen-32B-F16

F16anzeigen.16-Bit-Gleitkomma (FP16)ist das unberechnete Modell, das die höchste Genauigkeit aufweist, aber den meisten Videospeicher benötigt.

Erfahren Sie hier mehr über das Konzept der Quantifizierung:Was ist Modellquantisierung: Erklärung der Datentypen FP32, FP16, INT8, INT4

Wie wähle ich die richtige Version?

- Geräte mit geringem Videospeicher (z. B. Consumer-GPUs) →AuswählenQ4, Q5 Quantifizierungz.B..

Q4_K_MvielleichtQ5_K_MDas Gleichgewicht zwischen Leistung und Genauigkeit. - Extrem speicherarme Geräte (z. B. CPU-Betrieb) →AuswählenQuantifizierung von Q2 oder Q3z.B..

Q2_K_LvielleichtQ3_K_MDadurch wird der Speicherplatzbedarf reduziert. - Leistungsstarke GPU-Server→AuswählenQuantifizierung von Q6 oder Q8z.B..

Q6_KvielleichtQ8_0Dadurch wird eine bessere Qualität der Argumentation erreicht. - am wirksamsten→Auswählen

F16Version, erfordert jedoch eine erhebliche Menge an Speicherplatz (etwa 60 GB oder mehr).

Free GPU Empfohlene Installationsversion

Q2_K_L

Beginn der Installation von DeepSeek-R1 32B

Wie man eine kostenlose GPU erhält, bis sie installiert ist Ollama Überfliegen des Prozesses, oder Lesen:Online-Einsatz des Open-Source-Modells DeepSeek-R1 mit kostenloser GPU-LeistungDer einzige Unterschied zum vorherigen Tutorial besteht in einer leichten Änderung des Installationsbefehls.

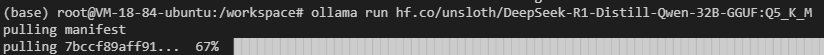

Gehen Sie direkt zum Prozess der Installation einer bestimmten quantisierten Version in Ollama. Glücklicherweise hat Ollama den gesamten Installationsprozess extrem vereinfacht, so dass nur ein einziger Installationsbefehl gelernt werden muss.

1. die Installation des quantitativen Versionierungsmodells von Huggingface im Basisbefehlsformat

Merken Sie sich das folgende Format für den Installationsbefehl

ollama run hf.co/{username}:{reponame}

2. die Auswahl der quantitativen Version

Liste aller quantitativen Versionen: https://huggingface.co/unsloth/DeepSeek-R1-Distill-Qwen-32B-GGUF/tree/main

Diese Installation verwendet: Q5_K_M (nur für Demozwecke, dieAuch hier gilt: Bitte installieren Sie die kostenlose, empfohlene GPU-Version!(Q5 benötigt 23 GB Festplattenspeicher für die eigentliche Installation)

3. der Befehl "Spleiß-Installation

{Benutzername}=unsloth/DeepSeek-R1-Distill-Qwen-32B-GGUF

{reponame}=Q5_K_M

Spleißen Sie sie zusammen, um den vollständigen Installationsbefehl zu erhalten:ollama run hf.co/unsloth/DeepSeek-R1-Distill-Qwen-32B-GGUF:Q5_K_M

4. die Installation in Ollama durchführen

Führen Sie den Installationsbefehl aus

Es kann zu Netzwerkfehlern kommen (viel Glück dabei), wiederholen Sie den Installationsbefehl noch ein paar Mal...

Funktioniert immer noch nicht? Führen Sie den folgenden Befehl aus, um es zu versuchen (wechseln Sie zur inländischen Mirror-Adresse):ollama run https://hf-mirror.com/unsloth/DeepSeek-R1-Distill-Qwen-32B-GGUF:Q5_K_M

Warum verwenden Sie nicht einfach die Adresse des Spiegels zum Herunterladen, anstatt zuerst die offizielle Adresse und dann den Spiegel zu verwenden?

Das liegt daran, dass die integrierte Installation schneller ist!

Natürlich brauchen Sie diese quantisierte Version vielleicht nicht, hier ist eine aktuellere, populäre unzensierte Version: ollama run huihui_ai/deepseek-r1-abliterated:14b

5. Ollama für Ausgestoßene zugänglich machen

Bestätigen Sie den Ollama-Port durch Eingabe des folgenden Befehls in das Terminal

ollama serve

11414 oder 6399

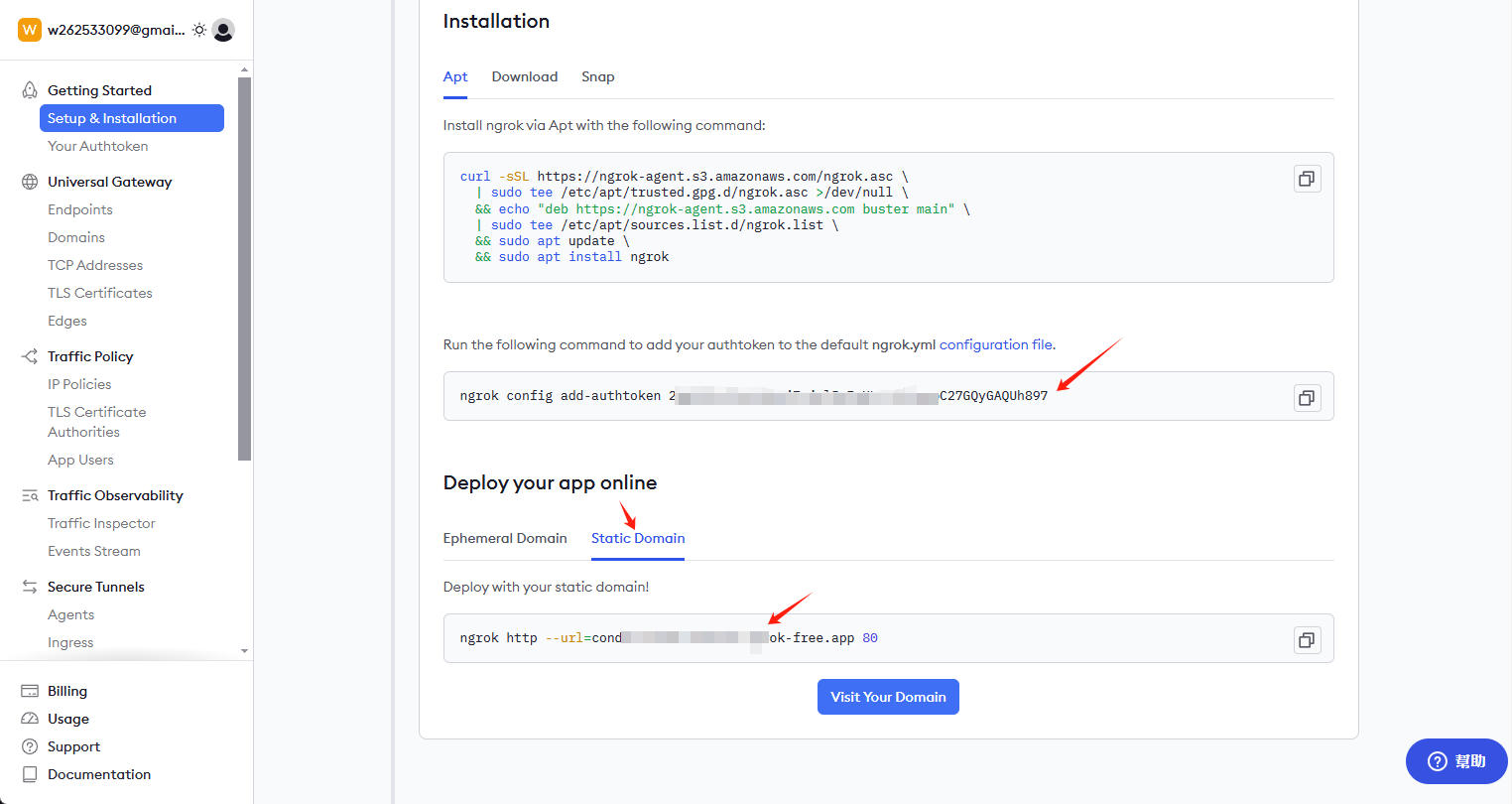

Installation von ngrok

curl -sSL https://ngrok-agent.s3.amazonaws.com/ngrok.asc \ | tee /etc/apt/trusted.gpg.d/ngrok.asc >/dev/null \ && echo "deb https://ngrok-agent.s3.amazonaws.com buster main" \ | tee /etc/apt/sources.list.d/ngrok.list \ && apt update \ && apt install ngrok

Schlüssel und permanenten Link erhalten

Besuchen Sie ngrok.com, um sich für ein Konto anzumelden, und gehen Sie auf die Homepage, um den Schlüssel und den permanenten Link zu erhalten

Installieren Sie den Schlüssel und aktivieren Sie die externe Zugangsadresse

Geben Sie den folgenden Befehl in den Client ein:

ngrok config add-authtoken 这里是你自己的密钥

Geben Sie weiterhin die folgenden Befehle ein, um den externen Zugang zu öffnen: 6399 Dieser Port kann von jedem anders sein, überprüfen und ändern Sie ihn selbst

ngrok http --url=condor-known-ferret.ngrok-free.app 6399

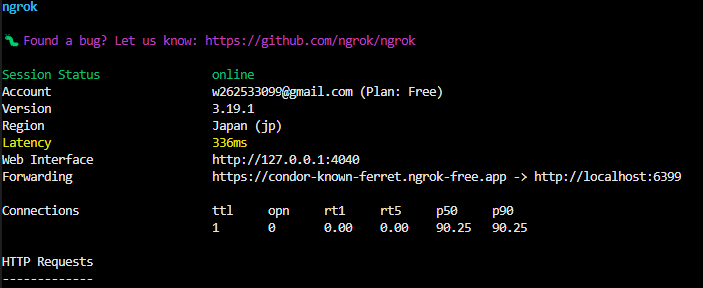

Nach dem Erfolg sehen Sie im Terminal

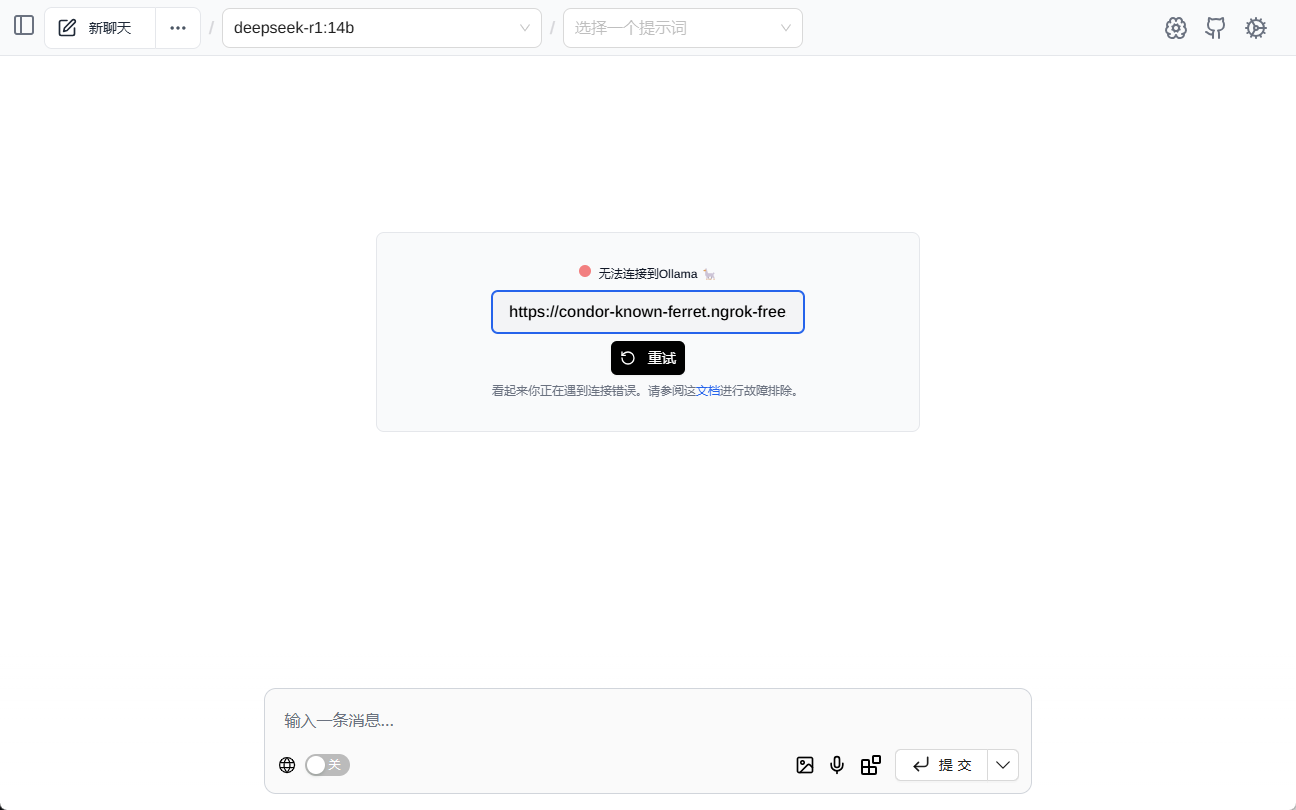

https://condor-known-ferret.ngrok-free.app ist die Zugangsadresse für die Modellschnittstelle, öffnen Sie sie und Sie sehen folgenden Inhalt

ausnutzen

Bezogen von https://condor-known-ferret.ngrok-free.app如何使用?

Der einfachste Weg, dies zu tun, ist die Installation von Seite Assist Zusammen ist das Tool ein Browser-Plugin, das sich selbst installiert.

konfigurieren.

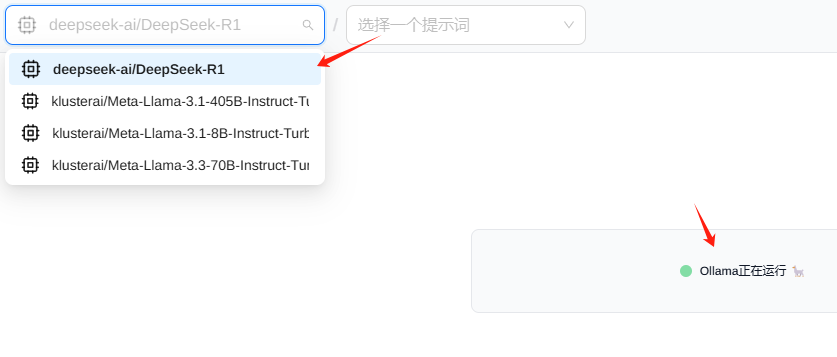

zeigen (eine Eintrittskarte) Seite Assist Danach wird die folgende Schnittstelle angezeigt, bitte geben Sie die Schnittstellenadresse ein

Normalerweise werden Sie sehen, dass das Modell automatisch geladen wird

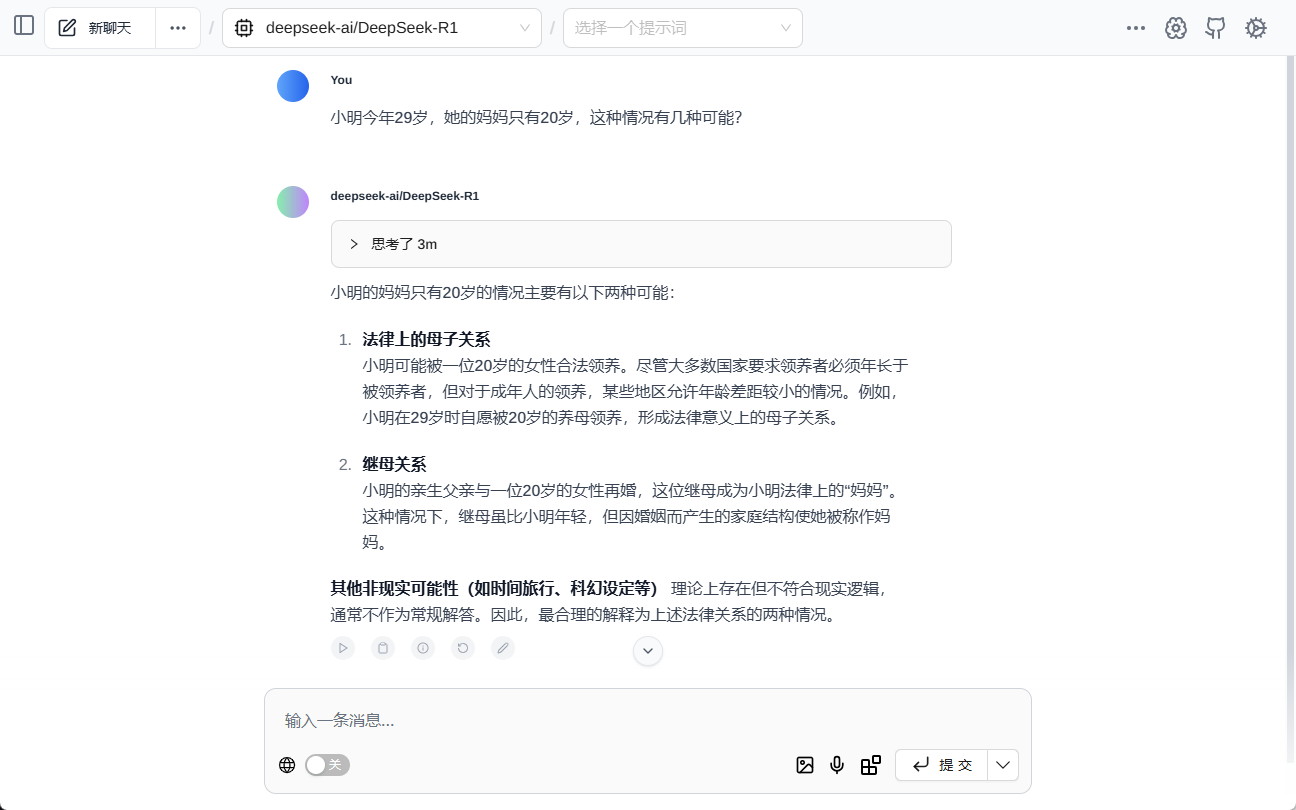

Prüfung (Maschinen usw.)

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...