Microsofts neues Modell: Phi-4 ist da, mit 14B-Parametern vergleichbar mit größeren Modellen

Mit nur 14 Milliarden (14B) Parametern zeigt Phi-4 eine Leistung, die mit einigen größeren Modellen vergleichbar ist oder diese sogar übertrifft, dank innovativer Trainingsmethoden und qualitativ hochwertiger Daten. In diesem Papier werden die Architektur, die Funktionen, die Trainingsmethodik und die Leistung von Phi-4 in realen Anwendungen und Benchmarks detailliert beschrieben.

https://github.com/xinyuwei-david/david-share.git

I. Betrachtung von Indikatoren zur Messung der Kapazität

Messung von drei Fragen zum Vergleich von o1 und Phi-4

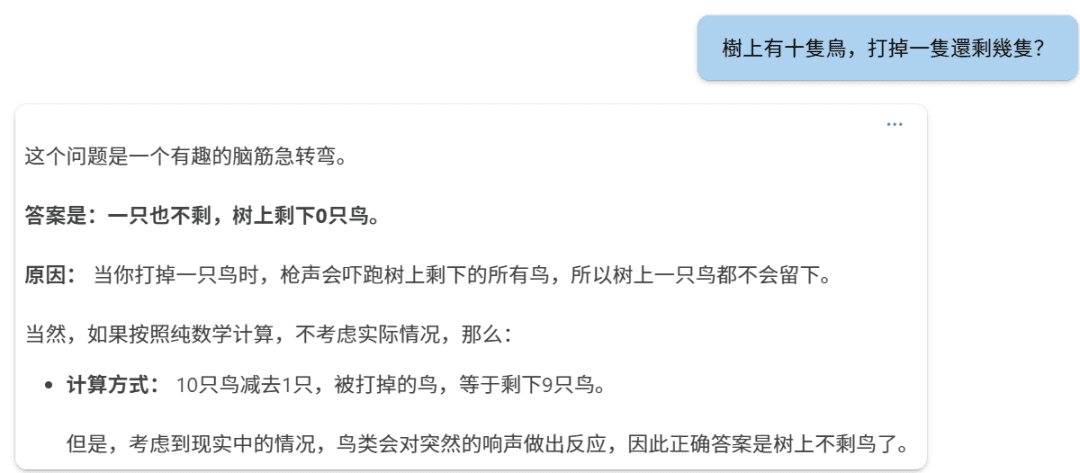

Erste Frage:

phi-4

o1

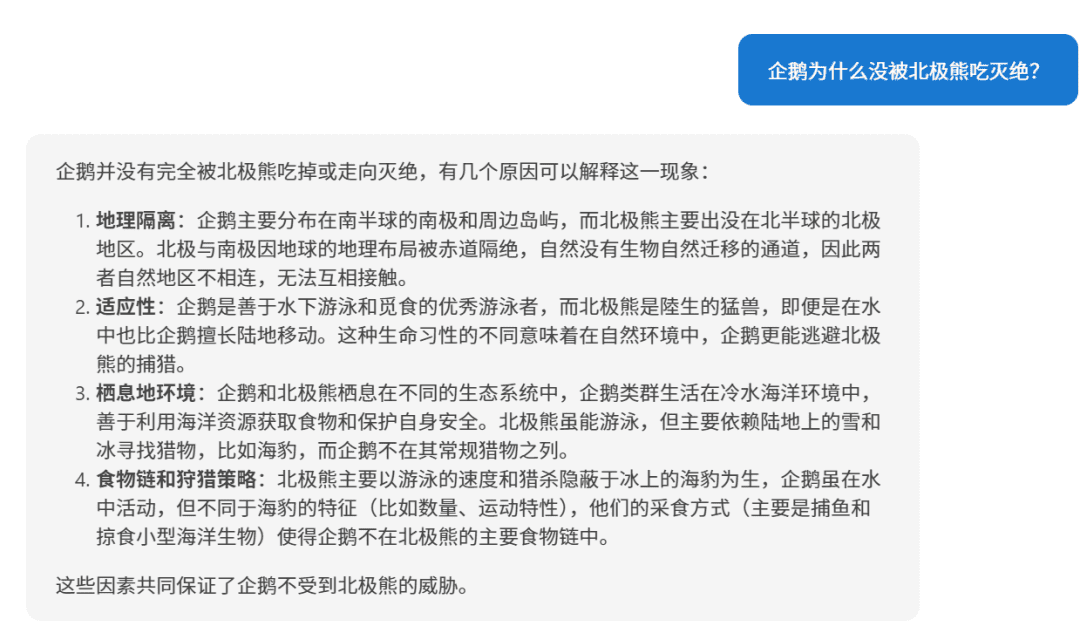

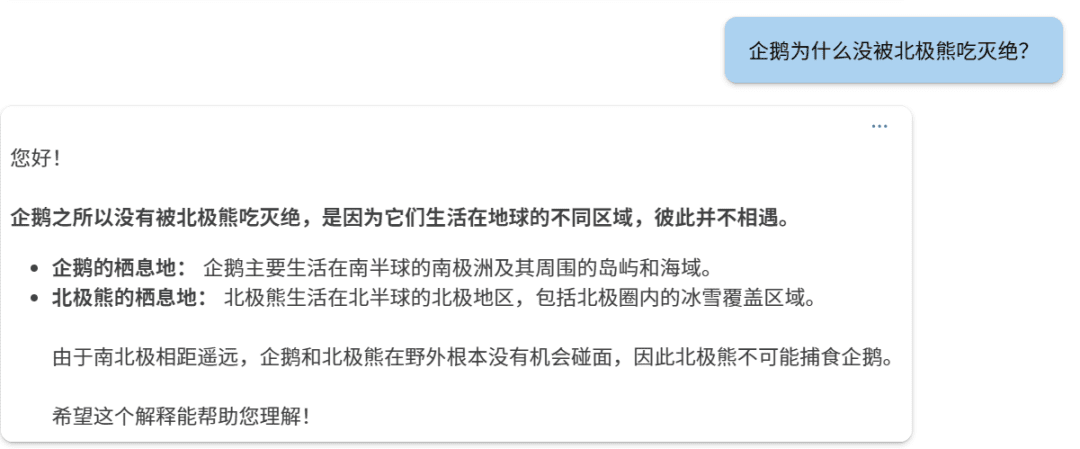

Zweite Frage:

Phi-4.

o1:

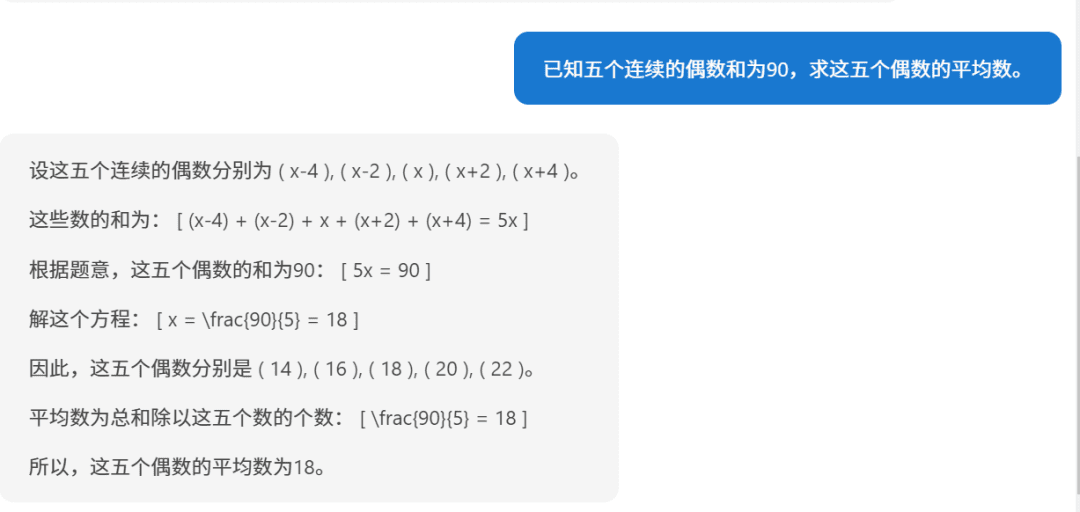

Dritte Frage:

Phi-4

o1.

要求五个连续偶数的平均数,已知它们的和为90,下面我们逐步解答。步骤1:设未知数设这五个连续的偶数为:第一个偶数:( n - 4 )第二个偶数:( n - 2 )第三个偶数:( n )第四个偶数:( n + 2 )第五个偶数:( n + 4 )(因为偶数之间相差2,所以相邻的偶数可以这样表示)步骤2:列方程求和根据题目,五个数的和为90:[(n - 4) + (n - 2) + n + (n + 2) + (n + 4) = 90]步骤3:简化方程合并同类项:[5n = 90]步骤4:求解 n[n = frac{90}{5} = 18]步骤5:求出五个偶数第一个偶数:( 18 - 4 = 14 )第二个偶数:( 18 - 2 = 16 )第三个偶数:( 18 )第四个偶数:( 18 + 2 = 20 )第五个偶数:( 18 + 4 = 22 )步骤6:计算平均数平均数等于总和除以数量:[text{平均数} = frac{14 + 16 + 18 + 20 + 22}{5} = frac{90}{5} = 18]答案:这五个连续的偶数的平均数是 18。

Wenn man es so betrachtet, ist die Argumentation von Phi-4 immer noch in Ordnung.

II. Phi-4 Modellarchitektur

1. transformatorbasierte Decoderarchitektur

Phi-4 verwendet ein System, das auf dem Transformator (in Form eines Nominalausdrucks) Nur für Decoder Diese Architektur ist der GPT-Modellfamilie ähnlich. Diese Architektur nutzt den Self-Attention-Mechanismus, um langfristige Abhängigkeiten in Textsequenzen effektiv zu erfassen, und eignet sich hervorragend für die Generierung natürlicher Sprache.

2. die Parametergröße und die Anzahl der Schichten

- Gesamtzahl der Parameter: 14 Milliarden (14B) Parameter.

- Anzahl der Modelletagen: 40

3. die Länge des Kontextes

- Ursprüngliche Kontextlänge: 4,096 Wertmarke.

- Mittelfristige Verlängerung der Ausbildung: In der mittleren Trainingsphase wurde die Kontextlänge von Phi-4 auf 16,000 Token (16K), das die Fähigkeit des Modells verbessert, lange Texte zu verarbeiten.

4. glossar und lexer

- Splitter: Die Verwendung von OpenAIs Tiktoken-SplitterDas Unternehmen unterstützt mehrere Sprachen und hat einen besseren Subtext-Effekt.

- Glossargröße: 100,352Dazu gehören auch einige reservierte, nicht verwendete Token.

III. Aufmerksamkeitsmechanismen und Positionskodierung

1. globale Aufmerksamkeitsmechanismen

Phi-4 verwendet Mechanismus der vollen Aufmerksamkeitd.h. die Selbstaufmerksamkeit wird für die gesamte Folge von Kontexten berechnet. Dies steht im Gegensatz zum Vorgängermodell Phi-3-medium, das 2.048 Token des Schiebefensters, während Phi-4 die Berechnung der globalen Aufmerksamkeit direkt auf den Kontexten von 4.096 Token (ursprünglich) und 16.000 Token (erweitert) durchführt, was die Fähigkeit des Modells verbessert, weitreichende Abhängigkeiten zu erfassen.

2. rotierende Positionskodierung (RoPE)

Um größere Kontextlängen zu unterstützen, wurde Phi-4 in der Mitte der Ausbildung angepasst, um Einbettung der Drehlage (RoPE) der Grundfrequenz:

- Anpassung der Grundfrequenz: Erhöhen Sie die Basisfrequenz von RoPE auf 250,000um die 16K Kontextlänge zu berücksichtigen.

- Die Rolle: RoPE hilft dem Modell, die Wirksamkeit der Positionskodierung in langen Sequenzen beizubehalten, so dass das Modell auch bei längeren Texten eine gute Leistung erbringt.

IV. Ausbildungsstrategien und -methoden

1. das Konzept der Priorisierung der Datenqualität

Die Trainingsstrategie für Phi-4 basiert auf Qualität der Daten im Kern. Im Gegensatz zu anderen Modellen, die hauptsächlich mit organischen Daten aus dem Internet (z. B. Webinhalte, Code usw.) trainiert werden, führt Phi-4 während des gesamten Trainingsprozesses strategisch ein Synthetische Daten.

2. die Erzeugung und Anwendung synthetischer Daten

Synthetische Daten spielte eine Schlüsselrolle bei der Vor- und Zwischenausbildung von Phi-4:

- Mehrere Techniken zur Datengenerierung:

- Multi-Agent Prompting: Die Vielfalt der Daten wird durch den Einsatz mehrerer Sprachmodelle oder Agenten zur gemeinsamen Datengenerierung bereichert.

- Selbstrevisions-Workflows: Nachdem das Modell die erste Ausgabe erzeugt hat, führt es eine Selbstbewertung und Korrektur durch, um die Qualität der Ausgabe iterativ zu verbessern.

- Befehlsumkehr: Die Generierung entsprechender Eingabeanweisungen aus vorhandenen Ausgaben verbessert die Fähigkeit des Modells, Anweisungen zu verstehen und zu generieren.

- Vorteile der synthetischen Daten:

- Strukturiertes und progressives Lernen: Synthetische Daten ermöglichen eine präzise Steuerung von Schwierigkeitsgrad und Inhalt, so dass das Modell schrittweise komplexe Denk- und Problemlösungsfähigkeiten erlernt.

- Verbesserung der Ausbildungseffizienz: Die Generierung synthetischer Daten kann gezielte Trainingsdaten für die Schwachstellen des Modells liefern.

- Vermeiden Sie Datenverschmutzung: Da die synthetischen Daten generiert werden, wird das Risiko vermieden, dass die Trainingsdaten den Inhalt des Überprüfungssatzes enthalten.

3. feines Screening und Filterung von organischen Daten

Zusätzlich zu den synthetischen Daten konzentriert sich Phi-4 auf die sorgfältige Auswahl und Filterung hochwertiger Daten aus verschiedenen Quellen Organische Daten::

- Datenquellen: Enthält Webinhalte, Bücher, Code-Bibliotheken, wissenschaftliche Arbeiten und mehr.

- Datenfilterung:

- Entfernen Sie minderwertige Inhalte: Verwenden Sie automatisierte und manuelle Methoden, um sinnlose, falsche, doppelte oder schädliche Inhalte herauszufiltern.

- Verhindern Sie die Kontamination von Daten: Ein hybrider n-Gramm-Algorithmus (13-Gramm und 7-Gramm) wurde für die Entdopplung und Entkontaminierung verwendet, um sicherzustellen, dass die Trainingsdaten keine Inhalte aus dem Überprüfungssatz enthielten.

4) Strategie für die Datenmischung

Phi-4 wurde in der Zusammensetzung der Trainingsdaten mit den folgenden Verhältnissen optimiert:

- Synthetische Daten: in Besitz nehmen 40%.

- Web Rewrites: in Besitz nehmen 15%Im Falle eines neuen Trainingsmusters wird es aus hochwertigen Webinhalten neu geschrieben, um ein neues Trainingsmuster zu erzeugen.

- Organische Webdaten: in Besitz nehmen 15%Der Webinhalt ist eine Auswahl wertvoller Webinhalte.

- Code-Daten: in Besitz nehmen 20%einschließlich der öffentlichen Codebasis und der generierten Codesynthesedaten.

- Gezielte Akquisitionen: in Besitz nehmen 10%einschließlich akademischer Abhandlungen, Fachbücher und anderer hochwertiger Inhalte.

5. mehrstufiger Ausbildungsprozess

Vorschulungsphase:

- Zielsetzung: Modellierung des zugrunde liegenden sprachlichen Verständnisses und der generativen Fähigkeiten.

- Datenvolumen: reduzieren (einen Bruchteil) 10 Billionen (10T) Wertmarke.

Mittelfristige Ausbildungsphase:

- Zielsetzung: Ausweitung der Kontextlänge zur Verbesserung der Verarbeitung langer Texte.

- Datenvolumen: 250 Milliarden (250B) Wertmarke.

Nachschulungsphase (Feinabstimmung):

- Überwachte Feinabstimmung (SFT): Die Feinabstimmung unter Verwendung hochwertiger, bereichsübergreifender Daten verbessert die Fähigkeit des Modells, Anweisungen zu befolgen, und die Qualität der Antworten.

- Direkte Präferenzoptimierung (DPO): nutzen. Pivotal Token Search (PTS) und andere Methoden zur weiteren Optimierung der Modellleistung.

V. Innovative Ausbildungstechniken

1) Pivotal Token Search (PTS)

PTS-Methodik ist eine wichtige Innovation im Phi-4-Ausbildungsprozess:

- Das Prinzip: Durch die Identifizierung von Schlüssel-Token, die einen signifikanten Einfluss auf die Korrektheit der Antwort während des Generierungsprozesses haben, ist das Modell darauf ausgerichtet, die Vorhersage auf diese Token zu optimieren.

- Vorteil:

- Verbesserung der Ausbildungseffizienz: Wenn Sie sich bei der Optimierung auf die Teile konzentrieren, die den größten Einfluss auf die Ergebnisse haben, sind Sie doppelt so effektiv.

- Verbesserte Modellleistung: Hilft dem Modell, an wichtigen Entscheidungspunkten die richtigen Entscheidungen zu treffen, und verbessert die Gesamtqualität des Ergebnisses.

2. verbesserte direkte Präferenzoptimierung (DPO)

- DPO-Methode: Die Optimierung erfolgt direkt unter Verwendung von Präferenzdaten, um die Ergebnisse des Modells besser mit den menschlichen Präferenzen in Einklang zu bringen.

- Innovationspunkte:

- Kombiniert mit PTS: Die Einführung von PTS-generierten Trainingsdatenpaaren in DPO verbessert die Optimierung.

- Bewertung der Indikatoren: Messen Sie die Optimierung genauer, indem Sie die Leistung des Modells für die wichtigsten Token bewerten.

VI. Merkmale und Vorteile des Modells

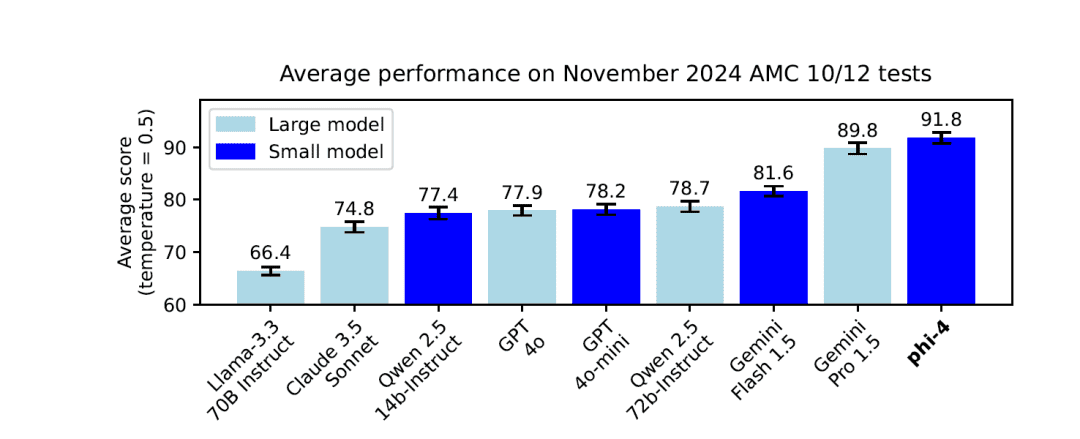

1. ausgezeichnete Leistung

- Kleine Modelle, große Möglichkeiten: Die Parameterskala ist zwar nur 14BAllerdings schneidet der Phi-4 bei mehreren Benchmarks gut ab, vor allem beim logischen Denken und bei Problemlösungsaufgaben.

2. ausgezeichnete Argumentationsfähigkeit

- Mathematisches und naturwissenschaftliches Problemlösen: existieren GPQAundMATH In Vergleichstests wie diesem schneidet Phi-4 sogar besser ab als sein Lehrermodell GPT-4o.

3. lange kontextbezogene Verarbeitungsmöglichkeiten

- Erweiterung der Kontextlänge: Durch die Erweiterung der Kontextlänge in der Mitte des Trainings auf die 16,000 Token ist Phi-4 in der Lage, lange Texte und Abhängigkeiten über große Entfernungen effizienter zu handhaben.

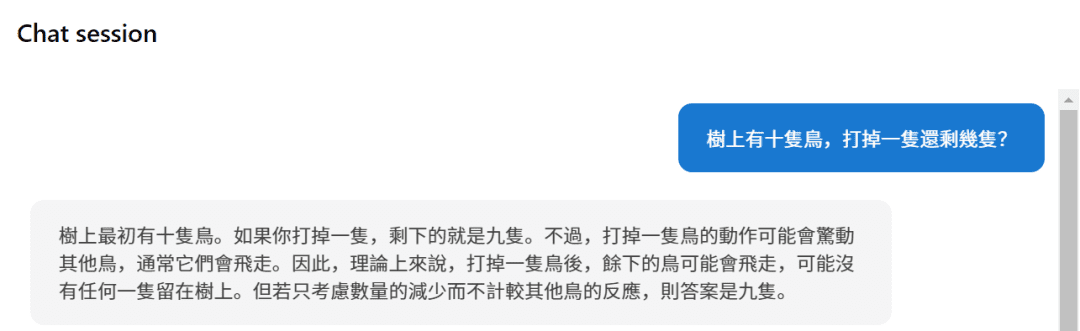

4. mehrsprachige Unterstützung

- Abdeckung von mehreren Sprachen: Die Trainingsdaten bestanden aus den Deutsch, Spanisch, Französisch, Portugiesisch, Italienisch, Hindi, Japanisch und viele andere Sprachen.

- Sprachübergreifende Kompetenz: Hervorragend geeignet für Aufgaben wie Übersetzungen und sprachenübergreifende Quizsendungen.

5. die Sicherheit und die Einhaltung der Vorschriften

- Grundsätze einer verantwortungsvollen KI: Der Entwicklungsprozess folgt strikt den Microsoft-Prinzipien für verantwortungsbewusste KI und konzentriert sich auf die Sicherheit und Ethik des Modells.

- Dekontaminierung von Daten und Schutz der Privatsphäre: Strenge Strategien zur Datendeduplizierung und -filterung werden eingesetzt, um zu verhindern, dass sensible Inhalte in die Trainingsdaten aufgenommen werden.

VII. Benchmarks und Leistung

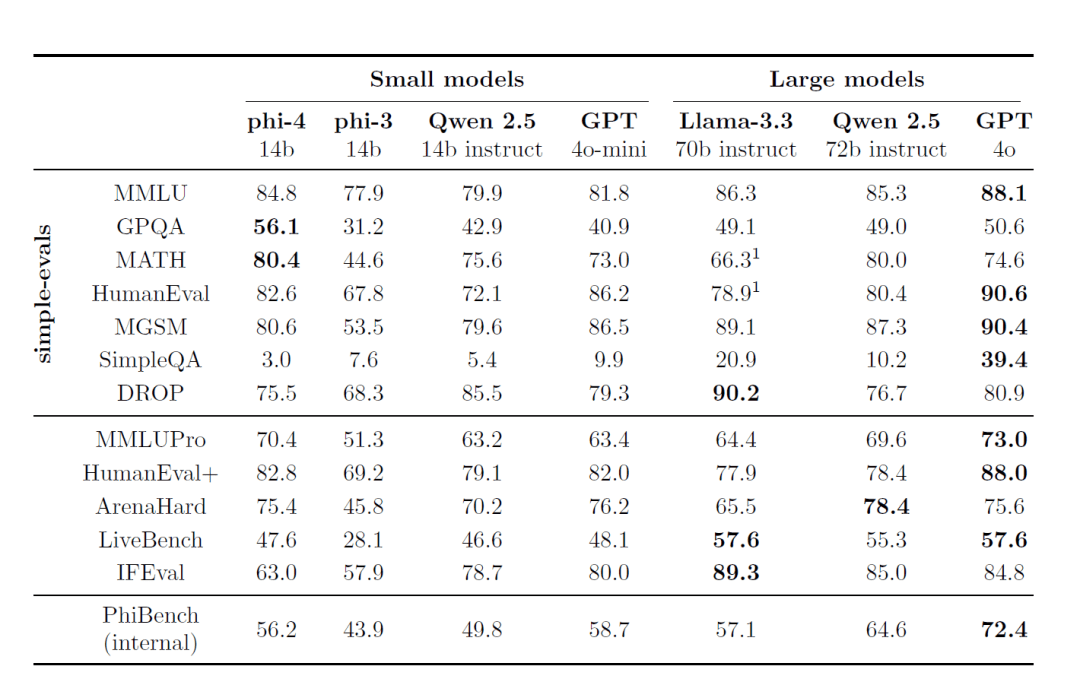

1. externes Benchmarking

Phi-4 zeigt eine führende Leistung bei mehreren öffentlich zugänglichen Prüfungsbenchmarks:

- MMLU (Multitasking Language Understanding): Hervorragende Ergebnisse in komplexen Multitasking-Verständnistests erzielt.

- GPQA (Graduate level STEM quiz): schnitt bei dem schwierigen MINT-Quiz besser ab als einige der größeren Modelle.

- MATH (Mathe-Wettbewerb): Beim Lösen mathematischer Probleme zeigt Phi-4 starke Argumentations- und Berechnungsfähigkeiten.

- HumanEval / HumanEval+ (Codegenerierung): Bei den Aufgaben zur Codegenerierung und zum Codeverständnis übertrifft Phi-4 Modelle seiner Größe und kommt sogar an größere Modelle heran.

2. interne Evaluierungssuite (PhiBench)

Um einen Einblick in die Fähigkeiten und Unzulänglichkeiten des Modells zu erhalten, entwickelte das Team ein spezielles internes Bewertungsprogramm PhiBench::

- Die Aufgabe der Diversifizierung: Umfasst Code-Debugging, Code-Vervollständigung, mathematisches Denken und Fehlererkennung.

- Leitfaden zur Modelloptimierung: Durch die Analyse der PhiBench-Ergebnisse war das Team in der Lage, gezielte Verbesserungen am Modell vorzunehmen.

VIII. sicherheit und haftung

1. strikte Strategie zur Anpassung der Sicherheit

Die Entwicklung von Phi-4 folgt Microsofts Grundsätze für verantwortungsvolle KIDer Schwerpunkt liegt dabei auf der Sicherheit und Ethik des Modells während der Ausbildung und der Feinabstimmung:

- Schutz vor schädlichen Inhalten: Verringern Sie die Wahrscheinlichkeit, dass das Modell ungeeignete Inhalte erzeugt, indem Sie in der Nachtrainings-Phase Daten zur Sicherheits-Feinabstimmung einbeziehen.

- Red-Team-Tests und automatisierte Bewertung: Es wurden umfangreiche Red-Team-Tests und automatisierte Sicherheitsbewertungen durchgeführt, die Dutzende von potenziellen Risikokategorien abdeckten.

2. die Dekontaminierung von Daten und die Vermeidung von Overfitting

- Verbesserte Strategien zur Dekontaminierung von Daten: Ein hybrider 13-Gramm- und 7-Gramm-Algorithmus wird verwendet, um mögliche Überschneidungen der Trainingsdaten mit den Review-Benchmarks zu vermeiden und eine Überanpassung des Modells zu verhindern.

IX. ressourcen und Zeit für die Ausbildung

1. die Ausbildungszeit

Obwohl der offizielle Bericht keine Angaben zur Gesamtausbildungszeit für den Phi-4 macht, sollte man sich das vor Augen halten:

- Modell Maßstab: 14B Parameter.

- Menge der Trainingsdaten: Vor der Ausbildungsphase 10T Token, während der Ausbildungsphase 250B Token.

Es lässt sich vermuten, dass der gesamte Ausbildungsprozess viel Zeit in Anspruch genommen hat.

2. der GPU-Ressourcenverbrauch

| GPUs | 1920 H100-80G |

| Ausbildungszeit | 21 Tage |

| Trainingsdaten | 9.8T Token |

X. Anwendungen und Grenzen

1. die Anwendungsszenarien

- Q&A-System: Phi-4 erbringt gute Leistungen bei komplexen Quizaufgaben und ist für alle Arten von intelligenten Quizanwendungen geeignet.

- Code-Generierung und -Verständnis: Hervorragend geeignet für Programmieraufgaben und kann in Szenarien wie Code-Tutoring, automatische Generierung und Debugging eingesetzt werden.

- Mehrsprachige Übersetzung und Verarbeitung: Mehrsprachige Unterstützung für globalisierte Sprachdienste.

2. mögliche Einschränkungen

- Wissensabgrenzung: Die Kenntnisse des Modells enden bei den Trainingsdaten und wissen möglicherweise nichts über Ereignisse, die nach dem Training auftreten.

- Lange Sequenz Herausforderung: Obwohl die Kontextlänge auf 16K erweitert wurde, kann es bei längeren Sequenzen immer noch zu Problemen kommen.

- Risikokontrolle: Trotz strenger Sicherheitsvorkehrungen können die Modelle immer noch Opfer von Angriffen oder der versehentlichen Erzeugung unangemessener Inhalte werden.

Der Erfolg von Phi-4 zeigt, wie wichtig die Datenqualität und die Trainingsstrategie bei der Entwicklung von Sprachmodellen in großem Maßstab sind. Durch innovative Methoden zur Generierung synthetischer Daten, sorgfältige Strategien zum Mischen von Trainingsdaten und fortschrittliche Trainingstechniken erreicht Phi-4 eine hervorragende Leistung bei gleichzeitig kleiner Parametergröße:

- Das logische Denkvermögen ist hervorragend: Hervorragende Leistungen in den Bereichen Mathematik, Naturwissenschaften und Programmierung.

- Verarbeitung langer Texte: Die erweiterte Kontextlänge verleiht dem Modell einen Vorteil bei der Verarbeitung langer Texte.

- Sicherheit und Verantwortung: Die strikte Einhaltung der Grundsätze der verantwortungsvollen KI gewährleistet, dass die Modelle sicher und ethisch vertretbar sind.

Phi-4 setzt neue Maßstäbe bei der Entwicklung kleiner parametrischer quantitativer Modelle und zeigt, dass durch die Konzentration auf Datenqualität und Trainingsstrategien auch bei kleineren Parameterskalen eine hervorragende Leistung erzielt werden kann.

Referenzen: /https://www.microsoft.com/en-us/research/uploads/prod/2024/12/P4TechReport.pdf

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...