Microsoft Azure+Copilot+AI PC-Produkte unterstützen vollständig DeepSeek R1 Modelle

Am 30. Januar 2025 teilte Microsoft mit, dass das R1-Modell von DeepSeek jetzt auf seiner Cloud-Computing-Plattform Azure und den GitHub-Tools für Entwickler im Allgemeinen verfügbar ist. Microsoft sagte auch, dass Kunden bald in der Lage sein werden, das R1-Modell von DeepSeek auf ihren Kopilot + Führen Sie das R1-Modell lokal auf dem PC aus.

Wie bereits erwähnt, wird Copilot neben OpenAI nach und nach auch andere große Modelle verwenden:

Microsoft war in letzter Zeit häufiger in den Nachrichten, und einer der bemerkenswertesten Punkte ist, dass dieDer Kopilot von GitHub ist kostenlos und offen!auf, wenn auch in geringerer Zahl (2.000 pro Monat für Code-Vervollständigungen und 50 pro Monat für Chat-Konversationen), aber zumindest ist es ein Meilenstein, und das Modell wurde von dem ursprünglichen einzelnen GPT 4o auf o1 erweitert Claude im Gesang antworten Zwillinge und viele andere Modelle.

Das bedeutet, dass Microsoft sich jetzt von seiner Abhängigkeit von der OpenAI-Technologie löst, die in gewisser Hinsicht nicht mehr das beste Modell und leider auch nicht mehr das kostengünstigste ist.

Infolge der jüngsten Deepseek Der stärkere Einfluss in der Welt, eine Reihe von auffälligen neuen Funktionen weiterhin online zu kommen, sondern auch verursacht das Leben und Tod Wettbewerb zwischen China und den Vereinigten Staaten im Bereich der KI, Microsoft, um Copilot bessere Unterstützung für die chinesische Sprache, bereit, Deepseek's R1-Modell in Copilot verwenden zu machen.

Der Microsoft-CEO betonte in der Telefonkonferenz auch, dass die DeepSeek R1-Modelle jetzt über Microsofts KI-Plattform Azure AI Foundry und GitHub verfügbar sind und bald auch auf Copilot+-Computern laufen können werden. Nadella sagte, dass DeepSeek "einige echte Innovationen" biete und dass die Kosten für KI tendenziell sinken: "Das Skalierungsgesetz baut sich bei den Berechnungen der Pre-Training- und Inferenzzeit auf. Im Laufe der Jahre haben wir erhebliche Effizienzsteigerungen beim KI-Training und bei der Inferenz festgestellt. Auf der Inferenzseite sehen wir in der Regel eine mehr als zweifache Verbesserung des Preis-Leistungs-Verhältnisses pro Hardware-Generation und eine mehr als 10-fache Verbesserung des Preis-Leistungs-Verhältnisses pro Modellgeneration."

Wir freuen uns darüber.

copilot für Microsoft 365 ist ein natives copilot plugin für office 365 (word, excel, ppt, OneNote, teams, etc.), das Inhalte basierend auf anderen Dateien in word generieren kann, Formeln und Berechnungen in excel erzeugt, Präsentationen basierend auf anderen Dateien in PPT erstellt. Sie können auch Präsentationen aus anderen Dokumenten in PPT erstellen, Notizen organisieren und weitere Notizen in OneNote erstellen, Besprechungen in Teams zusammenfassen und vieles mehr.

Zugehörige Lektüre 1: "Lokale Ausführung destillationsoptimierter DeepSeek R1-Modelle auf Copilot+ PCs

KI verlagert sich an den Rand und Copilot+ PCs sind führend auf diesem Weg. Während Azure AI Foundry mit dem in der Cloud gehosteten DeepSeek R1 in Betrieb geht (siehe dazu auch 2), bringen wir eine NPU-optimierte Version von DeepSeek-R1 direkt auf Copilot+ PCs, mit den ersten Anpassungen für die Qualcomm Snapdragon X-Plattform, gefolgt von der Unterstützung für Plattformen wie Intel Core Ultra 200V. Die erste Version von DeepSeek-R1-Distill-Qwen-1.5B wird auf AI Toolkit verfügbar sein, die Versionen 7B und 14B werden folgen. Diese optimierten Modelle ermöglichen es Entwicklern, KI-Anwendungen zu erstellen und einzusetzen, die effizient auf dem Gerät laufen und die Leistung der NPU in Copilot+ PC voll ausschöpfen.

Die Neural Processing Unit (NPU) von Copilot+ PC bietet eine hocheffiziente Engine für die Modellinferenz und eröffnet damit ein neues Paradigma für generative KI, die nicht nur nach Bedarf ausgeführt werden kann, sondern auch semikontinuierlich laufende Dienste ermöglicht. Dies ermöglicht es Entwicklern, proaktive, kontinuierliche Erfahrungen mit leistungsstarken Inferenz-Engines zu erstellen. Durch die Anhäufung von Technologien aus dem Phi Silica-Projekt haben wir eine effiziente Inferenz erreicht, die die Batterielebensdauer und den Systemressourcenverbrauch minimiert und gleichzeitig wettbewerbsfähige First Token-Antwortzeiten und Durchsatzraten gewährleistet. modulares Design für ein optimales Gleichgewicht zwischen Leistung und Effizienz, Quantisierungstechniken mit geringer Bitbreite und Transformer's Mapping-Strategie auf der NPU. Darüber hinaus nutzen wir die Windows Copilot Runtime (WCR), um über das ONNX QDQ-Format eine Skalierung über das Windows-Ökosystem zu ermöglichen.

Erleben Sie es jetzt!

Erstens... Fangen wir schnell an.

Um DeepSeek auf Copilot+ PCs zu erleben, laden Sie einfach die VS Code-Erweiterung für AI Toolkit herunter. ONNX QDQ-formatierte, optimierte DeepSeek-Modelle werden bald im AI Toolkit-Modell-Repository verfügbar sein und direkt aus der Azure AI Foundry gezogen. Klicken Sie auf die Schaltfläche "Download", um die Modelle lokal herunterzuladen. Nach dem Download öffnen Sie einfach den Playground, laden das Modell "deepseek_r1_1_5" und beginnen mit den Prompts zu experimentieren.

Zusätzlich zu dem für Copilot+ PC optimierten ONNX-Modell können Sie auch das ONNX-Modell für Copilot+ PC verwenden, indem Sie auf die Schaltfläche "DeepSeek R1"Anprobieren". Spielplatz", um das ursprüngliche Modell zu erleben, das in der Cloud in Azure Foundry gehostet wird.

Das AI Toolkit ist ein wichtiger Teil des Entwickler-Workflows und unterstützt das Experimentieren mit Modellen und die Bereitschaft zur Bereitstellung. Mit diesem Playground können Sie DeepSeek-Modelle einfach in Azure AI Foundry für die lokale Bereitstellung testen.

Optimierung auf Chipebene

Das für die Destillation optimierte Qwen 1.5B-Modell enthält einen Tokenizer, eine Einbettungsschicht, ein Kontextverarbeitungsmodell, ein Token-Iterationsmodell, einen Sprachmodell-Header und ein Detokenizer-Modul.

Wir verwenden 4-Bit-Chunk-Quantisierung für die Einbettungsschicht und den Sprachmodell-Header und führen diese speicherintensiven Operationen auf der CPU aus. Da sich die wichtigsten NPU-Optimierungsressourcen auf das rechenintensive Transformer-Modul konzentrieren, das die Kontextverarbeitung und die Token-Iteration enthält, wird eine kanalweise Quantisierung mit int4 verwendet, und für die Gewichte wird eine selektive Verarbeitung mit gemischter Genauigkeit implementiert, während die Aktivierungswerte eine Genauigkeit von int16 verwenden.

Obwohl die DeepSeek-Version von Qwen 1.5B eine int4-Version hat, kann sie nicht direkt an NPUs angepasst werden, da es dynamische Eingabeformen und Verhaltensweisen gibt - diese müssen für Kompatibilität und optimale Effizienz optimiert werden. Darüber hinaus verwenden wirONNX QDQFormat, um die Skalierung verschiedener Typen von NPUs im Windows-Ökosystem zu unterstützen. Wir optimieren das Operator-Layout zwischen CPU und NPU, um das beste Gleichgewicht zwischen Stromverbrauch und Geschwindigkeit zu erreichen.

Um die beiden Ziele eines geringen Speicherbedarfs und einer schnellen Inferenz (ähnlich dem Phi-Silica-Schema) zu erreichen, nehmen wir zwei wesentliche Verbesserungen vor: Erstens verwenden wir ein Gleitfensterdesign, das eine ultraschnelle erste Token-Antwortzeit und eine lange Kontextunterstützung ermöglicht, selbst wenn der Hardware-Stack keinen dynamischen Tensor unterstützt; und zweitens verwenden wir ein 4-Bit-QuaRot-Quantisierungsschema, das die Vorteile der Verarbeitung mit geringer Bit-Breite voll ausschöpft. QuaRot eliminiert Ausreißer in Gewichten und Aktivierungswerten durch Hadamard-Rotation, wodurch das Modell leichter zu quantisieren ist. Im Vergleich zu bestehenden Methoden wie GPTQ verbessert QuaRot die Quantisierungsgenauigkeit erheblich, insbesondere in Szenarien mit geringer Granularität wie der Kanal-für-Kanal-Quantisierung. Die Kombination aus Quantisierung mit geringer Bitbreite und Hardware-Optimierungen wie dem Sliding-Window-Design ermöglicht es dem Modell, die Verhaltenseigenschaften eines großen Modells bei kompaktem Speicherbedarf zu erreichen. Als Ergebnis dieser Optimierungen erreicht das Modell eine erste Token-Antwortzeit von 130 ms und eine Durchsatzrate von 16 Token/Sekunde in Szenarien mit kurzen Cues (<64 Token).

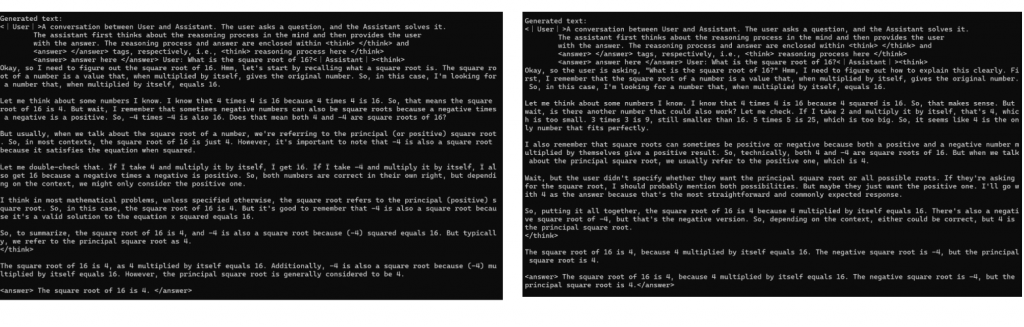

Wir demonstrieren die feinen Unterschiede zwischen der ursprünglichen Modellreaktion und der quantitativen Modellreaktion anhand des folgenden Beispiels, mit dem eine Optimierung der Energieeffizienz bei gleichbleibend hoher Leistung erreicht wird:

Abb. 1: Qualitativer Vergleich. Beispiele des ursprünglichen Modells (links) und des NPU-optimierten Modells (rechts), die auf die gleichen Hinweise reagieren, einschließlich einer Demonstration der Argumentationskraft des Modells. Das optimierte Modell behält das Denkmuster des ursprünglichen Modells bei und kommt zu denselben Schlussfolgerungen, was zeigt, dass die Denkfähigkeit des ursprünglichen Modells erhalten bleibt.

Dank der überragenden Geschwindigkeit und Energieeffizienz des NPU-optimierten DeepSeek R1-Modells können Nutzer mit diesen bahnbrechenden Modellen lokal und völlig autonom interagieren.

Lesen Sie weiter 2: "DeepSeek R1 jetzt auf Azure AI Foundry und GitHub verfügbar

DeepSeek R1 ist jetzt verfügbar Azure AI Foundry und den Modellkatalog von GitHub und ergänzt damit ein vielfältiges Portfolio von mehr als 1.800 Modellen, das modernste, quelloffene, branchenspezifische und aufgabenorientierte KI-Modelle umfasst. Als Teil der Azure AI Foundry ist DeepSeek R1 über eine vertrauenswürdige, skalierbare und unternehmenstaugliche Plattform zugänglich, die es Unternehmen ermöglicht, fortschrittliche KI-Technologien nahtlos zu integrieren und dabei SLAs, Sicherheit und das Versprechen einer verantwortungsvollen KI zu erfüllen - alles unterstützt durch die Zuverlässigkeit und Innovation von Microsoft. all dies wird durch die Zuverlässigkeit und Innovation von Microsoft gestützt.

Beschleunigung von AI Reasoning für Azure AI Foundry-Entwickler

KI gewinnt in rasantem Tempo an Popularität und verändert die Art und Weise, wie Entwickler und Unternehmen hochmoderne Intelligenz einsetzen. Wie DeepSeek erklärt, bietet R1 leistungsstarke und kosteneffiziente Modelle, die es mehr Anwendern ermöglichen, mit minimalen Infrastrukturinvestitionen auf die fortschrittlichsten KI-Funktionen zuzugreifen.

Der Hauptvorteil der Verwendung von DeepSeek R1 oder anderen Modellen in Azure AI Foundry ist die Geschwindigkeit, mit der Entwickler experimentieren, iterieren und KI in ihre Arbeitsabläufe integrieren können. Mit den integrierten Tools zur Modellbewertung können Entwickler schnell Ergebnisse vergleichen, Leistungsbenchmarks auswerten und KI-gesteuerte Anwendungen skalieren. Dieser schnelle Zugriff, der noch vor wenigen Monaten unvorstellbar war, steht im Mittelpunkt unserer Vision für die Azure AI Foundry: die besten KI-Modelle an einem Ort zusammenzubringen, um Innovationen zu beschleunigen und neue Möglichkeiten für Unternehmen auf der ganzen Welt zu erschließen.

Entwickeln mit vertrauenswürdiger KI

Wir sind bestrebt, unsere Kunden bei der schnellen Entwicklung produktionsreifer KI-Anwendungen zu unterstützen und dabei die höchsten Sicherheitsstandards einzuhalten. deepSeek R1 hat strenge "Red-Team-Tests" und Sicherheitsevaluierungen durchlaufen, einschließlich automatisierter Bewertungen des Modellverhaltens und einer umfassenden Sicherheitsüberprüfung, um potenzielle Risiken zu minimieren. Die integrierte Inhaltsfilterung ist standardmäßig aktiviert und bietet flexible Opt-out-Optionen durch Azure AI Content Security. Darüber hinaus hilft ein Sicherheitsbewertungssystem den Kunden, Anwendungen vor der Bereitstellung effizient zu testen. Dank dieser Sicherheitsvorkehrungen bietet Azure AI Foundry Unternehmen eine sichere, konforme und verantwortungsvolle Umgebung für den Einsatz von KI-Lösungen.

Wie man DeepSeek in einem Modellkatalog verwendet

- Wenn Sie kein Azure-Abonnement haben, können Sie jetztRegistrieren Sie sich für ein Azure-Konto

- Suche nach DeepSeek R1 im Modellkatalog

- Öffnen Sie die Modellkarte im Modellkatalog von Azure AI Foundry

- Klicken Sie auf "Bereitstellen", um die Inferenz-API und den Schlüssel abzurufen und auf das Testbed zuzugreifen.

- Sie werden innerhalb von 1 Minute auf die Bereitstellungsseite mit der API und dem Schlüssel weitergeleitet und können versuchen, die Eingabeaufforderungen in der Testumgebung einzugeben

- Die API und der Schlüssel können von einer Vielzahl von Clients verwendet werden

Jetzt loslegen

DeepSeek R1 ist jetzt über einen serverlosen Endpunkt im Azure AI Foundry-Modellkatalog zugänglich.Greifen Sie noch heute auf die Azure AI Foundry zu und wählen Sie das DeepSeek-Modell.

Weitere Ressourcen und eine Schritt-für-Schritt-Anleitung zur nahtlosen Integration von DeepSeek R1 in Ihre Anwendung finden Sie auf GitHub. Lesen Sie GitHub-Modelle Blog-Beitrag.

In Kürze: Kunden werden in der Lage sein, DeepSeek R1 lokal auf Copilot+ PCs zu nutzen. Mehr lesen Windows-Entwickler Blog-Beitrag.

Während wir den Katalog der Azure AI Foundry Modelle weiter ausbauen, freuen wir uns darauf zu sehen, wie Entwickler und Unternehmen DeepSeek R1 nutzen, um reale Herausforderungen zu bewältigen und transformative Erfahrungen zu schaffen. Wir sind bestrebt, das umfassendste Portfolio an KI-Modellen bereitzustellen, um sicherzustellen, dass Unternehmen jeder Größe Zugang zu modernsten Tools haben, um Innovation und Erfolg zu fördern.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...