VITA: Open Source Multimodale Großsprachmodelle für visuelle und sprachliche Interaktion in Echtzeit

Allgemeine Einführung

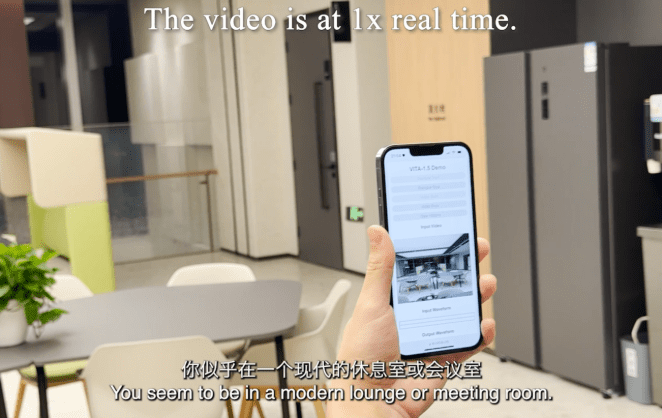

VITA ist ein führendes Open-Source-Projekt zur interaktiven multimodalen Modellierung großer Sprachen und leistet Pionierarbeit bei der Ermöglichung echter multimodaler Interaktion. Das Projekt brachte im August 2024 VITA-1.0 auf den Markt und leistete damit Pionierarbeit für das erste quelloffene interaktive multimodale große Sprachmodell. Im Dezember 2024 brachte das Projekt eine wichtige Upgrade-Version, VITA-1.5, auf den Markt, die das Interaktionserlebnis und die Leistung erheblich verbessert.Das VITA-Modell unterstützt multimodale Ein- und Ausgaben wie Bild, Video, Audio usw. und die Fähigkeit zur Interaktion in Echtzeit, wodurch die End-to-End-Latenzzeit für die Sprachinteraktion von 4 Sekunden auf 1,5 Sekunden erheblich reduziert wird. Das VITA-Modell unterstützt multimodale Ein- und Ausgaben wie Bild, Video und Audio und verfügt über eine Echtzeit-Interaktionsfähigkeit, die die End-to-End-Latenzzeit für die Sprachinteraktion von 4 Sekunden auf 1,5 Sekunden deutlich reduziert und damit die Benutzererfahrung erheblich verbessert. Als vollständig quelloffenes Projekt bietet VITA eine ideale Plattform für Forscher und Entwickler zur Erforschung multimodaler KI.

Funktionsliste

- Multimodale Eingabeverarbeitung: Unterstützt Bild-, Video-, Audio- und andere Formen der Eingabe

- Sprachinteraktion in Echtzeit: End-to-End-Latenzzeit für Sprachinteraktionen von nur 1,5 Sekunden

- Visuelle Analysefunktionen: leistungsstarke Funktionen zum Verstehen und Analysieren von Bildern und Videos

- Audioverarbeitung: unterstützt Spracherkennung und Sprachsynthese

- Modalübergreifendes Verstehen: eine intelligente Korrelation zwischen Text, Bild und Ton

- Open-Source-Unterstützung: Der gesamte Code für Training und Inferenz ist offen.

- Vorgefertigte Modelle: mehrere Versionen von vorgefertigten Modellen sind verfügbar

- Flexible Bereitstellungsoptionen: unterstützt die Bereitstellung mehrerer Hardware-Plattformen

VITA-1.5 Überblick

Am 12. August 2024 haben wir die VITA-1.0Dies ist Das erste quelloffene, interaktive, multimodale Makro-Sprachmodell. Und jetzt (20. Dezember 2024) bringen wir Ihnen die Neue Version VITA-1.5!

Was ist neu in VITA-1.5?

Wir freuen uns, Ihnen Folgendes präsentieren zu können VITA-1.5, die eine Reihe von Fortschritten brachte:

- Deutliche Reduzierung der Interaktionslatenz.. Die End-to-End-Latenzzeit für Sprachinteraktionen hat sich von Ca. 4 Sekunden Ermäßigung auf 1,5 SekundenDies ermöglicht eine nahezu sofortige Interaktion und verbessert das Nutzererlebnis erheblich.

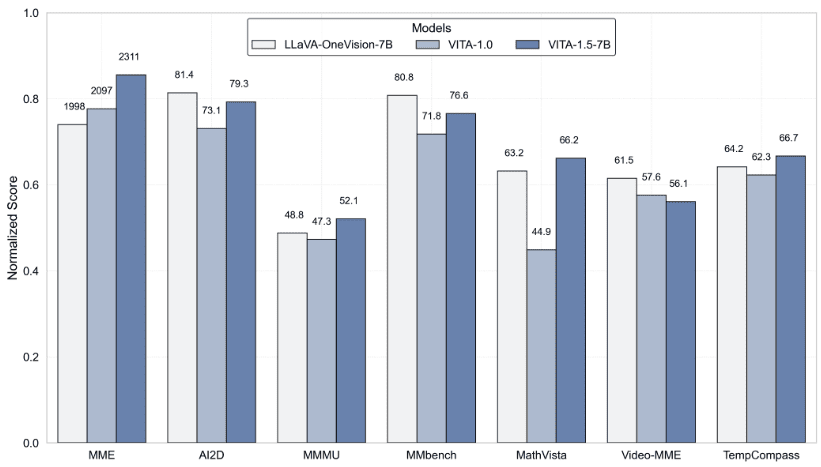

- Verbesserte multimodale Leistung. Unter MMEundMMBench im Gesang antworten MathVista Die durchschnittliche Leistung bei multimodalen Benchmarks, wie dem 59.8 erhöhen sie auf 70.8.

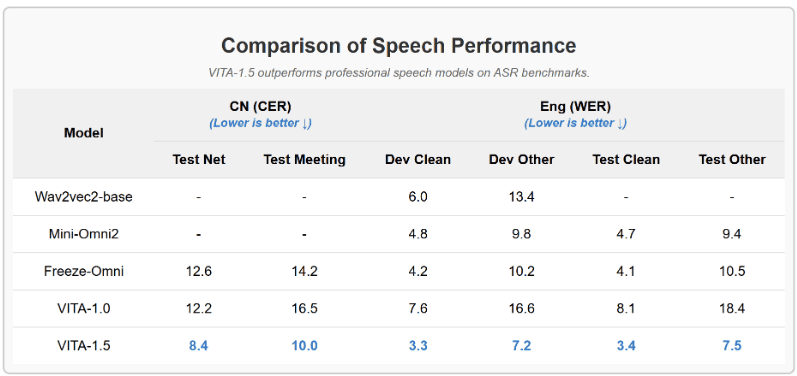

- Erweiterung der Sprachverarbeitungsfähigkeiten.. Es wurde ein neues Niveau der Sprachverarbeitungsleistung erreicht, wobei die ASR WER (Word Error Rate, Test Other) von 18.4 Verringern auf 7.5. Darüber hinaus haben wir End-to-End-TTS-Modul Ersetzt das eigenständige TTS-Modul von VITA-1.0, das als Eingabe die Einbettung großer Sprachmodelle akzeptiert.

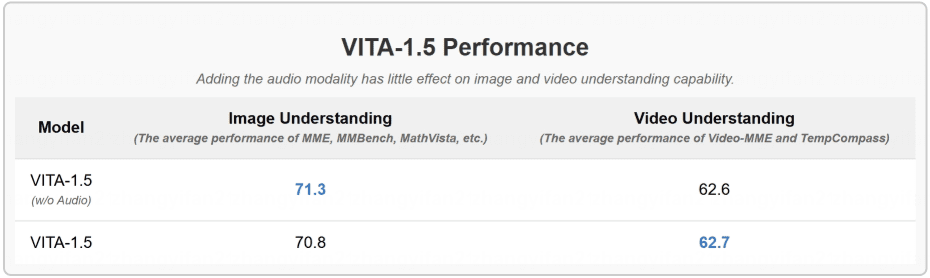

- Progressive Ausbildungsstrategien. Auf diese Weise hat die Einbeziehung des Sprachmoduls kaum Auswirkungen auf die anderen multimodalen Leistungen (visuell-verbal). Die durchschnittliche Leistung beim Bildverständnis sank lediglich von 71,3 auf 70,8.

Ergebnisse

- Auswertung von Bild- und Videoverstehens-Benchmarktests

- VITA-1.5 übertrifft professionelle Sprachmodelle in ASR-Benchmarks

- Die Hinzufügung der Audiomodalität hat kaum Auswirkungen auf das Verständnis von Bildern und Videos

Hilfe verwenden

1. die Konfiguration und Installation der Umgebung

1.1 Anforderungen an das Fundament:

- Python-Umgebung

- PyTorch-Rahmenwerk

- CUDA-Unterstützung (GPU-Beschleunigung empfohlen)

1.2 Installationsschritte:

# 克隆项目仓库

git clone https://github.com/VITA-MLLM/VITA.git

cd VITA

# 安装依赖

pip install -r requirements.txt

2. die Verwendung von Modellen

2.1 Laden des vortrainierten Modells:

from vita.model.builder import load_pretrained_model

from vita.conversation import conv_templates

from vita.util.mm_utils import get_model_name_from_path

# 加载模型

model_path = 'VITA/vita'

model_name = get_model_name_from_path(model_path)

tokenizer, model, image_processor, _ = load_pretrained_model(

model_path,

None,

model_name,

model_type='mixtral-8x7b',

device_map='auto'

)

2.2 Konfiguration der Audioverarbeitung:

# 初始化音频编码器

audio_encoder = model.get_audio_encoder()

audio_encoder.to(dtype=torch.float16)

audio_processor = audio_encoder.audio_processor

3. interaktive Funktionen in Echtzeit

- Unterstützt Echtzeit-Spracheingabe und -Antwort

- Integrierte Bilderkennung und -analyse

- Unterstützt Multirunden-Dialog-Interaktionen

- Bereitstellung eines vollständigen Dialogvorlagensystems

4. die Nutzung der erweiterten Funktionen

4.1 Multimodale Eingabeverarbeitung:

- Unterstützt die Stapelverarbeitung von Bildern

- Analyse von Videoströmen in Echtzeit

- Verarbeitung und Synthese von Audioströmen

4.2 Modelltraining und Feinabstimmung:

- Bietet vollständige Schulungsskripte

- Unterstützung von Funktionen für kontinuierliches Lernen

- Unterstützung beim Training mit benutzerdefinierten Datensätzen

5. die Bewertung und Prüfung

- Unterstützt die wichtigsten multimodalen Bewertungsmaßstäbe

- Integriertes Auswertetool VLMEvalKit

- Liefert detaillierte Metriken für Leistungstests

6. vorsichtsmaßnahmen

- GPUs werden für die Modellinferenz empfohlen

- Achten Sie auf die Speicherverwaltung, insbesondere bei großen multimodalen Eingaben

- Prüfen Sie regelmäßig die Projektaktualisierungen auf die neuesten Funktionen und Optimierungen

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...