Vision Parse: Intelligente Konvertierung von PDF-Dokumenten in das Markdown-Format mithilfe visueller Sprachmodelle

Allgemeine Einführung

Vision Parse ist ein revolutionäres Werkzeug zur Dokumentenverarbeitung, das auf intelligente Weise modernste Technologie zur visuellen Sprachmodellierung (Vision Language Models) kombiniert, um PDF-Dokumente auf intelligente Weise in hochwertige Inhalte im Markdown-Format zu konvertieren. Das Tool unterstützt eine Vielzahl von Top visuelle Sprachmodelle, einschließlich OpenAI, LLama und Google Gemini, etc., kann genau den Text und Tabellen im Dokument zu extrahieren, und die hierarchische Struktur des Originaldokuments, Stil und Einrückung zu erhalten.Vision Parse unterstützt nicht nur mehrseitige PDF-Verarbeitung, sondern bietet auch ein lokales Modell Bereitstellungsoptionen, so dass die Benutzer in der gleichen Zeit, um sicherzustellen, dass das Dokument Sicherheit sein kann Offline-Verarbeitung. Sein einfaches API-Design ermöglicht es Entwicklern, komplexe Dokumentkonvertierungsaufgaben mit nur wenigen Zeilen Code zu erreichen, was die Effizienz und Genauigkeit der Dokumentenverarbeitung erheblich verbessert.

Funktionsliste

- Intelligente Inhaltsextraktion: Verwendung fortschrittlicher visueller Sprachmodelle zur genauen Erkennung und Extraktion von Text- und Tabelleninhalten

- Formatierungsintegrität: Beibehaltung der gesamten hierarchischen Struktur, des Stils und der Einrückungsformatierung des Dokuments

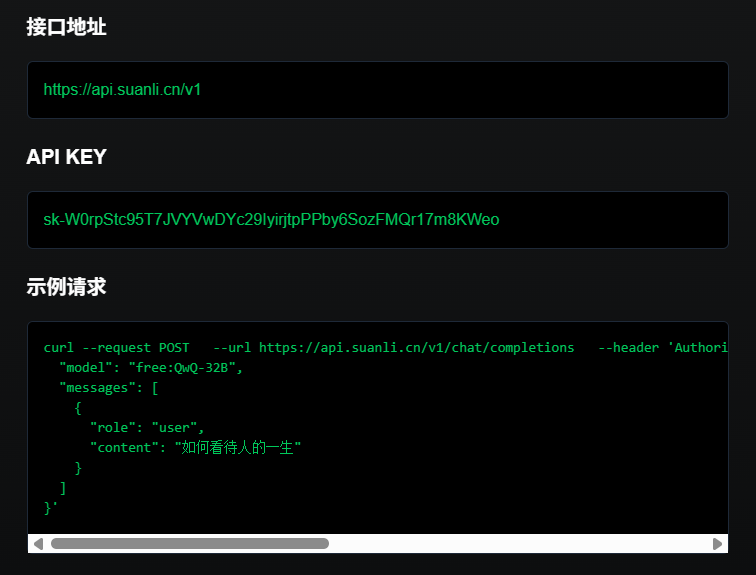

- Unterstützung mehrerer Modelle: kompatibel mit OpenAI, LLama, Gemini und anderen Anbietern visueller Sprachmodelle

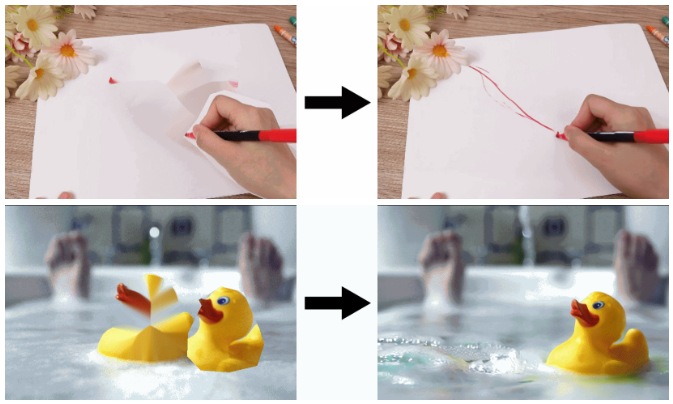

- PDF-Mehrseitenverarbeitung: Unterstützung für mehrseitige PDF-Dokumente, die zur Verarbeitung in base64-kodierte Bilder umgewandelt werden

- Lokale Modellbereitstellung: Unterstützung der lokalen Modellbereitstellung durch Ollama für Dokumentensicherheit und Offline-Nutzung.

- Benutzerdefinierte Konfiguration: Unterstützung von benutzerdefinierten PDF-Verarbeitungsparametern, wie DPI, Farbraum, etc.

- Flexible API: bietet eine einfache und intuitive Python-API-Schnittstelle

Hilfe verwenden

1. die Vorbereitung der Installation

Grundlegende Anforderungen:

- Python 3.9 oder höher

- Um das lokale Modell zu verwenden, müssen Sie Ollama installieren.

- Der entsprechende API-Schlüssel ist erforderlich, um OpenAI oder Google Gemini zu verwenden

Installationsschritte:

- Verwenden Sie pip, um das Basispaket zu installieren:

pip install vision-parse

- Installieren Sie bei Bedarf weitere Abhängigkeiten:

- OpenAI-Unterstützung:

pip install 'vision-parse[openai]' - Zwillinge unterstützen:

pip install 'vision-parse[gemini]'

2. grundlegende Verwendung

Beispiel-Code:

from vision_parse import VisionParser

# 初始化解析器

parser = VisionParser(

model_name="llama3.2-vision:11b", # 使用本地模型

temperature=0.4,

top_p=0.3,

extraction_complexity=False # 设置为True获取更详细的提取结果

)

# 转换PDF文件

pdf_path = "your_document.pdf"

markdown_pages = parser.convert_pdf(pdf_path)

# 处理转换结果

for i, page_content in enumerate(markdown_pages):

print(f"\n--- 第 {i+1} 页 ---\n{page_content}")

3. erweiterte Konfiguration

PDF-Seiten-Konfiguration:

from vision_parse import VisionParser, PDFPageConfig

# 配置PDF处理设置

page_config = PDFPageConfig(

dpi=400,

color_space="RGB",

include_annotations=True,

preserve_transparency=False

)

# 使用自定义配置初始化解析器

parser = VisionParser(

model_name="llama3.2-vision:11b",

temperature=0.7,

top_p=0.4,

page_config=page_config

)

4. unterstützende Modelle

Vision Parse unterstützt eine breite Palette gängiger visueller Sprachmodelle:

- OpenAI-Modelle: gpt-4o, gpt-4o-mini

- Google Gemini-Modelle: gemini-1.5-flash, gemini-2.0-flash-exp, gemini-1.5-pro

- Meta Llama und Llava (durch Ollama): llava:13b, llava:34b, llama3.2-vision:11b, llama3.2-vision:70b

5. techniken der Verwendung

- Wahl des richtigen Modells: Wählen Sie je nach Bedarf ein lokales Modell oder einen Cloud-basierten Dienst

- Einstellung der Parameter: Kreativität und Genauigkeit der Ausgabe wird durch die Parameter Temperatur und top_p eingestellt.

- Extraktionskomplexität: für komplexe Dokumente wird empfohlen, extraction_complexity=True zu setzen

- Lokale Bereitstellung: Die sensible Dokumentation empfiehlt die Verwendung von Ollama für die lokale Modellbereitstellung

- PDF-Konfiguration: je nach den Eigenschaften des Dokuments, um die DPI und den Farbraum und andere Parameter anzupassen

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...