Kostenloser Kurs über die Funktionsweise von Transformer LLMs von Enda Wu

Wie funktionieren Transformer LLMs?

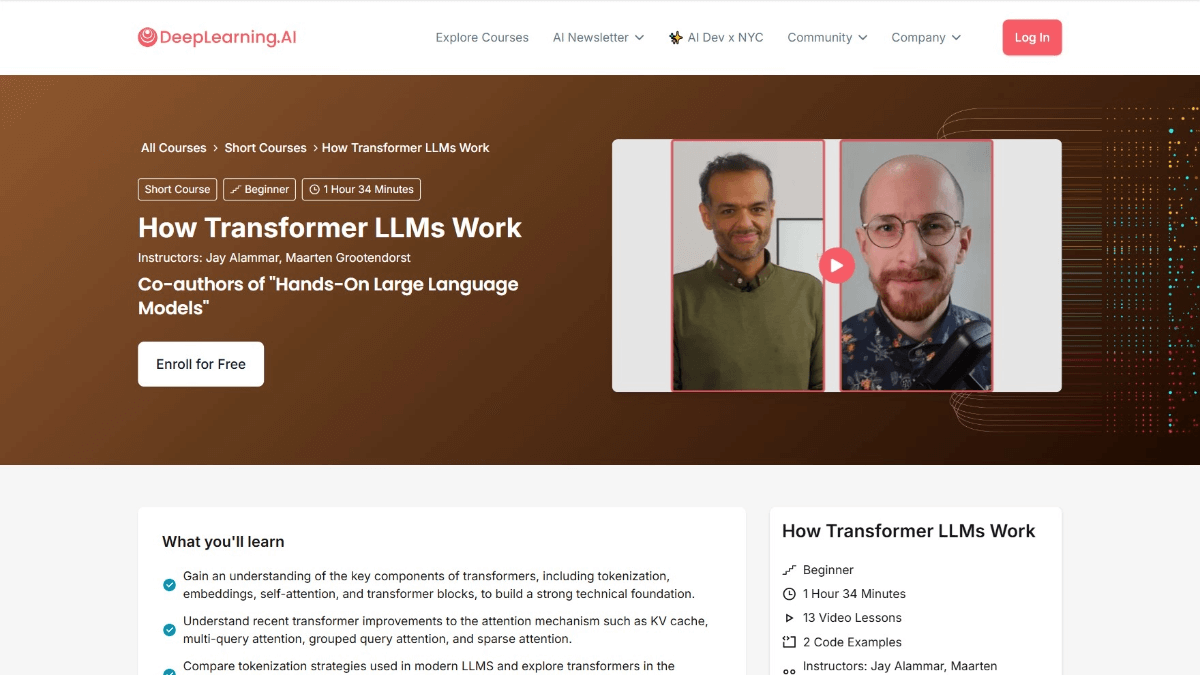

Transformator How LLMs Work ist ein Kurs von DeepLearning.AI in Zusammenarbeit mit Jay Alammar und Maarten Grootendorst, den Autoren von Hands-On Large Language Models. Der Kurs bietet einen detaillierten Einblick in die Transformer-Architektur, die Large Language Models (LLMs) unterstützt. Der Kurs beginnt mit der Entwicklung der numerischen Repräsentation von Sprachen und behandelt Themen wie Disambiguierung, den Aufmerksamkeitsmechanismus und die Feedforward-Schicht von Transformer-Blöcken sowie die Verbesserung der Leistung durch Zwischenspeicherung von Berechnungen. Nach Abschluss des Kurses werden die Benutzer ein tiefes Verständnis dafür haben, wie LLMs Sprachen verarbeiten, sie werden in der Lage sein, relevante Arbeiten zu lesen und zu verstehen, und sie werden ihre Fähigkeit verbessern, LLM-Anwendungen zu erstellen.

Kursziele für die Funktionsweise von LLMs für Transformatoren

- Die Entwicklung der numerischen Darstellung von Sprache verstehenVerstehen, wie Sprache digital dargestellt wird, von einfachen Bag-of-Words-Modellen bis hin zu komplexen Transformer-Architekturen.

- Partizip-Verarbeitung beherrschenLernen, wie man Eingabetext in "Token" zerlegt und verstehen, wie die Token in das Sprachmodell eingespeist werden.

- Eintauchen in die Transformer-ArchitekturDie drei Hauptphasen der Transformer-Architektur werden im Detail untersucht: Disambiguierung und Einbettung, Transformer-Blockstacking und der Sprachmodell-Header.

- Verstehen der Details des TransformatorblocksInklusive Aufmerksamkeitsmechanismen und Feedforward-Schichten und wie sie zusammenarbeiten, um Text zu verarbeiten und zu erzeugen.

- Optimierung der LernleistungLernen Sie, wie Sie die Leistung von Transformer durch Techniken wie Cache-Computing verbessern können.

- Erkundung der praktischen AnwendungErkundung neuer Modellimplementierungen für verbesserte praktische Anwendungen durch die Hugging Face Transformer-Bibliothek.

Kursübersicht über die Funktionsweise von Transformer LLMs

- Überblick über Transformator-LLMsEine Einführung in die Kursziele, die Struktur und die Bedeutung der Transformer-Architektur im Zusammenhang mit modernen Large Language Models (LLMs).

- Entwicklung der sprachlichen DarstellungEin Blick auf die Entwicklung der Sprachmodellierung von Bag-of-Words über Word2Vec bis hin zur Transformer-Architektur.

- Partizip und EinbettungLernen Sie, wie Eingabetext in Token zerlegt wird und wie man Token in Einbettungsvektoren umwandelt, einschließlich der Anwendung von Positionskodierung.

- Transformator-BlockVerstehen der Struktur des Transformer-Blocks, einschließlich des Selbstbeobachtungsmechanismus und der Rolle von Feedforward-Netzwerken.

- Lange AufmerksamkeitErforschen Sie, wie Multi-Head-Aufmerksamkeitsmechanismen die Modellleistung verbessern können, indem sie verschiedene Aspekte des Inputs durch mehrere "Köpfe" erfassen.

- Transformator-BlockstapelungLernen Sie, wie man tiefe Modelle durch das Stapeln mehrerer Transformer-Blöcke aufbaut und welche Rolle die Verknüpfung von Residuen und die Normalisierung von Schichten spielt.

- Kopfzeile des SprachmodellsTransformer: Verstehen, wie Transformer die Texterzeugung implementiert, indem es die Wahrscheinlichkeitsverteilung des nächsten Tokens aus dem Sprachmodell-Header generiert.

- Caching-MechanismusLernen Sie, wie Sie die Inferenzgeschwindigkeit von Transformer-Modellen durch Caching-Mechanismen verbessern können, und lernen Sie praktische Anwendungen des Caching kennen.

- Neueste architektonische InnovationenStellt die neuesten Innovationen bei Mixture-of-Experts (MoE) und anderen Transformer-Architekturen vor.

- Implementierung des Transformators mit umarmendem GesichtLernen Sie, wie Sie mit der Hugging Face Transformers-Bibliothek vortrainierte Transformer-Modelle laden und feinabstimmen können.

- Praktische Kodierung des TransformatorsLernen Sie, wie man die Schlüsselkomponenten des Transformers implementiert und einfache Transformatormodelle durch praktische Programmierübungen erstellt.

- Forschungspapier zum Lesen und VerstehenLernen Sie, wie man Forschungsarbeiten zum Thema Transformatoren liest und versteht, und analysieren Sie die neuesten Arbeiten und ihre Beiträge zu diesem Thema.

- Aufbau von LLM-BewerbungenErkunden Sie, wie LLM-basierte Anwendungen entwickelt werden können und diskutieren Sie zukünftige Richtungen und mögliche Anwendungen der Transformer-Architektur.

Kursadresse für die Funktionsweise von Transformer LLMs

- Adresse des Kurses::DeepLearning.AI

Für wen Transformer LLMs arbeiten

- Forscher auf dem Gebiet der Verarbeitung natürlicher Sprache (NLP)Eingehende Untersuchung der Transformer-Architektur, Erforschung von Spitzenanwendungen in den Bereichen Sprachverständnis, -generierung und -übersetzung sowie Förderung der Entwicklung von Technologien zur Verarbeitung natürlicher Sprache.

- Ingenieur für maschinelles LernenBeherrschen Sie die Funktionsweise von Transformer, um die Modellleistung zu optimieren, die Modellgenauigkeit und -effizienz zu verbessern und leistungsfähigere Sprachmodellanwendungen zu entwickeln.

- DatenwissenschaftlerVerarbeitung und Analyse umfangreicher Textdaten mit der Transformer-Architektur, Auswertung der Daten nach Mustern und Informationen zur Unterstützung der Entscheidungsfindung.

- SoftwareentwicklerIntegration von Transformer LLMs in verschiedene Softwareanwendungen, wie Chatbots, Inhaltsempfehlungssysteme usw., um die Produktintelligenz zu verbessern.

- Enthusiasten der Künstlichen IntelligenzSie interessieren sich für die Transformer-Architektur und möchten lernen, wie sie funktioniert, ein tieferes Verständnis der KI-Technologie erlangen und Ihren technischen Horizont erweitern.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...