Die Notwendigkeit von Cue Engineering bei der Modellierung großer Sprachen

Im Folgenden geht es um die Grundidee des Hint-Engineering und wie es die Leistung großer Sprachmodelle (LLMs) verbessern kann...

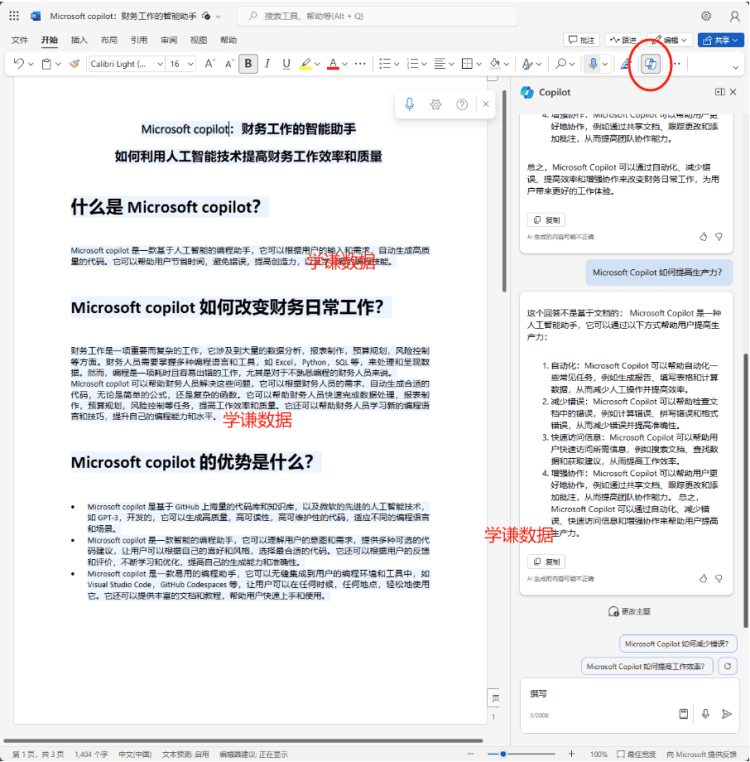

LLMs Schnittstelle:Einer der Hauptgründe, warum große Sprachmodelle so angesagt sind, ist, dass ihre Text-zu-Text-Schnittstellen eine minimalistische Betriebserfahrung ermöglichen. In der Vergangenheit erforderte die Lösung von Aufgaben mit Deep Learning in der Regel eine Feinabstimmung zumindest einiger Daten, um dem Modell beizubringen, wie die entsprechende Aufgabe zu lösen ist. Die meisten Modelle verfügten jedoch nur über Expertenwissen zu bestimmten Aufgaben. Dank der ausgezeichneten kontextuellen Lernfähigkeiten von LLM können wir nun eine Vielzahl von Problemen mit einem einzigen textuellen Hinweis lösen. Der ursprünglich komplexe Problemlösungsprozess wurde durch die Sprache abstrahiert!

"Prompt Engineering ist eine relativ neue Disziplin, die sich auf die effiziente Nutzung von Sprachmodellen konzentriert, um Prompts für eine Vielzahl von Anwendungen und Forschungsthemen zu entwickeln und zu optimieren." - Zitiert in [1]

Was ist das Tip-Projekt?Die Einfachheit von LLM macht es für mehr Menschen zugänglich. Sie müssen kein Datenwissenschaftler oder Ingenieur für maschinelles Lernen sein, um LLM zu nutzen, Sie müssen nur Englisch (oder eine andere Sprache Ihrer Wahl) verstehen und Sie können LLM nutzen, um relativ komplexe Probleme zu lösen! Wenn LLM jedoch Probleme lösen darf, hängen die Ergebnisse oft stark von den textuellen Hinweisen ab, die wir dem Modell geben. Infolgedessen ist das Cue Engineering (d.h. die Methode, die Erfahrung zu nutzen, um verschiedene Cues zu testen, um die Leistung des LLM zu optimieren) sehr populär geworden und hat einen großen Einfluss gehabt, was uns zu einer Reihe von Techniken und Best Practices geführt hat.

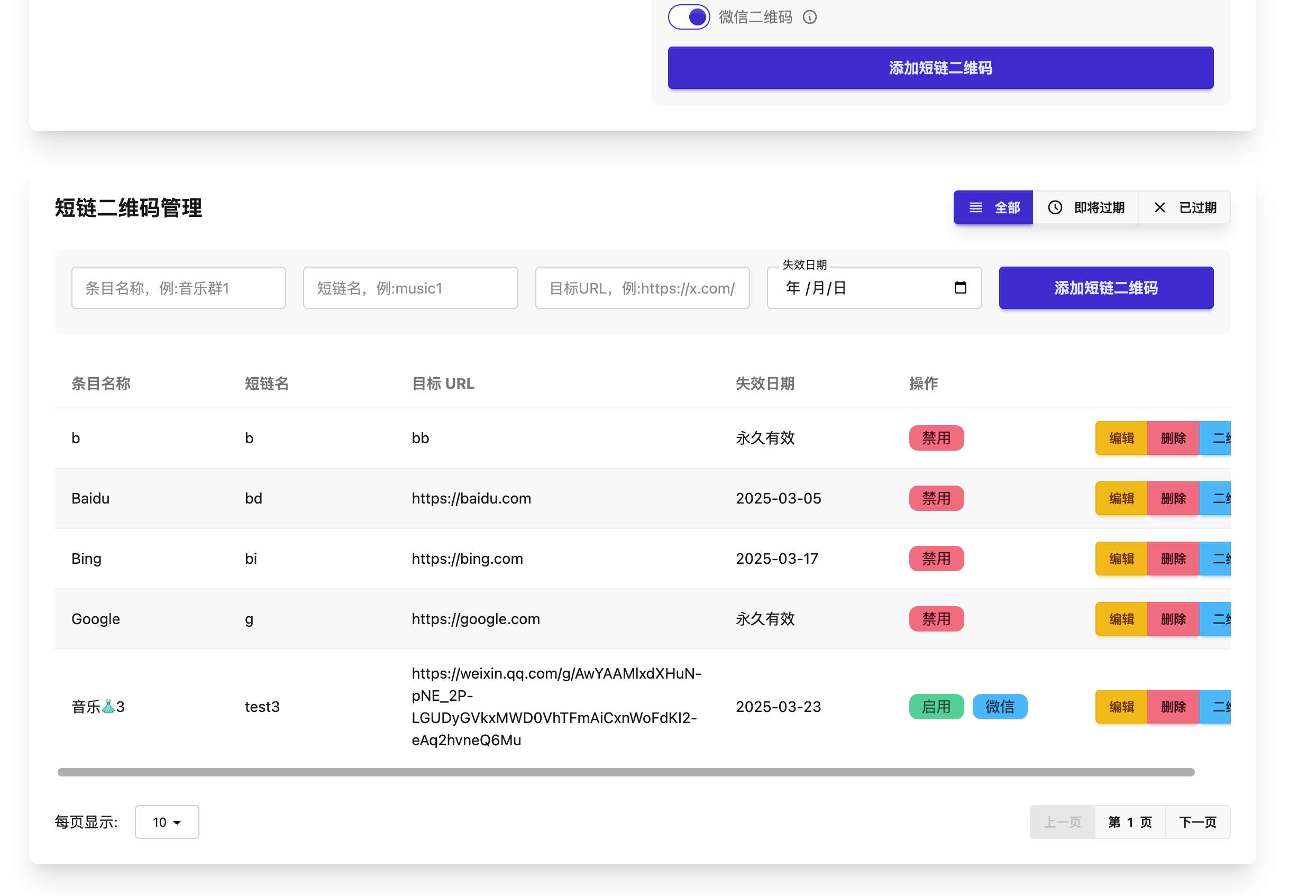

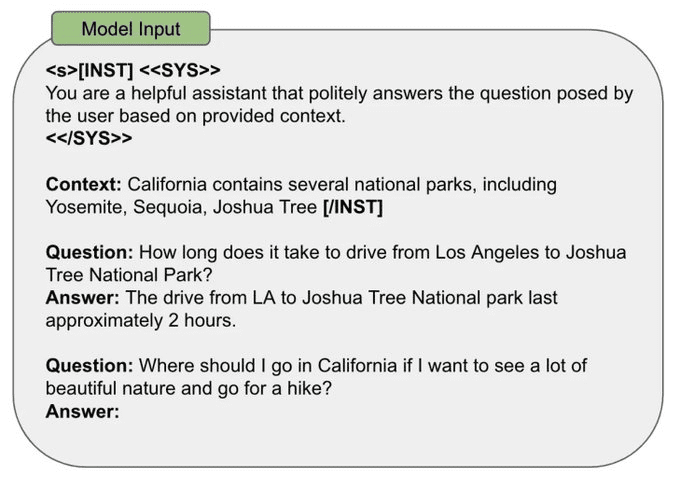

Wie man einen Prompt gestaltet:Es gibt viele Möglichkeiten, LLM-Hinweise zu gestalten. Die meisten Hinweisstrategien haben jedoch ein paar gemeinsame Punkte:

- Eingabedaten: die eigentlichen Daten, die LLM verarbeiten muss (z. B. zu übersetzende oder zu kategorisierende Sätze, zusammenzufassende Dokumente usw.).

- Beispiele: Beispiele für die richtigen Eingabe-Ausgabe-Paare, die in die Eingabeaufforderung aufzunehmen sind.

- Anweisung: Eine textliche Beschreibung der erwarteten Ergebnisse des Modells.

- Beschriftungen (Indikatoren): Beschriftungen oder Formatierungselemente, die die Eingabeaufforderung strukturieren.

- Kontext: alle zusätzlichen Informationen, die dem LLM in der Aufforderung gegeben werden.

In der folgenden Abbildung wird ein Beispiel dafür gegeben, wie alle oben genannten Cue-Elemente in einem einzigen Satz-Kategorisierungs-Cue zusammengeführt werden können.

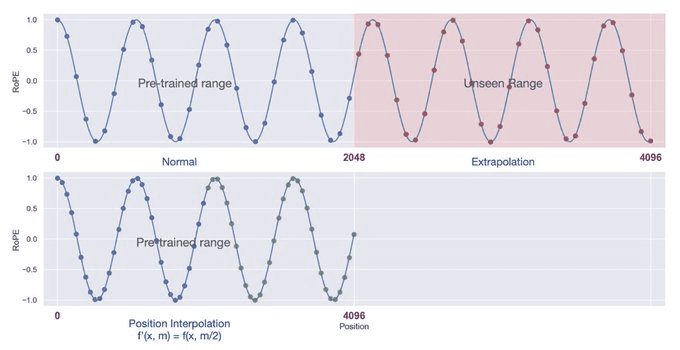

Kontext-Fenster:Während des Vortrainings sieht das LLM Eingabesequenzen mit einer bestimmten Länge. Während des Pre-Trainings wählen wir diese Sequenzlänge als "Kontextlänge" des Modells, d. h. als die maximale Sequenzlänge, die das Modell verarbeiten kann. Wenn ein Textstück gegeben wird, das deutlich länger als diese vorgegebene Kontextlänge ist, kann das Modell unvorhersehbar reagieren und falsche Ergebnisse ausgeben. In der Praxis gibt es jedoch Methoden - wie z. B. die Selbstexpansion [2] oder die Positionsinterpolation [3] -, mit denen das Kontextfenster des Modells erweitert werden kann.

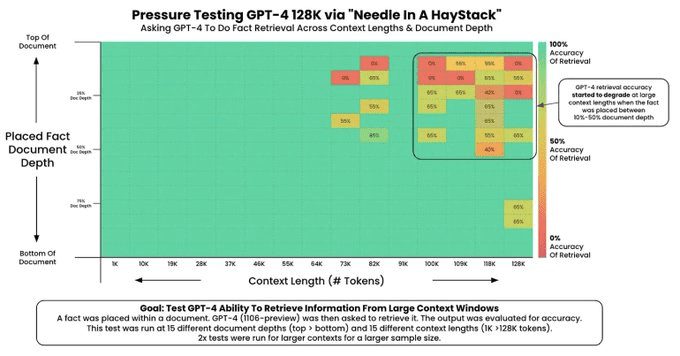

Neuere Forschungen zu LLMs haben den Schwerpunkt auf die Schaffung langer Kontextfenster gelegt, die es dem Modell ermöglichen, mehr Informationen pro Cue zu verarbeiten (z. B. mehr Beispiele oder mehr Kontext). Allerdings sind nicht alle LLMs in der Lage, ihre Kontextinformationen perfekt zu verarbeiten! Die Fähigkeit eines LLM, Informationen in einem langen Kontextfenster zu verarbeiten, wird in der Regel durch den "Nadel im Heuhaufen-Test" [4] bewertet, der.

1. eine zufällige Tatsache in den Kontext einbetten.

(2) Das Modell ist erforderlich, um diese Tatsache zu ermitteln.

3. diesen Test in verschiedenen Kontexten mit unterschiedlichen Längen und Positionen der Fakten im Kontext wiederholen.

Dieser Test erzeugt ein Bild wie das folgende (Quelle [4]), in dem man die Probleme mit dem Kontextfenster leicht erkennen kann.

Mein Stichwort Engineering-Strategie:Die Einzelheiten des Cue-Engineering variieren je nach verwendetem Modell. Es gibt jedoch einige allgemeine Grundsätze, die auch als Leitfaden für die Entwicklung von Cues dienen können:

- Empirischer Ansatz: Der erste Schritt beim Cue-Engineering besteht darin, ein zuverlässiges Verfahren zur Evaluierung Ihres Cues einzurichten (z. B. durch Testfälle, menschliche Bewertungen oder LLM als Rubrik), um Änderungen am Cue einfach zu messen.

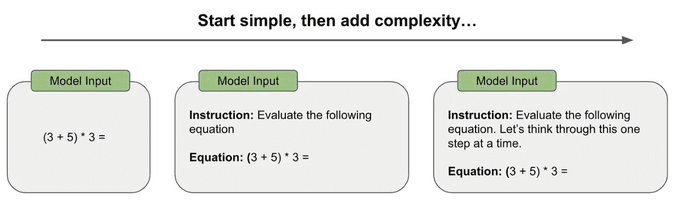

- Vom Einfachen zum Komplexen: Die ersten Versuche mit Prompts sollten so einfach wie möglich sein, anstatt von Anfang an komplexe Prompts für das Kettendenken oder andere spezialisierte Prompting-Techniken zu verwenden. Die ersten Prompts sollten einfach sein und dann allmählich an Komplexität zunehmen, wobei die Veränderungen in der Leistung gemessen werden, um zu beurteilen, ob zusätzliche Komplexität hinzugefügt werden muss.

- Seien Sie so spezifisch und direkt wie möglich: Bemühen Sie sich, Mehrdeutigkeiten in den Aufforderungen zu vermeiden und beschreiben Sie die erwarteten Ergebnisse so knapp, direkt und spezifisch wie möglich.

- Beispiele einbeziehen: Wenn die Beschreibung des erwarteten Outputs schwierig ist, versuchen Sie, Beispiele in die Aufforderung aufzunehmen. Beispiele liefern konkrete Beispiele für erwartete Ergebnisse und können Mehrdeutigkeiten beseitigen.

- Vermeiden Sie Komplexität, wo immer es möglich ist: Komplexe Prompting-Strategien sind manchmal notwendig (z. B. zur Lösung von mehrstufigen Argumentationsproblemen), aber wir müssen zweimal nachdenken, bevor wir diesen Ansatz wählen. Nehmen Sie eine empirische Sichtweise ein und verwenden Sie etablierte Bewertungsstrategien, um wirklich zu beurteilen, ob es notwendig ist, eine solche Komplexität einzubeziehen.

Zusammenfassend lässt sich sagen, dass meine persönliche Cue-Engineering-Strategie darin besteht, i) einen guten Bewertungsrahmen festzulegen, ii) mit einem einfachen Cue zu beginnen und iii) die Komplexität langsam zu erhöhen, um das gewünschte Leistungsniveau zu erreichen.

Anmerkung:

[1] https://promptingguide.ai[2] https://arxiv.org/abs/2401.01325

[3] https://arxiv.org/abs/2306.15595

[4] https://github.com/gkamradt/LLMTest_NeedleInAHaystack

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Verwandte Beiträge

Keine Kommentare...