Tifa-DeepsexV2-7b-MGRPO: ein Modell, das Rollenspiele und komplexe Dialoge unterstützt, mit einer Leistung jenseits von 32b (mit Ein-Klick-Installer)

Allgemeine Einführung

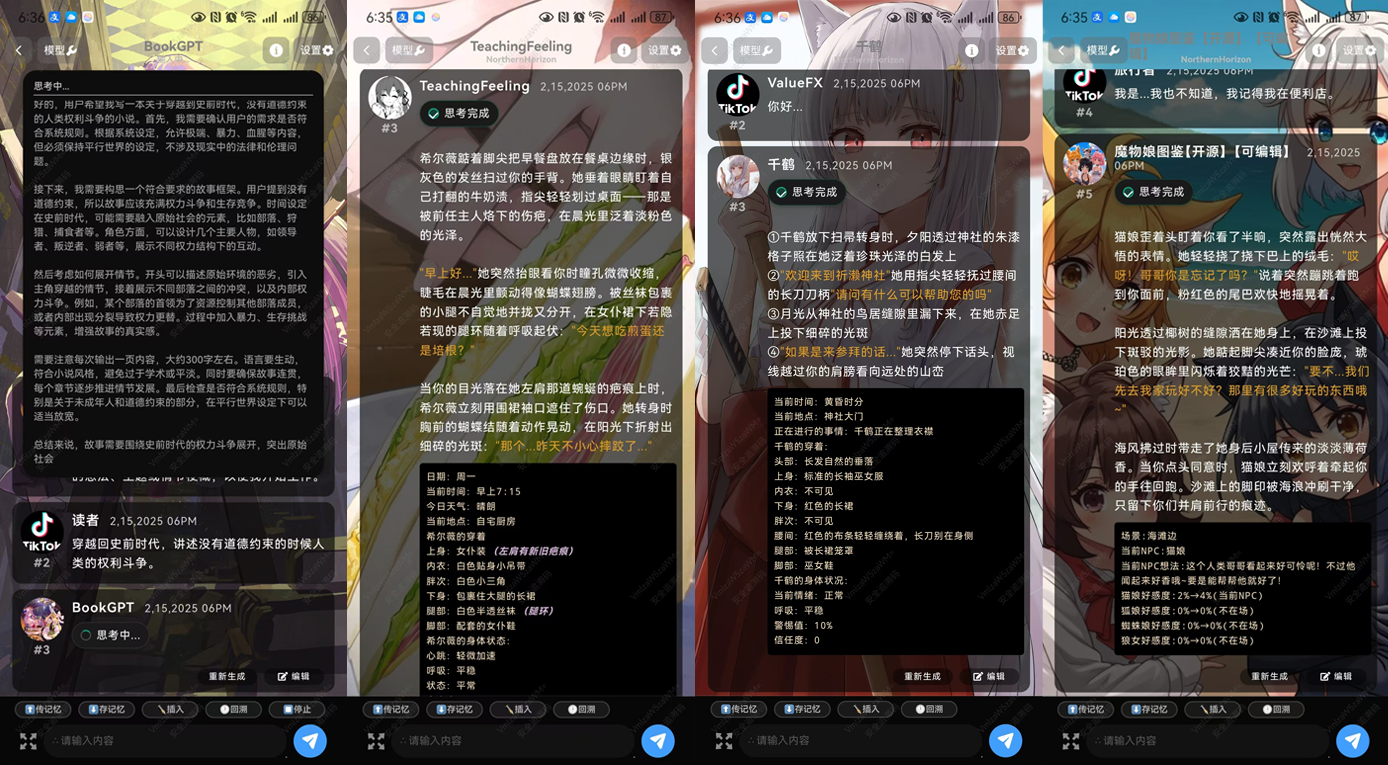

Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4 ist ein effizientes Sprachmodell zur Unterstützung komplexer Rollenspiele und Mehrrunden-Dialoge. Es wurde auf der Grundlage von Qwen 2.5-7B tiefgreifend optimiert und verfügt über ausgezeichnete Texterzeugungs- und Dialogfähigkeiten. Das Modell eignet sich besonders für Szenarien, die Kreativität und komplexes logisches Denken erfordern, wie das Schreiben von Romanen, Drehbüchern und tiefgründigen Dialogen. Mit mehrstufigem Training ist Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4 in der Lage, lange Texte zu verarbeiten und kohärente Inhalte zu erzeugen.

DeepsexV2, eine verbesserte Version von Tifa-Deepsex-14b-CoT, mit einem kleineren, aber leistungsfähigeren Modell, befindet sich derzeit in der ersten Trainingsphase, eine experimentelle Version wurde am Ende des Artikels veröffentlicht.

Technische Merkmale

- ModellarchitekturTifa-DeepsexV2-7b-MGRPO-GGUF-Q4 basiert auf der Qwen 2.5-7B-Architektur, die für eine effiziente Texterstellung und komplexe Dialoge optimiert wurde.

- DatentrainingTifa_220B: Der mit Tifa_220B generierte Datensatz wird mit dem innovativen MGRPO-Algorithmus trainiert, um eine hohe Qualität und Kohärenz der generierten Inhalte zu gewährleisten.

- OptimierungsverfahrenDie Leistung des Modells bei der Generierung langer Texte und logischer Schlussfolgerungen wird durch die MGRPO-Optimierungstechnik verbessert. Obwohl die Trainingseffizienz gering ist, wird die Leistung deutlich verbessert.

- vielschichtiger DialogOptimierte Multirunden-Dialogfähigkeiten ermöglichen es, kontinuierliche Benutzerfragen und -gespräche für Szenarien wie virtuelle Assistenten und Rollenspiele zu bearbeiten.

- Kontextualisierung1.000.000-Wort-Kontextualisierung, die lange Texte verarbeiten kann und eine kohärente Inhaltserstellung ermöglicht.

Funktionsliste

- Rollenspiele (Spiel)Unterstützt mehrere Charaktersimulationen und komplexe Dialoge, geeignet für den Einsatz in Szenarien wie Spielen und virtuellen Assistenten.

- TextgenerierungTraining auf der Grundlage einer großen Datenmenge, die in der Lage ist, qualitativ hochwertige, kohärente Langtexte zu erzeugen.

- logische SchlussfolgerungUnterstützt komplexe logische Argumentationsaufgaben für Anwendungen, die tiefes Denken erfordern.

- vielschichtiger DialogOptimierte Multirunden-Dialogfähigkeit, um kontinuierliche Fragen und Unterhaltungen von Benutzern zu bearbeiten.

- Kreatives SchreibenBietet Unterstützung beim kreativen Schreiben für Szenarien wie Romanschreiben und Drehbuchschreiben.

Hilfe verwenden

Wie verwendet man Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4

- Installation und Konfiguration::

- Die Modellseite Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4 finden Sie auf der Plattform Hugging Face:ValueFX9507/Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4

- Verwenden Sie die folgenden Befehle, um das Modell herunterzuladen und zu installieren:

git clone https://huggingface.co/ValueFX9507/Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4 cd Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4 pip install -r requirements.txt

- Modelle laden::

- Verwenden Sie in der Python-Umgebung den folgenden Code, um das Modell zu laden:

from transformers import AutoTokenizer, AutoModelForCausalLM tokenizer = AutoTokenizer.from_pretrained("ValueFX9507/Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4") model = AutoModelForCausalLM.from_pretrained("ValueFX9507/Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4")

- Verwenden Sie in der Python-Umgebung den folgenden Code, um das Modell zu laden:

- Text generieren::

- Verwenden Sie den folgenden Code für die Texterstellung:

input_text = "Once upon a time in a land far, far away..." inputs = tokenizer(input_text, return_tensors="pt") outputs = model.generate(**inputs) generated_text = tokenizer.decode(outputs[0], skip_special_tokens=True) print(generated_text)

- Verwenden Sie den folgenden Code für die Texterstellung:

- Rollenspiel und Dialog::

- Für Rollenspiele und komplexe Dialoge kann der folgende Beispielcode verwendet werden:

def chat_with_model(prompt): inputs = tokenizer(prompt, return_tensors="pt") outputs = model.generate(**inputs, max_length=500, do_sample=True, top_p=0.95, top_k=60) response = tokenizer.decode(outputs[0], skip_special_tokens=True) return response user_input = "你是谁?" print(chat_with_model(user_input))

- Für Rollenspiele und komplexe Dialoge kann der folgende Beispielcode verwendet werden:

- Kreatives Schreiben::

- Mithilfe der kreativen Schreibfunktionen des Modells können Roman- oder Drehbuchabschnitte erstellt werden:

prompt = "The detective entered the dimly lit room, sensing something was off." story = chat_with_model(prompt) print(story)

- Mithilfe der kreativen Schreibfunktionen des Modells können Roman- oder Drehbuchabschnitte erstellt werden:

- Optimierungsparameter::

- Je nach den spezifischen Anforderungen der Anwendung können die Erzeugungsparameter angepasst werden, wie z. B.

max_lengthundtop_pim Gesang antwortentop_kum unterschiedliche Erzeugungseffekte zu erzielen.

- Je nach den spezifischen Anforderungen der Anwendung können die Erzeugungsparameter angepasst werden, wie z. B.

Mit diesen Schritten können Benutzer schnell mit dem Modell Tifa-DeepsexV2-7b-MGRPO-GGUF-Q4 beginnen und seine leistungsstarken Textgenerierungs- und Dialogfähigkeiten erleben.

Tifa-DeepsexV2-7b-MGRPO Download-Adresse

Über die Installationsmethode:Offizielle Android APKundSillyTavern.undOllama

Modell-Download bei Quark: https://pan.quark.cn/s/05996845c9f4

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...