Text2Edit: Ein natives multimodales Modell für die textgesteuerte Erstellung von Videoanzeigen (unveröffentlicht)

Allgemeine Einführung

Text2Edit ist ein Open-Source-Projekt, das auf GitHub gehostet wird und darauf abzielt, effiziente Funktionen zur Textbearbeitung und Werbeerstellung bereitzustellen. Das Hauptziel des Projekts ist es, Nutzern zu helfen, Textinhalte schnell zu bearbeiten und hochwertiges Werbematerial durch eine einfach zu bedienende Schnittstelle und leistungsstarke Funktionen zu generieren.Text2Edit Projekt wird von einer Gruppe von Entwicklern gepflegt, die Code-Basis ist offen, Benutzer können frei zugreifen und beitragen. Zu den wichtigsten Programmiersprachen des Projekts gehören JavaScript, HTML und CSS, was eine plattformübergreifende Kompatibilität und eine großartige Benutzererfahrung gewährleistet.

Technische Merkmale

1. multimodale große Sprachmodelle (MLLMs)

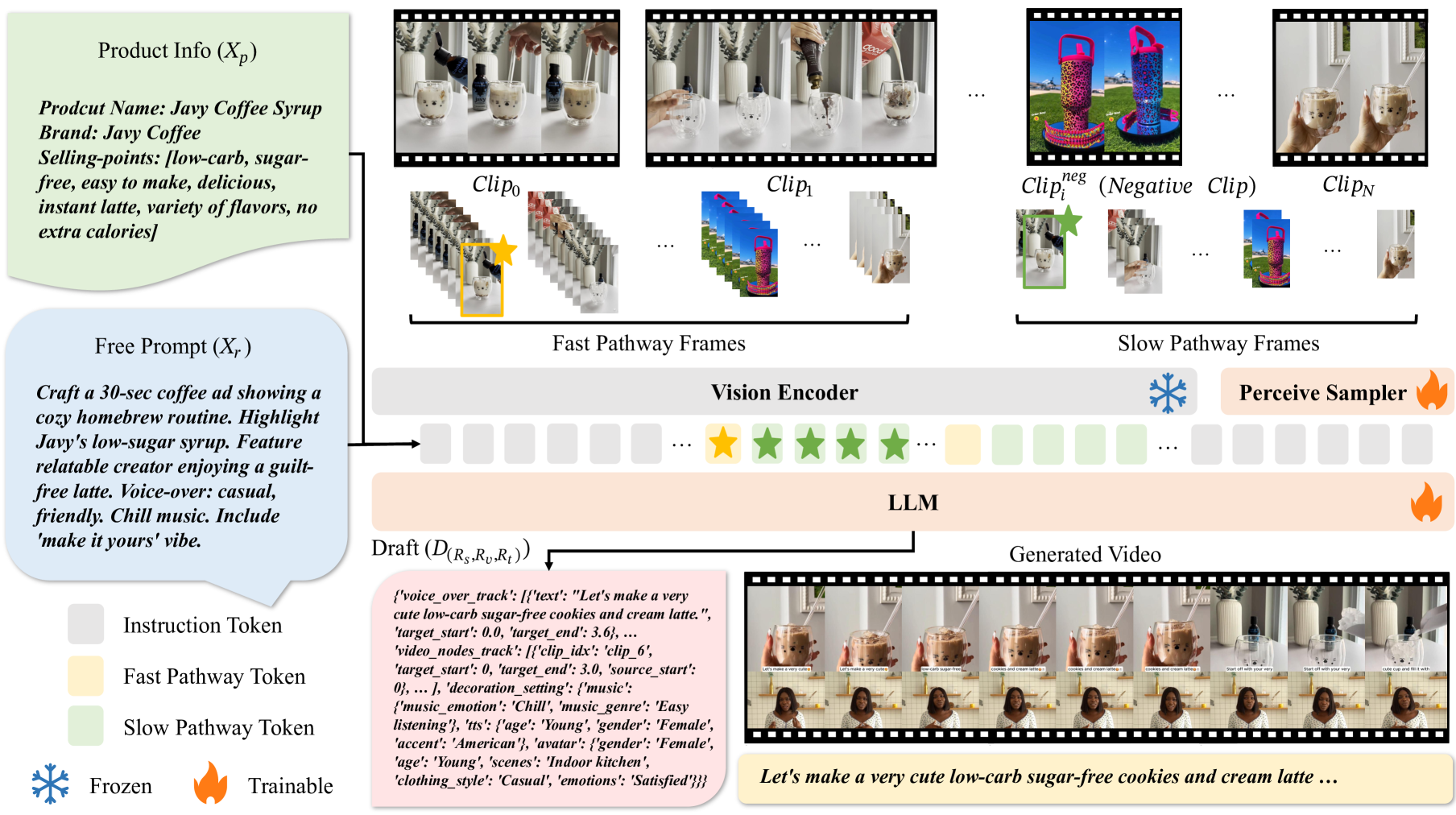

Das Multimodal Big Language Model ist die Grundlage des Projekts, das in der Lage ist, Informationen in mehreren Modalitäten wie Text, Bild und Video gleichzeitig zu verarbeiten.

2) Abtastung mit hoher Bildfrequenz und langsam-schnelle Verarbeitungstechniken

Um die räumlich-zeitlichen Informationen im Video besser zu verstehen, werden im Rahmen des Projekts Abtastungen mit hoher Bildfrequenz und langsam-schnelle Verarbeitungstechniken eingesetzt:

- Abtastung mit hoher Bildfrequenz: Durch die Abtastung von Videobildern mit einer Frequenz von 2 Bildern pro Sekunde (fps) ist das Modell in der Lage, zeitliche Veränderungen im Video empfindlicher zu erfassen. Dieser Ansatz verbessert die Fähigkeit des Modells, Veränderungen in der Videodynamik zu verstehen, erheblich.

- Langsam-schnelle Verarbeitungstechnik: Das Modell verarbeitet Videobilder auf zwei Wegen gleichzeitig.

- Langsamer Pfad: Die Bilder werden mit einer niedrigeren Bildrate (z. B. 0,5 Bilder/s) verarbeitet, aber es werden mehr Token pro Bild zugewiesen, um detaillierte räumliche und zeitliche Informationen zu erfassen.

- Schneller Pfad: Verarbeitung von Frames mit hoher Bildrate (z. B. 2fps), aber Zuweisung von weniger Token pro Frame, wobei der Schwerpunkt auf der Erfassung sich schnell verändernder Szenen liegt. Diese Zwei-Wege-Strategie gleicht die räumlich-zeitlichen und semantischen Informationen des Videos aus und verbessert das Verständnis des Modells für den Videoinhalt erheblich.

3. textgesteuerte Bearbeitung

Der textgesteuerte Bearbeitungsmechanismus ermöglicht es den Benutzern, das Ergebnis der Videobearbeitung durch Texteingabe genau zu steuern. Die Benutzer können die Länge des Videos, die Handlung, die Zielgruppe, den Stil des Drehbuchs, die hervorzuhebenden Produktverkaufsargumente und andere Informationen angeben. Das Modell generiert auf der Grundlage dieser Texteingaben einen Videoschnittentwurf, der den Anforderungen des Benutzers entspricht und ein hohes Maß an Kontrolle und Vielfalt in der Ausgabe gewährleistet.

4. spezifische Umsetzung der Videobearbeitung

- Einbettung und Verarbeitung von Videobildern: Videobilder werden zunächst von einem visuellen Codierer wie CLIP oder OpenCLIP in Einbettungsvektoren umgewandelt. Diese Vektoren werden zusammen mit Texteinbettungsvektoren in das LLM eingegeben, und das Modell verarbeitet diese Einbettungsvektoren durch einen selbstaufmerksamen Mechanismus, um Entwürfe für die Videobearbeitung zu erstellen.

- Entwurfserstellung und Nachbearbeitung: Der Entwurf des Modells umfasst die Anordnung von Videoclips, Voice-over-Skripten und dekorativen Elementen (z. B. Soundtracks, digitale menschliche Bilder usw.). Diese Entwürfe werden durch Nachbearbeitung (z. B. Sprachsynthese, Musikwiedergabe usw.) verarbeitet, um das endgültige renderbare Video zu erstellen.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...