TANGO: ein Werkzeug für sprachgenerierte koordinierte Gestenportraits eines digitalen Ganzkörpermenschen

Allgemeine Einführung

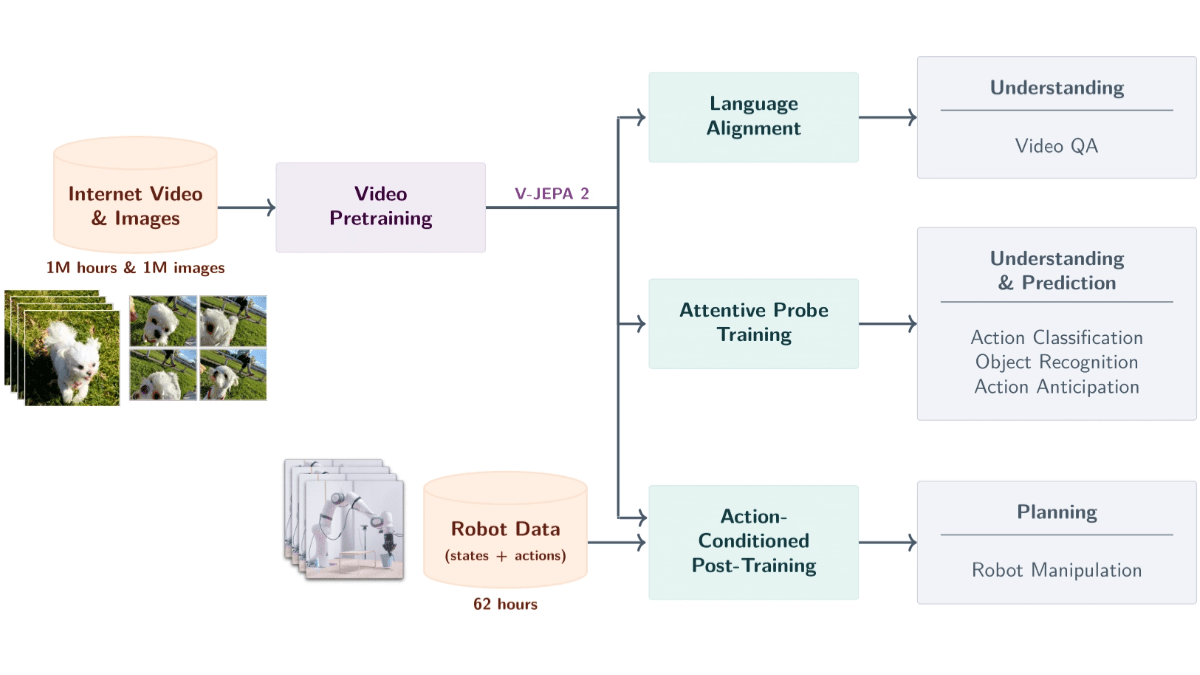

TANGO (Co-Speech Gesture Video Reenactment with Hierarchical Audio-Motion Embedding and Diffusion Interpolation) ist ein von der Universität Tokio und CyberAgent AI Labs gemeinsam entwickeltes Open-Source entwickeltes Open-Source-Framework für die kollaborative Erzeugung von Sprach-Gesten-Videos. Das Projekt verwendet hierarchische Audio-Motion-Embedding-Räume und Diffusionsinterpolation, um automatisch natürliche, glatte und synchronisierte Gestenvideos zu generieren, die auf der eingegebenen Sprache basieren. TANGO erreicht eine qualitativ hochwertige Gesten-Aktions-Generierung durch eine innovative Action-Graph-Retrieval-Methode, die zunächst den Referenzvideoclip findet, der der Zielsprache in einem implizit hierarchischen Audio-Motion-Embedding-Raum am nächsten kommt, und dann ein Diffusionsmodell für die Aktionsinterpolation verwendet. Handlungsgenerierung. Dieses Projekt bringt nicht nur die Forschung im Bereich der KI-gesteuerten Mensch-Computer-Interaktion voran, sondern bietet auch wichtige technische Unterstützung für Anwendungen wie virtuelle Anker und digitale Menschen.

Das aktuelle Open Source TANGO unterstützt nur bis zu 8s Audio, vor der Verwendung müssen Sie eine Segmentierung der Audiodatei vornehmen!

Arbeiten Sie mit dem Tool Voice Lip Sync für ein komplettes digitales Personenprojekt: Sync ,Wav2Lip Ultralight Digital Human. Der komplette Arbeitsablauf lautet: Ultralight Digital Human als Kontrapunkt, TANGO zur Erzeugung von Körperbewegungen, FaceFusion zum Ändern der Gesichter - perfekt!

Online-Erfahrung: https://huggingface.co/spaces/H-Liu1997/TANGO

Funktionsliste

- Hochpräzise Gesten-Synchronisation: Synchronisieren Sie jedes Audio genau mit den Gesten im Video.

- Mehrsprachige Unterstützung: Funktioniert mit einer Vielzahl von Sprachen und Klängen, einschließlich CGI-Gesichtern und synthetischen Klängen.

- Open Source und kostenlos: Der Code ist vollständig öffentlich und kann von den Benutzern frei verwendet und verändert werden.

- Interaktive Demo: Bietet eine Online-Demo, in die Benutzer Video- und Audiodateien hochladen können, um sie zu erleben.

- Pre-Training-Modelle: Bieten eine Vielzahl von Pre-Training-Modelle, Benutzer können direkt verwenden oder sekundäre Ausbildung.

- Vollständiger Trainingscode: Enthält Trainingscode für den Gesten-Synchronisations-Diskriminator und das TANGO-Modell.

Hilfe verwenden

1. ökologische Konfiguration

1.1 Grundlegende Anforderungen:

- Python-Version: 3.9.20

- CUDA Version: 11.8

- Festplattenspeicher: mindestens 35 GB (zum Speichern von Modellen und vorberechneten Diagrammen)

1.2 Installationsschritte:

# 克隆项目仓库

git clone https://github.com/CyberAgentAILab/TANGO.git

cd TANGO

git clone https://github.com/justinjohn0306/Wav2Lip.git

git clone https://github.com/dajes/frame-interpolation-pytorch.git

# 创建虚拟环境(可选)

conda create -n tango python==3.9.20

conda activate tango

# 安装依赖

pip install -r ./pre-requirements.txt

pip install -r ./requirements.txt

2. der Nutzungsablauf

2.1 Schnellstart:

- Führen Sie das Argumentationsskript aus:

python app.py

Beim ersten Durchlauf lädt das System automatisch die erforderlichen Kontrollpunktdateien und vorberechneten Diagramme herunter. Für die Erstellung von etwa 8 Sekunden Video werden etwa 3 Minuten Bearbeitungszeit benötigt.

2.2 Erstellung benutzerdefinierter Rollen:

- Wenn Sie eine Actionfigur für eine neue Figur erstellen müssen:

python create_graph.py

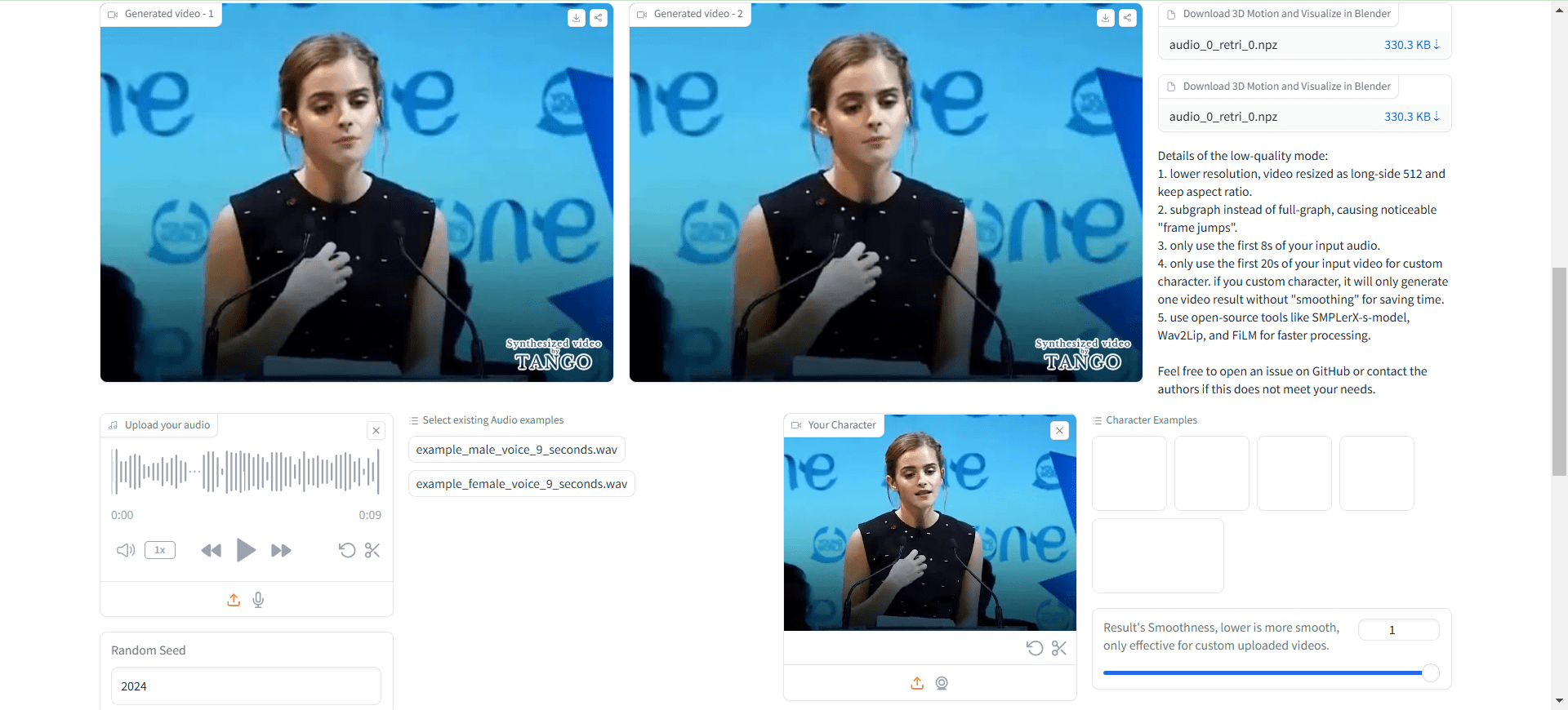

Unter anderem erzeugt das Projekt standardmäßig Videos mit TANGO-Wasserzeichen, ähnlich dem unten abgebildeten:

Im Wesentlichen handelt es sich um einen Aufruf an ein lokales ffmpeg, das das Originalvideo und das Bild mit dem Wasserzeichen zu einem neuen Video zusammensetzt.

Wenn Sie kein Wasserzeichen wünschen, können Sie dieapp.pyMitte:

gr.Video(value="./datasets/cached_audio/demo1.mp4", label="Demo 0", , watermark="./datasets/watermark.png") # 修改为 gr.Video(value="./datasets/cached_audio/demo1.mp4", label="Demo 0")

Nicht-Localhost-Zugang, Änderungen erforderlich:

demo.launch(server_name="0.0.0.0", server_port=7860)

Öffnen Sie es erneut, um zu sehen, dass das geladene Video kein Wasserzeichen enthält.

Das resultierende Video hat keinen Ton, so dass Sie den Ton manuell synthetisieren müssen.

/usr/bin/ffmpeg -i outputs/gradio/test_0/xxx.mp4 -i gen_audio.wav -c:v libx264 -c:a aac result_wav.mp4

Man merkt es: Mit den Körperbewegungen ist alles in Ordnung, die Mundform ist völlig falsch.

Das ist nicht der Fall. Ultraleicht Digital Human Und es hat sich als nützlich erwiesen?

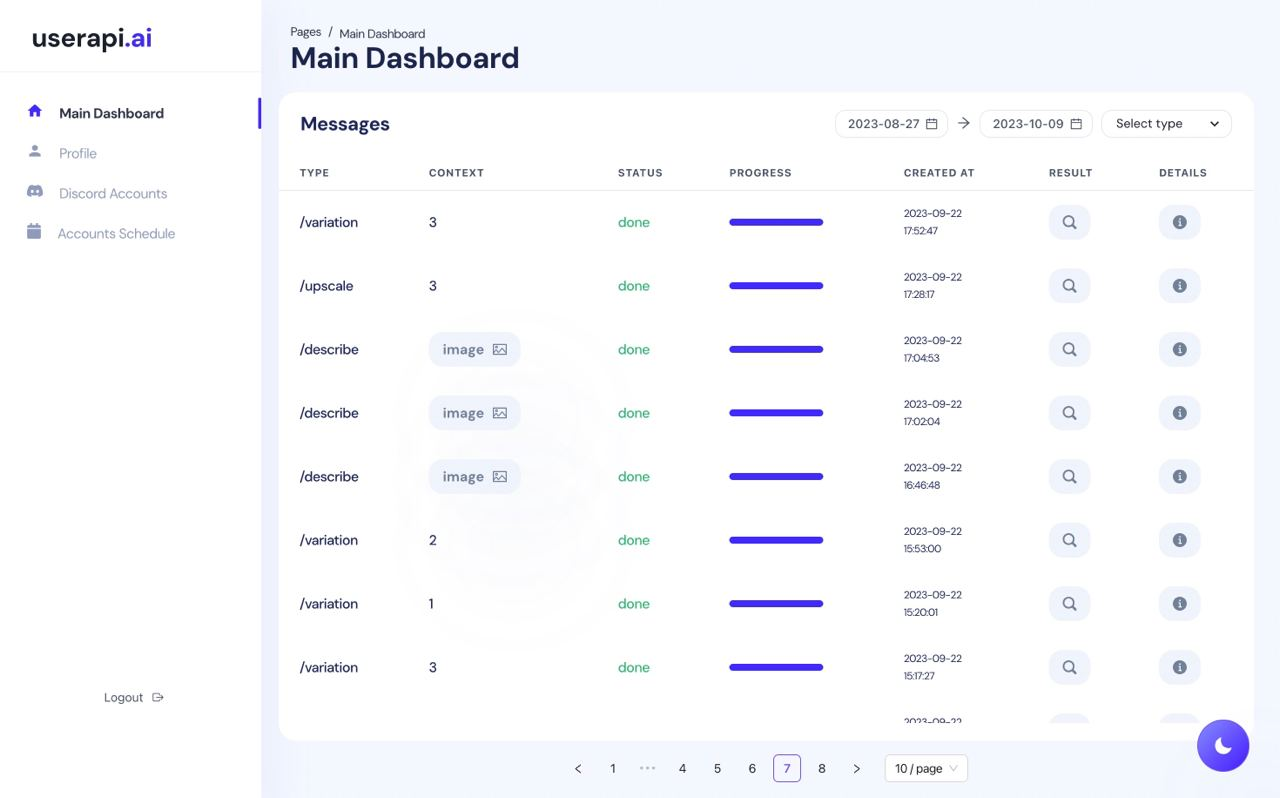

Verwendungsprozess

- Zugriff auf den lokalen Server: Öffnen im Browser

http://localhost:3000. - Video und Audio hochladen: Laden Sie die Audio- und Videodateien, die Sie synchronisieren möchten, in das Eingabefeld hoch.

- Gesten-Synchronisation durchführen: Tippen Sie auf die Schaltfläche "Synchronisieren", das System führt automatisch eine Gesten-Synchronisation durch.

- Anzeigen und Herunterladen von Ergebnissen: Nach Abschluss der Synchronisierung können Sie eine Vorschau der Ergebnisse anzeigen und die synchronisierten Videodateien herunterladen.

- Interaktive Demo verwenden: Laden Sie Video- und Audiodateien auf der Demo-Seite hoch, um den Effekt der Gestensynchronisation in Echtzeit zu erleben.

- Projekte verwalten: Auf der Seite Meine Projekte können Sie alle hochgeladenen Projekte anzeigen und verwalten, mit Unterstützung für Versionskontrolle und Zusammenarbeit.

Erweiterte Funktionen

- Intelligente Gesten-Synchronisation: Verbessern Sie die Darstellung Ihrer Videoinhalte mit intelligenter Gesten-Synchronisation durch KI.

- Mehrsprachige Unterstützung: Wählen Sie verschiedene Sprachen und Stimmen entsprechend den Anforderungen Ihres Projekts.

- Kundenspezifische Entwicklung: Da TANGO quelloffen ist, können Benutzer es nach ihren Bedürfnissen entwickeln.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...