Story-Flicks: Eingabe von Themen zur automatischen Generierung von Kurzgeschichten-Videos für Kinder

Allgemeine Einführung

Story-Flicks ist ein Open-Source-KI-Tool, das Nutzern hilft, schnell HD-Geschichtenvideos zu erstellen. Benutzer müssen nur ein Story-Thema eingeben, das System generiert Story-Inhalte durch ein großes Sprachmodell, und kombiniert mit KI-generierten Bildern, Audio und Untertiteln, die Ausgabe des kompletten Videos zu arbeiten. Das Backend des Projekts basiert auf Python und dem FastAPI-Framework, während das Frontend mit React, Ant Design und Vite aufgebaut ist. Es unterstützt OpenAI, AliCloud, DeepSeek und andere Modelldienstleister, und die Benutzer können flexibel Text- und Bilderzeugungsmodelle wählen. Ob es um die Erstellung von Kindergeschichten, kurzen Animationen oder Lehrvideos geht, Story-Flicks kann die Anforderungen von Entwicklern, Kreativen und Pädagogen problemlos erfüllen.

Funktionsliste

- Erzeugen Sie Videos mit einem KlickEingabe eines Themas und automatische Erstellung eines Videos mit Bildern, Text, Audio und Untertiteln.

- Unterstützung mehrerer ModelleKompatibel mit OpenAI, Aliyun, DeepSeek, Ollama und SiliconFlow von Text- und Bildmodellen.

- Segment-AnpassungDer Benutzer kann die Anzahl der Absätze der Geschichte angeben, und jeder Absatz erzeugt ein entsprechendes Bild.

- mehrsprachige AusgabeUnterstützung für Text- und Audiogenerierung in mehreren Sprachen, angepasst an globale Benutzer.

- Open-Source-BereitstellungBietet sowohl eine manuelle Installation als auch eine Docker-Bereitstellung für einen einfachen lokalen Betrieb.

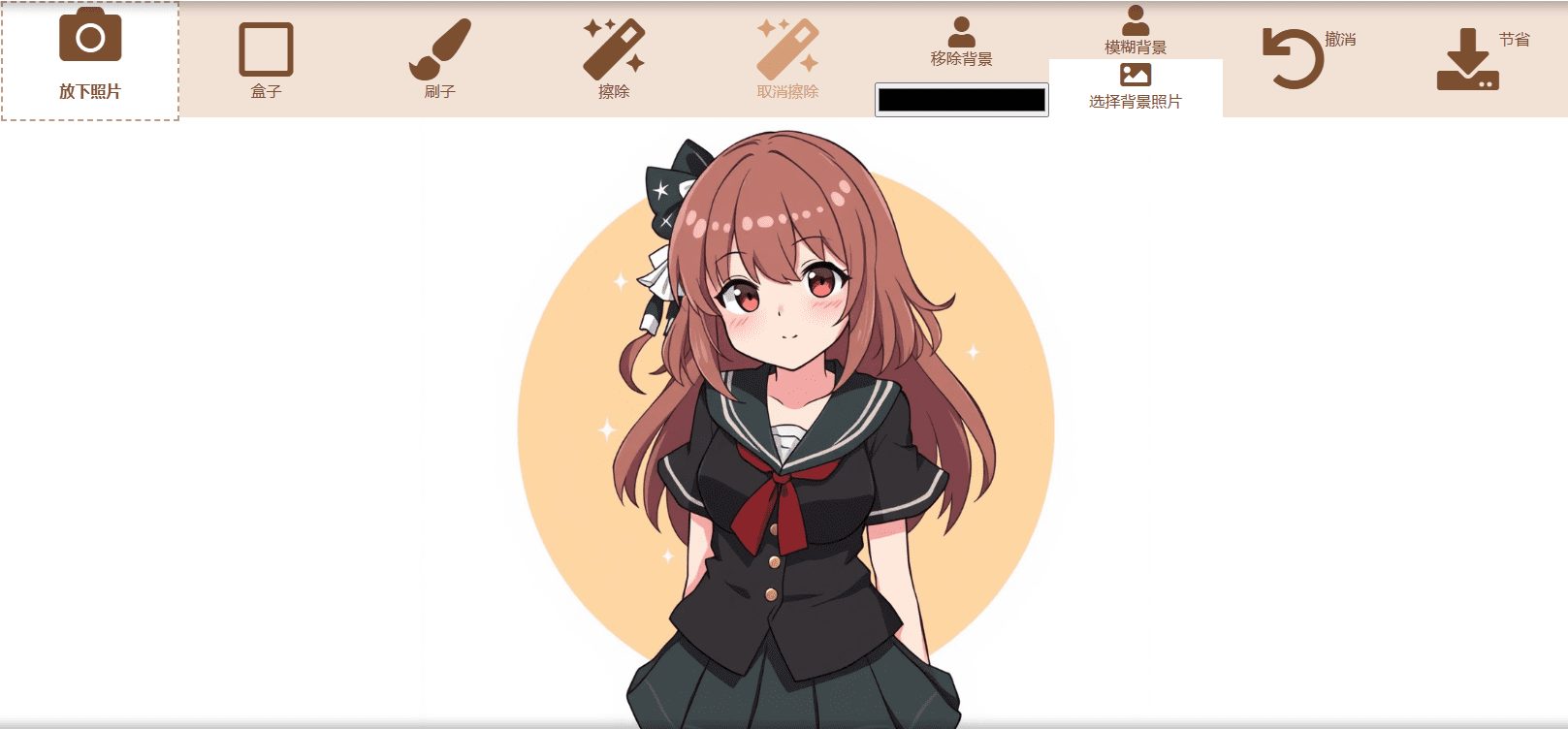

- intuitive SchnittstelleDie Front-End-Seite ist einfach zu bedienen und unterstützt die Parameterauswahl und die Videovorschau.

Hilfe verwenden

Einbauverfahren

Story-Flicks bietet zwei Installationsmethoden: manuelle Installation und Docker-Deployment. Im Folgenden finden Sie die detaillierten Schritte, um sicherzustellen, dass Benutzer die Umgebung reibungslos aufbauen können.

1. manuelle Installation

Schritt 1: Laden Sie das Projekt herunter

Klonen Sie das Projekt lokal, indem Sie den folgenden Befehl in das Terminal eingeben:

git clone https://github.com/alecm20/story-flicks.git

Schritt 2: Konfigurieren der Modellinformationen

Wechseln Sie in das Backend-Verzeichnis und kopieren Sie die Umgebungskonfigurationsdatei:

cd backend

cp .env.example .env

zeigen (eine Eintrittskarte) .env Datei, um das Text- und Bilderzeugungsmodell zu konfigurieren. Beispiel:

text_provider="openai" # 文本生成服务商,可选 openai、aliyun、deepseek 等

image_provider="aliyun" # 图像生成服务商,可选 openai、aliyun 等

openai_api_key="你的OpenAI密钥" # OpenAI 的 API 密钥

aliyun_api_key="你的阿里云密钥" # 阿里云的 API 密钥

text_llm_model="gpt-4o" # 文本模型,如 gpt-4o

image_llm_model="flux-dev" # 图像模型,如 flux-dev

- Wenn Sie sich für OpenAI entscheiden, wird empfohlen, dass Sie

gpt-4oals textliches Modell.dall-e-3als ein Bildmodell. - Wenn Sie sich für AliCloud entscheiden, empfiehlt sich die Verwendung von

qwen-plusvielleichtqwen-max(textuelle Modellierung) undflux-dev(Bildmodell, derzeit zum kostenlosen Test verfügbar, siehe Details unterAliCloud-Dokumentation). - Speichern Sie die Datei, wenn die Konfiguration abgeschlossen ist.

Schritt 3: Starten Sie das Backend

Wechseln Sie im Terminal zum Backend-Verzeichnis, erstellen Sie die virtuelle Umgebung und installieren Sie die Abhängigkeiten:

cd backend

conda create -n story-flicks python=3.10 # 创建 Python 3.10 环境

conda activate story-flicks # 激活环境

pip install -r requirements.txt # 安装依赖

uvicorn main:app --reload # 启动后端服务

Nach erfolgreichem Start wird das Terminal angezeigt:

INFO: Uvicorn running on http://127.0.0.1:8000 (Press CTRL+C to quit)

INFO: Application startup complete.

Dies zeigt an, dass der Back-End-Dienst ausgeführt wurde http://127.0.0.1:8000.

Schritt 4: Starten Sie das Frontend

Wechseln Sie in einem neuen Terminal in das Front-End-Verzeichnis, installieren Sie die Abhängigkeiten und führen Sie es aus:

cd frontend

npm install # 安装前端依赖

npm run dev # 启动前端服务

Nach erfolgreichem Start zeigt das Terminal an:

VITE v6.0.7 ready in 199 ms

➜ Local: http://localhost:5173/

Zugriff über einen Browser http://localhost:5173/Sie können die Front-End-Schnittstelle sehen.

2. die Docker-Bereitstellung

Schritt 1: Bereiten Sie die Umgebung vor

Vergewissern Sie sich, dass Docker und Docker Compose lokal installiert sind; falls nicht, laden Sie sie von der offiziellen Website herunter.

Schritt 2: Start des Projekts

Führen Sie es im Stammverzeichnis des Projekts aus:

docker-compose up --build

Docker erstellt und startet automatisch die Front- und Back-End-Dienste. Wenn das erledigt ist, besuchen Sie die http://localhost:5173/ Zeigen Sie die Frontend-Seite an.

Verwendung

Nach der Installation können die Benutzer über die Front-End-Schnittstelle Story-Videos erstellen. Im Folgenden wird der spezifische Arbeitsablauf beschrieben:

1. der Zugang zur Front-End-Schnittstelle

Geben Sie in Ihrem Browser ein http://localhost:5173/Die Hauptseite von Story-Flicks wird geöffnet.

2. die Einstellung der Erzeugungsparameter

Die Schnittstelle bietet die folgenden Optionen:

- Anbieter von Textgenerierungsmodellen: Auswahl

openaiundaliyunusw. - Bilderzeugung Modellanbieter: Auswahl

openaiundaliyunusw. - Textmodell: Geben Sie den Modellnamen ein, z. B.

gpt-4ovielleichtqwen-plus. - Bildliche Modellierung: Geben Sie den Modellnamen ein, z. B.

flux-devvielleichtdall-e-3. - Video SpracheWählen Sie eine Sprache, z. B. Chinesisch oder Englisch.

- Art der StimmeWählen Sie einen Audiostil, z. B. männlich oder weiblich.

- Themen der Geschichte: Geben Sie ein Thema ein, z. B. "Die Abenteuer von Hase und Fuchs".

- Anzahl der Absätze der GeschichteGeben Sie eine Zahl ein (z.B. 3), wobei jedes Segment einem Bild entspricht.

3. die Videoerstellung

Nachdem Sie die Parameter eingegeben haben, klicken Sie auf die Schaltfläche "Erzeugen". Das System wird das Video entsprechend den Einstellungen generieren. Die Generierungszeit hängt von der Anzahl der Absätze ab; je mehr Absätze, desto länger dauert es. Nach Abschluss der Erstellung wird das Video auf der Seite angezeigt und kann abgespielt und heruntergeladen werden.

caveat

- Wenn die Generierung fehlschlägt, prüfen Sie die

.envDatei nach dem richtigen API-Schlüssel, oder überprüfen Sie, ob die Netzwerkverbindung funktioniert. - ausnutzen Ollama Bei der Einstellung der

ollama_api_key="ollama"Empfohlenqwen2.5:14boder größere Modelle, kleinere Modelle funktionieren möglicherweise nicht so gut. - Das Bildmodell von SiliconFlow ist bisher nur getestet worden.

black-forest-labs/FLUX.1-devAchten Sie darauf, dass Sie ein kompatibles Modell auswählen.

Featured Function Bedienung

Komplettes Video mit einem Klick generieren

Geben Sie in der Benutzeroberfläche "Die Geschichte vom Wolf und vom Hasen" ein, legen Sie 3 Absätze fest und klicken Sie auf "Generieren". Nach ein paar Minuten erhalten Sie ein Video mit 3 Bildern, Voiceover und Untertiteln. Das offizielle Demo-Video zeigt zum Beispiel die Geschichten "Der Hase und der Fuchs" und "Der Wolf und der Hase".

Unterstützung mehrerer Sprachen

Möchten Sie ein englisches Video erstellen? Stellen Sie die "Videosprache" auf "Englisch", und das System generiert englischen Text, Ton und Untertitel. Die Umstellung auf andere Sprachen ist ebenso einfach.

Benutzerdefinierte Segmentierung

Sie brauchen eine längere Geschichte? Setzen Sie die Anzahl der Absätze auf 5 oder mehr. Jeder Absatz erzeugt ein neues Bild und die Geschichte wird entsprechend erweitert.

Mit diesen Schritten können Benutzer Story-Flicks einfach installieren und verwenden, um schnell HD-Videos mit Geschichten zu erstellen. Ob zur persönlichen Unterhaltung oder für den Unterricht, mit diesem Tool können Sie kreativ werden!

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...