SiliconCloud x FastGPT: Ermöglicht 200.000 Benutzern den Aufbau einer exklusiven KI-Wissensdatenbank

FastGPT ist ein auf dem LLM-Modell basierendes Wissensdatenbank-Q&A-System, das vom Circle Cloud-Team entwickelt wurde und sofort einsatzbereite Datenverarbeitung, Modellaufrufe und andere Funktionen bietet. FastGPT hat 19,4k Sterne auf Github erhalten.

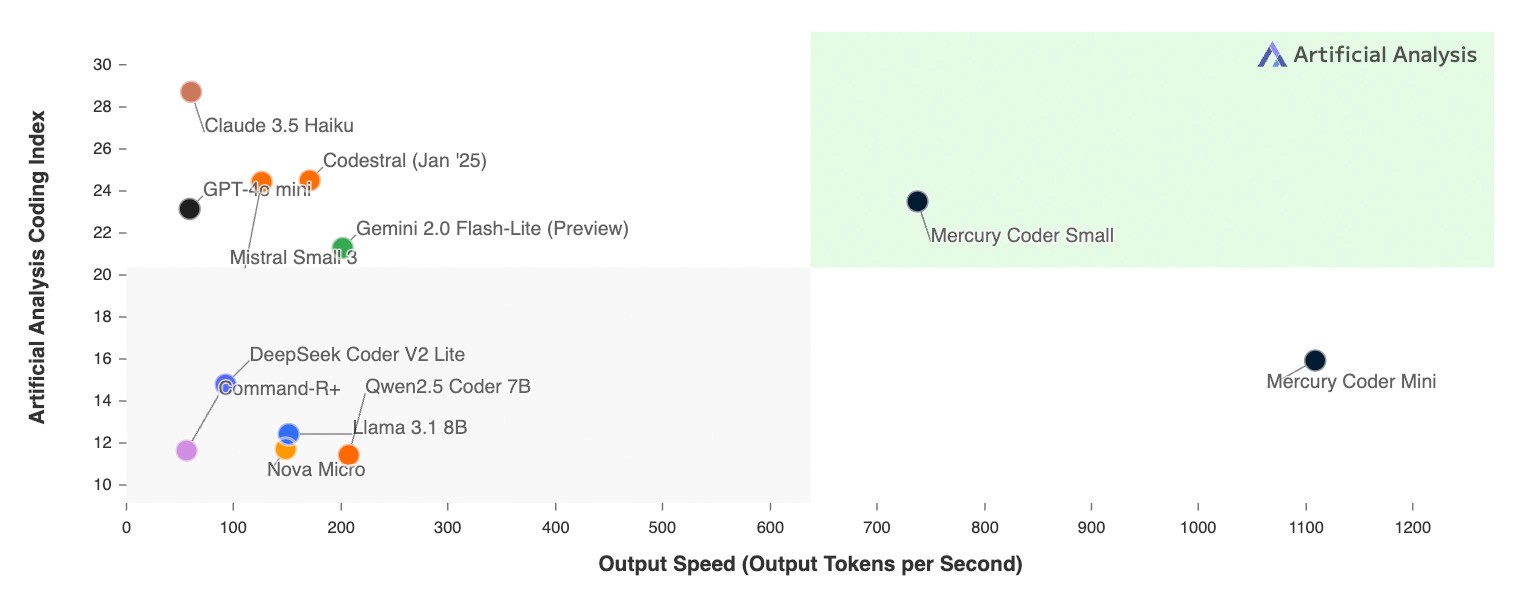

SiliconCloud von Silicon Flow ist eine große Modell-Cloud-Service-Plattform mit einer eigenen Beschleunigungs-Engine. SiliconCloud kann Nutzern helfen, Open-Source-Modelle kostengünstig und schnell zu testen und zu verwenden. Die tatsächliche Erfahrung ist, dass die Geschwindigkeit und Stabilität ihrer Modelle sehr gut sind, und sie sind reich an Vielfalt, die Dutzende von Modellen wie Sprachen, Vektoren, Neuordnung, TTS, STT, Mapping, Video-Generierung, etc. abdecken, die alle Modell Bedürfnisse in FastGPT befriedigen können.

Dieser Artikel ist ein Tutorial, das vom FastGPT-Team geschrieben wurde, um eine Lösung für den Einsatz von FastGPT in der lokalen Entwicklung unter ausschließlicher Verwendung von SiliconCloud-Modellen vorzustellen.

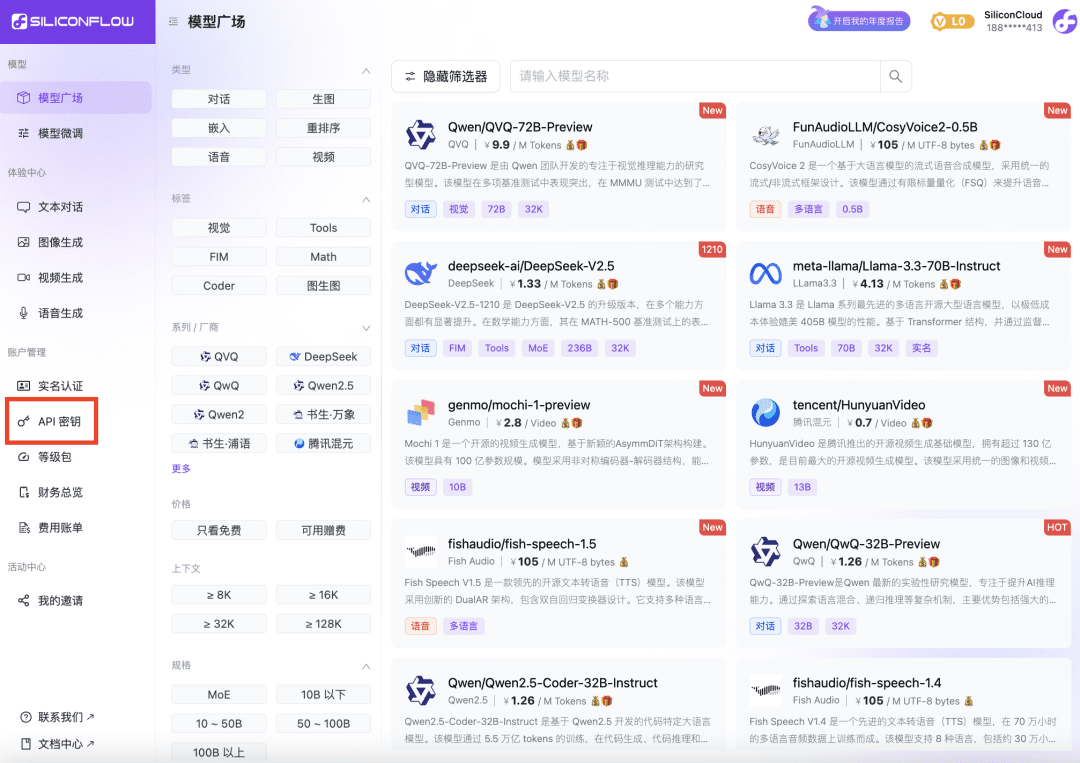

1 Beziehen des SiliconCloud-Plattform-API-Schlüssels

- Öffnen Sie die SiliconCloud-Website und melden Sie sich für ein Konto an.

- Nach Abschluss der Registrierung öffnen Sie den API-Schlüssel, erstellen einen neuen API-Schlüssel und klicken auf den Schlüssel, um ihn für die zukünftige Verwendung zu kopieren.

2 Ändern der FastGPT-Umgebungsvariablen

OPENAI_BASE_URL=https://api.siliconflow.cn/v1 # 填写 SiliconCloud 控制台提供的 Api Key CHAT_API_KEY=sk-xxxxxx

FastGPT Entwicklungs- und Einsatzdokumentation: https://doc.fastgpt.cn

3 Ändern der FastGPT-Konfigurationsdatei

Die Modelle in SiliconCloud wurden als FastGPT-Konfigurationen ausgewählt. Hier wird Qwen2.5 72b mit reinen Sprach- und Sehmodellen konfiguriert; bge-m3 wird als Vektormodell ausgewählt; bge-reranker-v2-m3 wird als Umordnungsmodell ausgewählt. Wählen Sie fish-speech-1.5 als Sprachmodell; wählen Sie SenseVoiceSmall als Spracheingabemodell.

Hinweis: Das ReRank-Modell muss noch einmal mit dem API-Schlüssel konfiguriert werden.

{

"llmModels": [

{

"provider": "Other", // 模型提供商,主要用于分类展示,目前已经内置提供商包括:https://github.com/labring/FastGPT/blob/main/packages/global/core/ai/provider.ts, 可 pr 提供新的提供商,或直接填写 Other

"model": "Qwen/Qwen2.5-72B-Instruct", // 模型名(对应OneAPI中渠道的模型名)

"name": "Qwen2.5-72B-Instruct", // 模型别名

"maxContext": 32000, // 最大上下文

"maxResponse": 4000, // 最大回复

"quoteMaxToken": 30000, // 最大引用内容

"maxTemperature": 1, // 最大温度

"charsPointsPrice": 0, // n积分/1k token(商业版)

"censor": false, // 是否开启敏感校验(商业版)

"vision": false, // 是否支持图片输入

"datasetProcess": true, // 是否设置为文本理解模型(QA),务必保证至少有一个为true,否则知识库会报错

"usedInClassify": true, // 是否用于问题分类(务必保证至少有一个为true)

"usedInExtractFields": true, // 是否用于内容提取(务必保证至少有一个为true)

"usedInToolCall": true, // 是否用于工具调用(务必保证至少有一个为true)

"usedInQueryExtension": true, // 是否用于问题优化(务必保证至少有一个为true)

"toolChoice": true, // 是否支持工具选择(分类,内容提取,工具调用会用到。)

"functionCall": false, // 是否支持函数调用(分类,内容提取,工具调用会用到。会优先使用 toolChoice,如果为false,则使用 functionCall,如果仍为 false,则使用提示词模式)

"customCQPrompt": "", // 自定义文本分类提示词(不支持工具和函数调用的模型

"customExtractPrompt": "", // 自定义内容提取提示词

"defaultSystemChatPrompt": "", // 对话默认携带的系统提示词

"defaultConfig": {}, // 请求API时,挟带一些默认配置(比如 GLM4 的 top_p)

"fieldMap": {} // 字段映射(o1 模型需要把 max_tokens 映射为 max_completion_tokens)

},

{

"provider": "Other",

"model": "Qwen/Qwen2-VL-72B-Instruct",

"name": "Qwen2-VL-72B-Instruct",

"maxContext": 32000,

"maxResponse": 4000,

"quoteMaxToken": 30000,

"maxTemperature": 1,

"charsPointsPrice": 0,

"censor": false,

"vision": true,

"datasetProcess": false,

"usedInClassify": false,

"usedInExtractFields": false,

"usedInToolCall": false,

"usedInQueryExtension": false,

"toolChoice": false,

"functionCall": false,

"customCQPrompt": "",

"customExtractPrompt": "",

"defaultSystemChatPrompt": "",

"defaultConfig": {}

}

],

"vectorModels": [

{

"provider": "Other",

"model": "Pro/BAAI/bge-m3",

"name": "Pro/BAAI/bge-m3",

"charsPointsPrice": 0,

"defaultToken": 512,

"maxToken": 5000,

"weight": 100

}

],

"reRankModels": [

{

"model": "BAAI/bge-reranker-v2-m3", // 这里的model需要对应 siliconflow 的模型名

"name": "BAAI/bge-reranker-v2-m3",

"requestUrl": "https://api.siliconflow.cn/v1/rerank",

"requestAuth": "siliconflow 上申请的 key"

}

],

"audioSpeechModels": [

{

"model": "fishaudio/fish-speech-1.5",

"name": "fish-speech-1.5",

"voices": [

{

"label": "fish-alex",

"value": "fishaudio/fish-speech-1.5:alex",

"bufferId": "fish-alex"

},

{

"label": "fish-anna",

"value": "fishaudio/fish-speech-1.5:anna",

"bufferId": "fish-anna"

},

{

"label": "fish-bella",

"value": "fishaudio/fish-speech-1.5:bella",

"bufferId": "fish-bella"

},

{

"label": "fish-benjamin",

"value": "fishaudio/fish-speech-1.5:benjamin",

"bufferId": "fish-benjamin"

},

{

"label": "fish-charles",

"value": "fishaudio/fish-speech-1.5:charles",

"bufferId": "fish-charles"

},

{

"label": "fish-claire",

"value": "fishaudio/fish-speech-1.5:claire",

"bufferId": "fish-claire"

},

{

"label": "fish-david",

"value": "fishaudio/fish-speech-1.5:david",

"bufferId": "fish-david"

},

{

"label": "fish-diana",

"value": "fishaudio/fish-speech-1.5:diana",

"bufferId": "fish-diana"

}

]

}

],

"whisperModel": {

"model": "FunAudioLLM/SenseVoiceSmall",

"name": "SenseVoiceSmall",

"charsPointsPrice": 0

}

}

4 FastGPT neu starten

5 Erfahrungstest

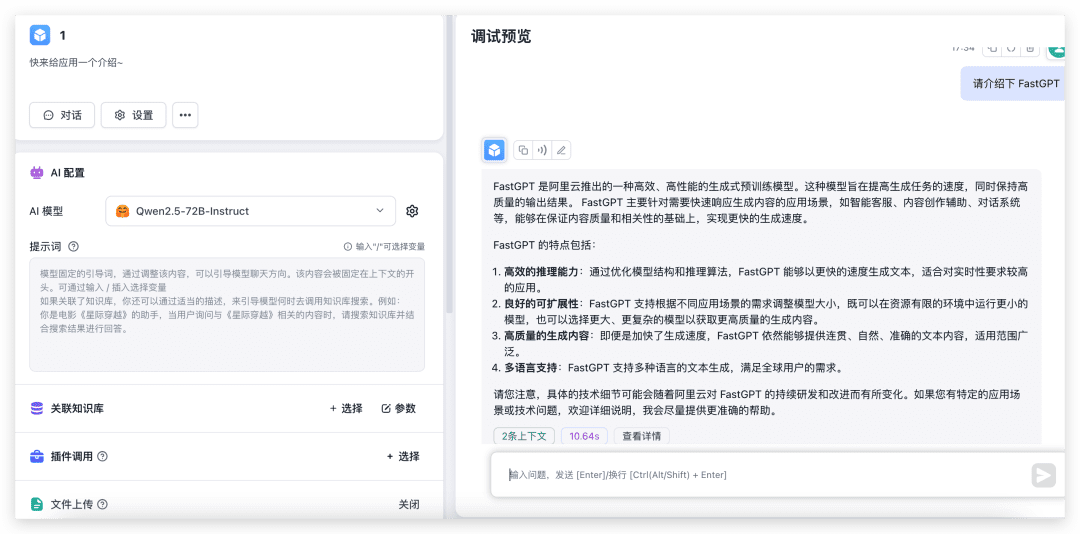

Dialog und Bilderkennung testen

Erstellen Sie eine neue einfache Anwendung, wählen Sie das entsprechende Modell und testen Sie es mit aktiviertem Bild-Upload.

Wie Sie sehen können, das Modell der 72B, ist die Leistung sehr schnell, die, wenn es nicht ein paar lokale 4090, ganz zu schweigen von der Konfiguration der Umwelt, ich habe Angst, dass die Ausgabe wird 30s dauern.

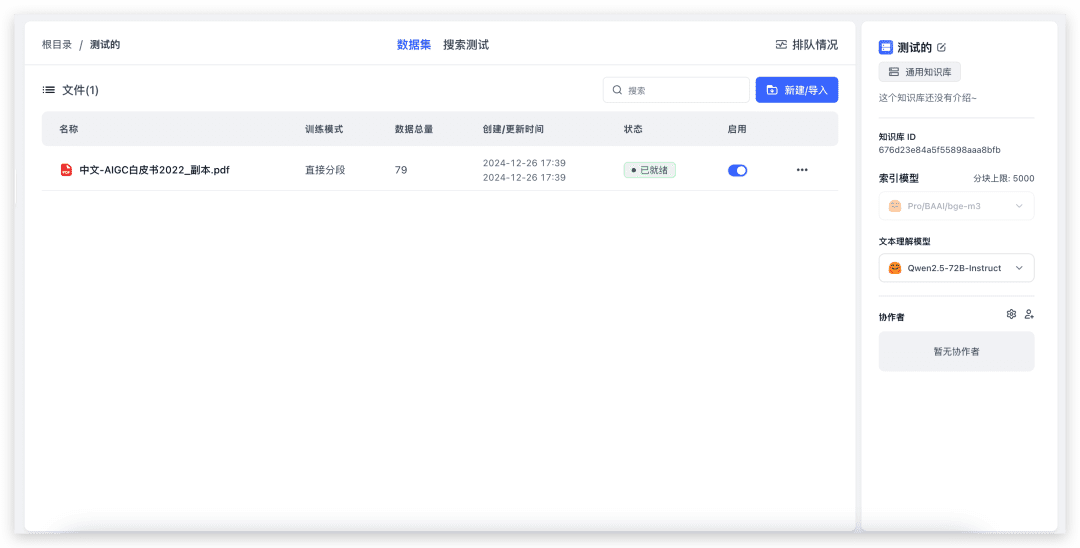

Test Wissensbasis-Import und Wissensbasis-Quiz

Erstellen Sie eine neue Wissensbasis (da nur ein Vektormodell konfiguriert ist, wird die Auswahl des Vektormodells nicht auf der Seite angezeigt).

Um eine lokale Datei zu importieren, wählen Sie einfach die Datei aus und gehen Sie auf "Weiter". 79 Indizes, und es dauerte etwa 20 Sekunden, bis der Vorgang abgeschlossen war. Testen wir nun das Quiz der Wissensdatenbank.

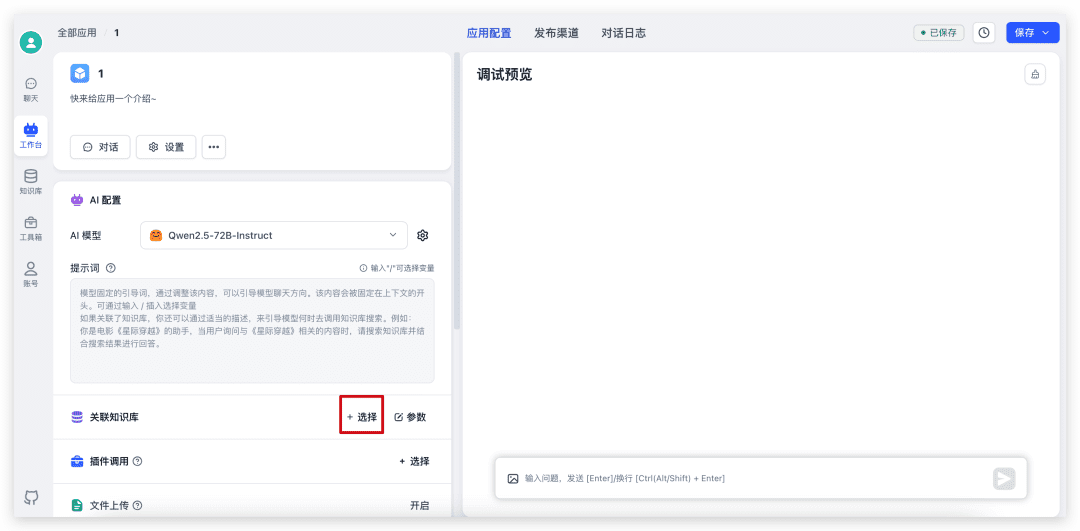

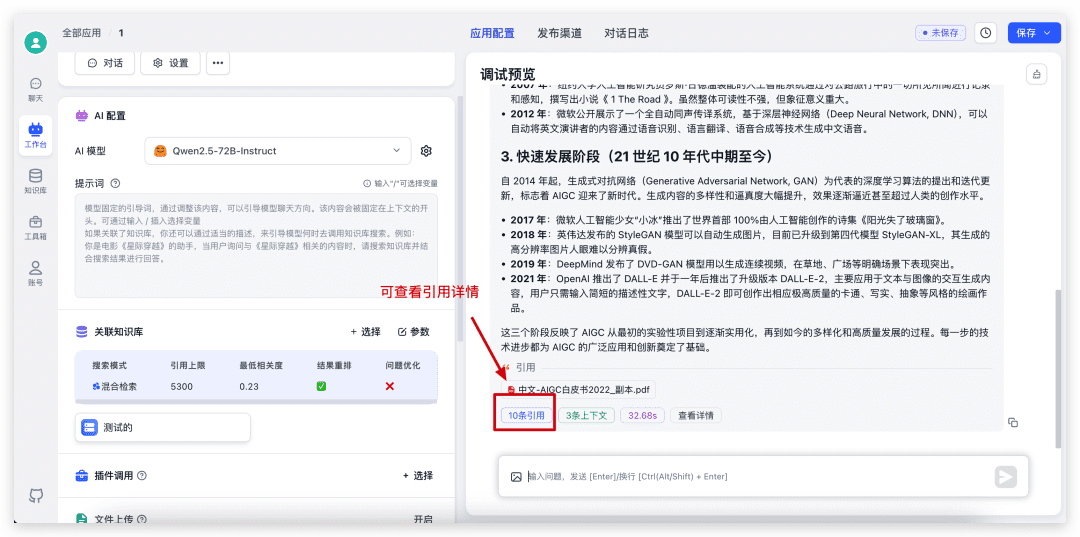

Gehen Sie zunächst zurück zu der soeben erstellten Anwendung, wählen Sie Knowledge Base, passen Sie die Parameter an und starten Sie den Dialog.

Sobald der Dialog abgeschlossen ist, klicken Sie unten auf das Zitat, um die Details des Zitats sowie die spezifischen Ergebnisse der Suche und der Neuordnung zu sehen.

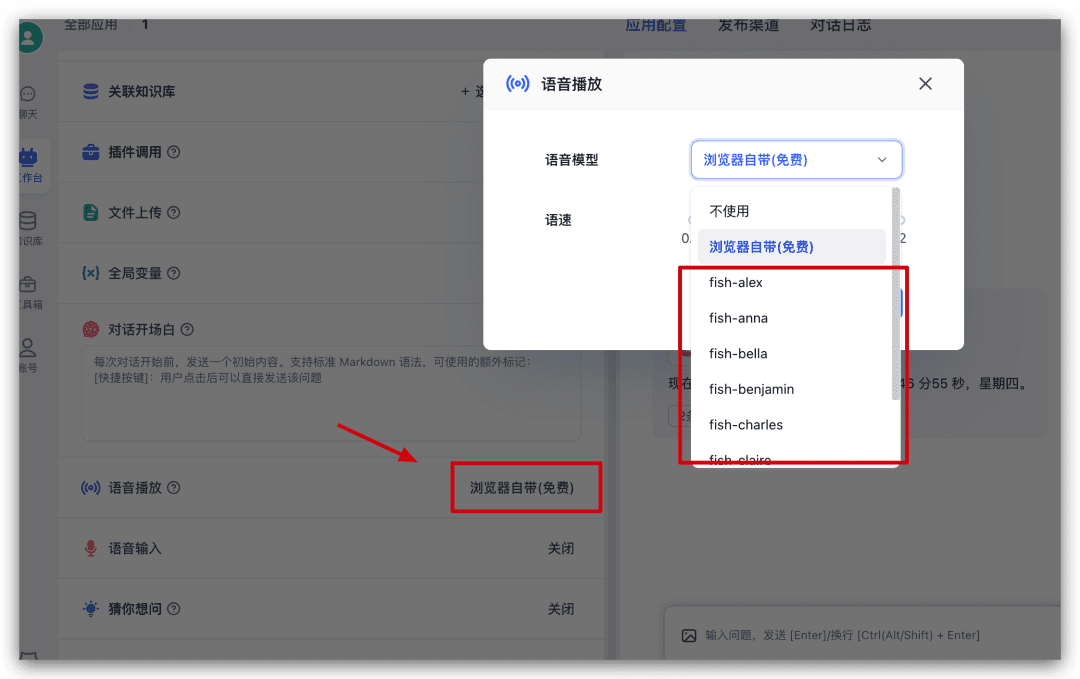

Test der Sprachwiedergabe

Fahren Sie in der App fort und suchen Sie auf der linken Seite der Konfiguration nach Voice Play. Klicken Sie darauf, um im Pop-up-Fenster ein Sprachmodell auszuwählen und es auszuprobieren.

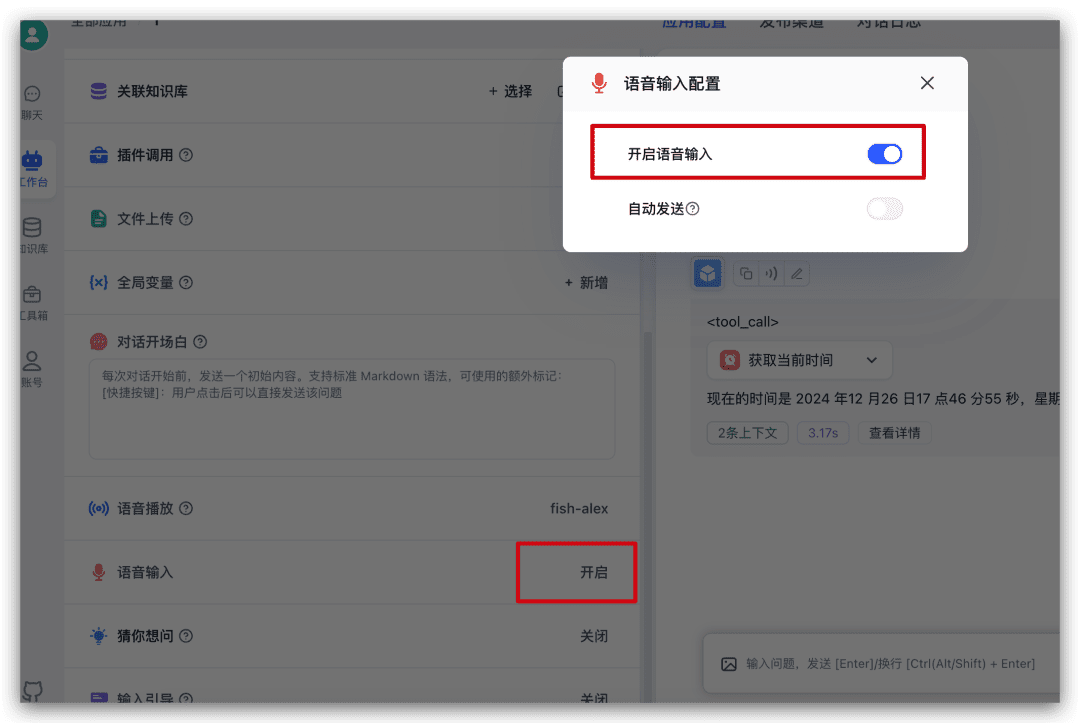

Test Spracheingabe

Suchen Sie die Spracheingabe in der Konfiguration auf der linken Seite der App und klicken Sie darauf, um die Spracheingabe im Pop-up-Fenster zu aktivieren.

Wenn sie eingeschaltet ist, wird im Dialogeingabefeld ein Mikrofonsymbol eingeblendet, auf das Sie zur Spracheingabe klicken können.

Zusammenfassungen

Wenn Sie das Open-Source-Modell schnell ausprobieren oder FastGPT schnell nutzen möchten und nicht alle Arten von API-Schlüsseln bei verschiedenen Dienstanbietern beantragen möchten, dann können Sie das Modell von SiliconCloud für eine schnelle Erfahrung wählen.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...