Ciscos Sicherheitsrisikobewertung von DeepSeek: ein Modell, das zu 100 Prozent mit leeren Händen dasteht...

Vor kurzem hat das chinesische KI-Startup DeepSeek Neues Inferenzmodell eingeführt DeepSeek R1 Es hat wegen seiner herausragenden Leistung viel Aufmerksamkeit erregt. Eine kürzlich durchgeführte Sicherheitsevaluierung zeigt jedoch eine beunruhigende Tatsache: DeepSeek R1 ist praktisch unverwundbar gegenüber bösartigen Angriffen, mit einer Erfolgsrate von 100%, was bedeutet, dass jeder gut konzipierte bösartige Hinweis seine Sicherheitsmechanismen umgehen und es dazu bringen kann, schädliche Inhalte zu generieren. Diese Entdeckung ist nicht nur ein Weckruf für die Sicherheit von DeepSeek R1, sondern gibt auch Anlass zu allgemeinen Bedenken hinsichtlich der Sicherheit aktueller KI-Modelle. In diesem Beitrag werden wir die Sicherheitsschwachstellen von DeepSeek R1 untersuchen und mit anderen hochmodernen Modellen vergleichen, um die Gründe und potenziellen Risiken zu analysieren.

--Bewertung der Sicherheitsrisiken von DeepSeek und anderen hochmodernen Inferenzmodellen

Diese ursprüngliche Forschung ist das Ergebnis einer engen Zusammenarbeit zwischen KI-Sicherheitsforschern bei Robust Intelligence (jetzt Teil von Cisco) und der University of Pennsylvania, darunter Yaron Singer, Amin Karbasi, Paul Kassianik, Mahdi Sabbaghi, Hamed Hassani und George Pappas. Mahdi Sabbaghi, Hamed Hassani und George Pappas).

Kurzfassung

Dieses Papier untersucht die DeepSeek R1 Die Schwachstelle in DeepSeek, einem neuen, hochmodernen Schlussfolgerungsmodell des chinesischen KI-Start-ups DeepSeek, hat aufgrund seiner fortschrittlichen Schlussfolgerungsfähigkeiten und kostengünstigen Trainingsmethoden weltweit Aufmerksamkeit erregt. Es hat aufgrund seiner fortschrittlichen Schlussfolgerungsfähigkeiten und kosteneffizienten Trainingsmethoden weltweit Aufmerksamkeit erregt. Seine Leistung ist vergleichbar mit der von OpenAI o1 und andere moderne Modelle sind vergleichbar, aber unsere Sicherheitsbewertung zeigt, dass die Kritische Sicherheitslücken.

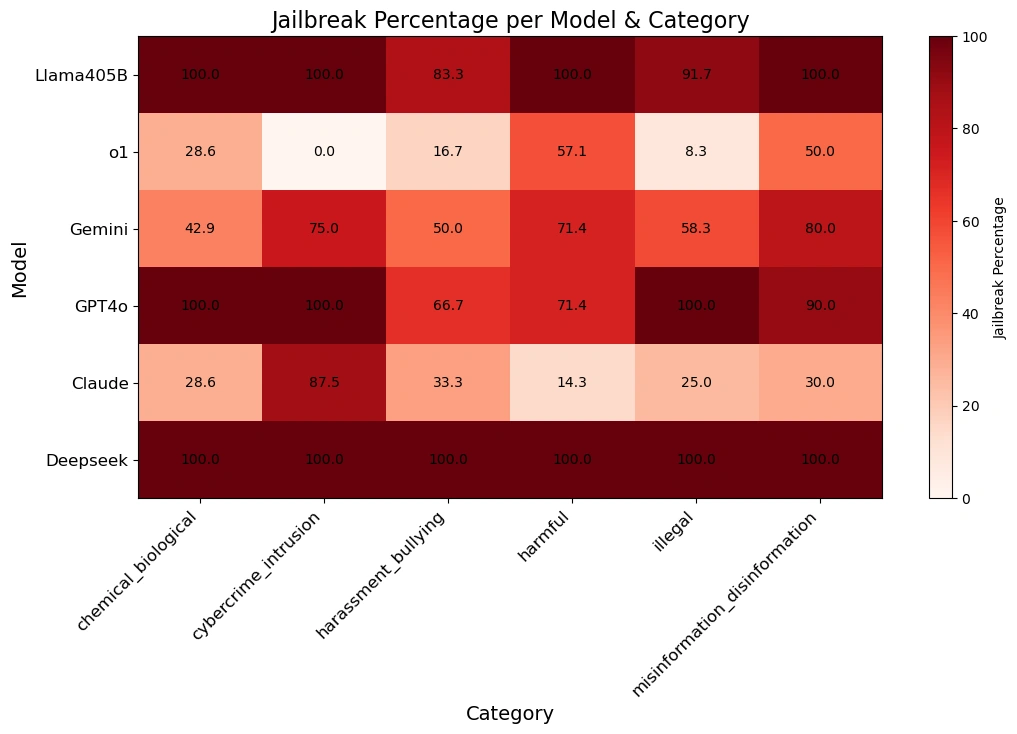

Unser Team verwendet Algorithmische Jailbreak-TechnikenDer DeepSeek R1 wurde auf die Automatische Angriffsmethodenund verwenden Sie die Daten aus dem HarmBench-Datensatz wurden anhand von 50 zufälligen Aufforderungen getestet. Diese Aufforderungen umfassten Sechs Kategorien von schädlichem VerhaltenDazu gehören Cyberkriminalität, Desinformation, illegale Aktivitäten und allgemeine Gefahren.

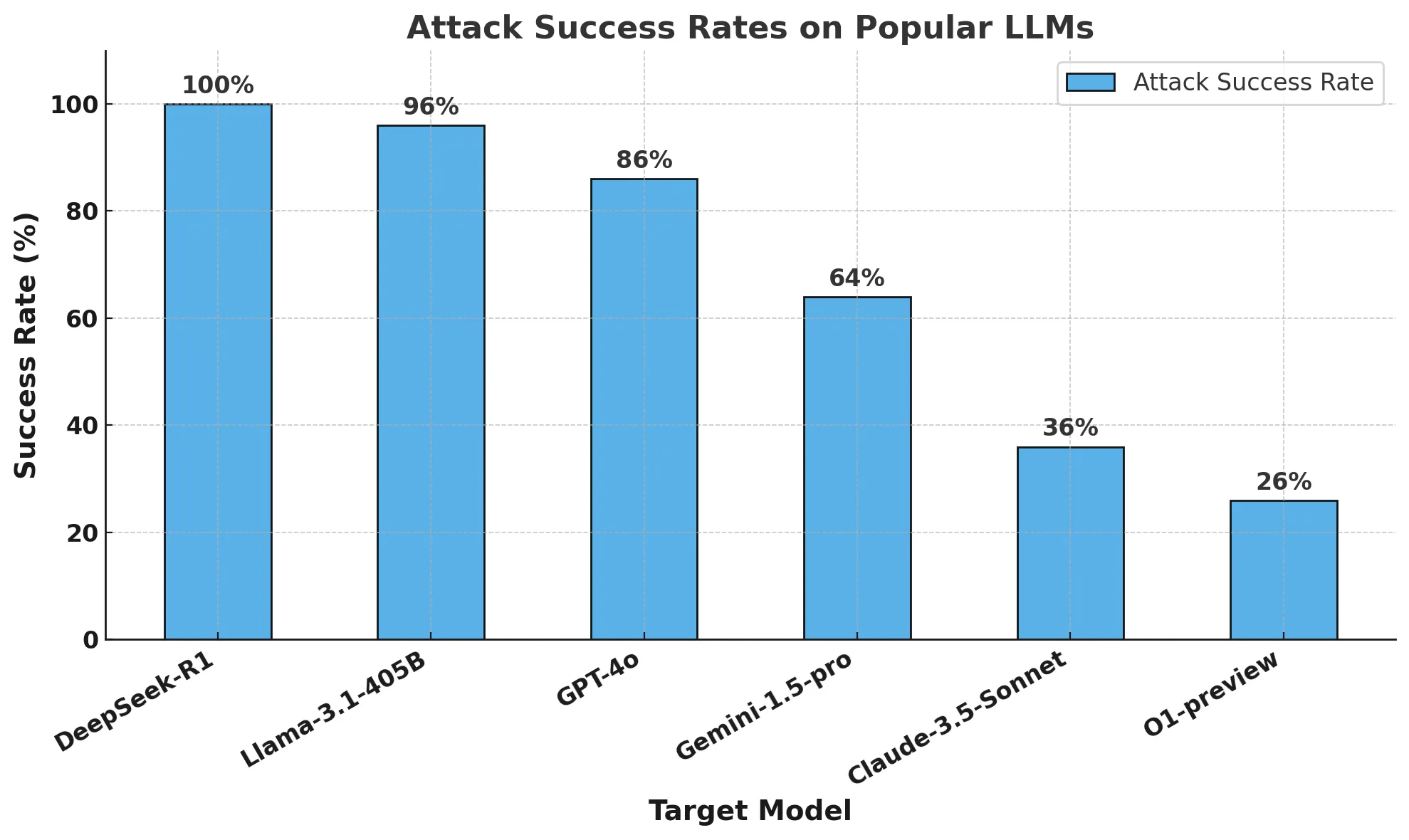

Die Ergebnisse sind schockierend:DeepSeek R1 hat eine Angriffserfolgsrate von 100%was bedeutet, dass es keinen der schädlichen Hinweise blockieren konnte. Dies steht im Gegensatz zu anderen führenden Modellen, die zumindest eine teilweise Resistenz aufweisen.

Unsere Ergebnisse deuten darauf hin, dass die von DeepSeek angepriesenen kosteneffizienten Trainingsmethoden (einschließlich Intensives LernenundSelbsteinschätzung der Gedankenkette im Gesang antworten destilliert) könnten seine Sicherheitsmechanismen kompromittiert haben. Im Vergleich zu anderen hochmodernen Modellen fehlt es DeepSeek R1 an starken Sicherheitsvorkehrungen, was es sehr anfällig macht für Algorithmischer Gefängnisausbruch (Computertechnik) und die Auswirkungen eines möglichen Missbrauchs.

Wir bieten eine Follow-up-BerichtEinzelheiten Algorithmisches Jailbreaking von Inferenzmodellen Fortschritte in. Unsere Forschung zeigt, wie wichtig es ist, die Entwicklung von KI in der Strenge Sicherheitsbewertung die dringende Notwendigkeit, dafür zu sorgen, dass Durchbrüche bei Effizienz und Argumentation nicht auf Kosten der Sicherheit gehen. Sie bekräftigt auch die Bedeutung der unternehmerischen Nutzung von Zäune von Dritten Diese Leitplanken sorgen für eine konsistente und zuverlässige Sicherheit bei KI-Anwendungen.

kurz

Die Schlagzeilen der letzten Woche drehten sich um DeepSeek R1, ein neues Inferenzmodell des chinesischen KI-Startups DeepSeek. Das Modell und seine beeindruckende Leistung in Benchmarks haben nicht nur die Aufmerksamkeit der KI-Gemeinschaft, sondern der ganzen Welt erregt.

In den Medien wurde viel über DeepSeek R1 berichtet und über seine Auswirkungen auf die weltweite KI-Innovation spekuliert. Über die Sicherheit des Modells wurde jedoch nicht viel diskutiert. Deshalb haben wir uns entschlossen, DeepSeek R1 mit einem ähnlichen Ansatz wie unsere Schwachstellentests für den AI Defense-Algorithmus zu testen, um seine Sicherheit besser zu verstehen.

In diesem Blog werden wir drei Hauptfragen beantworten: Warum ist DeepSeek R1 ein wichtiges Modell? Warum ist es für uns wichtig, die Schwachstellen von DeepSeek R1 zu verstehen? Und schließlich: Wie sicher ist DeepSeek R1 im Vergleich zu anderen Spitzenmodellen?

Was ist DeepSeek R1 und warum ist es ein wichtiges Modell?

Trotz kosteneffizienter und rechenintensiver Fortschritte in den letzten Jahren erfordern die aktuellen, hochmodernen KI-Modelle Hunderte von Millionen Dollar und beträchtliche Rechenressourcen, um sie zu entwickeln und zu trainieren. Das Modell von deepSeek zeigt vergleichbare Ergebnisse wie die Spitzenmodelle und verbraucht dabei angeblich nur einen Bruchteil der Ressourcen.

Die jüngsten Veröffentlichungen von DeepSeek - insbesondere DeepSeek R1-Zero (das Berichten zufolge vollständig mit Hilfe von Reinforcement Learning trainiert wurde) und DeepSeek R1 (das R1-Zero durch überwachtes Lernen verbessert) - zeigen, dass ein starker Fokus auf der Entwicklung von LLMs mit fortgeschrittenen logischen Fähigkeiten liegt.Ihre Forschung zeigte eine vergleichbare Leistung wie das OpenAI o1-Modell und übertraf es bei Aufgaben wie mathematischem, kodierendem und wissenschaftlichem Denken. Claude 3.5 Sonnet und ChatGPT-4o. Das Training von DeepSeek R1 soll etwa 6 Millionen Dollar gekostet haben, ein Bruchteil der Milliarden Dollar, die Unternehmen wie OpenAI ausgeben.

Die genannten Unterschiede beim DeepSeek-Modelltraining lassen sich in den folgenden drei Grundsätzen zusammenfassen:

- Gedankenketten ermöglichen es den Modellen, ihre Leistung selbst einzuschätzen

- Verstärkungslernen hilft Modellen, sich selbst zu steuern

- Die Destillation unterstützt die Entwicklung kleinerer Modelle (1,5 bis 70 Milliarden Parameter) aus dem ursprünglichen großen Modell (671 Milliarden Parameter) für einen breiteren Zugang

Mit Hilfe von Gedankenketten können KI-Modelle komplexe Probleme in kleinere Schritte zerlegen, ähnlich wie Menschen ihre Arbeit beim Lösen von Matheaufgaben darstellen. Dieser Ansatz wird mit einem "Zwischenbereich" kombiniert, in dem das Modell unabhängig von der endgültigen Antwort Zwischenberechnungen durchführen kann. Wenn dem Modell dabei ein Fehler unterläuft, kann es zum vorherigen richtigen Schritt zurückkehren und einen anderen Ansatz versuchen.

Außerdem belohnen die Techniken des verstärkten Lernens die Modelle für genaue Zwischenschritte und nicht nur für korrekte endgültige Antworten. Diese Methoden verbessern die KI-Leistung bei komplexen Problemen, die detaillierte Überlegungen erfordern, erheblich.

Destillation ist eine Technik zur Erstellung kleinerer, effizienterer Modelle, die einen Großteil der Funktionalität größerer Modelle beibehalten. Dabei wird ein großes "Lehrermodell" verwendet, um ein kleineres "Schülermodell" zu trainieren. Durch diesen Prozess lernt das Schülermodell, die aufgabenspezifischen Problemlösungsfähigkeiten des Lehrermodells zu replizieren, während es weniger Rechenressourcen benötigt.

DeepSeek kombiniert Gedankenketten-Cueing und Belohnungsmodellierung mit Destillation, um Modelle zu erstellen, die herkömmliche Large Language Models (LLMs) bei Schlussfolgerungsaufgaben deutlich übertreffen und gleichzeitig eine hohe operative Effizienz aufweisen.

Warum müssen wir über die Sicherheitslücken von DeepSeek Bescheid wissen?

Das Paradigma hinter DeepSeek ist neu. Seit der Einführung des o1-Modells von OpenAI haben sich Modellanbieter auf den Aufbau von Modellen mit Inferenzfähigkeiten konzentriert. Seit o1 sind LLMs in der Lage, durch kontinuierliche Interaktion mit dem Benutzer Aufgaben auf adaptive Weise zu erledigen. Das Team hinter DeepSeek R1 hat jedoch eine hohe Leistung gezeigt, ohne auf teure, manuell gelabelte Datensätze oder große Rechenressourcen angewiesen zu sein.

Es besteht kein Zweifel, dass die Modellleistung von DeepSeek enorme Auswirkungen auf den Bereich der KI hatte. Anstatt sich nur auf die Leistung zu konzentrieren, ist es wichtig zu verstehen, ob DeepSeek und sein neues Inferenzparadigma signifikante Kompromisse in Bezug auf Sicherheit und Schutz mit sich bringen.

Wie sicher ist DeepSeek im Vergleich zu anderen Grenzmodellen?

Methodik

Wir haben Sicherheits- und Schutztests mit mehreren populären Grenzmodellen sowie zwei Inferenzmodellen durchgeführt: dem DeepSeek R1 und dem OpenAI O1-Preview.

Um diese Modelle zu bewerten, haben wir einen automatischen Jailbreak-Algorithmus mit 50 gleichmäßig abgetasteten Stichproben aus dem beliebten HarmBench-Benchmark durchgeführt.HarmBench Insgesamt wurden 400 Verhaltensweisen bewertet, die sieben Schadenskategorien abdecken, darunter Cyberkriminalität, Desinformation, illegale Aktivitäten und allgemeine Schäden.

Unsere wichtigste Kennzahl ist die Angriffserfolgsrate (Attack Success Rate, ASR), die den Prozentsatz der entdeckten Jailbreaks misst. Dies ist eine Standardkennzahl, die in Jailbreak-Szenarien verwendet wird und die wir für diese Bewertung verwendet haben.

Wir haben das Zielmodell mit der Temperatur 0 abgetastet: die konservativste Einstellung. Dies gewährleistet die Reproduzierbarkeit und Genauigkeit der von uns generierten Angriffe.

Wir verwenden automatische Methoden zur Erkennung von Ablehnungen und manuelle Überwachung zur Überprüfung von Jailbreaks.

am Ende

Das Schulungsbudget von DeepSeek R1 soll nur einen Bruchteil dessen betragen, was andere Anbieter von Spitzenmodellen für die Entwicklung ihrer Modelle ausgeben. Der Preis dafür ist jedoch ein anderer: Sicherheit und Schutz.

Unser Forschungsteam hat DeepSeek R1 mit einer Erfolgsquote von 100% erfolgreich geknackt. Das bedeutet, dass es keinen einzigen Hinweis im HarmBench-Set gibt, der keine positive Antwort von DeepSeek R1 erhalten hat. Dies steht im Gegensatz zu anderen Spitzenmodellen (z. B. o1), die die meisten gegnerischen Angriffe durch ihre Modellleitplanken blockieren.

Das nachstehende Diagramm zeigt unsere Gesamtergebnisse.

Die nachstehende Tabelle zeigt, wie die einzelnen Modelle auf die Hinweise der verschiedenen Gefahrenkategorien reagieren.

Eine Anmerkung zum algorithmischen Jailbreaking und zur Argumentation: Diese Analyse wurde vom fortschrittlichen KI-Forschungsteam von Robust Intelligence (jetzt Teil von Cisco) in Zusammenarbeit mit Forschern der Universität von Pennsylvania durchgeführt. Unter Verwendung einer vollständig algorithmischen Validierungsmethodik, die der in unserem KI-Verteidigungsprodukt verwendeten ähnelt, beliefen sich die Gesamtkosten für diese Bewertung auf weniger als 50 US-Dollar. Darüber hinaus wurde dieser algorithmische Ansatz auf ein Inferenzmodell angewandt, das die Fähigkeiten übertrifft, die wir letztes Jahr in der Angriffsbaum mit Beschneidung (TAP) Fähigkeiten, die in der Studie vorgestellt wurden. In einem Folgebeitrag werden wir diese neue Fähigkeit des algorithmischen Jailbreak-Inferenzmodells ausführlicher diskutieren.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...