Online-Einsatz des Open-Source-Modells DeepSeek-R1 mit kostenloser GPU-Leistung

Danke an Tencent Cloud Cloud Studio und DeepSeek DeepSeek-R1.

Angesichts der rasanten Entwicklung von KI- und Big-Model-Technologien wollen immer mehr Entwickler und Forscher Big-Models selbst ausprobieren und feinabstimmen, um diese fortschrittlichen Technologien besser zu verstehen und anzuwenden. Die hohen Kosten der GPU-Arithmetik werden jedoch oft zu einem Engpass, der jeden von der Erforschung abhält. Glücklicherweise stellt Tencent Cloud Studio kostenlose GPU-Arithmetik-Ressourcen zur Verfügung. In Kombination mit den von DeepSeek eingeführten DeepSeek-R1 Big Models können wir diese leistungsstarken Modelle problemlos in der Cloud einsetzen und ausführen, ohne einen Cent auszugeben.

In diesem Artikel erfahren Sie, wie Sie die Tencent Cloud Wolken-Studio kostenloser GPU-Ressourcen zur Bereitstellung und Interaktion mit dem DeepSeek-R1-Makromodell. Wir beginnen mit der Verwendung von Cloud Studio und gehen Schritt für Schritt durch die Installation und Konfiguration von Ollama und zeigen, wie man die DeepSeek-R1 und sprechen Sie mit ihm, und Sie erhalten einen vollständigen und kostenlosen DeepSeek-R1 + eine Reihe von Roo-Code Kostenloses Programmierungsportfolio-Programm.

1. das Cloud Studio

1.1 Einführung in Cloud Studio

Tencent Cloud Cloud Studio ist eine Cloud-basierte integrierte Entwicklungsumgebung (IDE), die eine Fülle von Entwicklungstools und Ressourcen bereitstellt, um Entwicklern zu helfen, effizienter zu programmieren, zu debuggen und bereitzustellen. Kürzlich startete Cloud Studio kostenlose GPU-Computing-Ressourcen, Benutzer können jeden Monat 10.000 Minuten GPU-Server kostenlos nutzen, konfiguriert mit 16G Videospeicher, 32G RAM und 8-Core-CPU. dies ist zweifellos ein großer Segen für Entwickler, die High-Performance-Computing-Ressourcen benötigen. (Denken Sie daran, Punkt, um die Maschine nach Gebrauch zu schließen, die nächste Feinabstimmung und dann öffnen Sie es, die Umwelt wird automatisch gespeichert, 10.000 Minuten pro Monat kann einfach nicht aufgebraucht werden)

1.2 Registrierung und Anmeldung

Um Cloud Studio zu nutzen, müssen Sie zunächst ein Tencent Cloud-Konto registrieren. Sobald die Registrierung abgeschlossen ist, melden Sie sich bei Cloud Studio an und Sie sehen eine übersichtliche Benutzeroberfläche, die eine Vielzahl von Entwicklungsvorlagen zur Auswahl bietet. Diese Vorlagen decken eine breite Palette von Szenarien ab, von der grundlegenden Python-Entwicklung bis hin zu komplexen großen Modellimplementierungen. Vergessen Sie nicht, die Pro-Version einzugeben.

1.3 Auswahl der Ollama-Vorlage

Da unser Ziel darin besteht, die DeepSeek-R1 großes Modell, also können wir einfach wählen Ollama Templates.Ollama ist ein Tool zur Verwaltung und Ausführung großer Modelle, das den Prozess des Herunterladens, der Installation und der Ausführung von Modellen vereinfacht. Nach der Auswahl einer Ollama-Vorlage konfiguriert Cloud Studio automatisch die Ollama-Umgebung für uns, sodass eine manuelle Installation nicht mehr erforderlich ist.

Warten Sie auf den Start, klicken Sie auf Enter (Ollama ist bereits in der Umgebung installiert, führen Sie einfach den Installationsbefehl direkt aus)

2. ollama

2.1 Einführung in Ollama

Ollama ist ein Open-Source-Tool, das speziell für die Verwaltung und Ausführung verschiedener großer Modelle entwickelt wurde. Es unterstützt eine Vielzahl von Modellformaten und kann automatisch Modellabhängigkeiten handhaben, was die Bereitstellung und Ausführung von Modellen sehr einfach macht. Die offizielle Website von Ollama bietet eine Fülle von Modellressourcen, die Benutzer können das richtige Modell entsprechend ihren Bedürfnissen zum Herunterladen und Ausführen auswählen.

2.2 Modellparameter und Auswahl

Auf der offiziellen Website von Ollama ist die Anzahl der Parameter jedes Modells am unteren Rand des Modells angegeben, z. B. 7B, 13B, 70B usw. Dabei steht "B" für Milliarde. Das "B" steht hier für Milliarde und gibt die Anzahl der Parameter des Modells an. Je größer die Anzahl der Parameter ist, desto komplexer und leistungsfähiger ist das Modell, aber es verbraucht auch mehr Rechenressourcen.

Für die von Tencent Cloud Studio bereitgestellten kostenlosen GPU-Ressourcen (16G Videospeicher, 32G RAM, 8-Kern-CPU) können wir 8B- oder 13B-Modelle für den Einsatz wählen. Wenn Sie eine höhere Hardwarekonfiguration haben, können Sie auch Modelle mit größeren Parametern ausprobieren, um bessere Ergebnisse zu erzielen.

2.3 Installation von Ollama

Nach der Auswahl der Ollama-Vorlage in Cloud Studio wird das System automatisch Ollama für uns installieren. Wenn Sie Ollama in anderen Umgebungen verwenden, können Sie es mit dem folgenden Befehl installieren:

curl -fsSL https://ollama.com/install.sh | shSobald die Installation abgeschlossen ist, können Sie mit dem folgenden Befehl überprüfen, ob Ollama erfolgreich installiert wurde:

ollama --versionDer nächste Schritt ist die Bereitstellung von DeepSeek-R1 durch Ollama ...

3. kostenlose Bereitstellung von DeepSeek-R1

3.1 Einführung in DeepSeek-R1

DeepSeek-R1 ist ein leistungsstarkes, großes Modell von DeepSeek, das bei einer Reihe von Aufgaben zur Verarbeitung natürlicher Sprache, insbesondere in den Bereichen Texterzeugung, Dialogsysteme und Fragen und Antworten, gute Leistungen erbringt. Die Anzahl der Parameter von DeepSeek-R1 reicht von 8B bis 70B, so dass der Benutzer je nach seiner Hardwarekonfiguration das richtige Modell für den Einsatz wählen kann.

3.2 Herunterladen und Bereitstellen

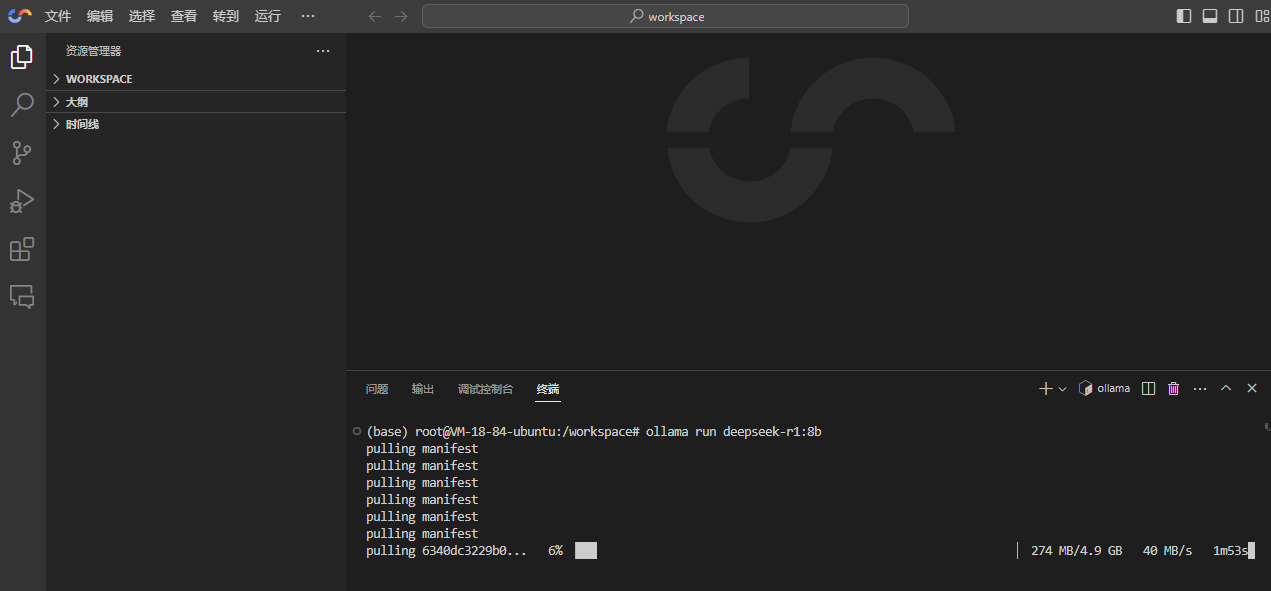

Die Bereitstellung von DeepSeek-R1 ist sehr einfach, da Cloud Studio Ollama bereits automatisch installiert. Wir müssen nur den folgenden Befehl ausführen:

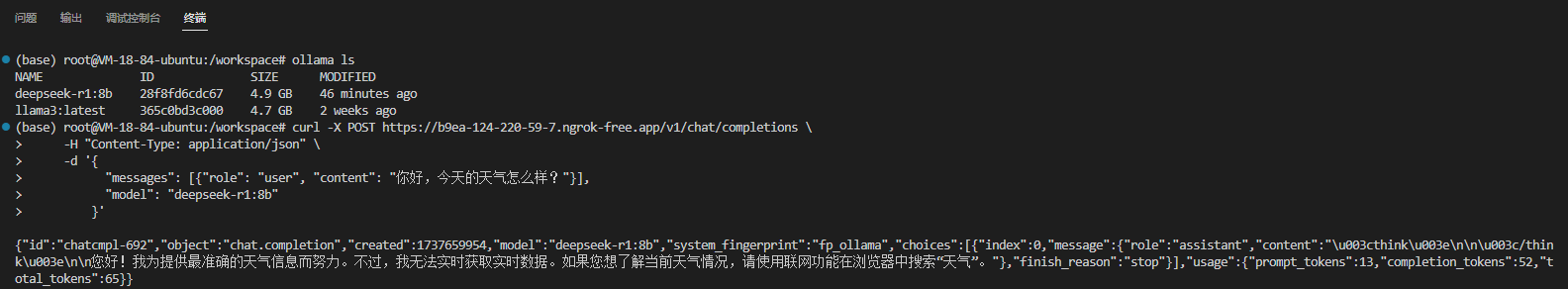

ollama run deepseek-r1:8b

Alle verfügbaren Modelle von DeepSeek-R1 finden Sie hier: https://ollama.com/library/deepseek-r1 , empfohlen! ollama run deepseek-r1:14b (Dies ist das destillierte Qwen-Modell.)

3.3 Modellläufe

Nachdem Sie gewartet haben, bis das Modell fertig heruntergeladen ist, startet Ollama automatisch DeepSeek-R1 und wechselt in den interaktiven Modus. An diesem Punkt können Sie Fragen oder Befehle direkt in das Terminal eingeben, um mit DeepSeek-R1 zu sprechen.

4. mit DeepSeek-R1 zu chatten beginnen

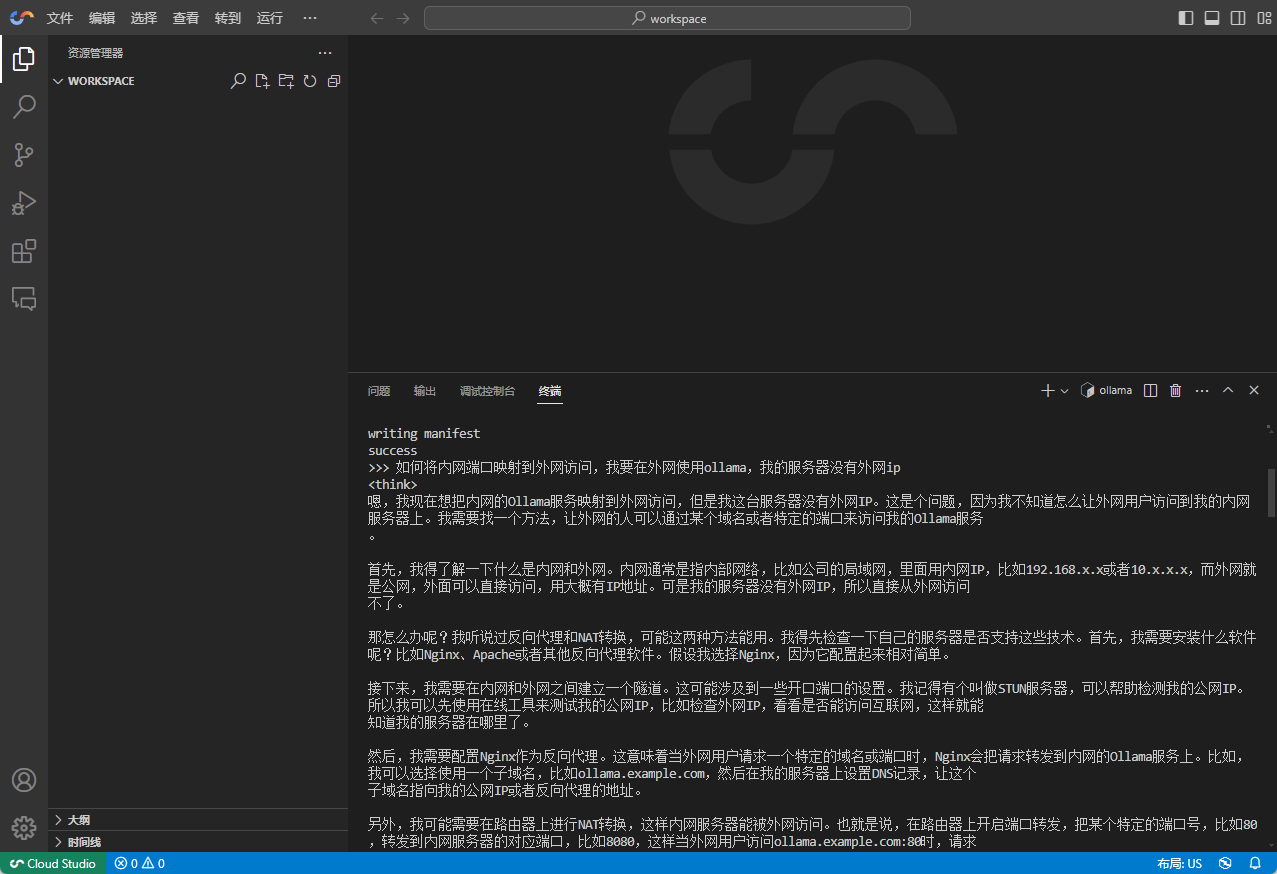

4.1 Grundlegender Dialog

Der Dialog mit DeepSeek-R1 ist sehr einfach, Sie müssen nur Ihre Frage oder Anweisung in das Terminal eingeben und das Modell wird sofort eine Antwort generieren.

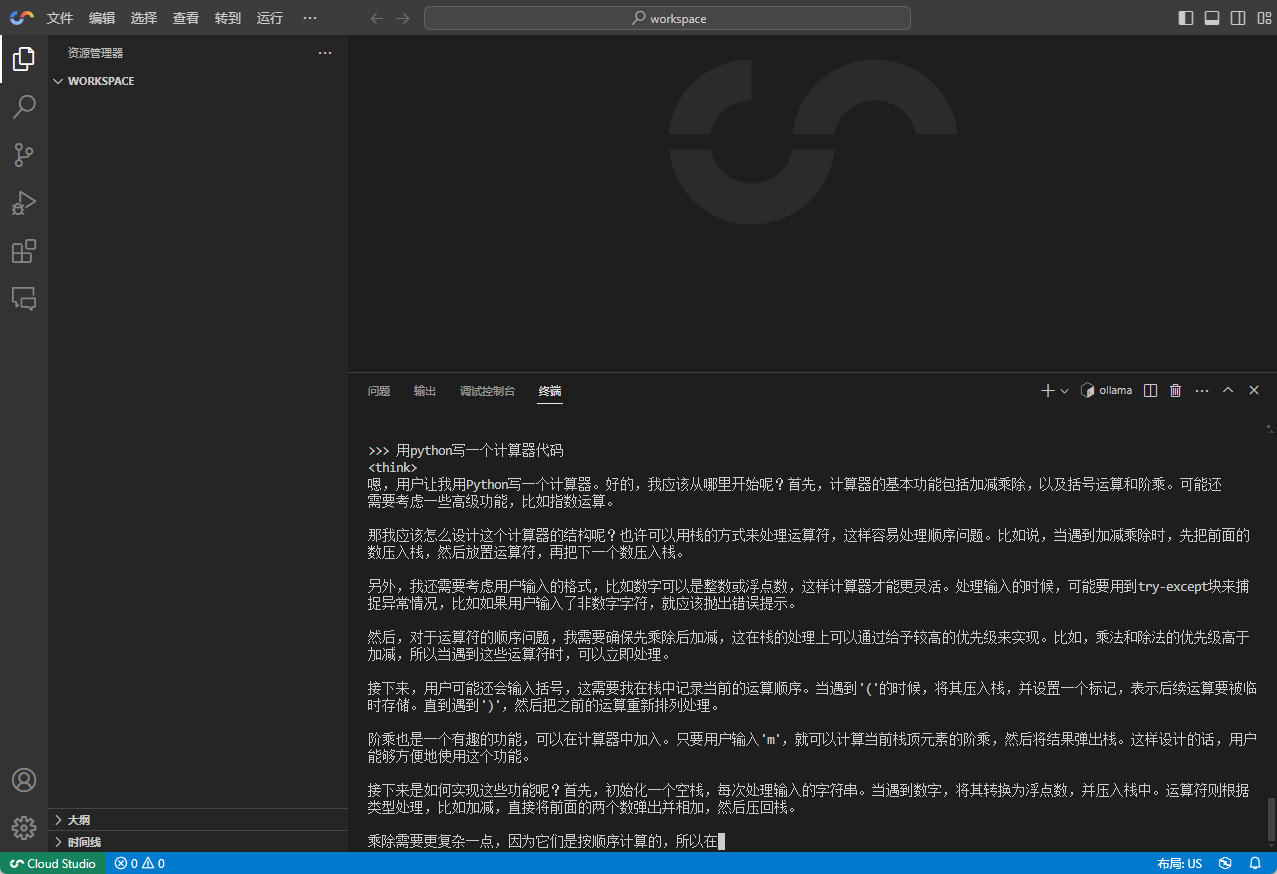

4.2 Komplexe Aufgaben

- Beispiel: Codegenerierung mit DeepSeek-R1

4.3 Feinabstimmung des Modells

Wenn Sie mit der Leistung von DeepSeek-R1 nicht zufrieden sind oder möchten, dass das Modell bei bestimmten Aufgaben besser abschneidet, können Sie versuchen, eine Feinabstimmung des Modells vorzunehmen. Der Prozess der Feinabstimmung umfasst in der Regel die Vorbereitung einiger domänenspezifischer Datensätze und das erneute Trainieren des Modells mit diesen Datensätzen.Ollama bietet einfache Schnittstellen, die den Benutzern bei der Feinabstimmung des Modells helfen.

4.4 Verwendung in KI-Programmierwerkzeugen

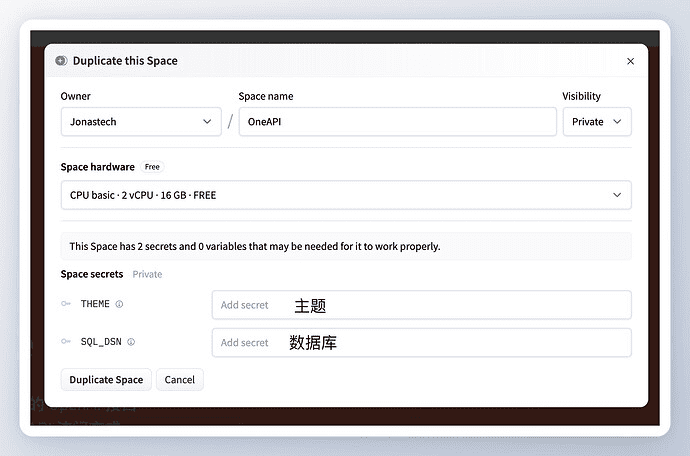

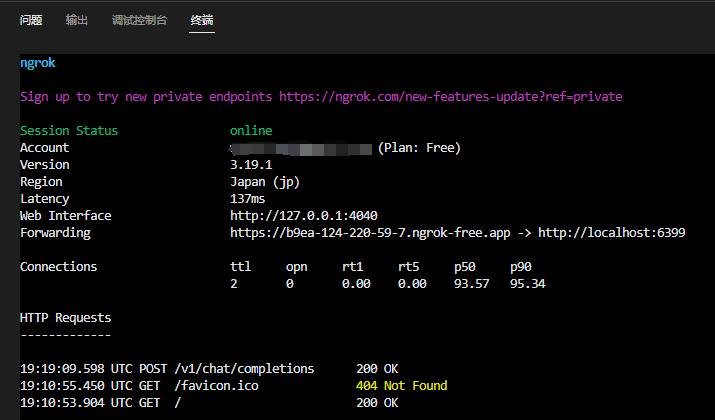

Die Verwendung im Terminal ist sicherlich nicht das Hauptszenario, wir wollen den Dienst in anderen Chat-Tools oder KI-Programmier-Tools verwenden, um praktisch zu sein. Cloud Studio bietet keine externe Zugangsadresse. In diesem Fall ist ngrok/Cpolar eine gute Lösung.

Nur Ideen liefern, nicht detaillierte Erklärung: der erste Schritt, um das Intranet Ollama Port abzufragen, der zweite Schritt, um ngrok zu installieren, der dritte Schritt, um die Ollama Port zu ngrok Karte, starten Sie den Dienst erhalten Sie die folgende Adresse:

Hinweis: Es wird davon ausgegangen, dass Ihr ollama serve Der Dienst ist bereits in 6399 Wenn Sie wissen, auf welchem Port Ngrok laufen soll, können Sie den folgenden Befehl verwenden, um Ngrok zu starten und den Port dem Extranet zuzuordnen:ngrok http 6399

Überprüfen Sie, ob das Extranet funktioniert: (zum Spleißen der vollständigen Adresse)

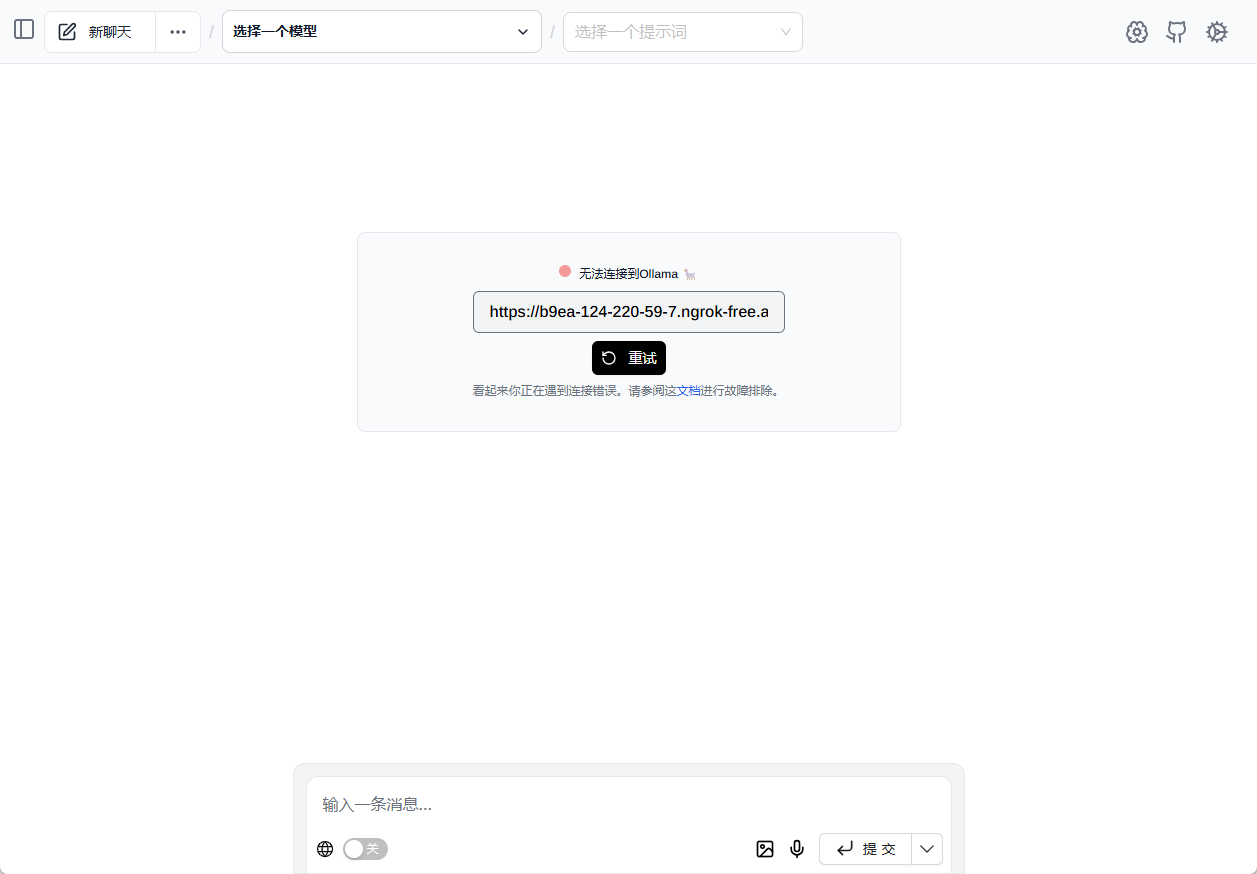

Wir empfehlen die Verwendung eines nativen Browser-Plug-ins, um die Funktionen von Ollama zu nutzen. Seite Assist (geben Sie direkt https://xxx.ngrok-free.app/ ein, um automatisch alle Ollama-Modelle zu laden)

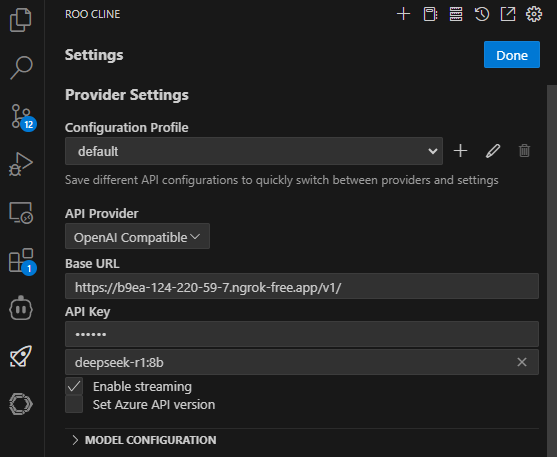

existieren Roo Code (Roo Cline) Konfigurieren Sie die API im Client: (Roo Code ist ein hervorragendes Plugin für die KI-Programmierung)

Beachten Sie die Hinzufügung von v1 zur ursprünglichen URL und zum API-KEY.

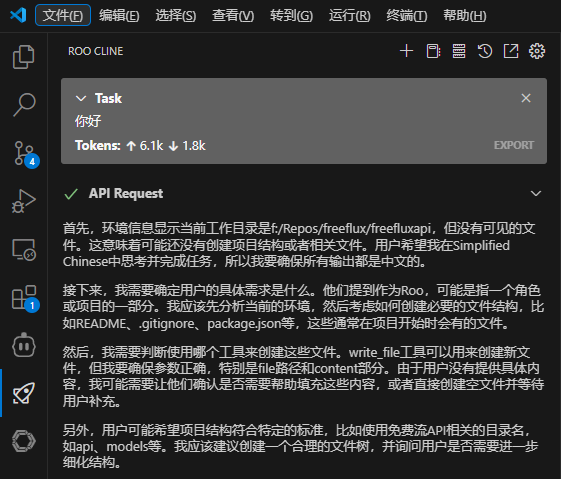

Speichern und testen Sie den Dialog:

5. zusammenfassung

Mit den kostenlosen GPU-Ressourcen von Tencent Cloud Cloud Studio in Kombination mit Ollama und DeepSeek-R1 können wir große Modelle problemlos in der Cloud bereitstellen und ausführen, ohne uns über hohe Hardwarekosten Gedanken zu machen. Ob Sie eine einfache Unterhaltung führen oder an einer komplexen Aufgabe arbeiten, DeepSeek-R1 bietet leistungsstarke Unterstützung. Wir hoffen, dass dieser Artikel Ihnen helfen kann, DeepSeek-R1 reibungslos einzusetzen und Ihre Reise zur Erforschung großer Modelle zu beginnen.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...