Schaffung der nächsten Generation von Chat-Assistenten mit Amazon Bedrock, Amazon Connect, Amazon Lex, LangChain und WhatsApp

Dieser Artikel wurde gemeinsam von Harrison Chase, Erick Friis und Linda Ye von LangChain verfasst.

Generative KI wird das Nutzererlebnis in den kommenden Jahren revolutionieren. Ein wichtiger Schritt in diesem Prozess ist die Einführung von KI-Assistenten, die den Kunden auf intelligente Weise bei der Navigation in der digitalen Welt helfen können. In diesem Beitrag zeigen wir, wie ein kontextbezogener KI-Assistent eingesetzt werden kann. Der Assistent basiert auf Amazon Bedrock WissensdatenbankundAmazon Lex im Gesang antworten Amazon verbinden Aufbau und Nutzung von WhatsApp als Interaktionskanal, um den Nutzern eine vertraute und bequeme Schnittstelle zu bieten.

Die Amazon Bedrock Knowledge Base bietet kontextbezogene Informationen aus privaten Unternehmensdatenquellen für Foundational Models (FMs) und Agenten und unterstützt Suche Verbesserte Generation (RAG), um relevantere, genauere und individuellere Antworten zu geben. Diese Funktion bietet eine leistungsstarke Lösung für Unternehmen, die ihre generativen KI-Anwendungen verbessern möchten. Durch die native Kompatibilität mit Amazon Lex und Amazon Connect vereinfacht sie die Integration von domänenspezifischem Wissen. Durch die Automatisierung von Dokumentenimport, Chunking und Einbettung entfällt die Notwendigkeit, komplexe Vektordatenbanken oder benutzerdefinierte Abfragesysteme manuell einzurichten, was die Komplexität und den Zeitaufwand für die Entwicklung drastisch reduziert.

Diese Lösung verbessert die Genauigkeit der zugrundeliegenden Modellantworten und reduziert die Anzahl der falschen Antworten aufgrund von validierungsbasierten Daten. Im Vergleich zur Wartung eines benutzerdefinierten Wissensmanagementsystems verbessert diese Lösung die Kosteneffizienz durch die Reduzierung von Entwicklungsressourcen und Betriebskosten. Mit den serverlosen Services von AWS ist die Lösung skalierbar und kann schnell an wachsende Datenmengen und Benutzerabfragen angepasst werden. Außerdem wird die robuste Sicherheitsinfrastruktur von AWS genutzt, um Datenschutz und Compliance zu gewährleisten. Durch die kontinuierliche Aktualisierung und Erweiterung der Wissensdatenbank können KI-Anwendungen immer mit den neuesten Informationen Schritt halten. Durch die Entscheidung für die Amazon Bedrock Knowledge Base können sich Unternehmen auf die Erstellung von KI-Anwendungen mit Mehrwert konzentrieren, während AWS die Komplexität der Wissensverwaltung und -abfrage übernimmt, was zu einer schnelleren Bereitstellung genauerer und leistungsfähigerer KI-Lösungen mit weniger Aufwand führt.

Vorbedingungen

Um die Lösung zu implementieren, benötigen Sie folgende Voraussetzungen:

- eine AWS-KontoDas Unternehmen ist in der Lage, eine breite Palette von Dienstleistungen auf Amazon Bedrock, Amazon Lex, Amazon Connect und AWS Lambda Erlaubnis zum Erstellen von Ressourcen in der

- Modell-Zugriffsrechte sind verfügbar auf der Seite Amazonas-Felsen aktivieren. Claude 3 Haiku von Anthropic Modelle. In Übereinstimmung mit dem Zugriff auf das Amazon Bedrock Base Model Die schrittweise Vorgehensweise in der

- eine WhatsApp Geschäftskonto für die Integration mit Amazon Connect.

- Produktdokumentation, Wissensartikel oder andere relevante Daten in einem kompatiblen Format (z. B. PDF oder Text), die in die Wissensdatenbank importiert werden sollen.

Überblick über die Lösung

Diese Lösung nutzt mehrere wichtige AWS-KI-Services zur Erstellung und Bereitstellung von KI-Assistenten:

- Amazonas-Felsen - Amazon Bedrock ist ein vollständig gehosteter Service, der leistungsstarke Fundamentalmodelle (FMs) von führenden KI-Unternehmen wie AI21 Labs, Anthropic, Cohere, Meta, Mistral AI, Stability AI und Amazon über eine einzige API bereitstellt. und die breite Palette an Funktionen, die für die Entwicklung generativer KI-Anwendungen mit Sicherheit, Datenschutz und verantwortungsvoller KI erforderlich sind.

- Amazon Bedrock Wissensdatenbanken - Versorgen Sie KI-Assistenten mit kontextbezogenen Informationen aus den privaten Datenquellen Ihres Unternehmens.

- Amazon OpenSearch-Dienst - Native Unterstützung für Amazon Bedrock Knowledge Bases als Vektorspeicher.

- Amazon Lex - Dialogschnittstelle für die Erstellung von KI-Assistenten, einschließlich der Definition von Intentionen und Slots.

- Amazon verbinden - Die Integration in WhatsApp macht den KI-Assistenten in der beliebten Messaging-App verfügbar.

- AWS Lambda - Führen Sie den Code aus, um die Dienste zu integrieren und den LangChain-Agenten zu implementieren, der die Kernlogik des KI-Assistenten bildet.

- Amazon API-Gateway - Empfangen Sie von WhatsApp ausgelöste eingehende Anfragen und leiten Sie die Anfrage zur weiteren Verarbeitung an AWS Lambda weiter.

- Amazon DynamoDB - Speichert empfangene und generierte Nachrichten zur Unterstützung des Dialogspeichers.

- Amazon SNS - Routes, die ausgehende Antworten von Amazon Connect verarbeiten.

- LangChain - Bietet eine leistungsfähige Abstraktionsschicht für den Aufbau von LangChain-Agenten, die Foundation Models (FMs) bei der Durchführung kontextbezogener Schlussfolgerungen unterstützen.

- LangSmith - Hochladen von Agentenausführungsprotokollen in LangSmith für eine bessere Beobachtbarkeit, einschließlich Debugging, Überwachung sowie Test- und Evaluierungsfunktionen.

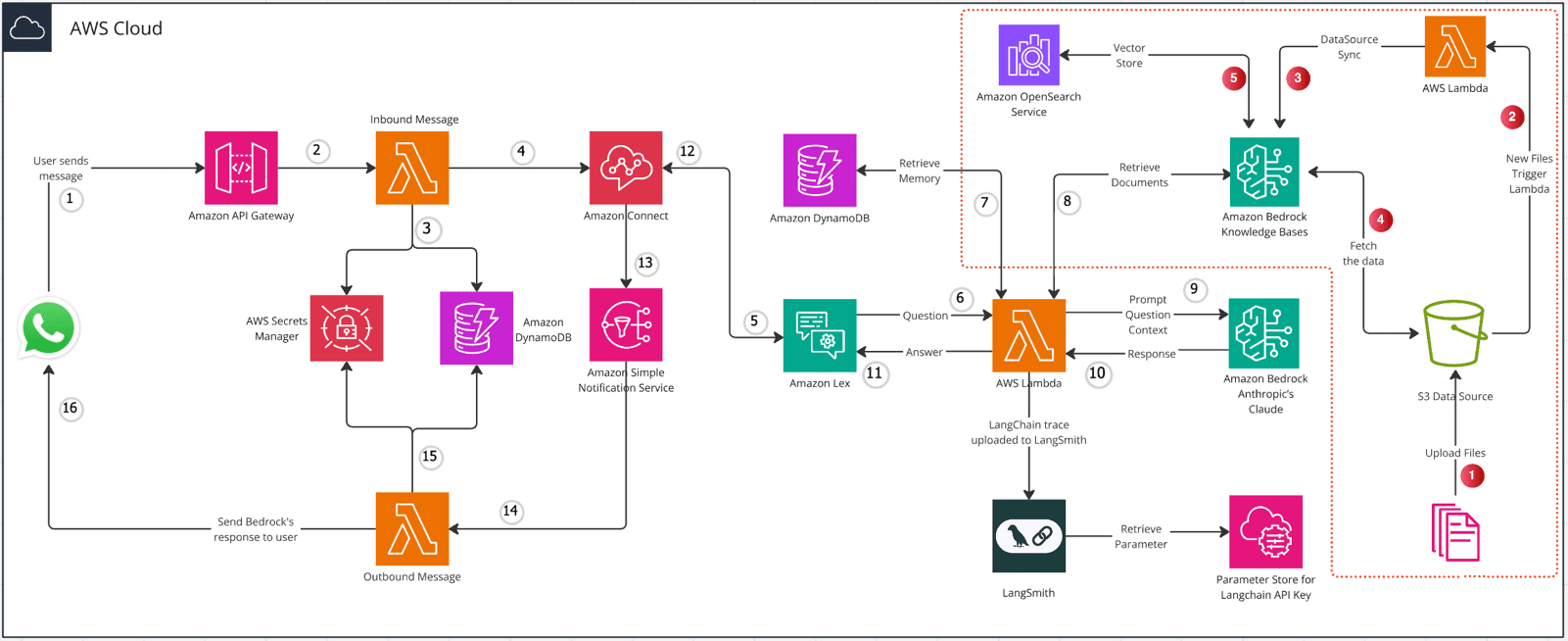

Das folgende Diagramm zeigt die Architektur.

Prozessbeschreibung

Der Prozess der Dateneingabe ist durch rote Zahlen auf der rechten Seite der Abbildung gekennzeichnet:

- Hochladen von Dateien auf Amazon Einfacher Speicherdienst (Amazon S3) Datenquelle.

- Die neue Datei löst die Lambda-Funktion aus.

- Lambda-Funktionen rufen Synchronisierungsoperationen auf Datenquellen der Wissensbasis auf.

- Amazon Bedrock Knowledge Bases übernimmt Daten aus Amazon S3, chunked sie und generiert Einbettungsvektoren aus ausgewählten Basismodellen (FMs).

- Amazon Bedrock Knowledge Bases speichert Einbettungsvektoren im Amazon OpenSearch Service.

Auf der linken Seite der Abbildung ist der Nachrichtenübermittlungsprozess mit Zahlen dargestellt:

- Der Nutzer leitet die Kommunikation ein, indem er eine Nachricht über WhatsApp an einen Webhook sendet, der irgendwo gehostet wird.

- Amazon API Gateway leitet eingehende Nachrichten an einen von AWS Lambda durchgeführten Prozessor für eingehende Nachrichten weiter.

- Der Eingangsnachrichtenprozessor befindet sich in der Amazon DynamoDB Die Kontaktinformationen des Nutzers werden in der

- Für erstmalige Benutzer erstellt der Prozessor für eingehende Nachrichten eine neue Sitzung in Amazon Connect und protokolliert sie in DynamoDB. Für wiederkehrende Benutzer wird ihre bestehende Amazon Connect-Sitzung wiederhergestellt.

- Amazon Connect leitet Benutzernachrichten zur Verarbeitung natürlicher Sprache an Amazon Lex weiter.

- Amazon Lex löst den durch Lambda-Funktionen implementierten LangChain-KI-Assistenten aus.

- Der KI-Assistent LangChain ruft den Gesprächsverlauf aus DynamoDB ab.

- Verwenden Sie Amazon Bedrock Knowledge Bases, den KI-Assistenten von LangChain, um relevante kontextbezogene Informationen zu erhalten.

- Der KI-Assistent von LangChain generiert einen Hinweis, kombiniert Kontextdaten und Benutzeranfragen und übergibt sie an das zugrunde liegende Modell, das auf Amazon Bedrock läuft.

- Amazon Bedrock verarbeitet die Eingabe und gibt die Antwort des Modells an den LangChain-KI-Assistenten zurück.

- Der KI-Assistent von LangChain gibt die Antwort des Modells an Amazon Lex zurück.

- Amazon Lex überträgt die Antwort des Modells an Amazon Connect.

- Amazon Connect veröffentlicht die Antwort des Modells auf Amazon Einfacher Benachrichtigungsdienst (Amazon SNS).

- Amazon SNS löst die Lambda-Funktion Outbound Message Processor aus.

- Der Prozessor für ausgehende Nachrichten ruft relevante Chat-Kontaktinformationen aus Amazon DynamoDB ab.

- Der Handler für ausgehende Nachrichten sendet die Antwort über die WhatsApp-API von Meta an den Benutzer.

Der Einsatz dieses KI-Assistenten umfasst drei Hauptschritte:

- Verwenden Sie Amazon Bedrock Knowledge Bases, um eine Wissensdatenbank zu erstellen und relevante Produktdokumentation, häufig gestellte Fragen (FAQs), Wissensartikel und andere nützliche Daten zu importieren, die dem AI Assistant bei der Beantwortung von Benutzerfragen helfen. Die Daten sollten die wichtigsten Anwendungsfälle und Themen abdecken, die vom KI-Assistenten unterstützt werden.

- Erstellen einer LangChain-Agent um die Logik des KI-Assistenten zu steuern. Der Agent ist in Lambda-Funktionen implementiert und verwendet eine Wissensdatenbank als primäres Werkzeug für die Informationssuche. Er wird von der bereitgestellten AWS CloudFormation-Vorlagen Automatische Bereitstellung von Agenten und anderen Ressourcen. Siehe die Liste der Ressourcen im nächsten Abschnitt.

- einrichten. Amazon Connect-Instanzen und konfigurieren WhatsApp-IntegrationDies ermöglicht es den Nutzern, mit dem KI-Assistenten über WhatsApp zu chatten, wobei eine vertraute Schnittstelle zur Verfügung steht und umfangreiche Interaktionen wie Bilder und Schaltflächen unterstützt werden. Dies ermöglicht es den Nutzern, mit dem KI-Assistenten über WhatsApp zu chatten, wobei eine vertraute Oberfläche bereitgestellt und umfangreiche Interaktionen wie Bilder und Schaltflächen unterstützt werden.Die Popularität von WhatsApp hat die Zugänglichkeit des KI-Assistenten erhöht.

Bereitstellung der Lösung

Wir bieten vorgefertigte AWS CloudFormation Vorlagen für die Bereitstellung aller Inhalte, die Sie in Ihrem AWS-Konto benötigen.

- Wenn Sie noch nicht eingeloggt sind, melden Sie sich bitte an AWS-Konsole.

- Wählen Sie eine der folgenden Möglichkeiten Stapellauf zum Öffnen des CloudFormation-Konsole und erstellen Sie einen neuen Stapel.

- Geben Sie die folgenden Parameter ein:

StackName: Benennen Sie Ihren Stapel, z.B.WhatsAppAIStackLangchainAPIKey: durch LangChain Erstellter API-Schlüssel

| Bezirk | Schaltfläche für den Einsatz | Vorlagen-URL (für die Aktualisierung eines vorhandenen Stapels auf eine neue Version) | AWS CDK-Stack (bei Bedarf anpassbar) |

|---|---|---|---|

| Nord-Virginia (us-east-1) | YML | GitHub |

- Kreuzen Sie das Kästchen an, um zu bestätigen, dass Sie eine AWS Identitäts- und Zugriffsmanagement (IAM)-Ressource, dann wählen Sie Stapel erstellen.

- Warten Sie, bis die Erstellung des Stapels abgeschlossen ist. Dies dauert etwa 10 Minuten. Wenn er fertig ist, wird Folgendes erstellt:

- LangChain-Agent

- Amazon Lex bot

- Amazon Bedrock Wissensdatenbank

- Vektorspeicher (Amazon OpenSearch Serverless)

- lambda (griechischer Buchstabe Λλ)(für Datenimport und Anbieter)

- Datenquellen (Amazon S3)

- DynamoDB

- Parameter speichern Wird zum Speichern von LangChain-API-Schlüsseln verwendet

- IAM-Rolle und Autorität

- Laden Sie die Datei in die für WhatsApp erstellte Datenquelle hoch (Amazon S3). Sobald Sie die Datei hochgeladen haben, wird die Datenquelle automatisch synchronisiert.

- Wählen Sie in der Amazon Lex-Konsole den zuletzt erstellten Assistenten zum Testen aus. Wählen Sie Englischund wählen Sie dann Test und senden Sie eine Nachricht.

Erstellen einer Amazon Connect-Instanz und Integrieren von WhatsApp

Konfigurieren Sie Amazon Connect für die Integration mit Ihrem WhatsApp-Unternehmenskonto und aktivieren Sie den WhatsApp-Kanal für AI Assistant:

- existieren Amazon Connect in der AWS-Konsole Navigieren in der Erstellen Sie eine Instanz, falls Sie dies noch nicht getan haben. Erstellen Sie eine Instanz im Bereich Einstellungen für die Verteilung Kopieren Sie Ihr Instanz ARNDiese Informationen werden später benötigt, um Ihr WhatsApp-Geschäftskonto zu verknüpfen. Diese Informationen werden später benötigt, um Ihr WhatsApp-Business-Konto zu verknüpfen.

- Wählen Sie Ihre Instanz aus, und wählen Sie dann im Navigationsbereich Strömungen. Blättern Sie nach unten und wählen Sie Amazon Lex. Wählen Sie Ihren Roboter und wählen Sie Amazon Lex Bot hinzufügen.

- Wählen Sie im Navigationsbereich Übersicht. Unter Informationen zum Zugang untere Option Anmelden für den Zugang im Notfall.

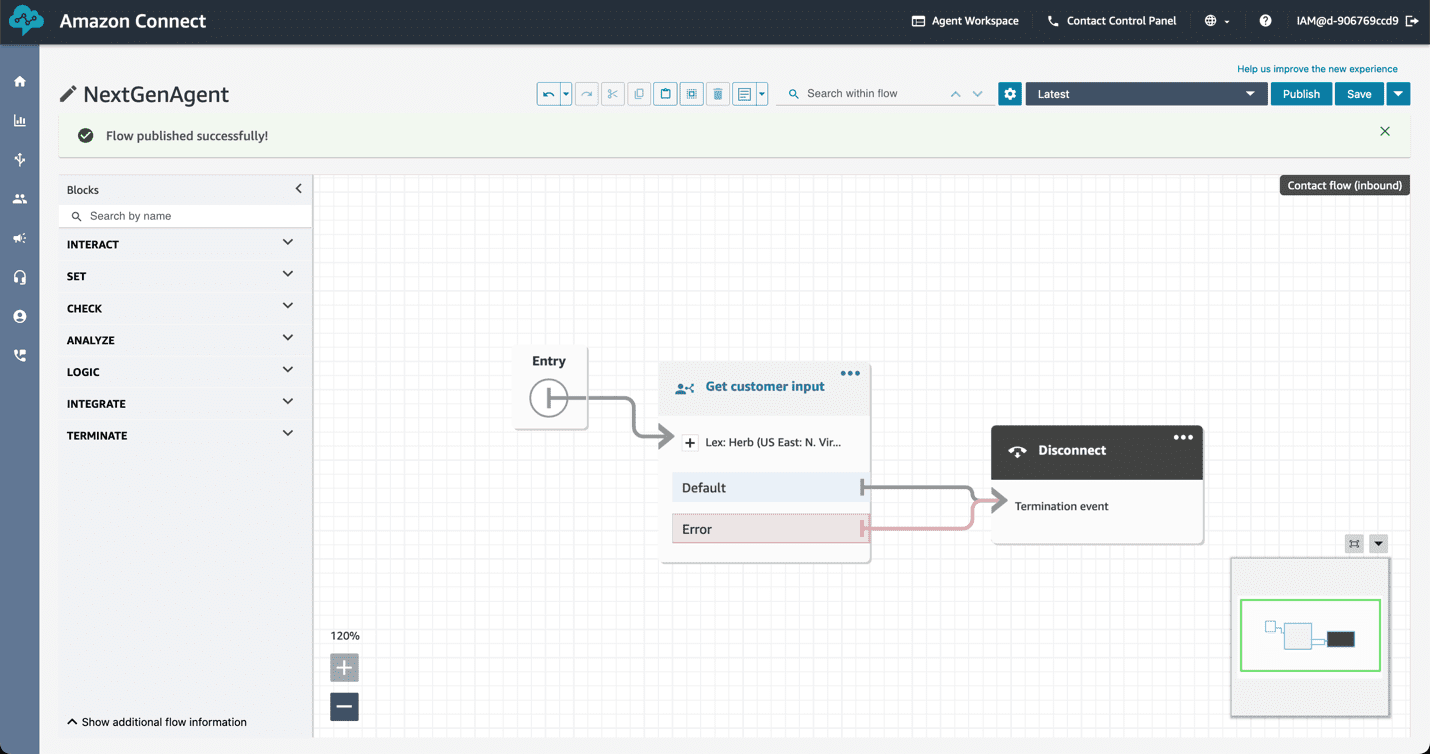

- In der Amazon Connect-Konsole können Sie im Navigationsbereich der Weiterleitung untere Option Strömungen. Auswahl Fluss erzeugen. Setzen Sie eine der folgenden Möglichkeiten ein Anregungen von Kunden einholen Ziehen Sie den Block in den Prozess. Wählen Sie den Block aus. Wählen Sie den Text-to-Speech oder Chat-Text und fügen Sie eine einleitende Nachricht hinzu, z. B. "Hallo, was kann ich für Sie tun?" Scrollen Sie nach unten und wählen Sie Amazon LexWählen Sie dann den Amazon Lex-Bot aus, den Sie in Schritt 2 erstellt haben.

- Nachdem Sie den Block gespeichert haben, fügen Sie einen weiteren Block mit dem Namen "Disconnect" hinzu. Platzieren Sie den Eintrag Die Pfeile verbinden sich mit den Anregungen von Kunden einholenund wird Anregungen von Kunden einholen Die Pfeile verbinden sich mit den Trennen Sie die Verbindung. Auswahl veröffentlichen..

- Wählen Sie nach der Veröffentlichung unten im Navigationsbereich Zusätzliche Flussinformationen anzeigen. Kopieren Sie den Amazon Resource Name (ARN) des Prozesses. Sie benötigen diese Informationen später für die Bereitstellung der WhatsApp-Integration. Der folgende Screenshot zeigt den Ablauf in der Amazon Connect-Konsole.

- Boden Bieten Sie WhatsApp-Nachrichten als Kanal über Amazon Connect an Implementieren Sie WhatsApp-Integrationen mit den Details in.

Test-Lösungen

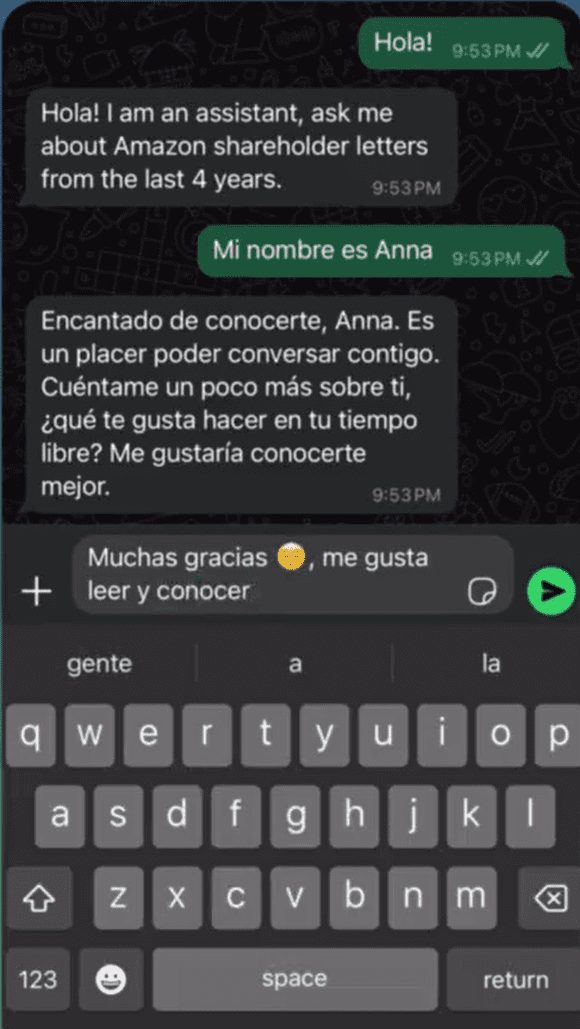

Interagieren Sie mit dem KI-Assistenten über WhatsApp, wie unten gezeigt:

aufräumen

Um laufende Kosten zu vermeiden, löschen Sie Ressourcen, wenn Sie sie nicht mehr benötigen:

- Löschen Sie den CloudFormation-Stack.

- Löschen Sie eine Amazon Connect-Instanz.

Zusammenfassungen

Dieser Artikel beschreibt, wie man die Amazonas-FelsenundAmazon Lex im Gesang antworten Amazon verbinden Erstellen Sie einen intelligenten KI-Assistenten für Konversationen und stellen Sie ihn für die WhatsApp.

Die Lösung importiert relevante Daten in Amazon Bedrock Wissensdatenbanken Wissensdatenbank, mit LangChain-Agent Realisierung, Beantwortung von Fragen durch die Wissensbasis und durch die WhatsApp Bieten Sie den Nutzern eine Zugangsschnittstelle. Diese Lösung bietet einen zugänglichen, intelligenten KI-Assistenten, der die Nutzer durch die Produkte und Dienstleistungen Ihres Unternehmens führt.

Mögliche nächste Schritte sind die Anpassung des KI-Assistenten an spezifische Anwendungsfälle, die Erweiterung der Wissensbasis und die Nutzung der LangSmith Analysieren Sie Dialogprotokolle, um Probleme zu erkennen, Fehler zu verbessern und Leistungsengpässe in FM-Aufrufsequenzen zu beseitigen.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...