Hands-on: Erstellung leistungsstarker multimodaler Suchanfragen mit Voyager-3 und LangGraph

Voyager 3 von Voyage AI ist ein neues, hochmodernes Modell, mit dem Sie Text und Bilder in denselben Raum einbetten können. In diesem Beitrag erkläre ich, wie man diese multimodalen Einbettungen aus Zeitschriften extrahiert, sie in einer Vektordatenbank (Weaviate) speichert und Ähnlichkeitssuchen für Text und Bilder mit denselben Einbettungsvektoren durchführt.

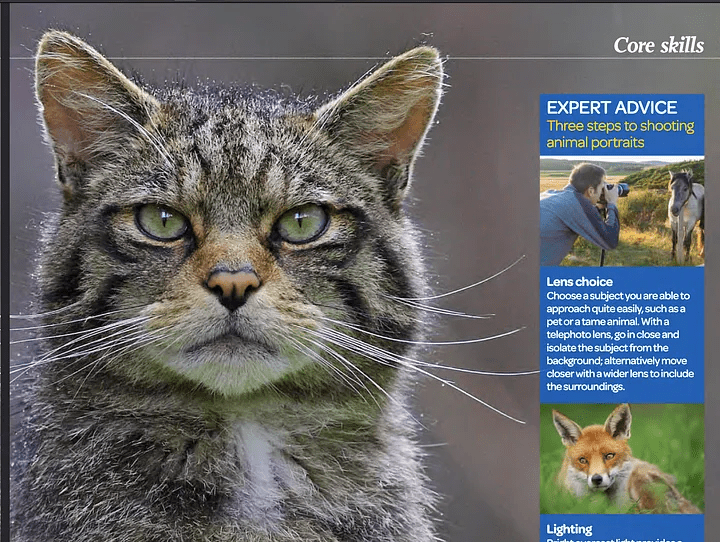

Die Einbettung von Bildern und Text in denselben Raum wird es uns ermöglichen, hochpräzise Suchvorgänge in multimodalen Inhalten wie Webseiten, PDF-Dateien, Zeitschriften, Büchern, Broschüren und verschiedenen Dokumenten durchzuführen. Warum ist diese Technik so interessant? Das Spannende an der Einbettung von Text und Bildern in denselben Raum ist, dass man einen Text mit Bezug zu einem bestimmten Bild suchen und abrufen kann und umgekehrt. Wenn Sie z. B. nach Katzen suchen, finden Sie Bilder, auf denen Katzen zu sehen sind, aber Sie erhalten auch Text, der sich auf diese Bilder bezieht, selbst wenn das Wort "Katze" im Text nicht ausdrücklich erwähnt wird.

Lassen Sie mich den Unterschied zwischen der traditionellen Ähnlichkeitssuche bei der Texteinbettung und dem multimodalen Einbettungsraum aufzeigen:

BEISPIELFRAGE: Was steht in der Zeitschrift über Katzen?

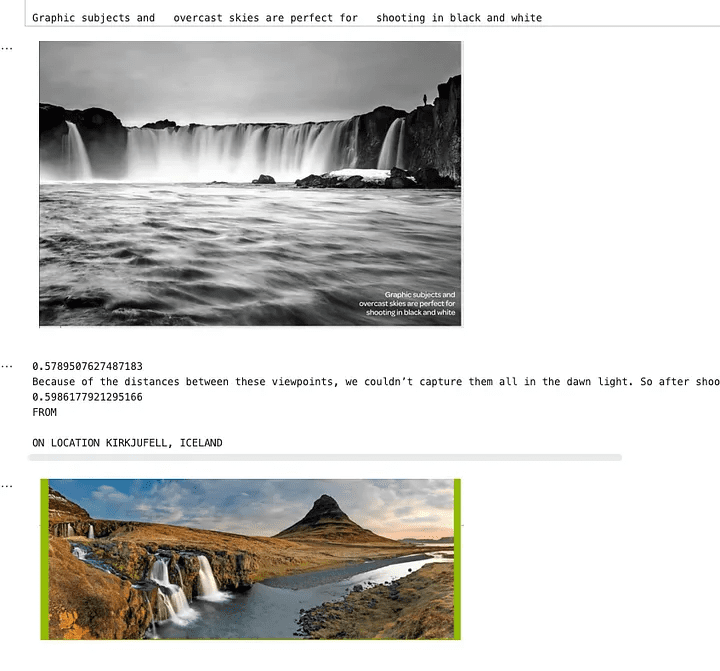

Ein Screenshot aus einer Fotozeitschrift - OUTDOOR

Regelmäßige Antworten auf die Ähnlichkeitssuche

Die angebotenen Suchergebnisse enthalten keine spezifischen Informationen über Katzen. Sie erwähnen Tierporträts und Fototechniken, aber nicht explizit Katzen oder Details zu ihnen.

Wie oben dargestellt, wird das Wort "Katze" nicht erwähnt; es gibt nur ein Bild und eine Erklärung, wie man das Tier fotografiert. Da das Wort "Katze" nicht erwähnt wurde, ergab eine normale Ähnlichkeitssuche keine Ergebnisse.

Multimodale Suche nach Antworten

Dieses Magazin zeigt das Porträt einer Katze und hebt die feine Erfassung ihrer Gesichtszüge und ihres Charakters hervor. Der Text unterstreicht, wie gut gemachte Tierporträts die Seele des Porträtierten erreichen und eine emotionale Verbindung mit dem Betrachter durch überzeugenden Augenkontakt herstellen.

Mithilfe der multimodalen Suche werden wir ein Bild einer Katze finden und dann den entsprechenden Text damit verknüpfen. Wenn diese Daten dem Modell zur Verfügung gestellt werden, kann es besser antworten und den Kontext verstehen.

Wie man eine multimodale Einbettungs- und Abrufpipeline aufbaut

Ich werde nun in einigen Schritten beschreiben, wie eine solche Pipeline funktioniert:

- Wir werden die Unstrukturiert(eine leistungsstarke Python-Bibliothek zur Datenextraktion) Extrahiert Text und Bilder aus PDF-Dateien.

- Wir werden die Voyager Multimodal 3 Das Modell erstellt multimodale Vektoren für Text und Bilder im gleichen Vektorraum.

- Wir fügen sie in den Vektorspeicher ein (Weaviate) in.

- Schließlich führen wir eine Ähnlichkeitssuche durch und vergleichen die Ergebnisse von Text und Bild.

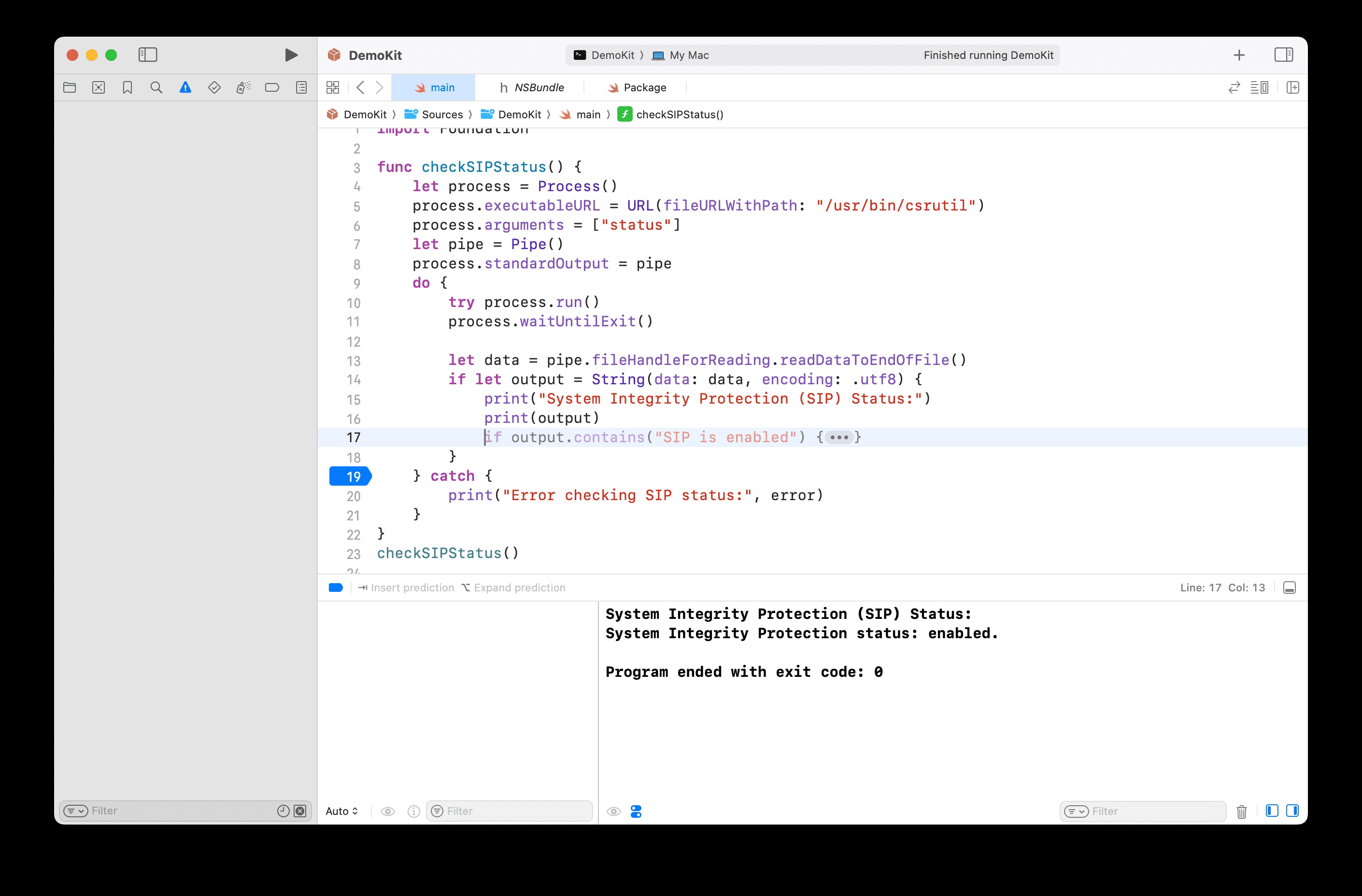

Schritt 1: Einrichten der Vektorspeicherung und Extraktion von Bildern und Text aus dem Dokument (PDF)

Hier müssen wir etwas manuelle Arbeit leisten. Normalerweise ist Weaviate ein sehr einfach zu bedienender Vektorspeicher, der die Daten automatisch umwandelt und Einbettungen beim Einfügen hinzufügt. Für Voyager Multimodal v3 gibt es jedoch kein Plugin, so dass wir die Einbettungen manuell berechnen müssen.In diesem Fall müssen wir eine Sammlung erstellen, ohne ein Vektormodul zu definieren.

import weaviate

from weaviate.classes.config import Configure

client = weaviate.connect_to_local()

collection_name = "multimodal_demo"

client.collections.delete(collection_name)

try:

client.collections.create(

name=collection_name,

vectorizer_config=Configure.Vectorizer.none() # 不为此集合设置向量化器

)

collection = client.collections.get(collection_name)

except Exception:

collection = client.collections.get(collection_name)pyt

Hier führe ich eine lokale Weaviate-Instanz in einem Docker-Container aus.

Schritt 2:Extrahieren von Dokumenten und Bildern aus PDF

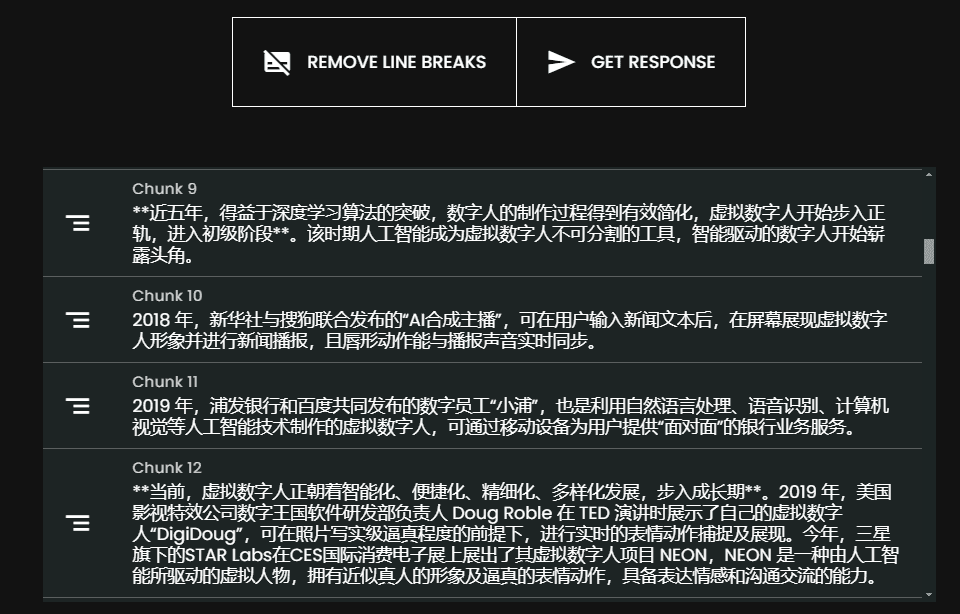

Dies ist ein wichtiger Schritt in der Arbeitsweise des Prozesses. Hier erhalten wir eine PDF-Datei, die Text und Bilder enthält. Dann extrahieren wir den Inhalt (Bilder und Text) und speichern ihn in entsprechenden Blöcken. Jeder Block wird also eine PDF-Datei sein, die Zeichenketten (eigentlichen Text) und Python PIL-Bilder Die Liste der Elemente der Datei

Wir werden die Unstrukturiert Bibliothek, um einen Teil der schweren Arbeit zu erledigen, aber wir müssen noch etwas Logik schreiben und Bibliotheksparameter konfigurieren.

from unstructured.partition.auto import partition

from unstructured.chunking.title import chunk_by_title

elements = partition(

filename="./files/magazine_sample.pdf",

strategy="hi_res",

extract_image_block_types=["Image", "Table"],

extract_image_block_to_payload=True)

chunks = chunk_by_title(elements)

Hier müssen wir die hi_res Strategie und verwenden die extract_image_block_to_payload Exportieren Sie das Bild als Nutzdaten, da wir diese Informationen später für die eigentliche Einbettung benötigen. Sobald wir alle Elemente extrahiert haben, gruppieren wir sie in Blöcke, die auf den Titeln im Dokument basieren.

Weitere Informationen finden Sie unter Unstrukturierte Dokumentation über Chunking.

Im folgenden Skript werden wir diese Blöcke verwenden, um zwei Listen auszugeben:

- Eine Liste mit den Objekten, die wir an Voyager 3 senden werden, um den Vektor zu erstellen

- Eine Liste mit den von Unstructured extrahierten Metadaten. Diese Metadaten sind erforderlich, weil wir sie dem Vektorspeicher hinzufügen müssen. Sie liefern uns zusätzliche Attribute, nach denen wir filtern können, und sagen uns etwas über die abgerufenen Daten.

from unstructured.staging.base import elements_from_base64_gzipped_json

import PIL.Image

import io

import base64

embedding_objects = []

embedding_metadatas = []

for chunk in chunks:

embedding_object = []

metedata_dict = {

"text": chunk.to_dict()["text"],

"filename": chunk.to_dict()["metadata"]["filename"],

"page_number": chunk.to_dict()["metadata"]["page_number"],

"last_modified": chunk.to_dict()["metadata"]["last_modified"],

"languages": chunk.to_dict()["metadata"]["languages"],

"filetype": chunk.to_dict()["metadata"]["filetype"]

}

embedding_object.append(chunk.to_dict()["text"])

# 将图像添加到嵌入对象

if "orig_elements" in chunk.to_dict()["metadata"]:

base64_elements_str = chunk.to_dict()["metadata"]["orig_elements"]

eles = elements_from_base64_gzipped_json(base64_elements_str)

image_data = []

for ele in eles:

if ele.to_dict()["type"] == "Image":

base64_image = ele.to_dict()["metadata"]["image_base64"]

image_data.append(base64_image)

pil_image = PIL.Image.open(io.BytesIO(base64.b64decode(base64_image)))

# 如果图像大于 1000x1000,则在保持纵横比的同时调整图像大小

if pil_image.size[0] > 1000 or pil_image.size[1] > 1000:

ratio = min(1000/pil_image.size[0], 1000/pil_image.size[1])

new_size = (int(pil_image.size[0] * ratio), int(pil_image.size[1] * ratio))

pil_image = pil_image.resize(new_size, PIL.Image.Resampling.LANCZOS)

embedding_object.append(pil_image)

metedata_dict["image_data"] = image_data

embedding_objects.append(embedding_object)

embedding_metadatas.append(metedata_dict)

Das Ergebnis dieses Skripts ist eine Liste von Listen, deren Inhalt im Folgenden dargestellt wird:

[['来自\n\n冰岛 KIRKJUFELL 的位置',

<PIL.Image.Image image mode=RGB size=1000x381>,

<PIL.Image.Image image mode=RGB size=526x1000>],

['这座标志性的山峰是我们冰岛拍摄地点的首选,而且在我们去那里之前,我们就看过许多从附近瀑布拍摄的照片。因此,这是我们在日出时前往的第一个地方 - 我们没有失望。这些瀑布为这张照片(顶部)提供了完美的近景趣味,而从这个角度来看,Kirkjufell 是一座完美的尖山。我们花了一两个小时简单地探索这些瀑布,找到了几个不同的角度。']]

Schritt 3: Vektorisierung der extrahierten Daten

In diesem Schritt verwenden wir den im vorherigen Schritt erstellten Block mit der Voyager-Python-Pakete Senden Sie sie an Voyager, der uns eine Liste aller eingebetteten Objekte zurückgibt. Dieses Ergebnis können wir dann verwenden und schließlich in Weaviate speichern.

from dotenv import load_dotenv

import voyageai

load_dotenv()

vo = voyageai.Client()

# 这将自动使用环境变量 VOYAGE_API_KEY。

# 或者,您可以使用 vo = voyageai.Client(api_key="<您的密钥>")

# 包含文本字符串和 PIL 图像对象的示例输入

inputs = embedding_objects

# 向量化输入

result = vo.multimodal_embed(

inputs,

model="voyage-multimodal-3",

truncation=False

)

Wenn wir auf result.embeddings zugreifen, erhalten wir eine Liste mit allen berechneten Einbettungsvektoren:

[[-0.052734375, -0.0164794921875, 0.050048828125, 0.01348876953125, -0.048095703125, ...]]Wir können nun die batch.add_object Methode speichert diese eingebetteten Daten in Weaviate als einen einzigen Stapel. Beachten Sie, dass wir dem Parameter properties auch Metadaten hinzugefügt haben.

with collection.batch.dynamic() as batch:

for i, data_row in enumerate(embedding_objects):

batch.add_object(

properties=embedding_metadatas[i],

vector=result.embeddings[i]

)

Schritt 4: Abfrage der Daten

Wir können nun eine Ähnlichkeitssuche durchführen und die Daten abfragen. Das ist einfach, denn der Prozess ähnelt einer normalen Ähnlichkeitssuche, die für eine Texteinbettung durchgeführt wird. Da Weaviate nicht über ein Modul für Voyager Multimodal verfügt, müssen wir den Suchanfragevektor selbst berechnen, bevor wir ihn an Weaviate zur Durchführung einer Ähnlichkeitssuche weitergeben.

from weaviate.classes.query import MetadataQuery

question = "杂志上关于瀑布说了什么?"

vector = vo.multimodal_embed([[question]], model="voyage-multimodal-3")

vector.embeddings[0]

response = collection.query.near_vector(

near_vector=vector.embeddings[0], # 您的查询向量在此处

limit=2,

return_metadata=MetadataQuery(distance=True)

)

# 显示结果

for o in response.objects:

print(o.properties['text'])

for image_data in o.properties['image_data']:

# 使用 PIL 显示图像

img = PIL.Image.open(io.BytesIO(base64.b64decode(image_data)))

width, height = img.size

if width > 500 or height > 500:

ratio = min(500/width, 500/height)

new_size = (int(width * ratio), int(height * ratio))

img = img.resize(new_size)

display(img)

print(o.metadata.distance)

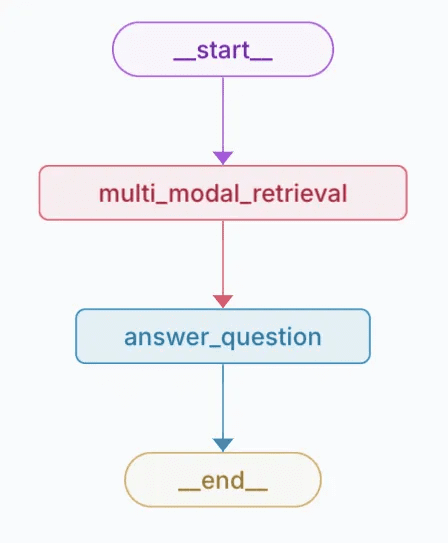

Die folgende Abbildung zeigt, dass eine Suche nach Wasserfällen Text und Bilder zurückgibt, die für diese Suchanfrage relevant sind. Wie Sie sehen können, spiegeln die Fotos Wasserfälle wider, aber der Text selbst erwähnt sie nicht. Der Text bezieht sich auf ein Bild, auf dem ein Wasserfall zu sehen ist, weshalb er auch abgerufen wurde. Dies ist bei einer normalen Suche mit Texteinbettung nicht möglich.

Ein Bild mit Ergebnissen der Ähnlichkeitssuche

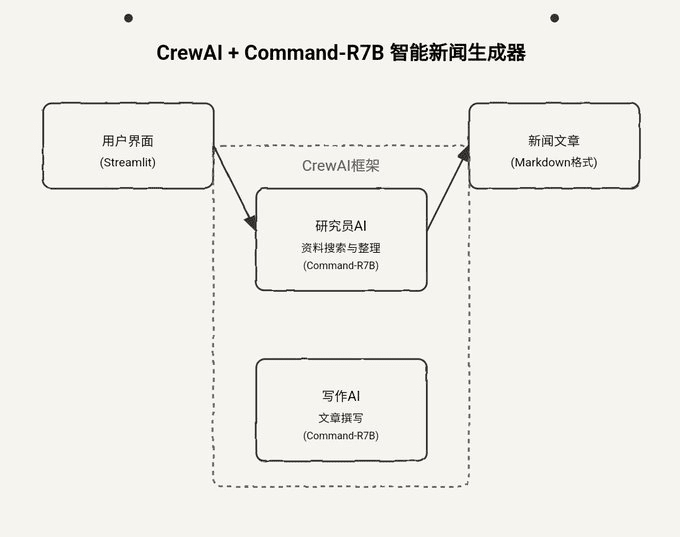

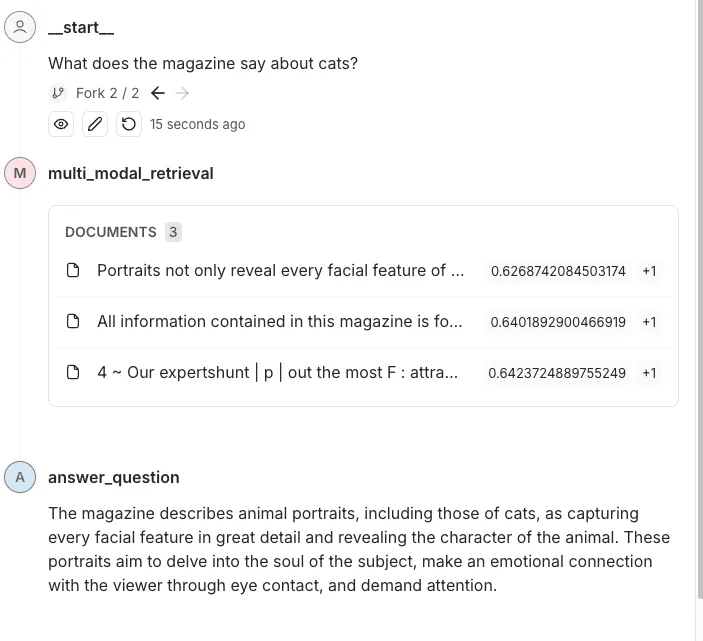

Schritt 5: Hinzufügen zur gesamten Suchpipeline

Nachdem wir nun den Text und die Bilder aus der Zeitschrift extrahiert, Einbettungen für sie erstellt, sie zu Weaviate hinzugefügt und unsere Ähnlichkeitssuche eingerichtet haben, füge ich sie der gesamten Retrieval-Pipeline hinzu. In diesem Beispiel verwende ich LangGraph. Der Benutzer stellt eine Frage zu dieser Zeitschrift, und die Pipeline beantwortet diese Frage. Nun, da die ganze Arbeit getan ist, ist dieser Teil so einfach wie das Einrichten einer typischen Retrieval-Pipeline mit normalem Text.

Ich habe einen Teil der Logik, die wir im vorherigen Abschnitt besprochen haben, in andere Module abstrahiert. Hier ist, wie ich sie in das LangGraph Beispiele in der Pipeline.

class MultiModalRetrievalState(TypedDict):

messages: Annotated[Sequence[BaseMessage], add_messages]

results: List[Document]

base_64_images: List[str]

class RAGNodes(BaseNodes):

def __init__(self, logger, mode="online", document_handler=None):

super().__init__(logger, mode)

self.weaviate = Weaviate()

self.mode = mode

async def multi_modal_retrieval(self, state: MultiModalRetrievalState, config):

collection_name = config.get("configurable", {}).get("collection_name")

self.weaviate.set_collection(collection_name)

print("正在运行多模态检索")

print(f"正在搜索 {state['messages'][-1].content}")

results = self.weaviate.similarity_search(

query=state["messages"][-1].content, k=3, type="multimodal"

)

return {"results": results}

async def answer_question(self, state: MultiModalRetrievalState, config):

print("正在回答问题")

llm = self.llm_factory.create_llm(mode=self.mode, model_type="default")

include_images = config.get("configurable", {}).get("include_images", False)

chain = self.chain_factory.create_multi_modal_chain(

llm,

state["messages"][-1].content,

state["results"],

include_images=include_images,

)

response = await chain.ainvoke({})

message = AIMessage(content=response)

return {"messages": message}

# 定义配置

class GraphConfig(TypedDict):

mode: str = "online"

collection_name: str

include_images: bool = False

graph_nodes = RAGNodes(logger)

graph = StateGraph(MultiModalRetrievalState, config_schema=GraphConfig)

graph.add_node("multi_modal_retrieval", graph_nodes.multi_modal_retrieval)

graph.add_node("answer_question", graph_nodes.answer_question)

graph.add_edge(START, "multi_modal_retrieval")

graph.add_edge("multi_modal_retrieval", "answer_question")

graph.add_edge("answer_question", END)

multi_modal_graph = graph.compile()

__all__ = ["multi_modal_graph"]

Der obige Code erzeugt das folgende Diagramm

Visuelle Darstellung der erstellten Diagramme

In dieser Spur wird dieSie können die Inhalte und Bilder sehen, die an OpenAI gesendet werden, um Fragen zu beantworten.

zu einem Urteil gelangen

Die multimodale Einbettung eröffnet die Möglichkeit, Informationen aus verschiedenen Datentypen (z. B. Text und Bilder) innerhalb desselben Einbettungsraums zu integrieren und abzurufen. Durch die Kombination modernster Tools wie dem Voyager Multimodal 3-Modell, Weaviate und LangGraph zeigen wir, wie eine robuste Retrieval-Pipeline aufgebaut werden kann, die Inhalte intuitiver versteht und verknüpft als traditionelle reine Textansätze.

Dieser Ansatz verbessert die Such- und Abrufgenauigkeit für eine Vielzahl von Datenquellen wie Zeitschriften, Broschüren und PDFs erheblich. Außerdem wird gezeigt, wie die multimodale Einbettung umfassendere, kontextbezogene Erkenntnisse liefern kann, die Bilder mit beschreibendem Text verknüpfen, selbst wenn keine expliziten Schlüsselwörter vorhanden sind. In diesem Tutorial können Sie diese Techniken erkunden und auf Ihre Projekte anwenden.

Beispiel Notebook: https://github.com/vectrix-ai/vectrix-graphs/blob/main/examples/multi-model-embeddings.ipynb

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...