Qwen2.5-Max auf Basis der MoE-Architektur übertrifft DeepSeek V3 vollständig

Modell-Übersicht

In den letzten Jahren hat sich das Training großer Modelle auf der Grundlage der Mixture of Experts (MoE)-Architektur zu einer wichtigen Forschungsrichtung im Bereich der künstlichen Intelligenz entwickelt. Das Qwen-Team hat vor kurzem das Qwen2.5-Max-Modell veröffentlicht, das mehr als 20 Billionen Token an Pre-Trainingsdaten und ein verfeinertes Post-Trainingsschema verwendet und einen Durchbruch bei der skalierbaren Anwendung der MoE-Architektur erzielt hat. Fortschritte. Das Modell ist jetzt verfügbar überAPI-SchnittstellevielleichtQwen-SchmätzerPlattform für diese Erfahrung.

Technische Merkmale

1 Innovationen in der Modellarchitektur

- Hybride Expertensystem-OptimierungEffiziente Zuweisung von Rechenressourcen durch dynamische Routing-Mechanismen

- Multimodale SkalierbarkeitUnterstützt mehrere Arten von Eingaben und Ausgaben wie Text, strukturierte Daten usw.

- Verbesserung der KontextualisierungMaximale Eingabe: 30.720 Token, kann Fließtext mit bis zu 8.192 Token erzeugen.

2. funktionale Kernmatrix

| funktionale Dimension | Technische Indikatoren |

|---|---|

| Unterstützung mehrerer Sprachen | Abdeckung von 29 Sprachen (einschließlich Chinesisch/Englisch/Französisch/Spanisch, etc.) |

| rechnerische Fähigkeiten | Komplexe mathematische Operationen und Codegenerierung |

| Strukturierte Verarbeitung | Generierung und Analyse von JSON-/Tabellendaten |

| kontextuelles Verständnis | Generierung von 8K-Tokens langer Textverkettung |

| Anwendungstauglichkeit | Dialogsysteme/Datenanalyse/Wissensbasierte Argumentation |

Leistungsbewertung

Vergleich der Befehlsmodelle

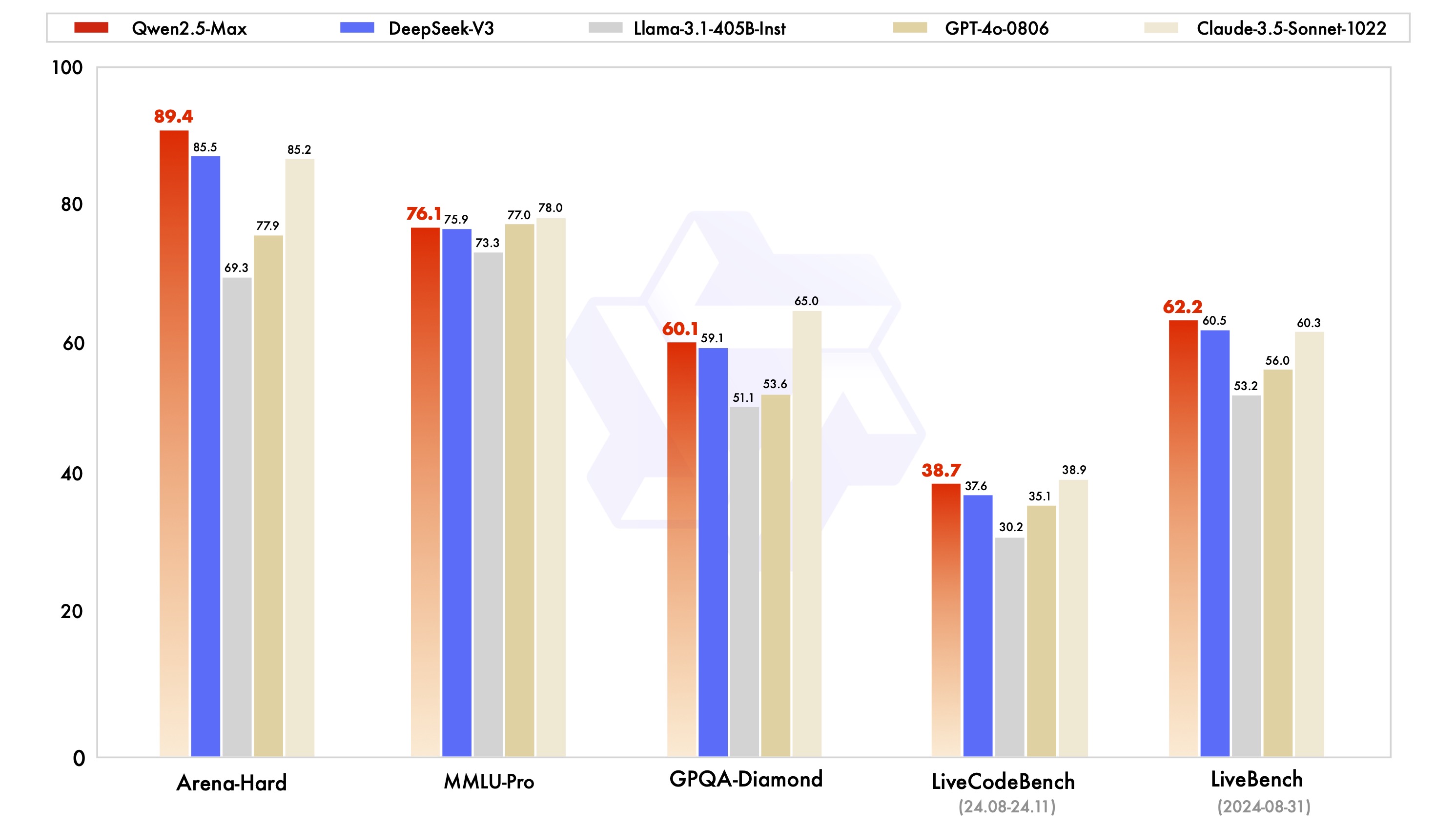

Qwen2.5-Max zeigte sich in Benchmark-Tests wie MMLU-Pro (University Knowledge Test), LiveCodeBench (Programming Ability Assessment) und Arena-Hard (Human Preference Simulation) sehr konkurrenzfähig:

Die Testdaten zeigen, dass das Modell DeepSeek V3 in den Dimensionen Programmierfähigkeit (LiveCodeBench) und integriertes schlussfolgerndes Denken (LiveBench) übertrifft und im GPQA-Diamond-Test zum schlussfolgernden Denken die höchste Stufe erreicht.

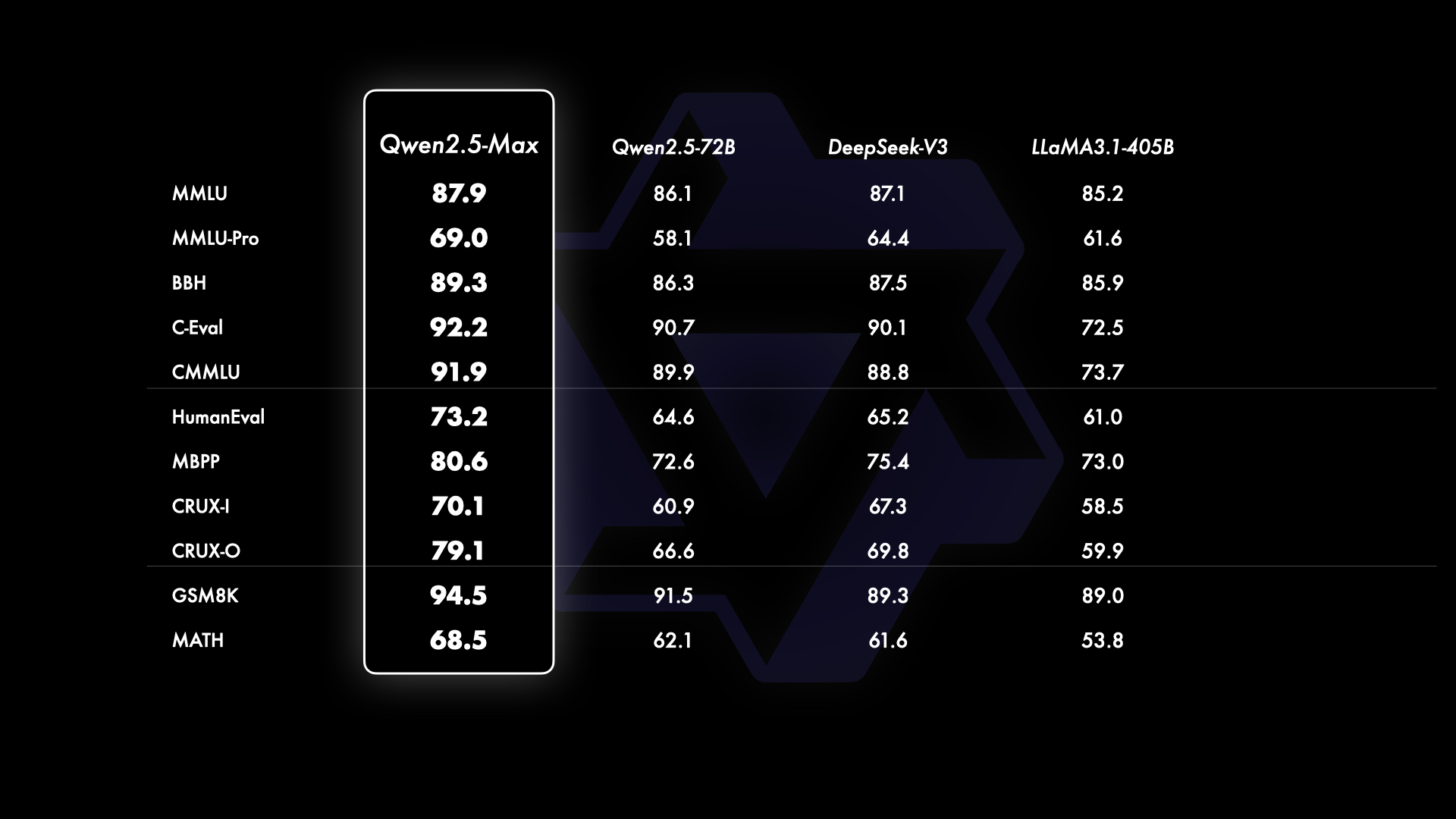

Vergleich der Basismodelle

Im Vergleich zu den gängigen Open-Source-Modellen weist Qwen2.5-Max technische Vorteile auf der Ebene der Basisfunktionen auf:

Beim Vergleich von Llama-3.1 mit einer Parameterskala von 405B und Qwen2.5-72B mit 720B Parametern behält Qwen2.5-Max bei den meisten Testaufgaben die Nase vorn, was die Wirksamkeit der MoE-Architektur bei der Modellskalierung bestätigt.

Zugang und Nutzung

1) Cloud-API-Zugang

from openai import OpenAI

import os

client = OpenAI(

api_key=os.getenv("API_KEY"),

base_url="https://dashscale.aliyuncs.com/compatible-mode/v1",

)

response = client.chat.completions.create(

model="qwen-max-2025-01-25",

messages=[

{'role':'system', 'content':'设定AI助手角色'},

{'role':'user', 'content':'输入查询内容'}

]

)

2. interaktive Erfahrung

- InterviewsUmarmung Gesicht Demo Raum

- Starten der Schaltfläche Ausführen zum Laden des Modells

- Interaktion in Echtzeit über ein Texteingabefeld

3. unternehmensweiter Einsatz

- EinschreibungAliyun-Konto

- Einführung einer großen Modell-Serviceplattform

- API-Schlüssel für die Systemintegration erstellen

Richtung der technologischen Entwicklung

Die aktuelle Version wird in den folgenden Bereichen kontinuierlich optimiert:

- Strategien zur Verbesserung der Datenqualität nach der Schulung

- Expertenübergreifende Zusammenarbeit zur Optimierung der Effizienz

- Geringer Ressourcenverbrauch Reasoning-Beschleunigung

- Multimodale erweiterte Schnittstellenentwicklung

Zukunftsaussichten

Die kontinuierliche Verbesserung der Daten- und Modellparameterskala kann das Intelligenzniveau des Modells effektiv verbessern. Als Nächstes werden wir weiter erforschen, zusätzlich zur Skalierung des Pre-Trainings werden wir energisch in die Skalierung des Verstärkungslernens investieren, in der Hoffnung, eine Intelligenz zu erreichen, die über die des Menschen hinausgeht, und die KI zur Erforschung des unbekannten Bereichs voranzutreiben.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...