Promptimizer: eine experimentelle Bibliothek zur Optimierung großer Modell-Prompt-Wörter, die Prompt automatisch optimiert

Allgemeine Einführung

Promptimizer ist eine experimentelle Bibliothek zur Optimierung von Stichwortwörtern, die Benutzern helfen soll, die Stichwortwörter ihrer KI-Systeme systematisch zu verbessern. Durch die Automatisierung des Optimierungsprozesses kann Promptimizer die Leistung von Cue Words bei bestimmten Aufgaben verbessern. Benutzer stellen einfach ein anfängliches Stichwort, einen Datensatz und einen benutzerdefinierten Evaluator (mit optionalem menschlichem Feedback) zur Verfügung, und Promptimizer führt eine Optimierungsschleife durch, die ein optimiertes Stichwort erzeugt, das das ursprüngliche Stichwort übertrifft.

Funktionsliste

- Stichwortoptimierung: automatische Optimierung von Stichwörtern, um die Leistung des KI-Systems bei bestimmten Aufgaben zu verbessern.

- Unterstützung von Datensätzen: Unterstützt mehrere Datensatzformate zur benutzerfreundlichen Optimierung von Stichwörtern.

- Benutzerdefinierte Bewerter: Benutzer können benutzerdefinierte Bewerter definieren, um die Leistung von Stichwörtern zu quantifizieren.

- Menschliches Feedback: Menschliches Feedback wird unterstützt, um die Schlagwortoptimierung weiter zu verbessern.

- Schnellstartanleitung: Eine ausführliche Schnellstartanleitung hilft den Anwendern, schnell loszulegen.

Hilfe verwenden

Montage

- Installieren Sie zunächst das CLI-Tool:

pip install -U promptim - Stellen Sie sicher, dass Sie einen gültigen LangSmith API-Schlüssel in Ihrer Umgebung haben:

export LANGSMITH_API_KEY=你的API_KEY export ANTHROPIC_API_KEY=你的API_KEY

Aufgaben erstellen

- Erstellen Sie eine Optimierungsaufgabe:

promptim create task ./my-tweet-task \ --name my-tweet-task \ --prompt langchain-ai/tweet-generator-example-with-nothing:starter \ --dataset https://smith.langchain.com/public/6ed521df-c0d8-42b7-a0db-48dd73a0c680/d \ --description "Write informative tweets on any subject." \ -yMit diesem Befehl wird ein Verzeichnis erzeugt, das die Aufgabenkonfigurationsdatei und den Aufgabencode enthält.

Definition des Evaluators

- Öffnen Sie das generierte Aufgabenverzeichnis im

task.pyDatei, um den Abschnitt mit der Auswertungslogik zu finden:score = len(str(predicted.content)) < 180 - Änderung der Bewertungslogik, z. B. Bestrafung von Ausgaben, die Etiketten enthalten:

score = int("#" not in result)

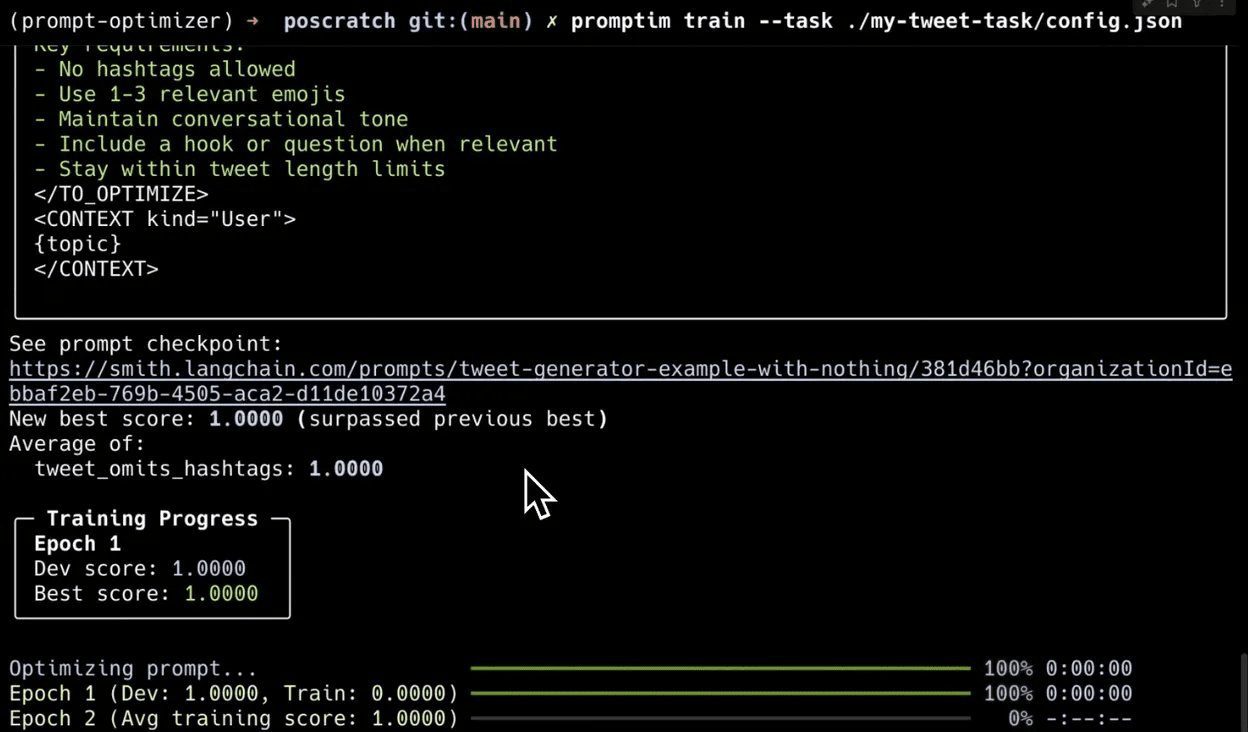

Zug

- Führen Sie den Trainingsbefehl aus, um die Optimierung des Stichworts zu starten:

promptim train --task ./my-tweet-task/config.jsonSobald das Training abgeschlossen ist, gibt das Terminal das endgültige optimierte Stichwort aus.

Manuelle Tags hinzufügen

- Richten Sie die Anmerkungswarteschlange ein:

promptim train --task ./my-tweet-task/config.json --annotation-queue my_queue - Rufen Sie die LangSmith-Benutzeroberfläche auf und navigieren Sie zu der für die manuelle Beschriftung vorgesehenen Warteschlange.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...