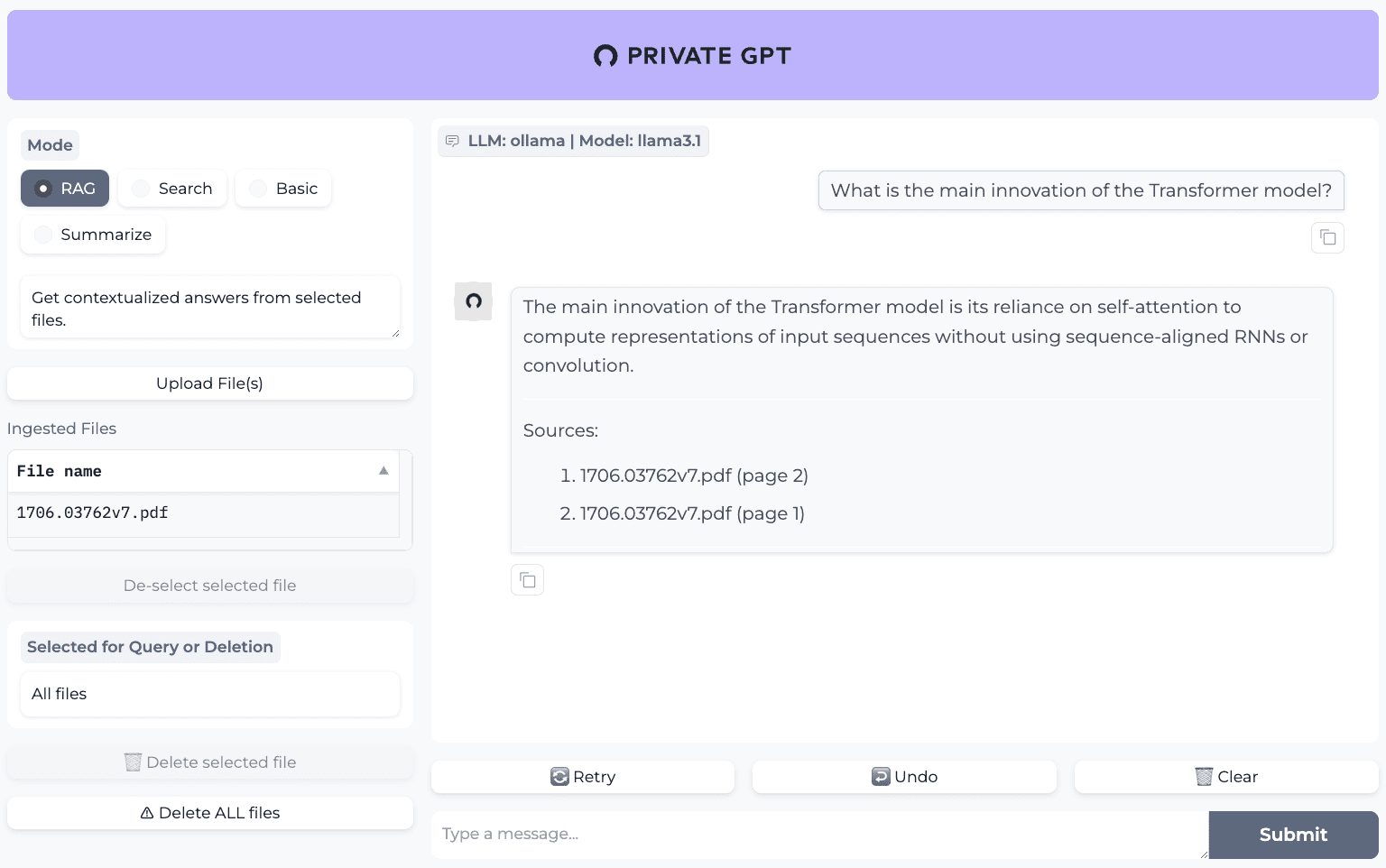

PrivateGPT: Ein Dokumenten-Q&A-System mit vollständig lokalisiertem RAG-Bearbeitungsfluss

Allgemeine Einführung

PrivateGPT ist ein für Produktionsumgebungen verfügbares KI-Projekt, das es Nutzern ermöglicht, Dokumente mit Hilfe von Large Language Models (LLMs) ohne Internetverbindung zu quizzen. Das Projekt gewährleistet den Datenschutz für 100%, und alle Daten werden in der Ausführungsumgebung des Benutzers ohne Offenlegung verarbeitet.PrivateGPT wurde vom Zylon-Team entwickelt, um eine API bereitzustellen, die den Aufbau privater, kontextbezogener KI-Anwendungen unterstützt. Das Projekt folgt dem OpenAI-API-Standard und erweitert diesen, um sowohl normale als auch Streaming-Antworten zu unterstützen.PrivateGPT eignet sich für Bereiche, die ein hohes Maß an Datenschutz erfordern, wie z. B. das Gesundheitswesen und das Recht.

Ähnliche Projekte:Kotaemon: ein einfach zu verwendendes Open-Source-Werkzeug für multimodale Dokumentenquizs

Funktionsliste

- Dokumentenaufnahme: Verwalten des Parsens, Aufteilens, Extrahierens von Metadaten, Erzeugen von Einbettungen und Speichern von Dokumenten.

- Chat & Finish: Konversation und Aufgabenerledigung unter Verwendung des Kontexts des aufgenommenen Dokuments.

- Einbettungsgenerierung: Generierung von Einbettungen auf der Grundlage von Text.

- Context Block Search: nimmt die relevantesten Textblöcke eines Dokuments auf der Grundlage der zurückgegebenen Abfrage auf.

- Gradio UI Client: bietet einen funktionierenden Client zum Testen der API.

- Tools für Batch-Modell-Download-Skripte, Ingestion-Skripte, Dokumentenordner-Überwachung und mehr.

Hilfe verwenden

Einbauverfahren

- Klon-Lager: Klonen Sie zunächst das GitHub-Repository von PrivateGPT.

git clone https://github.com/zylon-ai/private-gpt.git

cd private-gpt

- Installation von Abhängigkeiten: Verwendung

pipInstallieren Sie die erforderlichen Python-Abhängigkeiten.

pip install -r requirements.txt

- Konfiguration der UmgebungKonfigurieren Sie die Umgebungsvariablen und Setup-Dateien nach Bedarf.

cp settings-example.yaml settings.yaml

# 编辑settings.yaml文件,配置相关参数

- Neue DiensteStarten Sie den Dienst mit Docker.

docker-compose up -d

Verwendung der Q&A-Funktion der Dokumentation

- BelegeingabeLegen Sie die zu verarbeitenden Dokumente in dem angegebenen Ordner ab und führen Sie das Ingestion-Skript aus.

python scripts/ingest.py --input-folder path/to/documents

- Q&A InteraktionVerwenden Sie den Gradio UI-Client für Q&A-Interaktionen.

python app.py

# 打开浏览器访问http://localhost:7860

API-Verwendung auf höchster Ebene

- Parsen von Dokumenten und Generierung von EinbettungenParsing von Dokumenten und Generierung von Einbettungen mit Hilfe von High-Level-APIs.

from private_gpt import HighLevelAPI

api = HighLevelAPI()

api.ingest_documents("path/to/documents")

- Kontextsuche und Generierung von AntwortenKontextabfrage und Antwortgenerierung mit Hilfe von High-Level-APIs.

response = api.chat("你的问题")

print(response)

Low-Level-API-Verwendung

- Generation einbettenGenerieren von Texteinbettungen mit Hilfe der Low-Level-API.

from private_gpt import LowLevelAPI

api = LowLevelAPI()

embedding = api.generate_embedding("你的文本")

- KontextblocksucheContext block retrieval using low-level APIs.

chunks = api.retrieve_chunks("你的查询")

print(chunks)

Verwendung des Werkzeugsatzes

- Batch Model DownloadVerwenden Sie das Skript Bulk Model Download, um die benötigten Modelle herunterzuladen.

python scripts/download_models.py

- Überwachung des DokumentenordnersAutomatisches Einlesen neuer Dokumente mit dem Tool Document Folder Monitor.

python scripts/watch_folder.py --folder path/to/documents© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...