Pieces OS: Umgekehrte Pieces-OS GRPC-Konvertierung zur OpenAI-Schnittstelle (fehlgeschlagen)

Allgemeine Einführung

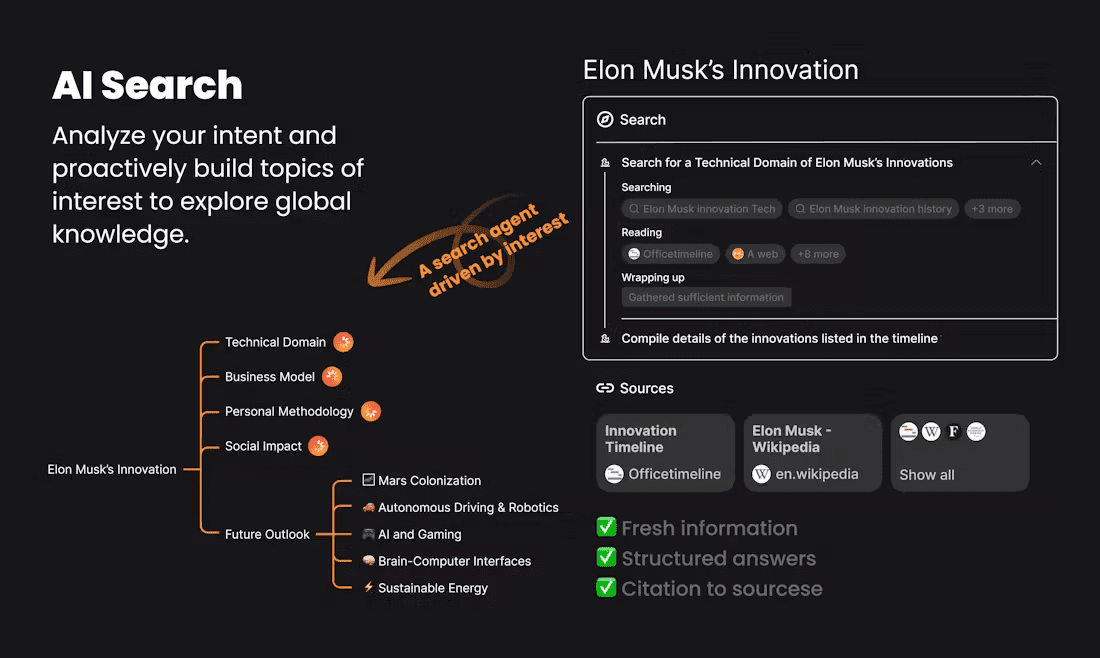

Pieces-OS ist ein Open-Source-Projekt, zielt darauf ab, Pieces-OS GRPC-Streams umzukehren und zu konvertieren, um die Standard-OpenAI-API-Schnittstelle, Unterstützung für Claude, GPT, Gemini. das Projekt wird von Nekohy entwickelt, auf der Grundlage der GPL-3.0-Protokoll Open Source, vor allem für das Lernen und Kommunikation, nicht für den kommerziellen Einsatz. Das Projekt bietet eine Vielzahl von Modell-Kompatibilität , und unterstützt Vercel Ein-Klick-Einsatz .

Rückwärtsrichtung Stücke Kostenlose Bereitstellung von API-Schnittstellen zur Unterstützung der Modelle Claude, GPT und Gemini in einer Minute. Bereitstellung vonGo-Version.

Funktionsliste

- GRPC-FlussumkehrGRPC: Konvertiert GRPC-Streams von Pieces-OS in die Standard-OpenAI-Schnittstelle.

- Unterstützung mehrerer Modelle: Kompatibel Claude Serie, GPT-Serie, Gemini-Serie und viele andere Modelle.

- Ein-Klick-Bereitstellung: Unterstützung Ein-Klick-Bereitstellung der Vercel-Plattformdie von den Benutzern schnell und einfach erstellt werden kann.

- Konfiguration des WolkenmodellsBereitstellung von Profilen von Cloud-Modellen, so dass die Benutzer je nach Bedarf verschiedene Modelle extrahieren und verwenden können.

- Verwaltung von API-AnfragenVerwaltung von Präfixpfaden, Schlüsseln, Wiederholungen usw. für API-Anfragen durch Konfiguration von Umgebungsvariablen.

Hilfe verwenden

Einbauverfahren

- Klonprojekt: Verwendung

git cloneBefehl, um das Projekt lokal zu klonen.git clone https://github.com/Nekohy/pieces-os.git - Installation von Abhängigkeiten: Wechseln Sie in das Projektverzeichnis und installieren Sie

package.jsonAbhängigkeits-Bibliotheken, die in dercd pieces-os npm install - Auslöseverfahren: Umsetzung

node index.jsLeiten Sie das Verfahren ein.node index.js

Verwendungsprozess

- Abrufen einer Liste von ModellenAbrufen der Liste der verfügbaren Modelle mit dem folgenden Befehl.

curl --request GET 'http://127.0.0.1:8787/v1/models' --header 'Content-Type: application/json' - Anfrage senden: Verwenden Sie den folgenden Befehl, um eine Chat-Anfrage zu senden.

curl --request POST 'http://127.0.0.1:8787/v1/chat/completions' --header 'Content-Type: application/json' --data '{ "messages": [ { "role": "user", "content": "你好!" } ], "model": "gpt-4o", "stream": true }'

Konfiguration der Umgebungsvariablen

- API_PREFIXPräfixpfad für API-Anfragen, Standardwert ist

'/'. - API_KEYSchlüssel: Der Schlüssel für die API-Anfrage, standardmäßig eine leere Zeichenkette.

- MAX_RETRY_COUNTMaximale Anzahl von Wiederholungsversuchen, Standardwert ist

3. - RETRY_DELAYWiederholungsverzögerungszeit in Millisekunden, Standardwert ist

5000(5 Sekunden). - PORT: der Port, an dem der Dienst lauscht; der Standardwert ist

8787.

Modell Konfiguration

Das Projekt bietet Profile für mehrere Modelle cloud_model.jsonDer Benutzer kann je nach Bedarf verschiedene Modelle extrahieren und verwenden. Zum Beispiel:

- Claude-Serie::

claude-3-5-sonnet@20240620undclaude-3-haiku@20240307usw. - GPT-Serie::

gpt-3.5-turboundgpt-4undgpt-4-turbousw. - Serie Gemini::

gemini-1.5-flashundgemini-1.5-prousw.

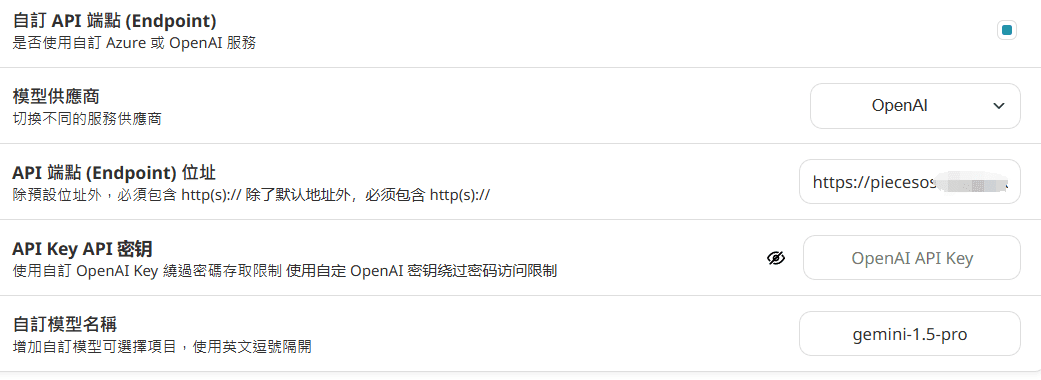

Wie man es nach dem Einsatz verwendet

Konfiguriert in nextchat:

Geben Sie den Domänennamen direkt ein, fügen Sie ihn nicht nach der URL hinzu./v1/models und /v1/chat/completions

API_KEY ist in Vercel nicht konfiguriert, dann ist keine Eingabe erforderlich.

Konfiguration in der immersiven Übersetzung: (aufgrund von Gleichzeitigkeitsproblemen nicht empfohlen)

https://你的域名/v1/chat/completions

Wenn apikey nicht gesetzt ist, füllen Sie die Lücken aus.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...