Parler-TTS: Generierung sprecherspezifischer Text-to-Speech-Modelle aus Eingabetext

Allgemeine Einführung

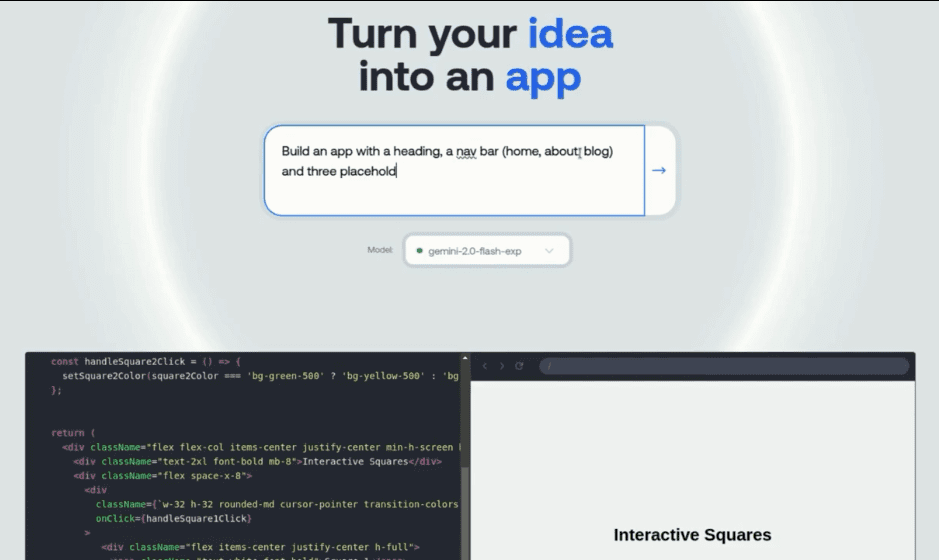

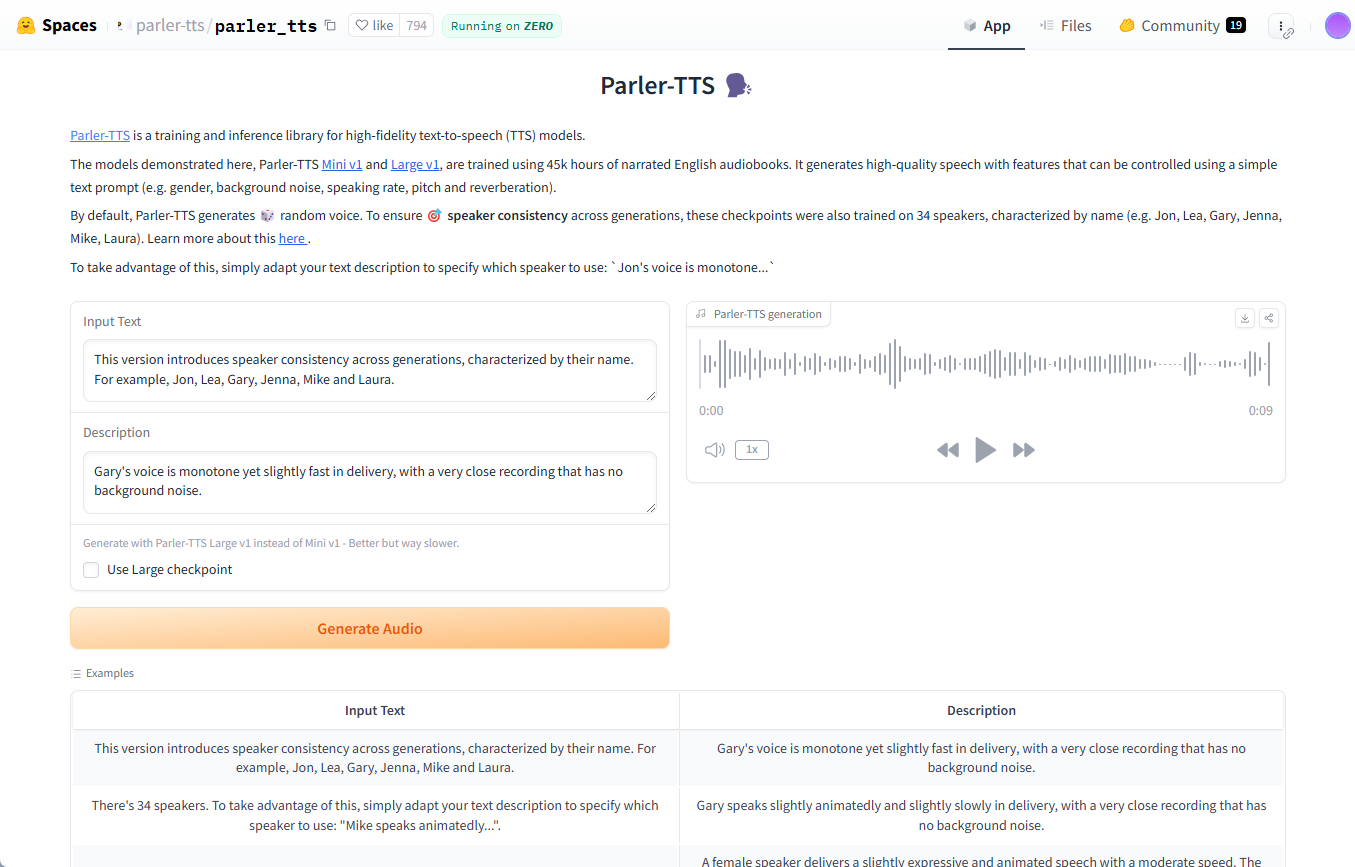

Parler-TTS ist eine von Hugging Face entwickelte Open-Source-Text-to-Speech (TTS)-Modellbibliothek zur Erzeugung qualitativ hochwertiger, natürlich klingender Sprache. Das Modell ist in der Lage, auf der Grundlage des Eingabetextes Sprache mit einem bestimmten Sprecherstil (z. B. Geschlecht, Tonhöhe, Sprechweise usw.) zu erzeugen.Parler-TTS basiert auf den Forschungsergebnissen des Papiers "Natural language guidance of high-fidelity text-to-speech with synthetic Parler-TTS basiert auf den Forschungsergebnissen des Papiers "Natural language guidance of high-fidelity text-to-speech with synthetic annotations" und ist vollständig quelloffen, d.h. alle Datensätze, die Vorverarbeitung, der Trainingscode und die Gewichte sind öffentlich zugänglich, so dass die Community sie weiterentwickeln und verbessern kann.

Funktionsliste

- Hochwertige SpracherzeugungGenerieren Sie natürliche und flüssige Sprache mit Unterstützung für mehrere Sprecherstile.

- offene QuelleAlle Code- und Modellgewichte sind für die Entwicklung und Verbesserung der Gemeinschaft öffentlich zugänglich.

- Leichtgewichtige AbhängigkeitenEinfach zu installieren und zu verwenden, mit wenigen Abhängigkeiten.

- Mehrere ModellversionenParler-TTS Mini und Parler-TTS Large: Es sind Versionen des Modells mit unterschiedlichen Parameterzahlen verfügbar.

- Schnelle ErzeugungOptimierte Generierungsgeschwindigkeit mit Unterstützung für SDPA und Flash Attention 2.

- Datensätze und GewichteBietet umfangreiche Datensätze und vortrainierte Modellgewichte für einfaches Training und Feinabstimmung.

Hilfe verwenden

Einbauverfahren

- Stellen Sie sicher, dass die Python-Umgebung installiert ist.

- Verwenden Sie den folgenden Befehl, um die Parler-TTS-Bibliothek zu installieren:

pip install git+https://github.com/huggingface/parler-tts.git

- Für Apple Silicon-Benutzer führen Sie den folgenden Befehl aus, um bfloat16 zu unterstützen:

pip3 install --pre torch torchaudio --index-url https://download.pytorch.org/whl/nightly/cpu

Verwendung

Zufällige Sprache generieren

- Importieren Sie die erforderlichen Bibliotheken:

import torch

from parler_tts import ParlerTTSForConditionalGeneration

from transformers import AutoTokenizer

import soundfile as sf

- Modelle und Splitter laden:

device = "cuda:0" if torch.cuda.is_available() else "cpu"

model = ParlerTTSForConditionalGeneration.from_pretrained("parler-tts/parler-tts-mini-v1").to(device)

tokenizer = AutoTokenizer.from_pretrained("parler-tts/parler-tts-mini-v1")

- Text eingeben und Sprache erzeugen:

prompt = "Hey, how are you doing today?"

description = "A female speaker delivers a slightly expressive and animated speech with a moderate speed and pitch."

inputs = tokenizer(prompt, return_tensors="pt").to(device)

outputs = model.generate(**inputs, description=description)

sf.write("output.wav", outputs.cpu().numpy(), 22050)

Generieren von Sprache in einem bestimmten Sprecherstil

- Beschreibungen, die den Stil eines bestimmten Sprechers verwenden:

description = "A male speaker with a deep voice and slow pace."

inputs = tokenizer(prompt, return_tensors="pt").to(device)

outputs = model.generate(**inputs, description=description)

sf.write("output_specific.wav", outputs.cpu().numpy(), 22050)

Ausbildungsmodelle

- Laden Sie den Datensatz herunter und bereiten Sie ihn vor.

- Das Training des Modells wird mit dem mitgelieferten Trainingscode durchgeführt:

python train.py --dataset_path /path/to/dataset --output_dir /path/to/output

Optimierte Argumentation

- Optimiert mit SDPA und Flash Attention 2:

model = ParlerTTSForConditionalGeneration.from_pretrained("parler-tts/parler-tts-mini-v1", use_flash_attention=True).to(device)© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...