par_scrape: ein Crawler-Tool für die intelligente Extraktion von Webdaten

Allgemeine Einführung

par_scrape ist ein auf Python basierender Open-Source-Web-Crawler, der vom Entwickler Paul Robello auf GitHub veröffentlicht wurde und Benutzern helfen soll, auf intelligente Weise Daten aus Webseiten zu extrahieren. Er integriert zwei leistungsstarke Browser-Automatisierungstechnologien, Selenium und Playwright, und kombiniert sie mit KI-Verarbeitungsfunktionen, um das Crawlen von Daten von einfachen statischen Seiten bis hin zu komplexen dynamischen Websites zu unterstützen. Egal, ob es um die Extraktion von Preisen, Titeln oder anderen strukturierten Informationen geht, par_scrape erledigt die Aufgabe schnell, indem es Felder angibt und die Ergebnisse als Markdown, JSON oder CSV ausgibt. Projekt für Entwickler, Datenanalysten oder Benutzer, die die Sammlung von Informationen im Web automatisieren wollen, einfach zu installieren und flexible Funktionen, beliebt in der Open-Source-Community.

Funktionsliste

- Intelligente DatenextraktionAnalyse von Webinhalten mit Hilfe von KI-Modellen wie OpenAI oder Anthropic, um benutzerdefinierte Felder genau zu extrahieren.

- Duale RaupenunterstützungDie Website unterstützt sowohl Selenium- als auch Playwright-Technologien, die an unterschiedliche Website-Architekturen angepasst werden können.

- Mehrere AusgabeformateCapture-Ergebnisse können zur einfachen Weiterverarbeitung in Markdown, JSON, CSV oder Excel exportiert werden.

- Benutzerdefinierte FelderfassungBenutzer können die zu extrahierenden Felder, wie z. B. Titel, Beschreibung, Preis usw. angeben, um individuelle Bedürfnisse zu erfüllen.

- parallele ErfassungUnterstützung von Multi-Thread-Crawling zur Verbesserung der Effizienz bei der Erfassung großer Datenmengen.

- Wartender MechanismusBereitstellung einer Vielzahl von Methoden zum Warten auf das Laden von Seiten (z. B. Pause, Warten auf Selektoren), um den Erfolg des Crawlings von dynamischen Inhalten zu gewährleisten.

- Auswahl des AI-ModellsUnterstützung für mehrere KI-Anbieter (z. B. OpenAI, Anthropic, XAI) zur flexiblen Anpassung an unterschiedliche Aufgaben.

- Cache-OptimierungEingebaute Hint-Caching-Funktion, um die Kosten für wiederholte Anfragen zu reduzieren und die Effizienz zu verbessern.

Hilfe verwenden

Einbauverfahren

Um par_scrape zu verwenden, müssen Sie zunächst die folgenden Installationsschritte durchführen, um sicherzustellen, dass Ihre Umgebung gut vorbereitet ist. Im Folgenden finden Sie eine detaillierte Installationsanleitung:

1. die Vorbereitung der Umwelt

- Python-VersionStellen Sie sicher, dass Python 3.11 oder höher auf Ihrem System installiert ist, indem Sie den Befehl

python --versionPrüfen. - Git-WerkzeugeKlonen von Code von GitHub: Wird verwendet, um Code von GitHub zu klonen; wenn es nicht installiert ist, kann es über die

sudo apt install git(Linux) oder die offizielle Website zum Herunterladen und Installieren. - UV-WerkzeugeEs wird empfohlen, UV zu verwenden, um die Abhängigkeiten zu verwalten, der Installationsbefehl lautet:

- Linux/Mac:

curl -LsSf https://astral.sh/uv/install.sh | sh - Fenster:

powershell -ExecutionPolicy ByPass -c "irm https://astral.sh/uv/install.ps1 | iex"

- Linux/Mac:

2. klonen von Projekten

Klonen Sie das Projekt par_scrape lokal, indem Sie den folgenden Befehl in das Terminal eingeben:

git clone https://github.com/paulrobello/par_scrape.git

cd par_scrape

3. die Installation von Abhängigkeiten

Verwenden Sie UV, um Projektabhängigkeiten zu installieren:

uv sync

Oder installieren Sie direkt von PyPI:

uv tool install par_scrape

# 或使用 pipx

pipx install par_scrape

4. die Installation des Dramaturgen (fakultativ)

Wenn Sie Playwright als Crawler wählen, müssen Sie Ihren Browser zusätzlich installieren und konfigurieren:

uv tool install playwright

playwright install chromium

5. konfigurieren Sie den API-Schlüssel

par_scrape unterstützt mehrere AI-Anbieter, Sie müssen den entsprechenden Schlüssel in der Umgebungsvariablen konfigurieren. bearbeiten ~/.par_scrape.env fügen Sie Folgendes hinzu (wählen Sie nach Bedarf):

OPENAI_API_KEY=your_openai_key

ANTHROPIC_API_KEY=your_anthropic_key

XAI_API_KEY=your_xai_key

Oder setzen Sie die Umgebungsvariable, bevor Sie den Befehl ausführen:

export OPENAI_API_KEY=your_openai_key

Verwendung

Sobald die Installation abgeschlossen ist, können Sie par_scrape von der Kommandozeile aus starten, hier ist die detaillierte Vorgehensweise:

Grundlegende Anwendungsbeispiele

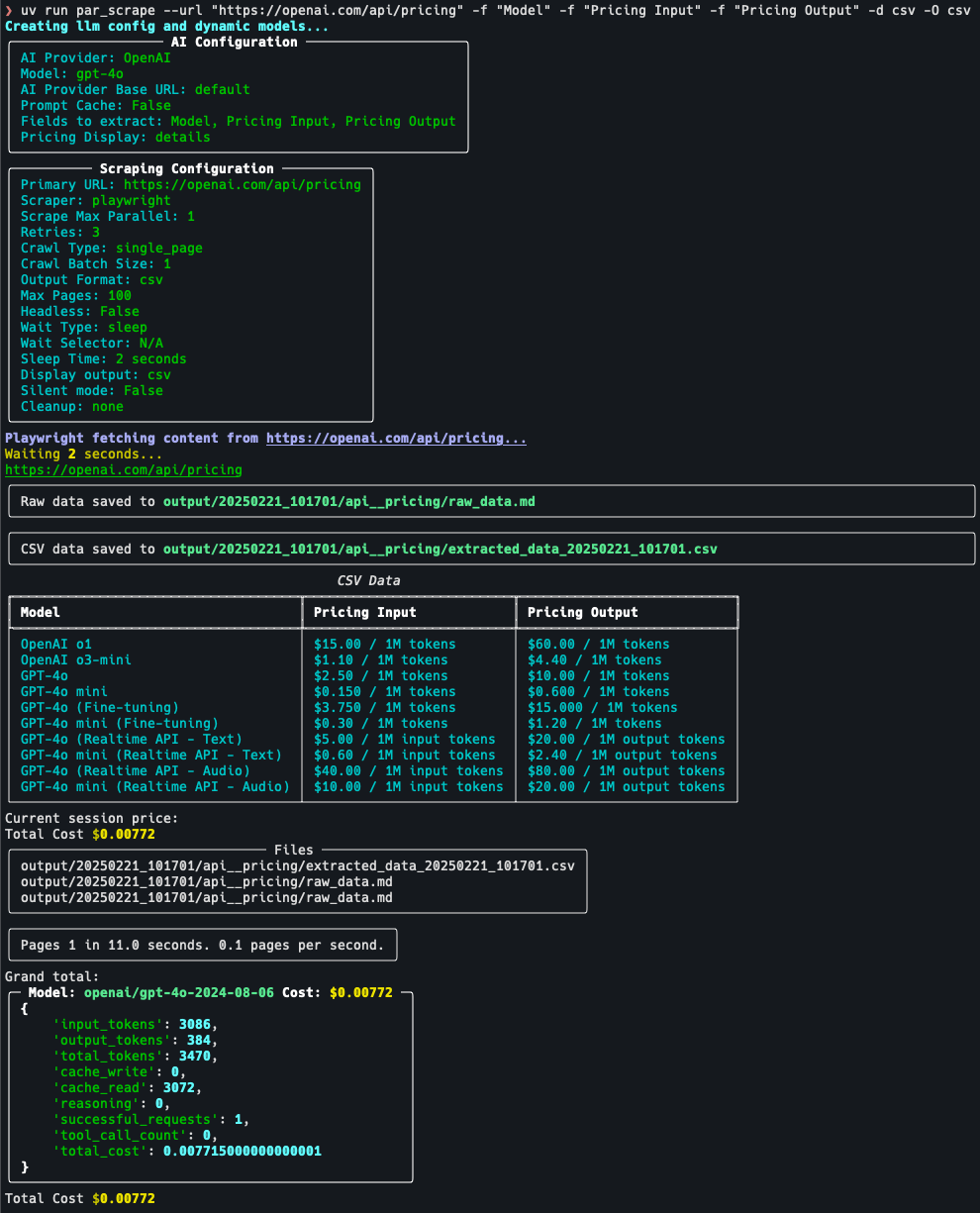

Angenommen, Sie möchten den Titel, die Beschreibung und den Preis aus der OpenAI-Preisseite extrahieren:

par_scrape --url "https://openai.com/api/pricing/" -f "Title" -f "Description" -f "Price" --model gpt-4o-mini --display-output md

--urlAdresse der Ziel-Webseite: Die Adresse der Ziel-Webseite.-f: Geben Sie das Extraktionsfeld an, das mehrfach verwendet werden kann.--modelWählen Sie das AI-Modell (z.B. gpt-4o-mini).--display-outputAusgabeformat (md, json, csv, usw.).

Featured Function Bedienung

- Wechsel der Crawler-Tools

Playwright wird standardmäßig verwendet, wenn Sie Selenium verwenden möchten, können Sie Parameter hinzufügen:par_scrape --url "https://example.com" -f "Title" --scraper selenium - parallele Erfassung

Legen Sie die maximale Anzahl der parallelen Anfragen fest, um die Effizienz zu verbessern:par_scrape --url "https://example.com" -f "Data" --scrape-max-parallel 5 - Dynamisches Warten auf Seiten

Für dynamisch geladene Inhalte können Wartetypen und Selektoren festgelegt werden:par_scrape --url "https://example.com" -f "Content" --wait-type selector --wait-selector ".dynamic-content"Unterstützte Wartearten sind

noneundpauseundsleepundidleundselectorim Gesang antwortentext. - Benutzerdefinierter Ausgabepfad

Speichert die Ergebnisse in dem angegebenen Ordner:par_scrape --url "https://example.com" -f "Title" --output-folder ./my_data

Details zum Betriebsablauf

Nehmen Sie zum Beispiel die Seite mit den Crawl-Preisen:

- Zielsetzung: Gehen Sie zu https://openai.com/api/pricing/ und bestätigen Sie, dass Sie das "Modell", den "Pricing Input" und den " Preisgestaltung Ausgabe".

- Befehl ausführen::

par_scrape --url "https://openai.com/api/pricing/" -f "Model" -f "Pricing Input" -f "Pricing Output" --model gpt-4o-mini --display-output json - Ergebnisse anzeigenNach Ausführung des Befehls zeigt das Terminal die Daten im JSON-Format an oder speichert sie in der Standardausgabedatei.

- AnpassungsparameterWenn die Daten unvollständig sind, fügen Sie bitte Folgendes hinzu

--retries 5(Anzahl der Wiederholungsversuche) oder Einstellungen--sleep-time 5(Wartezeit).

caveat

- API-SchlüsselVergewissern Sie sich, dass der Schlüssel gültig ist, andernfalls ist die AI-Extraktionsfunktion nicht verfügbar.

- Einschränkungen der WebsiteEinige Websites können einen Anti-Crawl-Mechanismus haben und es wird empfohlen, die

--headless(Headless-Modus) oder zum Einstellen der Greiffrequenz. - Cache-NutzungWenn Sie dieselbe Seite mehrfach crawlen, können Sie die Option

--prompt-cacheGeringere Kosten.

Mit den oben beschriebenen Schritten können Benutzer schnell mit par_scrape beginnen und einfach Aufgaben zur Datenextraktion aus Webseiten erledigen.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...