Bestandsaufnahme von LLM-Frameworks ähnlich wie Ollama: mehrere Optionen für lokal eingesetzte große Modelle

Das Aufkommen des Ollama-Frameworks hat im Bereich der künstlichen Intelligenz und der großen Sprachmodelle (LLMs) sicherlich viel Aufmerksamkeit erregt. Dieses Open-Source-Framework konzentriert sich auf die Vereinfachung der Bereitstellung und des Betriebs von LLMs auf lokaler Ebene und macht es mehr Entwicklern leicht, die Attraktivität von LLMs zu erleben. Wenn man sich den Markt ansieht, ist Ollama jedoch nicht allein, und es gibt viele andere Tools der gleichen Art, die aufgetaucht sind und Entwicklern eine breitere Auswahl bieten. In diesem Artikel werden wir einen detaillierten Blick auf einige der Tools werfen, die mit Ollama Mehrere große Modell-Framework-Tools wie diese werden den Lesern hoffentlich helfen, ein umfassenderes Verständnis des Technologie-Ökosystems in diesem Bereich zu gewinnen und das für sie am besten geeignete Tool zu finden.

Einführung in das Ollama Framework

Ollama wurde entwickelt, um den Einsatz und Betrieb von Large Language Models (LLMs) in lokalen Umgebungen zu vereinfachen. Es unterstützt eine breite Palette von Standard-LLMs wie Llama 2, Code Llama, Mistral, Gemma usw. und ermöglicht es den Benutzern, ihre eigenen Modelle entsprechend ihren Bedürfnissen anzupassen und zu erstellen. ChatGPT Die Chat-Schnittstelle ermöglicht es den Benutzern, ohne zusätzliche Entwicklung direkt mit dem Modell zu interagieren. Darüber hinaus ist Ollama aufgrund seines sauberen Codes und des geringen Ressourcenverbrauchs zur Laufzeit ideal für die Ausführung auf einem lokalen Computer.

Ähnliche Tools wie Ollama

Einführung in vLLM

vLLM VLLM (Vectorised Large Language Model Serving System) ist eine effiziente Inferenz- und Service-Engine für große Modelle, die auf LLM zugeschnitten ist. vLLM verbessert die LLM-Inferenzleistung durch innovative PagedAttention-Technologie, kontinuierliche Stapelverarbeitung, CUDA-Core-Optimierung und verteilte Inferenzunterstützung erheblich. vLLM verbessert die Inferenzleistung durch innovative PagedAttention-Technologie, kontinuierliche Batch-Verarbeitung, CUDA-Core-Optimierung und verteilte Inferenzunterstützung.

Besonderheiten

vLLM vLLM unterstützt eine Vielzahl von Modellformaten, darunter PyTorch, TensorFlow usw., so dass die Benutzer je nach ihren Bedürfnissen flexibel wählen können. Gleichzeitig verfügt vLLM über eine leistungsstarke Inferenz-Engine, die Online-Inferenz und Batch-Inferenz unterstützt und in der Lage ist, schnell auf eine große Anzahl gleichzeitiger Anfragen zu reagieren und auch in Szenarien mit hoher Auslastung eine gute Leistung zu erbringen.

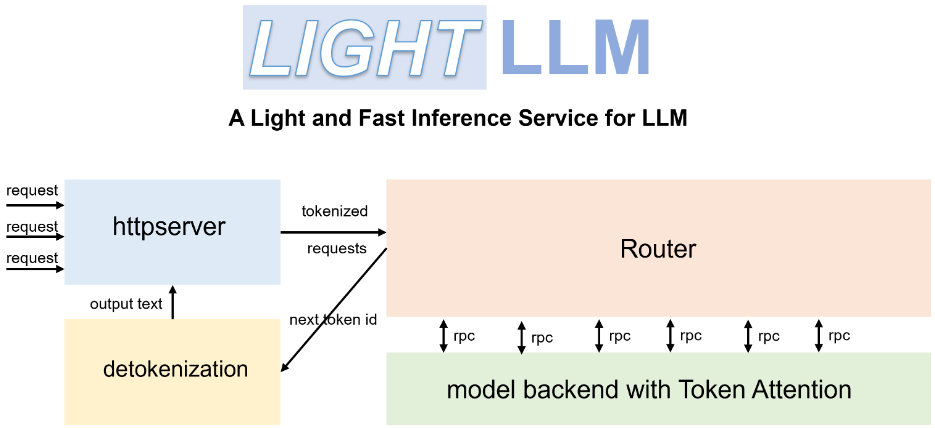

Einführung in LightLLM

LichtLLM ist ein Python-basiertes, leichtgewichtiges und hochleistungsfähiges LLM-Framework für Schlussfolgerungen und Dienste. Es nutzt die Stärken verschiedener Open-Source-Implementierungen wie FasterTransformer, TGI, vLLM und FlashAttention und bietet den Benutzern ein neues LLM-Dienstmodell.

Besonderheiten

LichtLLM Die einzigartige Drei-Prozess-Architektur entkoppelt die drei Hauptschritte Tokenisierung, Modellinferenz und Enttokenisierung und führt sie parallel über einen asynchronen Kooperationsmechanismus aus. Dieses Design verbessert die GPU-Nutzung erheblich und reduziert die durch die Datenübertragung verursachte Latenz, was die Effizienz der Inferenz effektiv verbessert. Darüber hinaus unterstützt LightLLM die Nopad-No-Fill-Operation, mit der Anfragen mit großen Längenunterschieden effizienter bearbeitet und ungültige Füllungen vermieden werden können, wodurch die Ressourcennutzung verbessert wird.

Einführung in llama.cpp

lama.cpp ist eine LLM-Inferenzmaschine, die in C und C++ entwickelt wurde. Sie ist für den Apple-Silizium-Chip optimiert und kann das Llama-2-Modell von Meta auf Apple-Geräten effizient ausführen.

Besonderheiten

Das Hauptziel von llama.cpp ist es, LLM-Inferenz auf einer Vielzahl von Hardware-Plattformen zu implementieren und dabei höchste Leistung bei minimaler Konfiguration zu bieten. Um die Leistung weiter zu steigern, bietet llama.cpp eine Vielzahl von Quantisierungsoptionen wie 1,5-Bit-, 2-Bit-, 3-Bit-, 4-Bit-, 5-Bit-, 6-Bit- und 8-Bit-Integer-Quantisierung, die die Inferenz beschleunigen und den Speicherbedarf reduzieren sollen. Darüber hinaus unterstützt llama.cpp gemischte CPU/GPU-Inferenz, was die Flexibilität und Effizienz der Inferenz weiter erhöht.

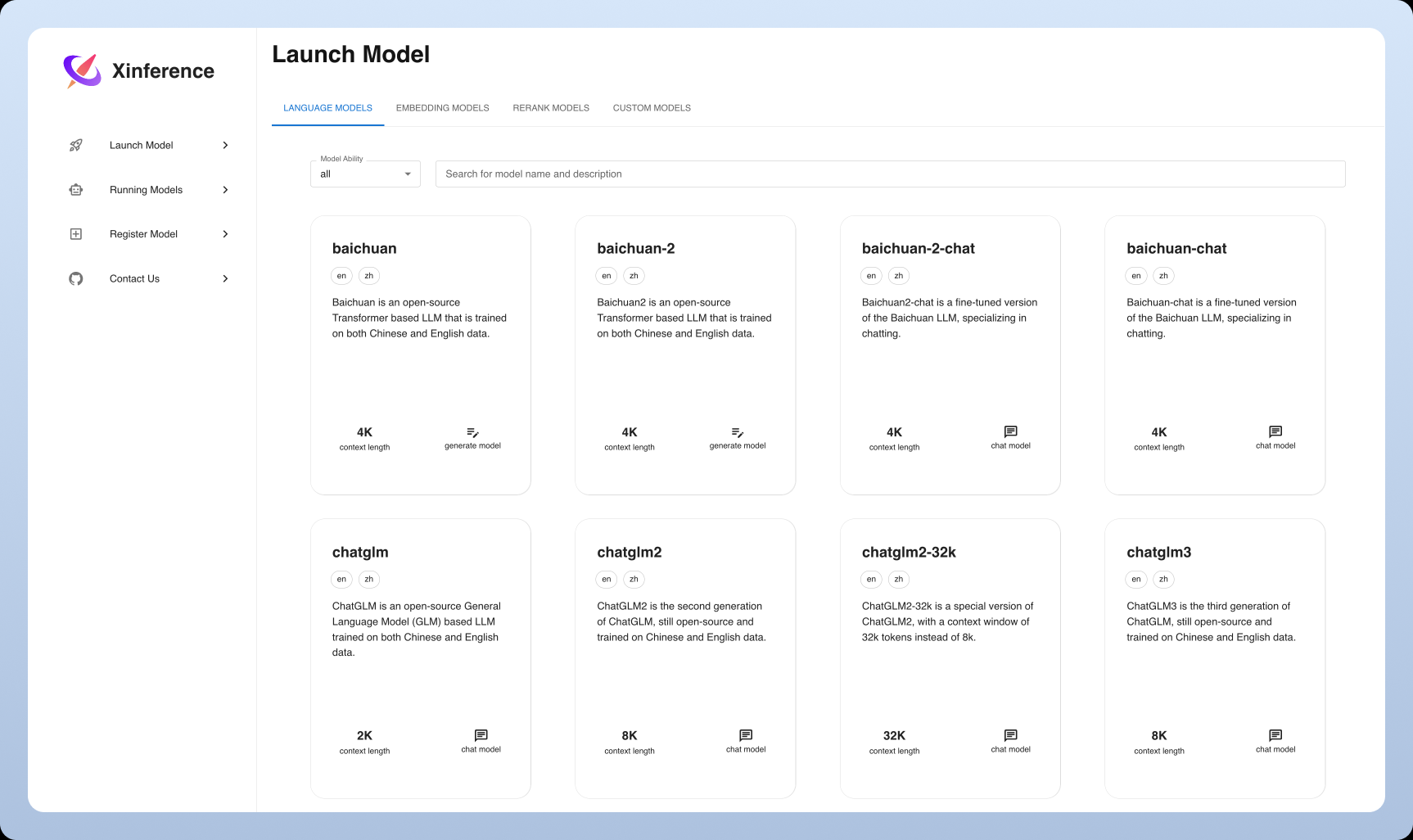

Einführung in Xinference

Xinference ist ein aufstrebendes universelles Inferenz-Framework, das nicht nur LLM, sondern auch Modelle in einer Vielzahl von Modalitäten wie Bild und Sprache unterstützt. Es zielt darauf ab, die Schwelle für den Einsatz und die Nutzung von Modellen zu senken, eine einheitliche Schnittstelle und eine freundliche Benutzererfahrung zu bieten.

Besonderheiten

Xinference Das Highlight von Xinference ist die umfassende Unterstützung für multimodale Modelle, die es den Benutzern ermöglicht, verschiedene Arten von Modellen auf derselben Plattform zu nutzen und zu erleben. Gleichzeitig konzentriert sich Xinference auf die Benutzerfreundlichkeit und bietet eine Vielzahl von Interaktionsmethoden wie Web UI, Python-Client usw. und unterstützt eine einheitliche Verwaltung und flexible Erweiterung von Modellen.

Vergleich und Analyse von Tools

Installation und Einsatz

Ollama. Der Installationsprozess ist extrem einfach, Ollama bietet eine klare und übersichtliche Installationsanleitung und unterstützt viele wichtige Betriebssysteme. Benutzer können ein umfangreiches Sprachmodell mit nur wenigen einfachen Befehlszeilenoperationen zum Laufen bringen.

vLLM. Im Gegensatz dazu ist die Installation von vLLM etwas komplizierter und erfordert vom Benutzerim VorfeldKonfiguration der Python-Umgebung und Installation einer Reihe von abhängigen Bibliotheken. Nach der Bereitstellung wird die effiziente Inferenzleistung von vLLM den Nutzern jedoch einen deutlichen Schub geben, insbesondere in leistungskritischen Szenarien.

LightLLM. Der Installationsprozess von LightLLM ist relativ benutzerfreundlich, und es werden ausführliche Installations- und Konfigurationsanleitungen bereitgestellt, die den Benutzern einen schnellen Einstieg ermöglichen. Die Benutzer können das geeignete Modellformat für den Einsatz je nach ihren Bedürfnissen flexibel auswählen.

llama.cpp. Der Einsatz von llama.cpp erfordert ein gewisses Maß an technischem Wissen, und der Benutzer muss über dieZur UnzeitKonfigurieren Sie die C++-Entwicklungsumgebung. Für Technologie-Enthusiasten und Entwickler bietet die hochleistungsfähige Inferenz-Engine von llama.cpp nach der Konfiguration jedoch die ultimative Benutzererfahrung mit umfassender Kontrolle über jeden Aspekt der Modellinferenz.

Xinference. Xinference ist auch relativ einfach zu installieren und bereitzustellen, da Docker-Images, Python-Pakete und andere Installationsmethoden zur Verfügung stehen, die es den Benutzern leicht machen, ihre Umgebungen schnell einzurichten. Gleichzeitig bietet Xinference eine umfassende Web-UI-Schnittstelle, die die Schwelle für die Nutzung senkt.

Modellunterstützung und Kompatibilität

Ollama. In Bezug auf die Modellunterstützung zeigt sich Ollama sehr offen und unterstützt viele Open-Source-Modelle, darunter Llama 2, Code Llama usw., und ermöglicht es den Benutzern, eigene Modelle hochzuladen. Darüber hinaus bietet Ollama eine Bibliothek mit vorgefertigten Modellen, die den Benutzern einen schnellen Einstieg in verschiedene Modelle ermöglichen.

vLLM. vLLM zeichnet sich durch die Kompatibilität der Modellformate aus und unterstützt PyTorch, TensorFlow und viele andere wichtige Modellformate.machbar Der Benutzer hat eine flexible Modellauswahl. Es ist erwähnenswert, dass vLLM auch verteilte Inferenz unterstützt, die die Rechenleistung mehrerer GPUs voll ausnutzen kann, um Modelle parallel laufen zu lassen, was die Effizienz der Inferenz weiter verbessert.

LightLLM. LightLLM ist außerdem hervorragend kompatibel und unterstützt eine Vielzahl gängiger Modellformate. Gleichzeitig bietet LightLLM reichhaltige APIs und Werkzeuge, die eine tiefgreifende Anpassung erleichtern und den Bedürfnissen einer größeren Anzahl von Nutzern gerecht werden.SpezialDer Bedarf an Anwendungsszenarien.

llama.cpp. llama.cpp konzentriert sich auf die Optimierung des Llama-Modells für extreme Inferenz, unterstützt aber auch andere Modelle. Dank seiner effizienten Inferenz-Engine kann llama.cpp auch bei großen Datensätzen eine hervorragende Leistung erzielen.

Xinference. Eines der Highlights von Xinference ist die Modellunterstützung, die nicht nur verschiedene LLMs unterstützt, sondern auch Bilderzeugungsmodelle wie Stable Diffusion, und Flüstern und anderen Sprachmodellen, was die Kompatibilität der multimodalen Modelle unter Beweis stellt und den Benutzern einen breiteren Anwendungsbereich eröffnet.

Leistung und Optimierung

Ollama. Ollama ist für seine saubere API und effiziente Inferenzleistung bekannt, aber es kann in Szenarien mit einer großen Anzahl gleichzeitiger Anfragen zu Leistungsengpässen kommen. Ollama ist immer noch eine gute Wahl für Benutzer, die eine einfache Bedienung und schnelle Bereitstellung wünschen.

vLLM. vLLM ist auf extreme Leistung ausgelegt. Es verbessert die LLM-Reasoning-Leistung durch Techniken wie PagedAttention erheblich, insbesondere bei einer großen Anzahl gleichzeitiger Anfragen, und ist in der Lage, Anwendungsszenarien mit strengen Anforderungen an die Serviceleistung zu erfüllen.

LightLLM. LightLLM unternimmt auch große Anstrengungen zur Leistungsoptimierung. Dank seiner einzigartigen Drei-Prozess-Architektur und dem Mechanismus für asynchrone Zusammenarbeit verbessert LightLLM effektiv die GPU-Auslastung und die Inferenzgeschwindigkeit. Darüber hinaus unterstützt LightLLM den Nopad-No-Fill-Betrieb, der die Ressourcenauslastung weiter verbessert. Trägt zur Gesamtleistung bei.

llama.cpp. llama.cpp zeichnet sich auch in Bezug auf die Leistung aus. Sie verfügt nicht nur über eine effiziente Inferenzmaschine, sondern bietet auch eine Vielzahl von Quantisierungsoptionen, die eine flexible Abstimmung zwischen Inferenzgeschwindigkeit und Speichernutzung ermöglichenGleichgewichtDie Schlussfolgerungen von llama.cpp basieren auf dem hybriden CPU/GPU-Schlussfolgern. Darüber hinaus unterstützt llama.cpp auch gemischte CPU/GPU-Schlussfolgerungen, was die Flexibilität und Effizienz der Schlussfolgerungen weiter erhöht und es dem Benutzer ermöglicht, dieBeste (Sportler, Film usw.)Konfiguration.

Xinference. Xinference ist auch leistungsoptimiert und unterstützt Techniken wie die Quantisierung und das Pruning von Modellen, um die Inferenz-Effizienz zu verbessern und den Ressourcenverbrauch zu reduzieren. Darüber hinaus wird Xinference auch iterativ optimiert, um die Leistung der multimodalen Modellinferenz zu verbessern.

Zusammenfassung und Ausblick

Tools, die Ollama ähneln, haben ihre eigenen Funktionen und Vorteile, und die Benutzer können je nach Anwendungsszenario und tatsächlichem Bedarf das richtige Framework wählen. Mit der kontinuierlichen Entwicklung der künstlichen Intelligenz und der Technologie zur Sprachmodellierung in großem Maßstab werden diese Tools weiter verbessert und aufgerüstet, um den Benutzern effizientere und bequemere Lösungen zu bieten. In Zukunft werden diese Tools eine größere Rolle bei der Verarbeitung natürlicher Sprache, beim intelligenten Kundendienst, bei der Texterstellung und in anderen Bereichen spielen und so die Entwicklung und Anwendung der Technologie der künstlichen Intelligenz weiter vorantreiben und letztlichrealisieren Eine schöne Vision von künstlicher Intelligenz für alle.

Empfehlungen und Vorschläge

Ollama kann eine gute Wahl für Einsteiger und Einzelanwender sein. Ollama bietet eine einfache API und eine freundliche Benutzeroberfläche, die es den Nutzern ermöglicht, ohne zusätzliche Entwicklung direkt mit den Modellen zu interagieren. Darüber hinaus unterstützt Ollama eine breite Palette von Open-Source-Modellen, was es den Nutzern leicht macht, schnell einzusteigen und verschiedene Anwendungsszenarien auszuprobieren und schnell den Spaß am lokalen Einsatz von LLM zu erleben.

Für Geschäftsanwender, die hochgradig gleichzeitige Anfragen bearbeiten müssen, ist vLLM möglicherweise die bessere Wahl. Die effiziente Reasoning-Leistung und die Unterstützung für verteiltes Reasoning von vLLM erfüllen die Anforderungen hochgradig gleichzeitiger Szenarien und bieten den Benutzern eine stabilere und zuverlässigere Lösung zur Gewährleistung der Geschäftskontinuität.Stabilität und Kontinuität.

LightLLM und llama.cpp sind eher für Benutzer geeignet, die über eine gewisse technische Basis für kundenspezifische Entwicklung und tiefgreifende Optimierung verfügen. Diese beiden Tools bieten Entwicklern mehr Flexibilität und mehr Kontrolle über die zugrunde liegenden zulässig Der Nutzer ist verantwortlich für dieSpezifikation Erstellen Sie individuellere und leistungsfähigere LLM-Anwendungen.

Xinference ist auch eine Option für diejenigen, die mit multimodalen Modellen experimentieren wollen und eine sofort einsatzbereite Lösung suchen. Xinference senkt die Hürden für die Nutzung multimodaler Modelle und ermöglicht es den Nutzern, die Leistungsfähigkeit einer breiten Palette von KI-Modellen auf einer einzigen Plattform zu erleben.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...