OpenManus Neue WebUI und Konfigurationsanleitung für die inländische Suchmaschine

OpenManus wurde in letzter Zeit häufig aktualisiert und unterstützt nun auch lokale Ollama und Web-API-Anbietern und fügte außerdem Unterstützung für inländische Suchmaschinen und mehrere WebUI-Anpassungen hinzu. In diesem Artikel stellen wir einige von der Gemeinschaft bereitgestellte OpenManus-WebUIs vor und zeigen, wie sie für inländische Suchmaschinen konfiguriert werden können.

Einführung in OpenManus WebUI

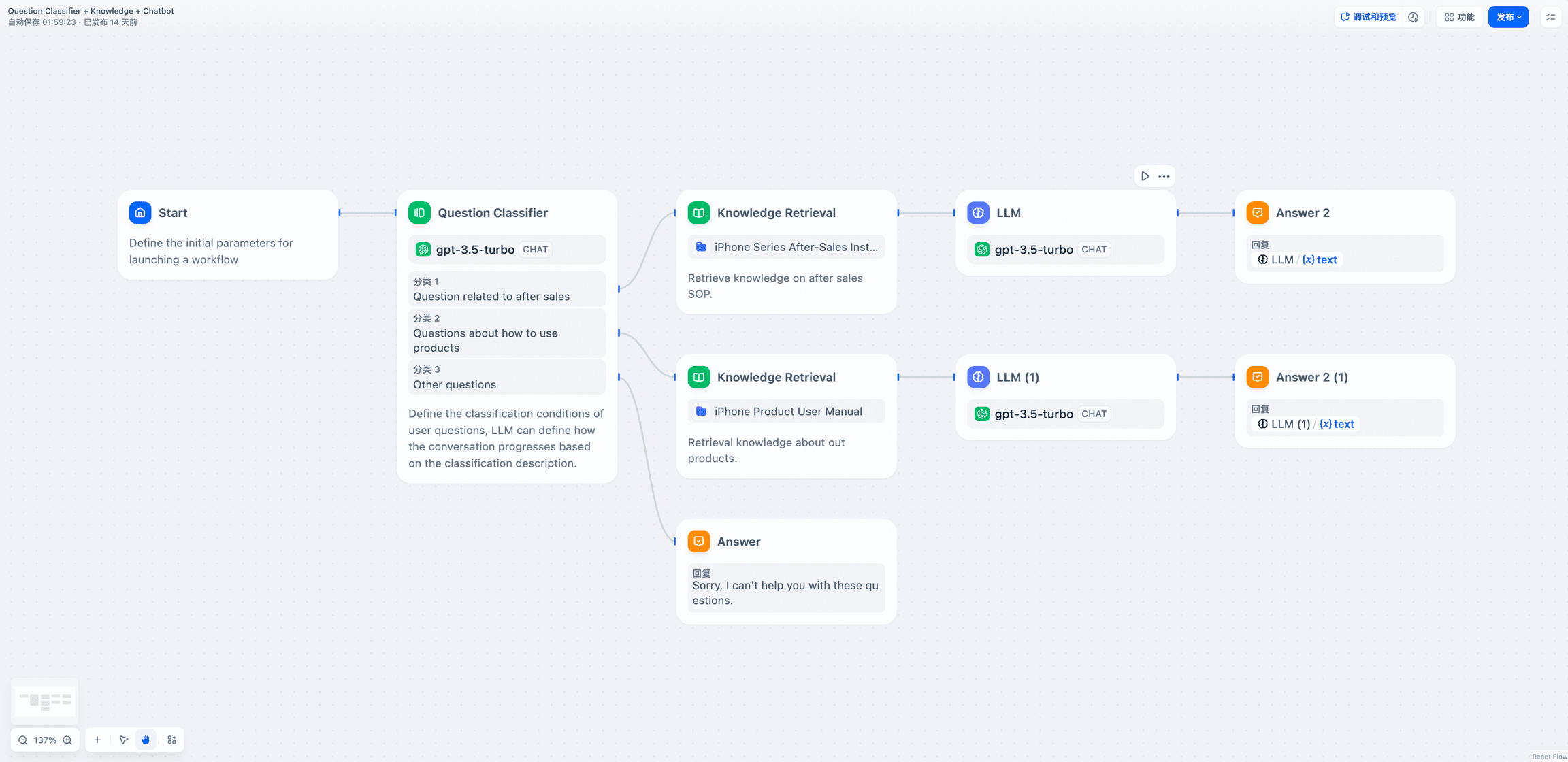

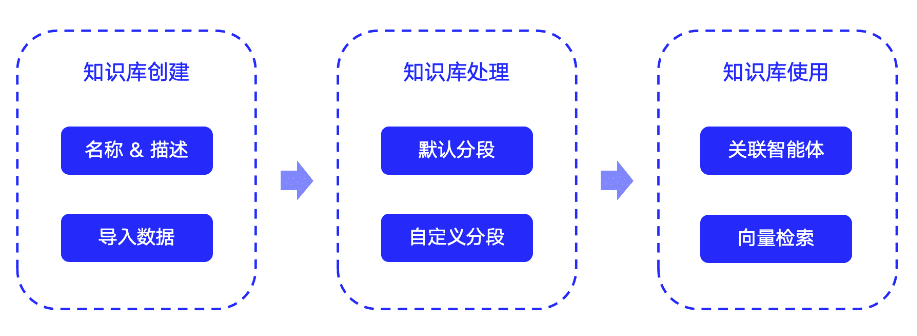

Es gibt eine Reihe von WebUI-Projekten in der Community, die an OpenManus angepasst sind. Einige davon sind unten als Referenz aufgeführt:

Jedes dieser WebUI-Elemente hat seine eigenen Merkmale, so dass Sie sie nach Ihren eigenen Vorlieben verwenden können.

Die offizielle OpenManus-Website wurde ebenfalls aktualisiert (https://openmanus.github.io/). Wenn man jedoch von der rechten Seite des GitHub-Repositorys auf die offizielle Website und dann auf den Dokumentationslink klickt, springt man zurück zum GitHub-Repository, was ein wenig verwirrend ist.

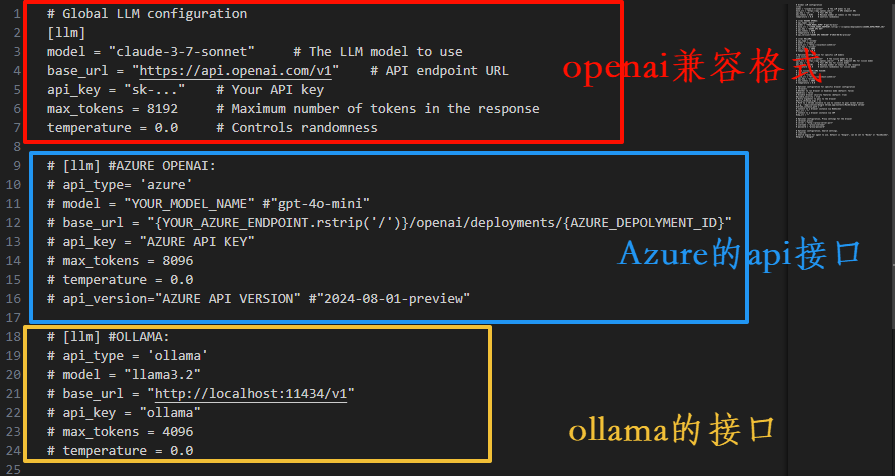

Aktualisierung der Konfigurationsschnittstelle

Die neue Version der Konfigurationsschnittstelle hat mehr Anmerkungen, UI, URL, Suchmaschine und andere Konfigurationselemente sind klarer erklärt, freundlicher für unerfahrene Benutzer.

Die Konfiguration des visuellen Modells ist ähnlich und wird hier nicht wiederholt.

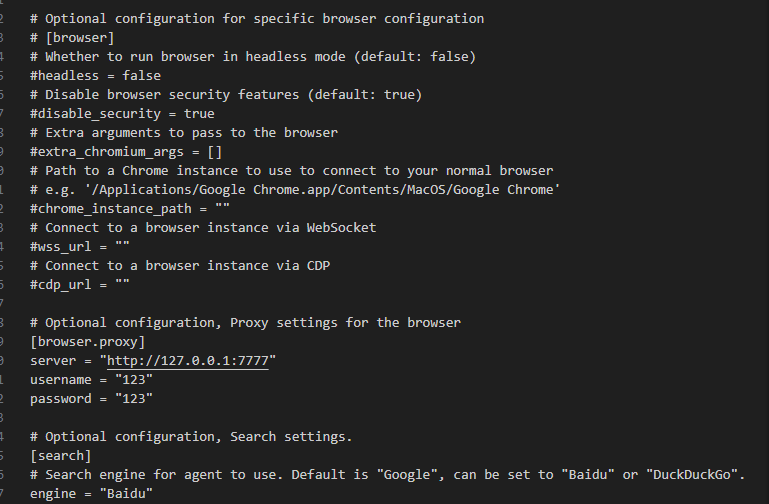

Konfiguration von Suchmaschine und Browser

OpenManus unterstützt jetzt die Konfiguration von Suchmaschinen und Browsern. Die Benutzer können nach ihren Bedürfnissen wählen. Wenn Sie mit den englischen Optionen nicht vertraut sind, können Sie ein Übersetzungstool verwenden, um Ihr Verständnis zu verbessern.

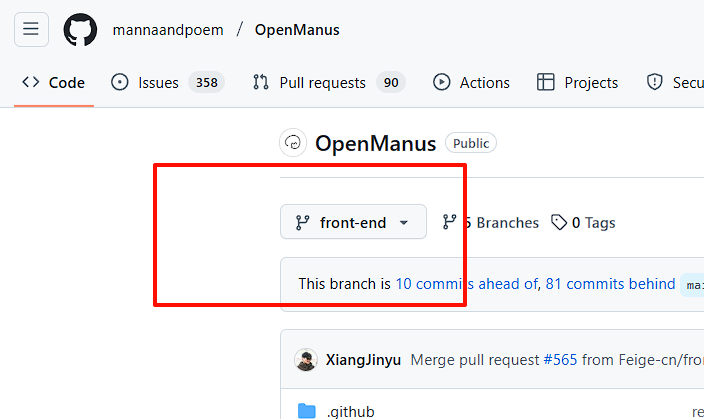

Verwendung der WebUI

Um WebUI zu verwenden, müssen Sie das Repository unter front-end Verzweigung.

Umgebung Konfiguration

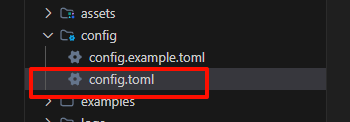

Bevor Sie beginnen, müssen die Umgebungsvariablen konfiguriert werden. Hier ist ein Beispiel für ein lokales Ollama. Erstellen Sie zunächst eine Kopie von config Dokumentation:

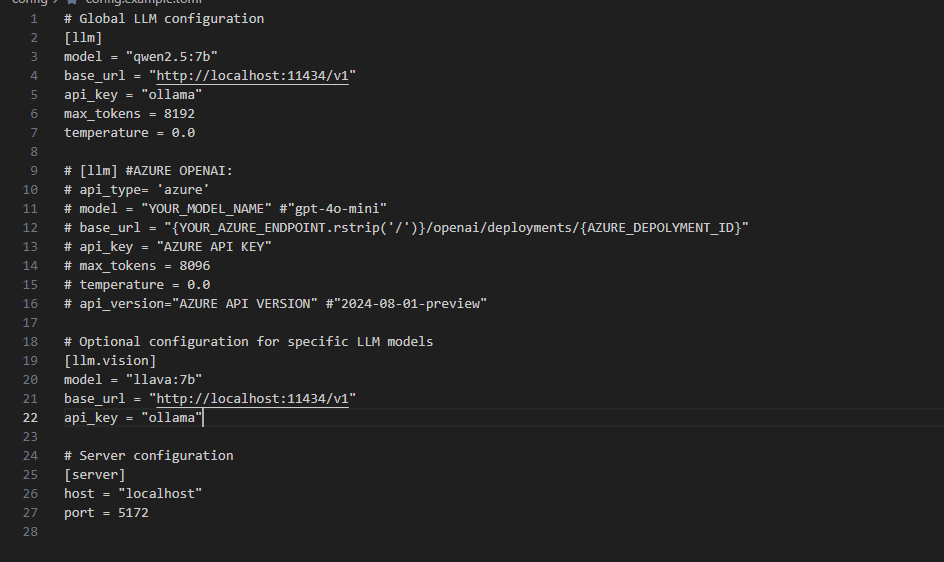

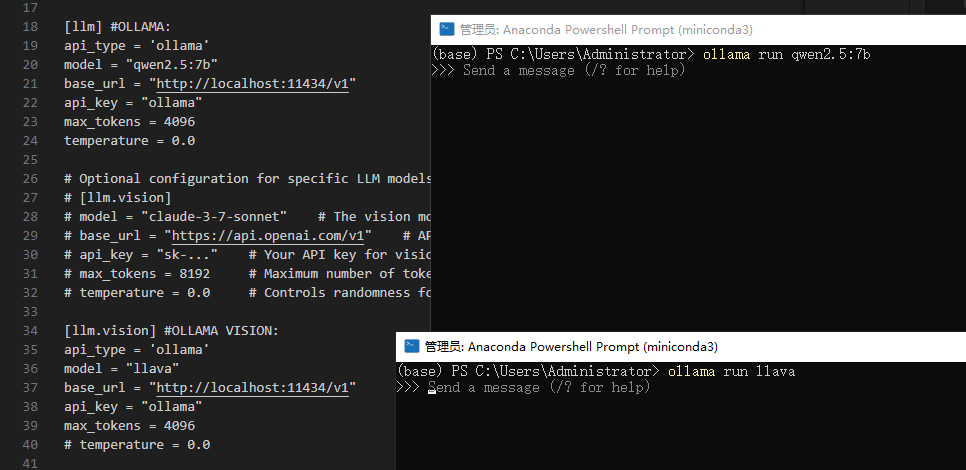

Nehmen Sie dann Änderungen in der kopierten Datei vor. Löschen Sie die ursprüngliche API-Konfiguration und konfigurieren Sie sie entsprechend dem Ollama-Port:

Achtung!api_key Kann nicht null sein und kann mit einem beliebigen Wert gefüllt werden.

Wenn Sie ein Modell auswählen, wählen Sie eines, das Funktionswerkzeuge unterstützt. Auf der Ollama-Website finden Sie eine Liste von Modellen, die Werkzeugaufrufe unterstützen.

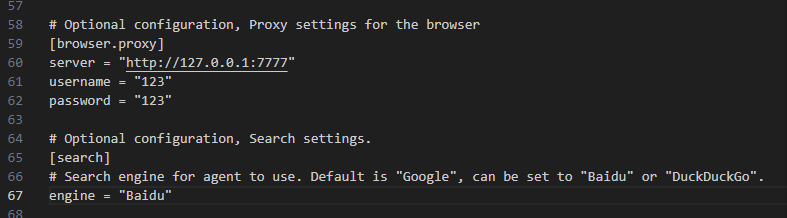

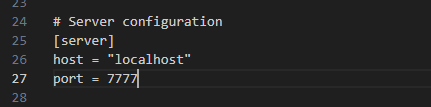

Legen Sie den Port und die Suchmaschine fest (der UI-Zweig ist noch nicht vollständig an inländische Suchmaschinen angepasst). Nehmen Sie zum Beispiel Baidu, geben Sie ein Baidu.

Black Window Version Konfiguration:

Konfiguration der UI-Version:

Speichern Sie die Konfigurationsdatei.

Ollama starten

Um Ollama von der Kommandozeile aus zu starten, verwendet das Beispiel die qwen2.5:7b im Gesang antworten llava Zwei Modelle:

Installation von Abhängigkeiten

Installieren Sie die hinzugefügten Abhängigkeitspakete, wie z. B. fastapiundduckduckgo im Gesang antworten baidusearch. Führen Sie es im Stammverzeichnis des Projekts aus:

pip install -r requirements.txt

Initiierung von Projekten

Nach Abschluss der Installation starten Sie das Projekt.

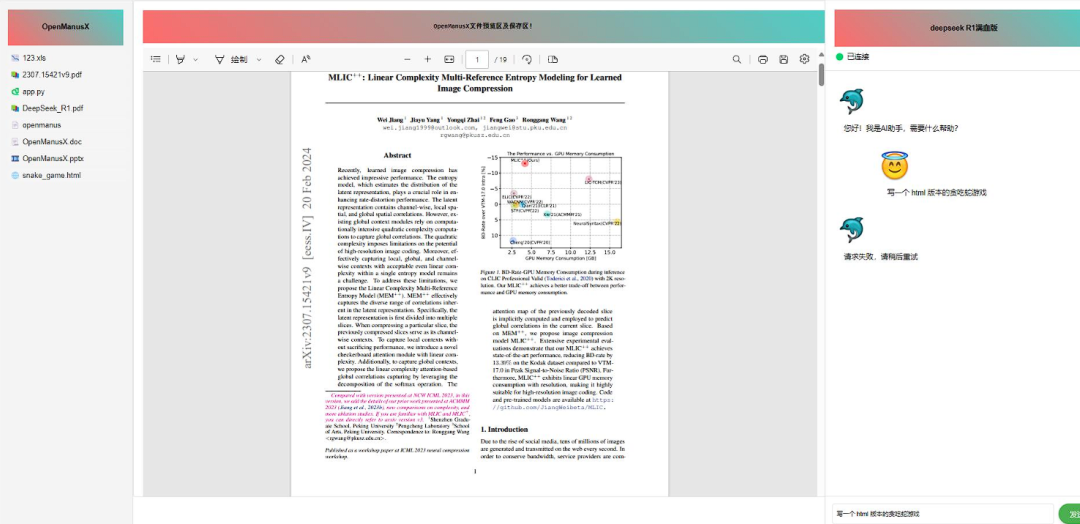

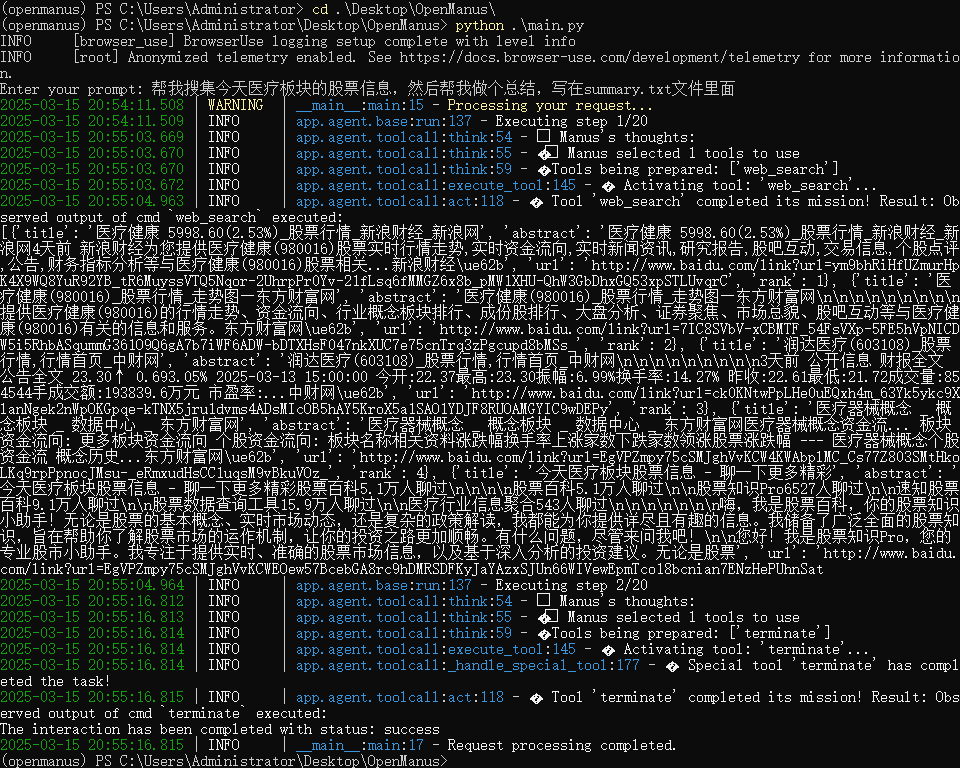

Die Black-Window-Version kann verwendet werden run_flow.py vielleicht main.py Dokumentation:

python run_flow.py

# 或者

python main.py

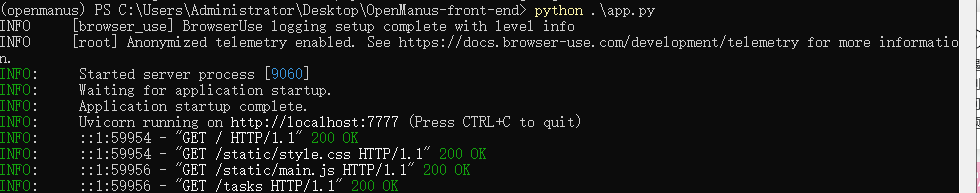

Die UI-Version wird mit dem folgenden Befehl gestartet:

python app.py

Beginn der Mission

Bei der Version mit schwarzem Fenster wird der Effekt ausgeführt:

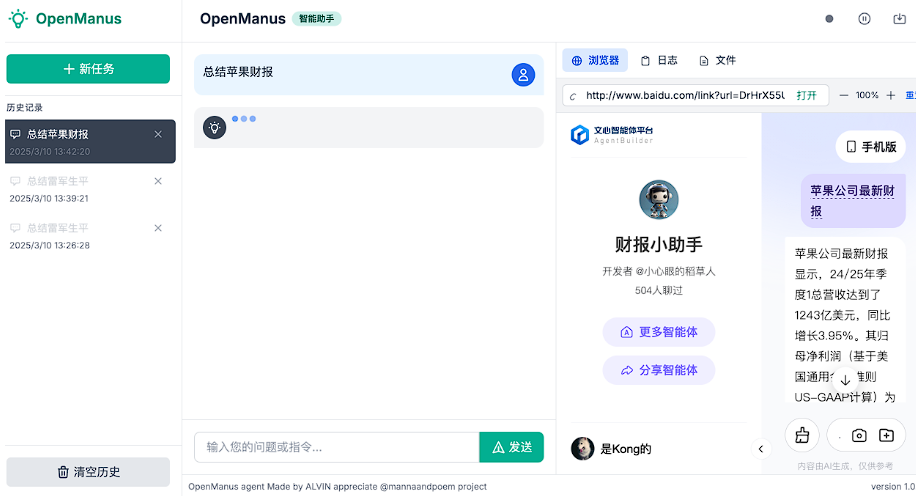

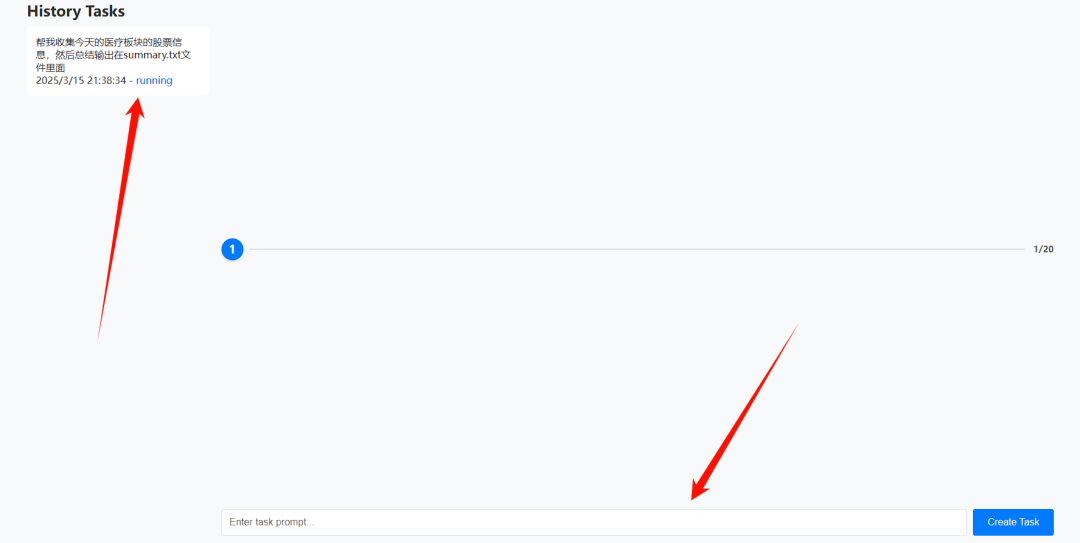

Wenn die UI-Version gestartet wird, springt sie automatisch auf die Webseite:

Geben Sie die Aufgabe in das Eingabefeld ein und klicken Sie auf "Aufgabe erstellen", um die Aufgabe zu erstellen.

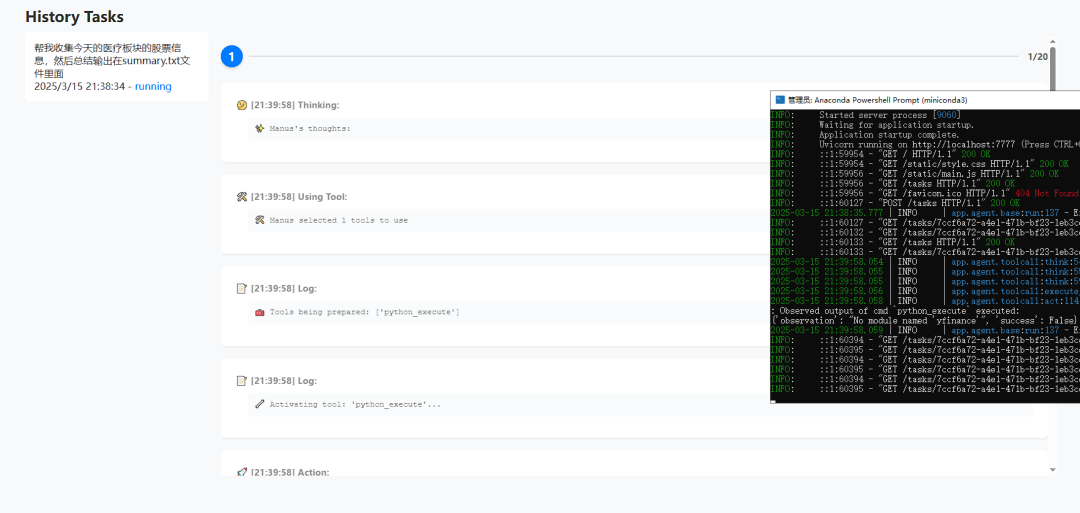

Aufgabenläufe können sowohl in der Back-End- als auch in der Front-End-Oberfläche angezeigt werden:

Unterstützung der WeChat-Suche (experimentell)

Ein Entwickler hat einen Pull Request für WeChat Search eingereicht:https://github.com/mannaandpoem/OpenManus/pull/483

Diese Funktion wurde auf der Grundlage der Sogou WeChat-Such- und Crawler-Technologie implementiert. Aufgrund der Optimierung der OpenManus-Suchschnittstelle muss der ursprüngliche Pfad möglicherweise neu konfiguriert werden. Interessierte Nutzer können versuchen, ihn selbst anzupassen.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...