OpenManus: die quelloffene Version von Manus von MetaGPT

Allgemeine Einführung

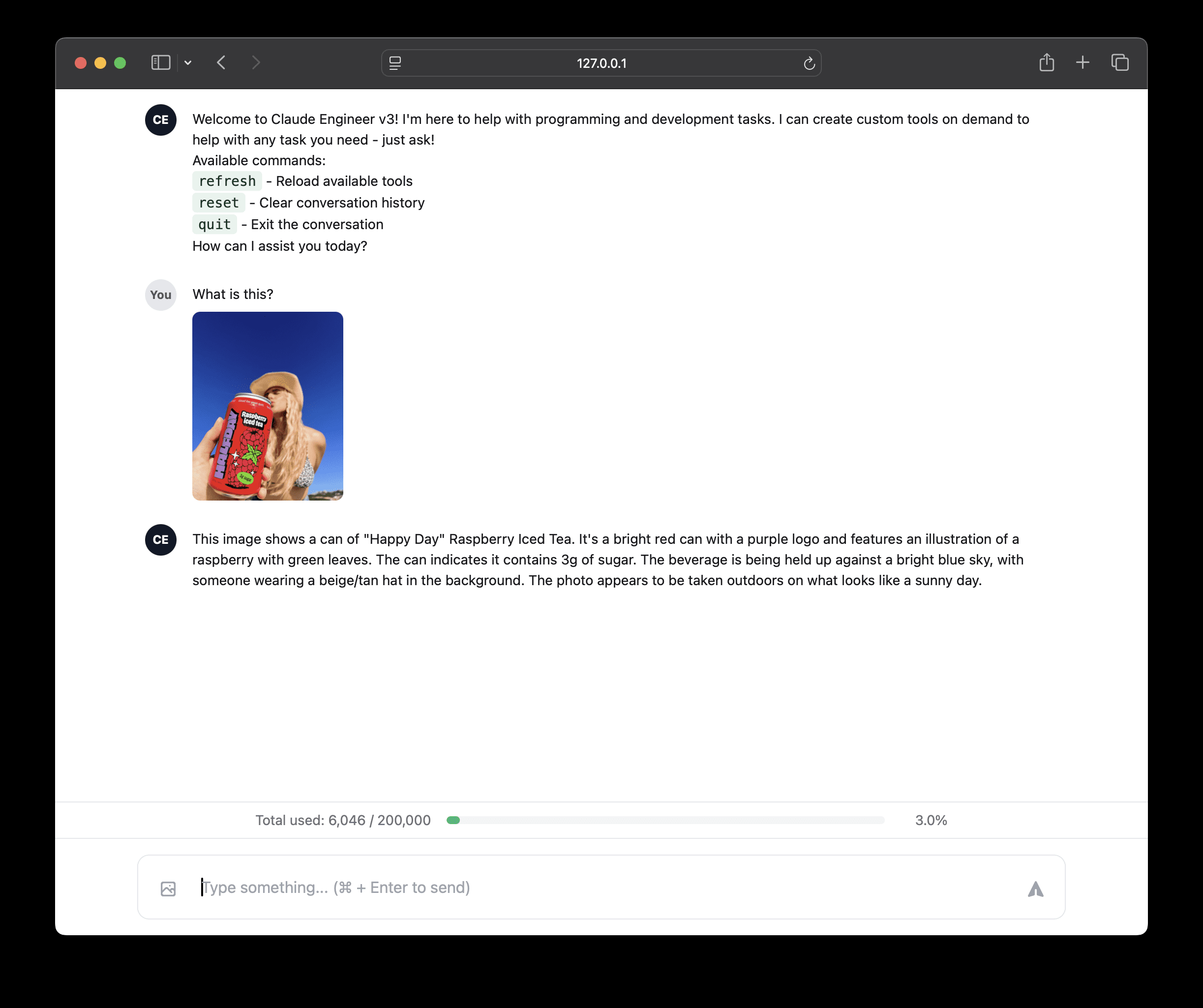

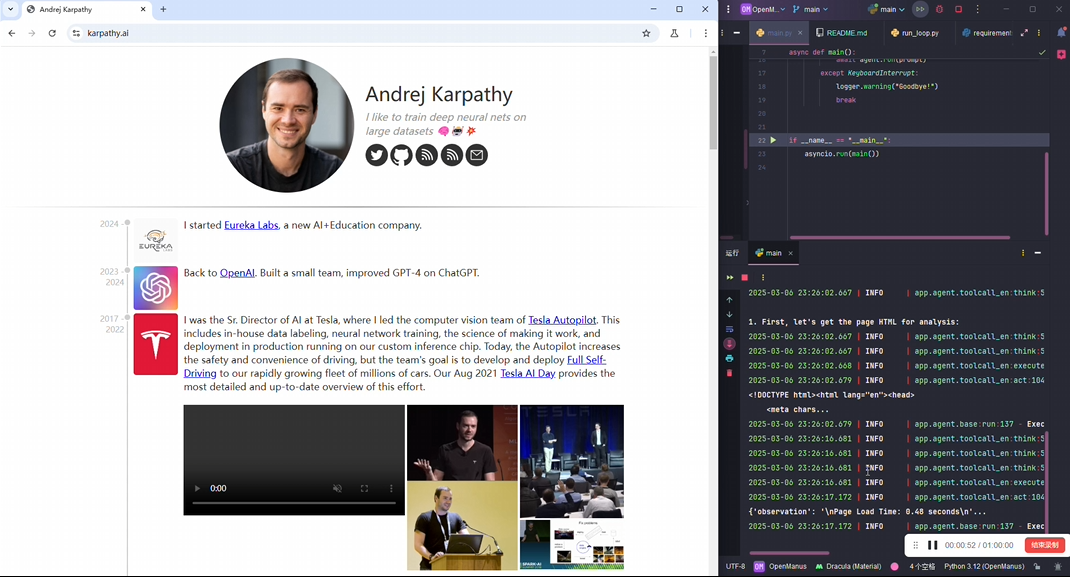

OpenManus ist ein Open-Source-Projekt, das Nutzern helfen soll, Intelligenzen mit einfachen Konfigurationen lokal zu betreiben, um verschiedene kreative Ideen zu verwirklichen. Es besteht aus MetaGPT Die Community-Mitglieder @mannaandpoem, @XiangJinyu, @MoshiQAQ und @didiforgithub haben es in nur 3 Stunden entwickelt, und in der Zwischenzeit kannst du ihr automatisiertes Programmierprojekt verfolgen! MGX Im Vergleich zu Manus, das einen Einladungscode erfordert, gibt es bei OpenManus keine Einstiegshürde. Im Vergleich zu Manus, für das ein Einladungscode erforderlich ist, gibt es bei OpenManus keine Einstiegshürde, und die Nutzer müssen nur den Code klonen und die LLM-API konfigurieren, um schnell loslegen zu können. Das Projekt basiert auf der Python-Entwicklung, mit einer einfachen und klaren Struktur, die die Eingabe von Aufgaben über das Terminal unterstützt, um den intelligenten Körper zur Durchführung von Operationen zu bewegen. Derzeit handelt es sich um eine rudimentäre Implementierung, und das Team ist offen für Vorschläge oder Code-Beiträge. Zu den künftigen Plänen gehören die Optimierung der Aufgabenplanung und das Hinzufügen von Echtzeit-Demonstrationsfunktionen.

Version der OpenManus-Schnittstelle: https://github.com/YunQiAI/OpenManusWeb

OpenManusWeb (inoffiziell)

Funktionsliste

- Operation der lokalen IntelligenzAutomatisierte Operationen lokal mit den konfigurierten LLM-APIs ausführen, indem Aufgaben über das Terminal eingegeben werden.

- Unterstützt gängige LLM-ModelleGPT-4o ist standardmäßig integriert, und der Benutzer kann die Modellkonfiguration nach Bedarf anpassen.

- One-Touch-Start: Lauf

python main.pySie können schnell in den Aufgabenerfassungsmodus wechseln. - Experimentelle Version: Vorausgesetzt

python run_flow.pyWird verwendet, um neue Funktionen in der Entwicklung zu testen. - Gemeinschaftliche ZusammenarbeitUnterstützung der Teilnahme an der Projektentwicklung durch Einreichen von Problemen oder Code über GitHub.

Hilfe verwenden

Einbauverfahren

Die Installation von OpenManus ist einfach und für Benutzer geeignet, die mit Python vertraut sind. Hier sind die detaillierten Schritte:

1. die Conda-Umgebung erstellen

Um Abhängigkeitskonflikte zu vermeiden, empfiehlt es sich, eine eigenständige Umgebung mit Conda zu erstellen:

conda create -n open_manus python=3.12

conda activate open_manus

- AnweisungenDer erste Befehl erstellt eine Datei namens

open_manusUmgebung, unter Verwendung von Python 3.12; der zweite Befehl aktiviert die Umgebung, und die Eingabeaufforderung ändert sich zu(open_manus). - VorbedingungenConda muss installiert werden und kann von der Anaconda-Website heruntergeladen werden.

2. das Klonen des Code-Repository

Laden Sie das OpenManus-Projekt von GitHub herunter:

git clone https://github.com/mannaandpoem/OpenManus.git

cd OpenManus

- AnweisungenDer erste Befehl klont den Code lokal und der zweite Befehl gibt das Projektverzeichnis ein.

- Vorbedingungen: Git muss installiert werden, was über

git --versionPrüfen Sie, ob es verfügbar ist, wenn nicht, laden Sie es von git-scm.com herunter.

3. die Installation von Abhängigkeiten

Installieren Sie die für Ihr Projekt erforderlichen Python-Pakete:

pip install -r requirements.txt

- Anweisungen::

requirements.txtlistet alle abhängigen Pakete auf, die durch die Ausführung dieses Befehls automatisch installiert werden. - NetzoptimierungWenn der Download langsam ist, können Sie einen inländischen Mirror verwenden, z. B.

pip install -r requirements.txt -i https://pypi.tuna.tsinghua.edu.cn/simple.

Schritte zur Konfiguration

Für OpenManus muss die LLM-API konfiguriert werden, um die Smartbody-Funktionalität zu steuern, wie unten beschrieben:

1. das Erstellen von Konfigurationsdateien

Im Projektstammverzeichnis des config um eine Konfigurationsdatei zu erstellen:

cp config/config.example.toml config/config.toml

- AnweisungenKopieren: Dieser Befehl kopiert die Beispieldatei als aktuelle Konfigurationsdatei.

config.tomlist die zur Laufzeit gelesene Datei.

2. die Bearbeitung von Konfigurationsdateien

zeigen (eine Eintrittskarte) config/config.tomlund geben Sie Ihren API-Schlüssel und Ihre Parameter ein:

# 全局 LLM 配置

[llm]

model = "gpt-4o"

base_url = "https://api.openai.com/v1"

api_key = "sk-..." # 替换为你的 OpenAI API 密钥

max_tokens = 4096

temperature = 0.0

# 可选的视觉模型配置

[llm.vision]

model = "gpt-4o"

base_url = "https://api.openai.com/v1"

api_key = "sk-..." # 替换为你的 OpenAI API 密钥

- Beschreibung der Parameter::

modelLLM-Modell: Gibt das LLM-Modell an, der Standardwert ist GPT-4o.base_urlAPI-Zugangsadresse: Standardmäßig wird die offizielle OpenAI-Schnittstelle verwendet.api_keySchlüssel: Von OpenAI für die Authentifizierung erhaltener Schlüssel.max_tokensMaximale Anzahl von Einzelgenerationen Token Zahl, die die Ausgabelänge steuert.temperatureLegt die Zufälligkeit des generierten Inhalts fest, wobei 0,0 die stabilste Ausgabe darstellt.

- Abrufen des API-SchlüsselsBesuchen Sie die OpenAI-Website, loggen Sie sich ein, generieren Sie einen Schlüssel auf der Seite "API Keys" und kopieren Sie ihn in Ihre Konfigurationsdatei.

Betrieb und Nutzung

Nach Abschluss der Installation und Konfiguration kann OpenManus auf folgende Weise gestartet werden:

1. grundlegende Operationen

Starten Sie das Hauptprogramm:

python main.py

- Arbeitsablauf::

- Nachdem das Terminal die Aufforderung angezeigt hat, geben Sie Ihre Aufgabe ein (z. B. "Helfen Sie mir, einen Wochenplan zu erstellen").

- Drücken Sie die Eingabetaste, um den Vorgang zu bestätigen, und OpenManus ruft LLM auf, um die Aufgabe zu bearbeiten.

- Die Verarbeitungsergebnisse werden direkt auf dem Terminal angezeigt.

- VerwendungsszenarienIdeal für schnelle Tests oder einfache Aufgaben wie die Erstellung von Text- oder Codeschnipseln.

2. experimentelle Läufe

Führen Sie die instabile Version aus, um die neuen Funktionen kennenzulernen:

python run_flow.py

- BesonderheitenEnthält Funktionen, die sich in der Entwicklung befinden, kann Fehler enthalten und ist für Benutzer geeignet, die es ausprobieren möchten.

- zur Kenntnis nehmenVergewissern Sie sich, dass die Konfigurationsdatei korrekt ist, sonst kann der Lauf fehlschlagen.

Featured Function Bedienung

Operation der lokalen Intelligenz

- Funktionelle BeschreibungOpenManus ruft den LLM lokal auf, um die Aufgabe zu bearbeiten und das Ergebnis zurückzugeben.

- Beispiel für den Betrieb::

- in Bewegung sein

python main.py. - Eingabe: "Schreibe eine Python-Funktion, die die Summe von 1 bis 100 berechnet".

- Beispielhafte Ausgabe:

def sum_to_100(): return sum(range(1, 101))

- in Bewegung sein

- SchneidkanteLäuft lokal ohne Hochladen von Daten, schützt die Privatsphäre und ist reaktionsschnell.

Unterstützt gängige LLM-Modelle

- Funktionelle BeschreibungBenutzer können je nach Bedarf zwischen verschiedenen LLM-Modellen wechseln.

- Verfahren::

- Compiler

config.tomlwirdmodelWechsel zu einem anderen Modell (z.B."gpt-3.5-turbo"). - Speichern und ausführen

python main.py. - Geben Sie Aufgaben ein, um die Ergebnisse verschiedener Modelle zu erfahren.

- Compiler

- AnregungGPT-4o für komplexe Aufgaben und GPT-3.5-turbo für einfache Aufgaben sind kostengünstiger.

Häufig gestellte Fragen

- AusgabenLäuft mit dem Fehler "ModuleNotFoundError".

- (einen Streit) schlichtenÜberprüfen Sie, ob die Abhängigkeiten vollständig installiert sind, und führen Sie das Programm erneut aus.

pip install -r requirements.txt.

- (einen Streit) schlichtenÜberprüfen Sie, ob die Abhängigkeiten vollständig installiert sind, und führen Sie das Programm erneut aus.

- Ausgaben: "Ungültiger API-Schlüssel".

- (einen Streit) schlichten: Inspektion

config.tomlden Nagel auf den Kopf treffenapi_keyrichtig ist, oder den Schlüssel neu generieren.

- (einen Streit) schlichten: Inspektion

- Ausgaben: Läuft stotternd oder nicht ansprechbar.

- (einen Streit) schlichtenÜberprüfen Sie, ob die Netzwerkverbindung stabil ist, oder reduzieren Sie die Anzahl der

max_tokensWerte, um den Berechnungsaufwand zu verringern. - Demo ansehenProjekte bieten Demo-Videound zeigt die tatsächlichen Betriebsergebnisse.

- (einen Streit) schlichtenÜberprüfen Sie, ob die Netzwerkverbindung stabil ist, oder reduzieren Sie die Anzahl der

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...