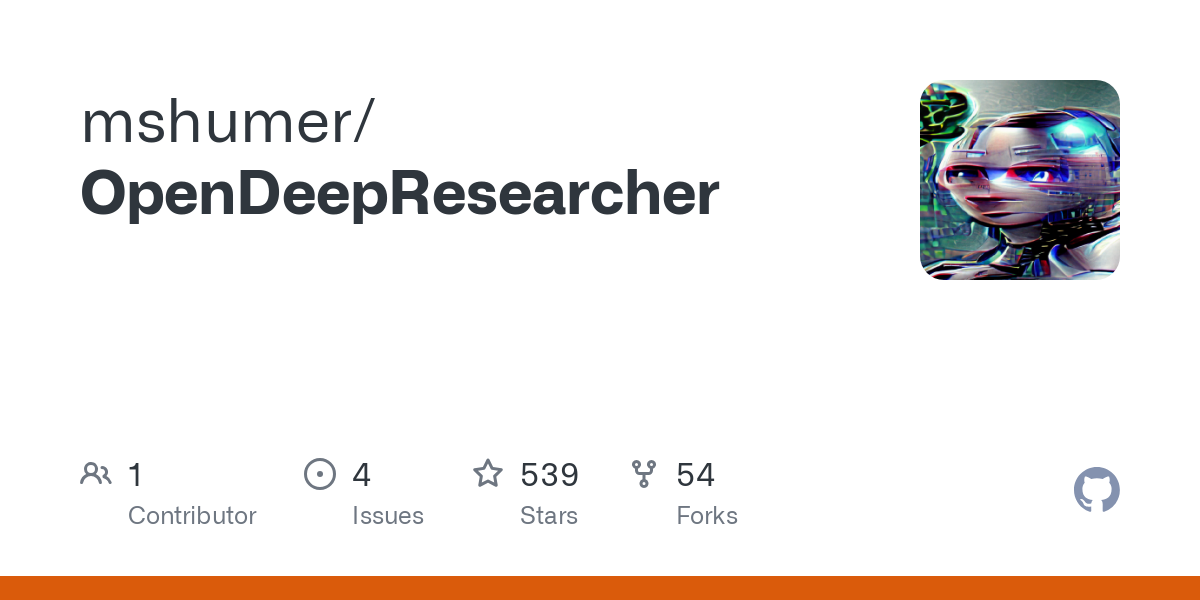

OpenDeepResearcher: automatisiertes Werkzeug zur Erstellung vollständiger Forschungsberichte

Allgemeine Einführung

OpenDeepResearcher ist ein quelloffenes, automatisiertes Deep-Research-Tool, das die Forschungseffizienz durch Techniken der künstlichen Intelligenz verbessern soll. Das Projekt wurde von mshumer entwickelt und wird auf GitHub gehostet. OpenDeepResearcher nutzt eine Vielzahl von Diensten und Technologien, darunter SERPAPI, Jina und OpenRouter, um Google-Suchen, die Extraktion von Webinhalten und kontextbezogene Analysen durchzuführen. Seine Kernfunktion ist die kontinuierliche Optimierung von Suchanfragen durch eine iterative Rechercheschleife, bis das System sicher ist, dass es alle notwendigen Informationen gesammelt hat. Das Tool unterstützt auch die asynchrone Verarbeitung, die iterative Filterung und die LLM-gesteuerte Entscheidungsfindung, so dass ein effizienter und umfassender Rechercheprozess gewährleistet ist.

Funktionsliste

- Iterativer ForschungszyklusDas System optimiert die Suchanfrage durch mehrere Iterationen, um eine umfassende Informationsbeschaffung zu gewährleisten.

- asynchrone VerarbeitungSuche, Webseitenextraktion, Bewertung und Kontextextextraktion werden gleichzeitig durchgeführt, um die Geschwindigkeit zu erhöhen.

- Wiederholung der FilterungAggregieren und Entdoppeln von Links in jeder Iteration, um eine doppelte Verarbeitung der gleichen Links zu vermeiden.

- LLM FahrentscheidungenGenerierung neuer Suchanfragen, Bestimmung der Nützlichkeit von Seiten, Extraktion von relevantem Kontext und Erstellung von Abschlussberichten unter Verwendung eines umfangreichen Sprachmodells.

- Gradio-SchnittstelleBereitstellung einer funktionalen und einfach zu bedienenden Benutzeroberfläche.

Hilfe verwenden

Einbauverfahren

- Klonen oder Öffnen des LaptopsDownload der Notizbuchdatei oder direkt unter Google Colab Öffnen in.

- Nest installierenasyncioNest einrichten: Führen Sie die erste Zelle aus, um das Nest einzurichten.asyncio.

- API-Schlüssel konfigurierenErsetzt die Platzhalterwerte im Notizbuch durch den tatsächlichen API-Schlüssel, einschließlich der OPENROUTERAPIKEY, SERPAPIAPIKEY und JINAAPISCHLÜSSEL.

Verwendungsschritte

- Laufende Notebook-ZellenAlle Zellen sequentiell ausführen. Das Notizbuch fragt nach einer Suchanfrage/einem Thema und einer optionalen maximalen Anzahl von Iterationen (Standard ist 10).

- Erste Abfrage und Generierung von SuchanfragenDas Notebook verwendet LLM, um die erste Suchanfrage zu erstellen.

- Asynchrone Suche und ExtraktionSERPAPI-Suchen parallel durchführen, eindeutige Links zusammenfassen und jeden Link parallel verarbeiten, um die Nützlichkeit der Seite zu bestimmen und relevanten Kontext zu extrahieren.

- Iterative OptimierungNach jeder Runde analysiert der LLM den Kontext der Aggregation und entscheidet, ob weitere Suchanfragen erforderlich sind.

- Abschlussbericht generierenSobald das LLM anzeigt, dass keine weiteren Nachforschungen mehr erforderlich sind (oder die Iterationsgrenze erreicht ist), wird ein Abschlussbericht auf der Grundlage aller gesammelten Kontexte erstellt.

- Abschlussbericht ansehenDer endgültige Synthesebericht wird in der Ausgabe gedruckt.

Detaillierte Vorgehensweise

- Eingabe und AbfragegenerierungDer Benutzer gibt ein Forschungsthema ein und LLM generiert bis zu vier verschiedene Suchanfragen.

- Gleichzeitige Suche und VerarbeitungJede Suchanfrage wird gleichzeitig an die SERPAPI gesendet.

- GewichtsreduzierungAggregieren und Entdoublieren aller abgerufenen Links in der aktuellen Iteration.

- kontextuelle ExtraktionVerarbeiten Sie jeden Link, um die Nützlichkeit der Seite zu bestimmen und relevanten Kontext zu extrahieren.

- Iterative OptimierungAnalysieren Sie den Kontext der Aggregation und entscheiden Sie, ob weitere Suchanfragen erforderlich sind.

- Erstellung des AbschlussberichtsErstellung eines konsolidierten Abschlussberichts auf der Grundlage aller Erfassungskontexte.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...