OpenAI veröffentlicht offiziell o3 und o3-mini, die ersten KI-Modelle, die die ARC-AGI-Benchmarks brechen

Heute Morgen um 2 Uhr kam das letzte Kapitel der 12 Tage Live-Streaming von OpenAI. openAI o3 wurde offiziell veröffentlicht!

o3 ist der Nachfolger der o1-Modellfamilie. Dieser Modelltyp zeichnet sich dadurch aus, dass das Modell vor der Beantwortung einer Frage mehr Zeit zum Nachdenken (Überlegen) benötigt, wodurch die Genauigkeit der Antwort erhöht wird. Allerdings hat OpenAI o2 bei der Namensgebung übersprungen. Laut The Information wurde dies getan, um Urheberrechtsprobleme zu vermeiden, da es in Großbritannien ein Telekommunikationsunternehmen namens O2 gibt, was zu Verwechslungen hätte führen können. sam Altman bestätigte dies heute Nachmittag in einem Live-Stream.

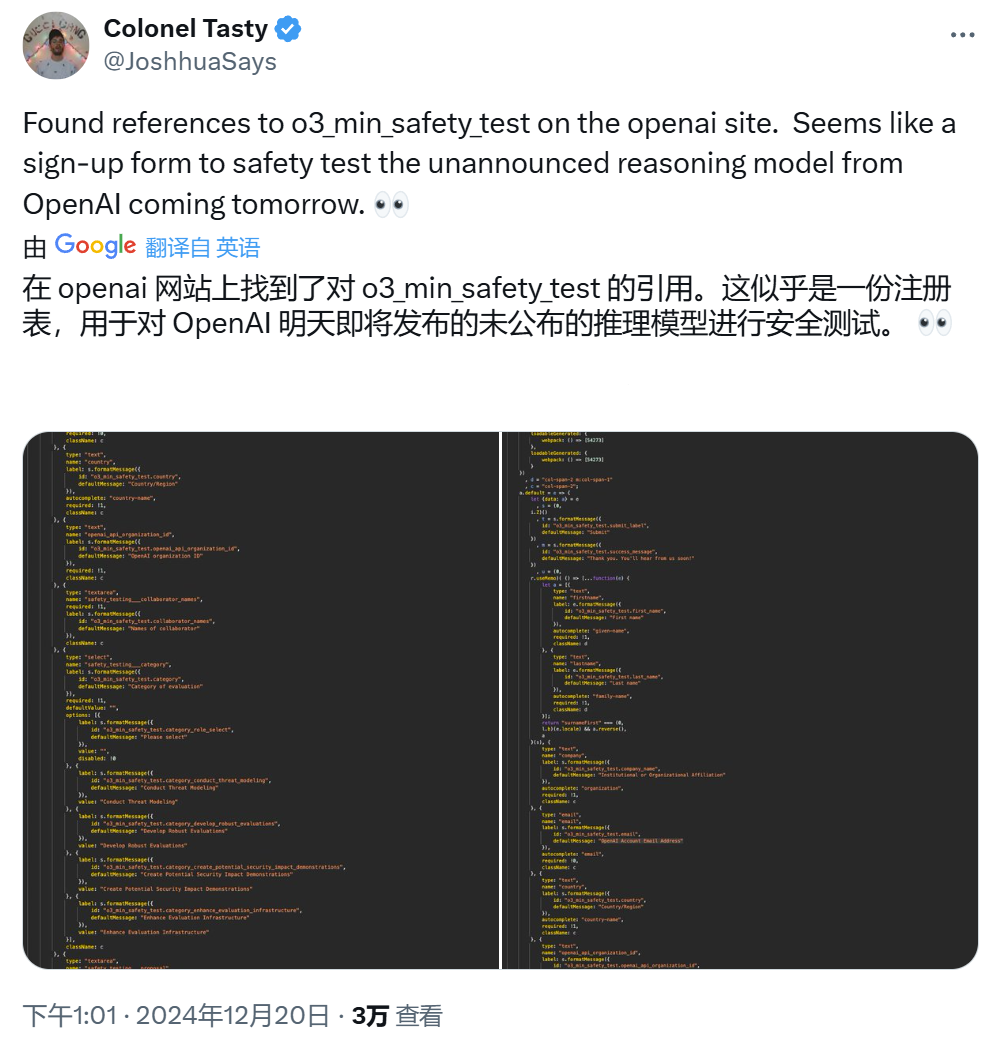

In der Tat hat OpenAI das Modell seit gestern aufgewärmt. Und schon haben Entwickler auf der OpenAI-Website Hinweise auf den o3_min_safety_test gefunden.

o3 Veröffentlichungsdatum

Jetzt, wie gemunkelt, o3 und o3-mini Los geht's! Leider werden die Modelle der o3-Serie nicht direkt für die Öffentlichkeit freigegeben, sondern zunächst auf Sicherheit getestet. sam Altman wies auch darauf hin, dass es sich heute nicht um eine Markteinführung, sondern nur um eine Ankündigung handelt.

Sam Altman erwähnte, dass die Markteinführung des o3-mini für Ende Januar und die des vollständigen o3-Modells kurz danach geplant ist.

Unterschiede zwischen o3 und o3-mini

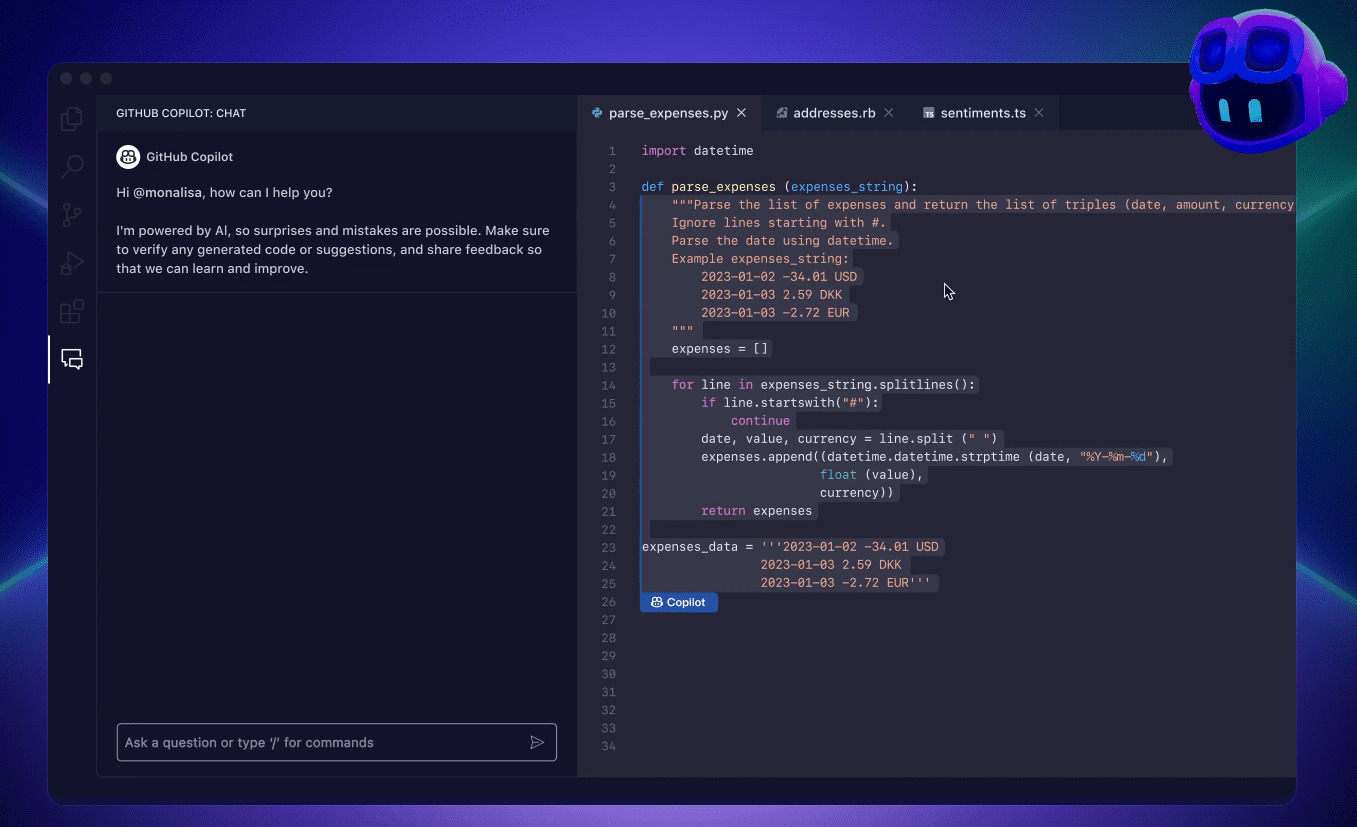

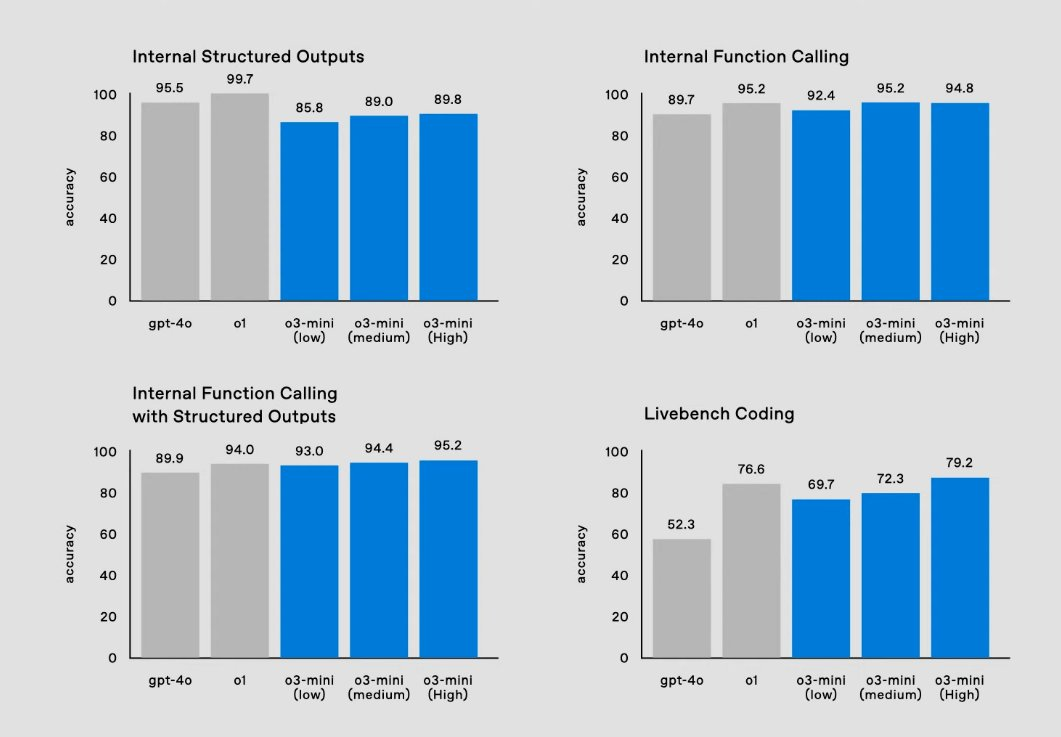

o3-mini: o3 mini ist eine kostengünstigere Version von o3, die sich auf die Verbesserung der Inferenzgeschwindigkeit und die Verringerung der Inferenzkosten unter Berücksichtigung der Modellleistung konzentriert. Hohe Leistung und niedrige Kosten machen es ideal für die Programmierung.

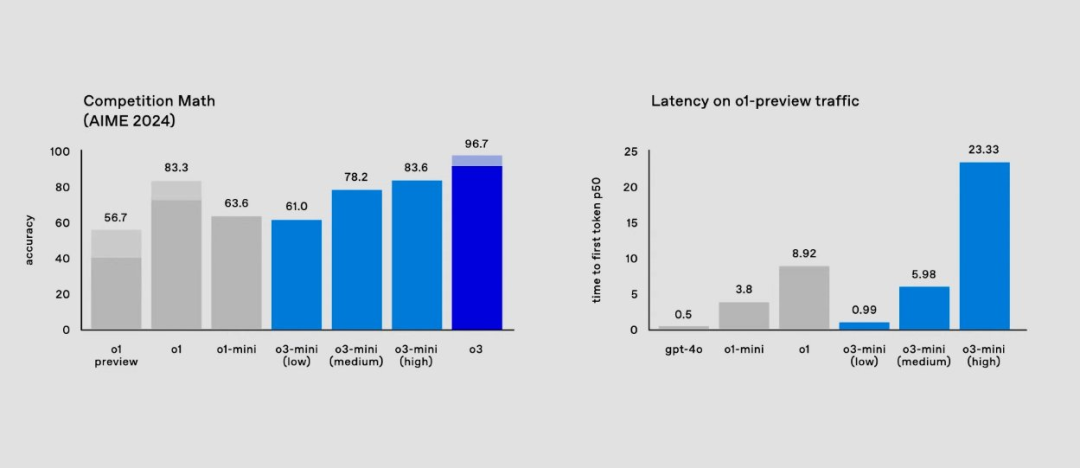

Es unterstützt drei verschiedene Optionen für die Inferenzzeit: niedrig, mittel und hoch.

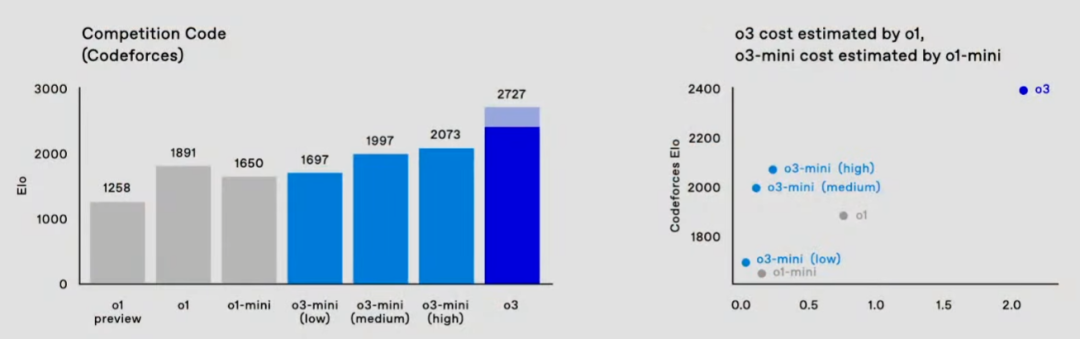

Im Vergleich zu o1 ist die Leistung von o3-mini auf Codeforces bemerkenswert kosteneffizient, was ihn zu einem hervorragenden Modell für die Programmierung macht.

Bei mathematischen Problemen erreicht o3-mini (low) eine geringe Latenzzeit, die mit gpt-4o vergleichbar ist.

Alle API-Funktionen von o3-mini und die entsprechenden Möglichkeiten sind unten aufgeführt:

o3 Eignungstests

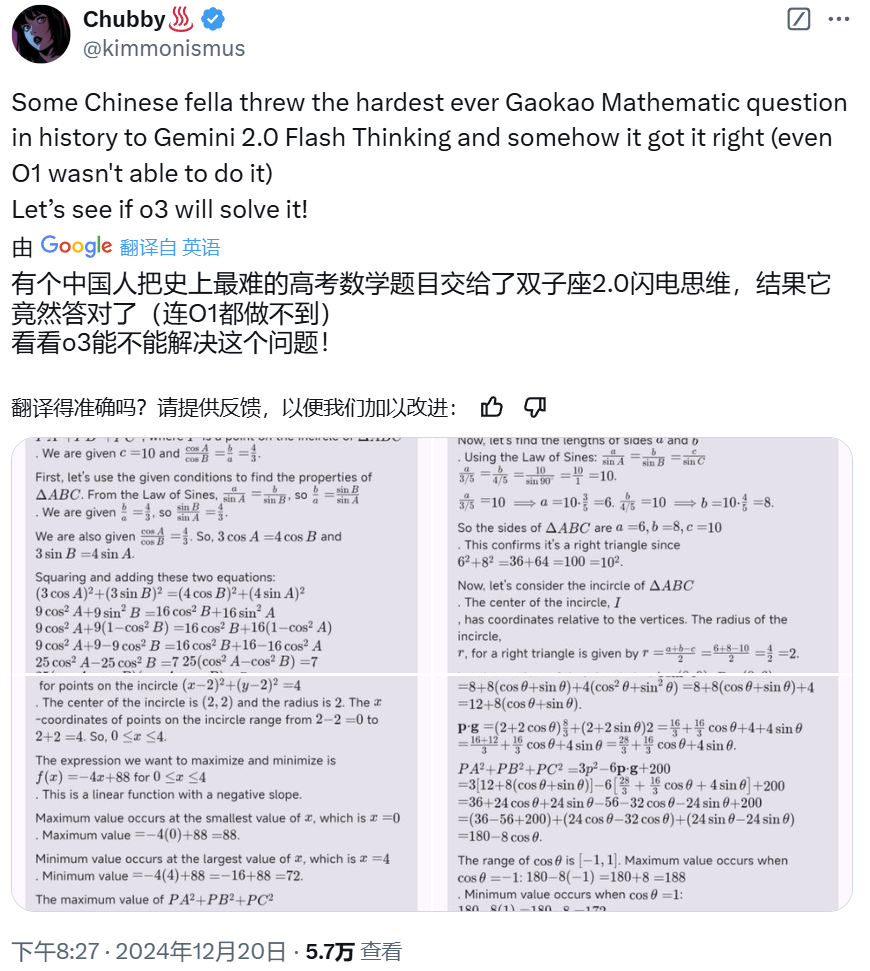

Wie stark ist der o3 im Vergleich zu Googles gerade veröffentlichtemGemini 2.0 Flash ThinkingVergleichen Sie:

Die Fähigkeit des o3 ist ein direkter Tiefschlag für fast alle Modelle, die es heutzutage gibt. Schauen Sie sich an, wozu der o3 fähig ist.

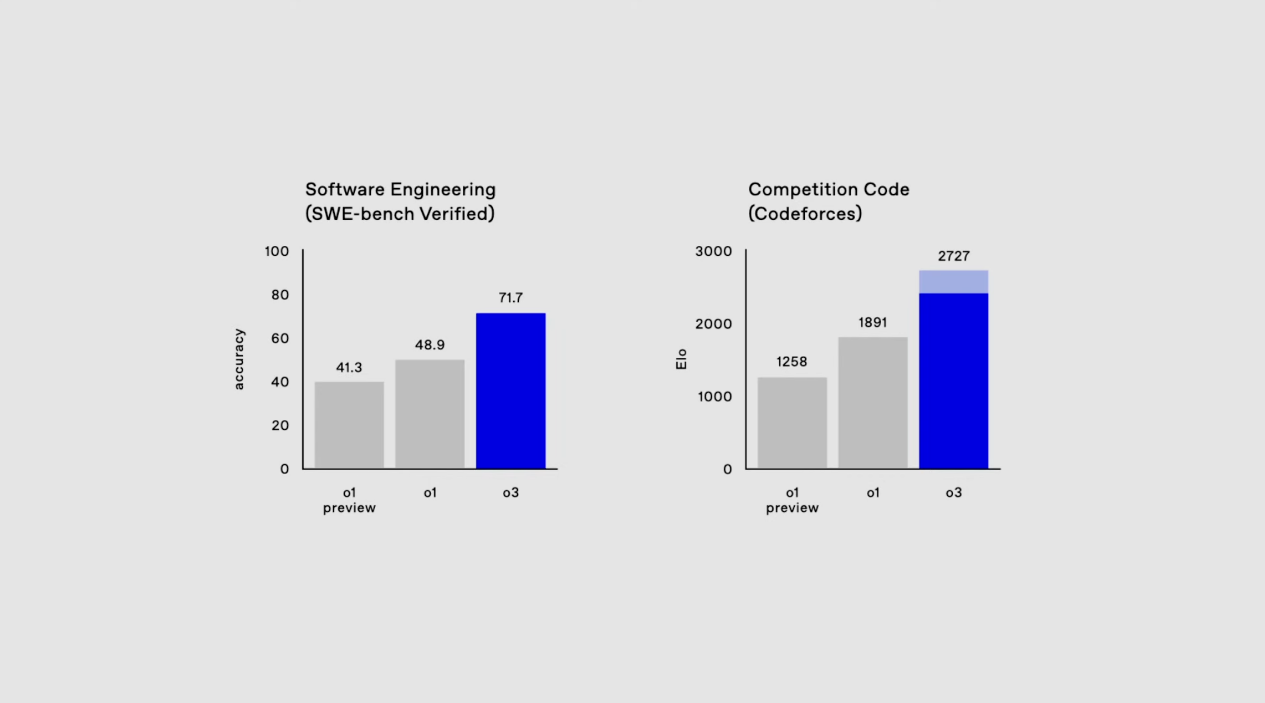

Auf der linken Seite.Software-Engineering-Prüfung (SWE-Bench Verified).Dies ist wie ein Test für das Schreiben von Programmen, z. B. schreibt man ein Stück Software, das schnell und genau sein soll und keine Bugs (kleine Fehler) enthalten darf. Damit soll überprüft werden, ob o3 perfekten Code wie ein erstklassiger Software-Ingenieur schreiben kann. o3s Ergebnis: 71,7%, was immer noch viel stärker ist als o1. Der Benchmark auf der rechten Seite ist etwas aggressiver, nämlich Codeforces, eine weltweit bekannte Plattform für Programmierwettbewerbe. o3 hat eine Punktzahl von 2.727, was dem 175. Platz in der gesamten Liste entspricht und die 99,99% von Menschen bereits übertroffen hat.

Die Programmierfähigkeit des o1 ist explosiv, und der o3 ist ein weiterer großer Schritt auf dem Weg zur Spitze des Berges der AGI.

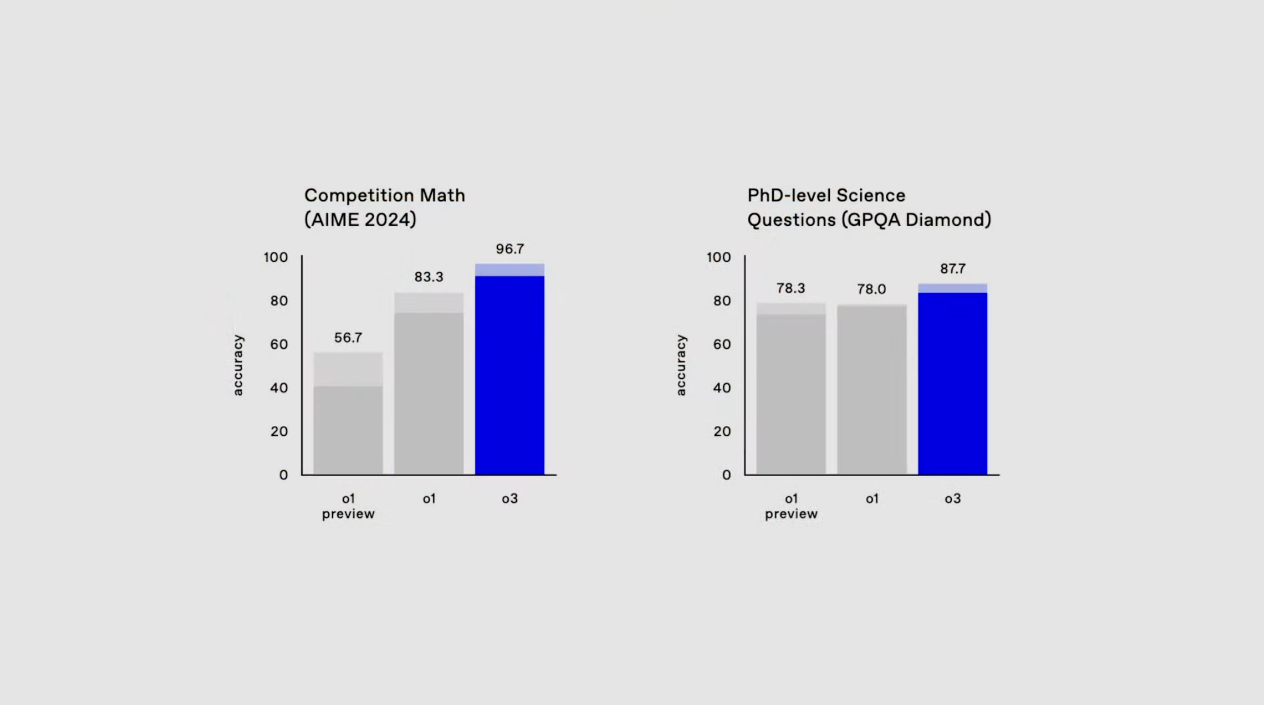

Der Mathematikwettbewerb AIEM 2024 und die wissenschaftliche Doktorprüfung GPQA Diamond. aIEM 2024 war nahe an einer perfekten Punktzahl, und wenn ich mich richtig erinnere, war es das erste Mal, dass eine KI ein Niveau erreicht hat, bei dem es eine AIEM nahe an einer perfekten Punktzahl gab. Die wissenschaftlichen Prüfungen auf PhD-Ebene haben sich weiterentwickelt, aber nicht so stark wie Mathematik und Programmierung.

Der Mathematikwettbewerb AIEM 2024 und die wissenschaftliche Doktorprüfung GPQA Diamond. aIEM 2024 war nahe an einer perfekten Punktzahl, und wenn ich mich richtig erinnere, war es das erste Mal, dass eine KI ein Niveau erreicht hat, bei dem es eine AIEM nahe an einer perfekten Punktzahl gab. Die wissenschaftlichen Prüfungen auf PhD-Ebene haben sich weiterentwickelt, aber nicht so stark wie Mathematik und Programmierung.

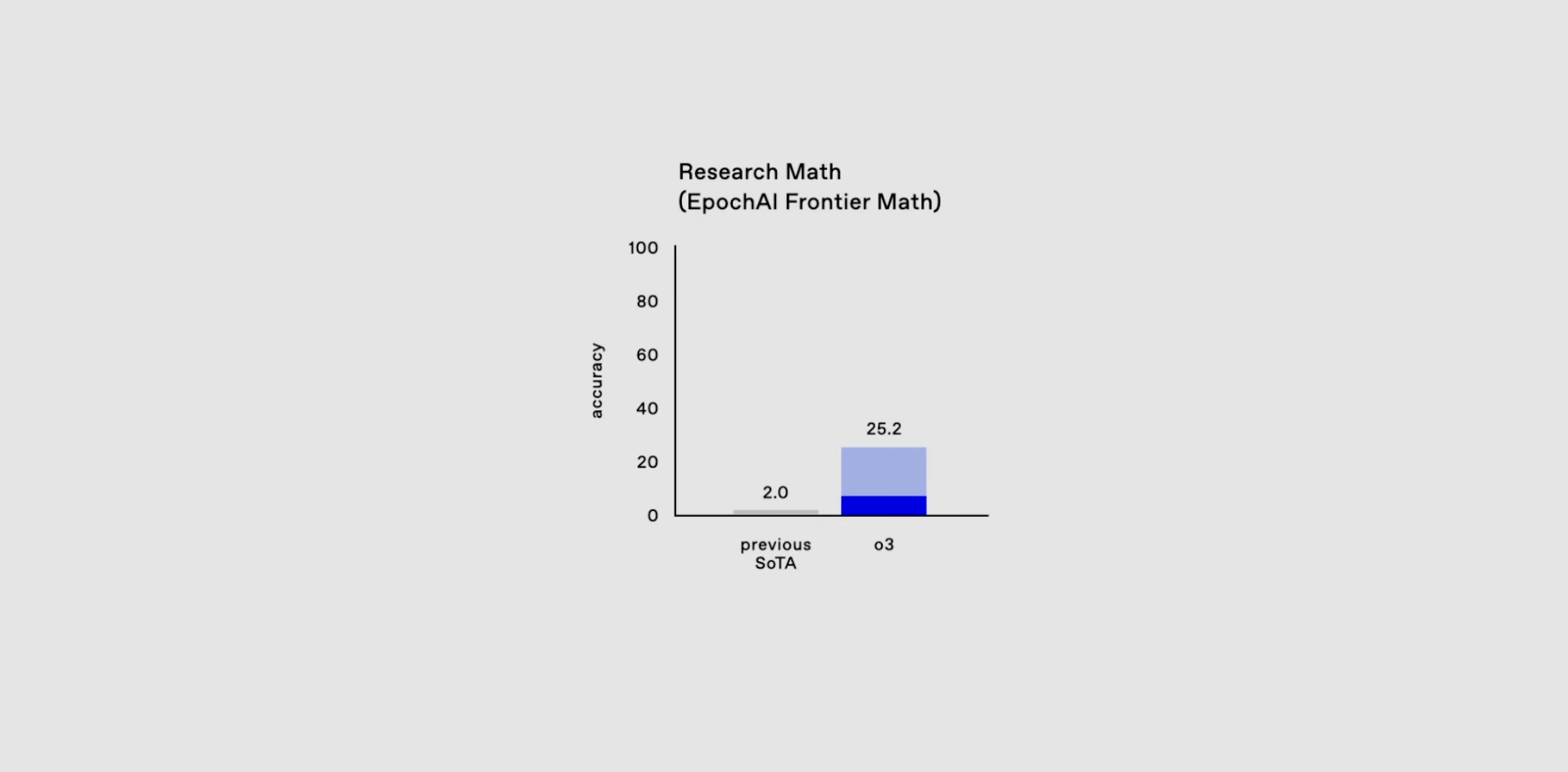

Der nächste Mathe-Benchmark ist ein wenig interessanter.  rontierMath, ein von Epoch AI entwickelter Mathe-Benchmark-Test, wurde in Zusammenarbeit mit mehr als 60 führenden Mathematikern entwickelt, um die Fähigkeiten der KI im Bereich des fortgeschrittenen mathematischen Denkens zu bewerten. Um eine Kontaminierung der Daten zu vermeiden, sind alle Fragen originell und neu und wurden noch nie zuvor veröffentlicht.

rontierMath, ein von Epoch AI entwickelter Mathe-Benchmark-Test, wurde in Zusammenarbeit mit mehr als 60 führenden Mathematikern entwickelt, um die Fähigkeiten der KI im Bereich des fortgeschrittenen mathematischen Denkens zu bewerten. Um eine Kontaminierung der Daten zu vermeiden, sind alle Fragen originell und neu und wurden noch nie zuvor veröffentlicht.

Zuvor waren GPT-4 und Zwillinge 1.5 Pro Dieses Modell geht für eine Bewertung mit weniger als 21 TP3T erfolgreicher Leistung, im Gegensatz zu der Erfolgsrate von mehr als 901 TP3T in anderen traditionellen mathematischen Benchmarks wie GSM-8K und MATH. Und dieses Mal.o3 direkt auf 25,2. Während alle anderen großen Modelle immer noch traditionelle Mathematik-Benchmarks durchführen, hat o3 wirklich eine andere Welt betreten.

o3 durchbricht als erstes KI-Modell die ARC-AGI-Benchmarks

Die ARC Prize Fundation ist eine gemeinnützige Organisation, die sich zum Ziel gesetzt hat, "der Nordstern auf dem Weg zur AGI durch Benchmarking zu sein". Der erste Benchmark der Organisation, ARC-AGI, wird seit fünf Jahren vorgeschlagen, konnte aber noch nicht umgesetzt werden.

Kamradt gab bekannt, dass o3 im Benchmark hervorragende Werte erreicht hat und damit das erste KI-Modell ist, das den ARC-AGI-Benchmark durchbricht.

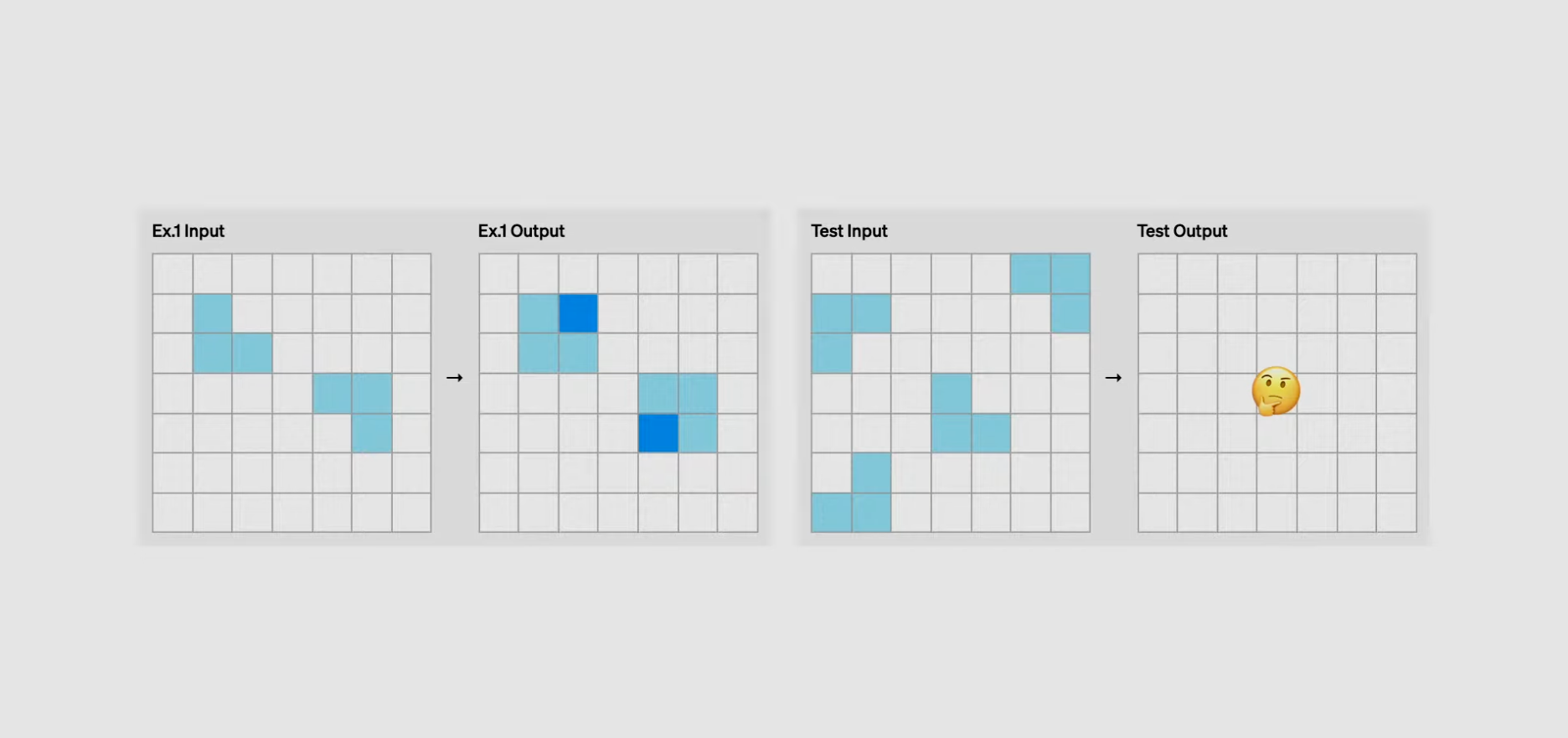

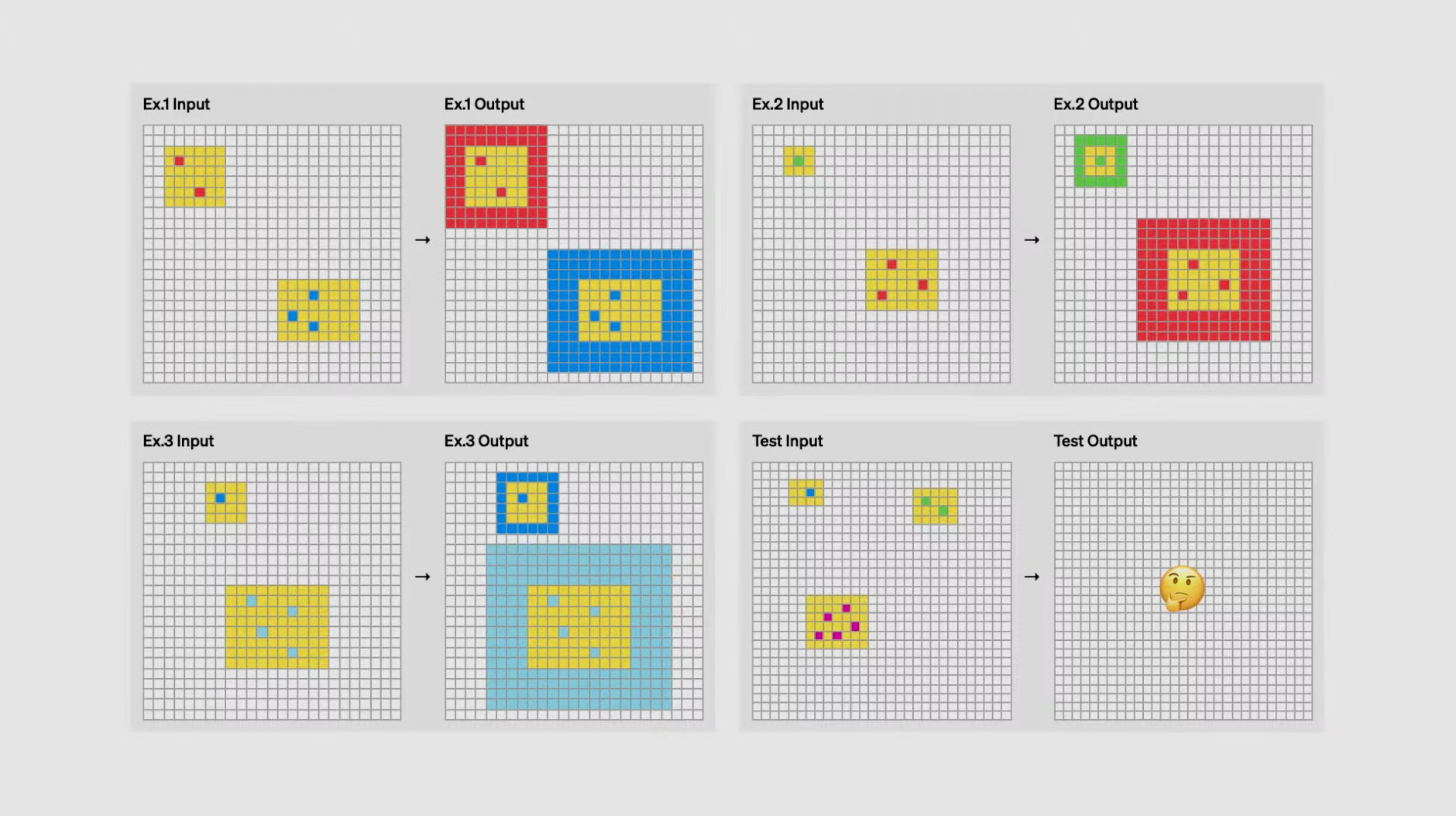

ARC-AGI, das 2019 erstmals vorgestellt wird, soll die Fähigkeiten von KI-Systemen anhand einer Reihe von Abstraktions- und Schlussfolgerungsaufgaben testen. Hauptsächlich deshalb, weil herkömmliche Maßstäbe für Fähigkeiten die Intelligenz nicht effektiv darstellen, da sie dazu neigen, sich auf Vorwissen und Erfahrung zu stützen, während wahre Intelligenz sich in umfassender Anpassungsfähigkeit und Verallgemeinerbarkeit widerspiegeln sollte. So wurde ARC-AGI geboren, und in diesen Aufgaben muss die KI Muster erkennen und neue Probleme lösen, wobei jede Aufgabe aus Input-Output-Beispielen besteht. Diese Aufgaben werden in Form eines Gitters präsentiert, wobei jedes Quadrat eine von zehn Farben haben kann und die Größe des Gitters von 1x1 bis 30x30 variieren kann. Die Teilnehmer müssen auf der Grundlage der gegebenen Eingaben korrekte Ausgaben generieren und dabei ihr logisches Denken und ihre Abstraktionsfähigkeit testen. Man kann es einfach so verstehen, dass es darum geht, Muster zu finden. So funktioniert es wahrscheinlich auch:

Beim ARC-AGI-Benchmark muss die KI nach Mustern suchen, die auf gepaarten "Input-Output"-Beispielen beruhen, bevor sie den Output auf der Grundlage eines Inputs vorhersagen kann (siehe Abbildung unten). Denjenigen, die an den Einstellungsprüfungen für die Abschlussjahrgänge oder an den Prüfungen für den öffentlichen Dienst teilgenommen haben, sind solche Aufgaben zum grafischen Denken vielleicht nicht fremd.

Sehr schwierig und abstrakt. Bewertungen für frühere Generationen von Modellen finden Sie hier:

Die o3-Modellfamilie soll beim ARC-AGI-Benchmark eine Mindestleistung von 75,7% erreichen, und o3 ist sogar in der Lage, 87,5% zu erreichen, wenn man es erlaubt, längere Zeit mit mehr Rechenressourcen zu denken. Von 0% bis 5% dauerte es fünf ganze Jahre, aber jetzt, von 5% bis 87,5%, dauerte es nur noch ein halbes Jahr. Und der entsprechende, menschliche Schwellenwert liegt bei 85%. Es gibt kein Hindernis mehr auf unserem Weg zum AGI.

Von 0% bis 5% dauerte es fünf ganze Jahre, aber jetzt, von 5% bis 87,5%, dauerte es nur noch ein halbes Jahr. Und der entsprechende, menschliche Schwellenwert liegt bei 85%. Es gibt kein Hindernis mehr auf unserem Weg zum AGI.

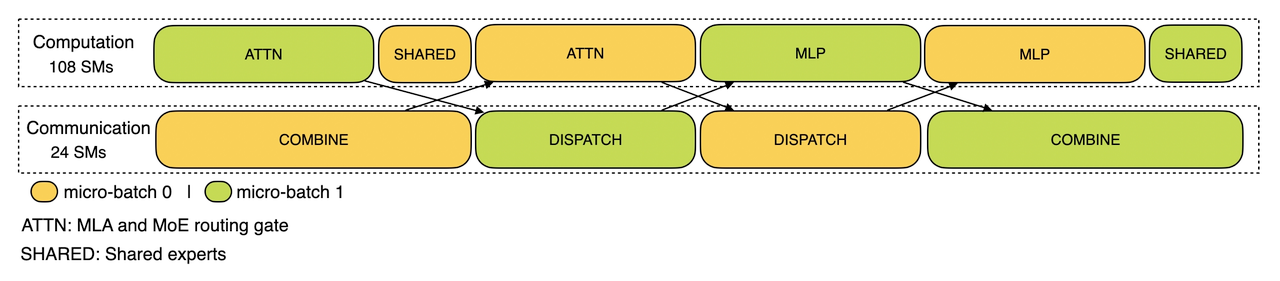

o3 Wie das Modell funktioniert

An dieser Stelle können wir nur ein wenig darüber spekulieren, wie das o3-Modell funktioniert. Der Kernmechanismus des o3-Modells scheint in der Token Raum für die Suche und Ausführung natürlichsprachlicher Programme - während des Tests durchsucht das Modell den Raum möglicher Gedankenketten, die die zur Lösung der Aufgabe erforderlichen Schritte beschreiben, auf eine Weise, die auf eine Art und Weise, die eine gewisse Ähnlichkeit mit der Monte-Carlo-Baumsuche im Stil von AlphaZero aufweist. Im Falle von o3 kann die Suche durch eine Art Bewertungsmodell geleitet werden. Es ist erwähnenswert, dass Demis Hassabis von DeepMind in einem Interview im Juni 2023 angedeutet hat, dass DeepMind an diesem Konzept gearbeitet hat - eine Arbeit, die schon seit langem in Arbeit ist.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...