OpenAIs Modelle der nächsten Generation stoßen auf einen großen Engpass, ehemaliger Chefwissenschaftler enthüllt neue Route

OpenAIs großes Sprachmodell der nächsten Generation, Orion, stößt möglicherweise auf einen noch nie dagewesenen Engpass. Laut The Information sagen OpenAI-Mitarbeiter, dass die Leistungssteigerungen des Orion-Modells hinter den Erwartungen zurückgeblieben sind und dass die Qualitätssteigerungen "viel geringer" sind als beim Upgrade von GPT-3 auf GPT-4.

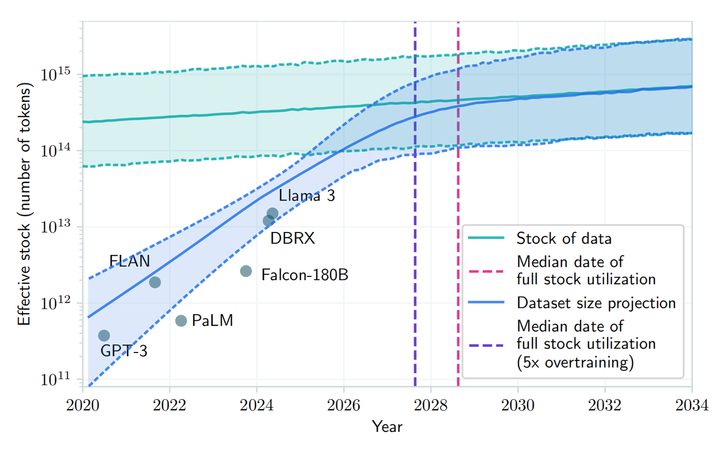

Darüber hinaus ist Orion bei bestimmten Aufgaben nicht so stabil wie sein Vorgänger GPT-4. Trotz der größeren linguistischen Fähigkeiten von Orion wird die Programmierleistung die von GPT-4 möglicherweise nicht übertreffen. Schwindende Ressourcen für das Training von qualitativ hochwertigen Texten und anderen Daten haben es schwieriger gemacht, qualitativ hochwertige Trainingsdaten zu finden, was die Entwicklung von Large Language Models (LLMs) verlangsamt hat.

Und nicht nur das: Künftiges Training wird noch rechenintensiver sein, was Geld und sogar Strom kostet, was bedeutet, dass die Kosten für die Entwicklung von Orion und nachfolgenden großen Sprachmodellen erheblich steigen werden. openAI-Forscher Noam Brown sagte kürzlich auf der TED-KI-Konferenz, dass fortgeschrittenere Modelle möglicherweise "wirtschaftlich nicht machbar" sind:

Werden wir wirklich Hunderte von Milliarden oder Billionen von Dollar für die Ausbildung von Modellen ausgeben? Irgendwann wird das Gesetz der Skalierung nicht mehr greifen.

OpenAI hat ein Gründungsteam unter der Leitung von Nick Ryder ins Leben gerufen, das sich mit der Frage beschäftigt, wie mit der zunehmenden Knappheit von Trainingsdaten umgegangen werden kann und wie lange die Skalierungsgesetze großer Modelle Bestand haben werden.

Noam Braun

Die Skalierungsgesetze sind eine der Grundannahmen in der KI: Solange es mehr lernfähige Daten und mehr Rechenleistung für den Trainingsprozess gibt, kann sich die Leistung eines großen Sprachmodells im gleichen Tempo weiter verbessern. Kurz gesagt, das Skalierungsgesetz beschreibt die Beziehung zwischen dem Ressourceninput (Datenmenge, Rechenleistung, Modellgröße) und dem Leistungsoutput des Modells. Das heißt, das Ausmaß, in dem sich die Leistung verbessert, wenn mehr Ressourcen in das große Sprachmodell investiert werden.

Das Trainieren eines großen Sprachmodells kann beispielsweise mit der Herstellung eines Autos verglichen werden: Zu Beginn ist die Fabrik klein, mit nur einigen Maschinen und wenigen Arbeitern, und zu diesem Zeitpunkt führt jede zusätzliche Maschine oder jeder zusätzliche Arbeiter zu einer erheblichen Steigerung der Produktion, da die zusätzlichen Ressourcen direkt in Produktivität umgesetzt werden. Mit zunehmender Größe der Fabrik nimmt die Produktionssteigerung pro zusätzlicher Maschine oder Arbeiter jedoch ab, was möglicherweise auf die zunehmende Komplexität des Managements oder die weniger effiziente Zusammenarbeit der Arbeiter zurückzuführen ist.

Wenn eine Fabrik eine bestimmte Größe erreicht, kann das Hinzufügen von mehr Maschinen oder Arbeitern zu einem begrenzten Anstieg der Produktion führen, und an diesem Punkt kann sich die Fabrik den Grenzen ihrer Ressourcen, wie Landversorgung und Logistik, nähern. Dies ist genau das Dilemma, mit dem das Orion-Modell konfrontiert ist: Mit zunehmender Größe des Modells (ähnlich wie mit dem Hinzufügen von mehr Maschinen und Arbeitern) ist die Leistungsverbesserung des Modells in den frühen und mittleren Phasen sehr signifikant, aber in den späteren Phasen wird die Leistungsverbesserung kleiner, selbst wenn die Modellgröße oder die Menge der Trainingsdaten erhöht wird. Dies wird als "gegen die Wand laufen" bezeichnet.

Einem Papier auf arXiv zufolge wird vorhergesagt, dass die Entwicklung von großen Sprachmodellen zwischen 2026 und 2032 die Ressourcen für öffentliche menschliche Texte erschöpfen könnte, da die Nachfrage nach öffentlichen menschlichen Textdaten steigt und diese nur begrenzt verfügbar sind. Norm Brown weist zwar darauf hin, dass es "wirtschaftliche Probleme" bei der Ausbildung künftiger Modelle gibt, argumentiert aber dagegen, dass "die Entwicklung der KI in absehbarer Zeit nicht nachlassen wird".

Die Forscher von OpenAI teilen im Allgemeinen diese Ansicht, und obwohl sich das Gesetz der Skalierung verlangsamen könnte, wird die KI-Entwicklung insgesamt durch die Optimierung der Inferenzzeiten und Verbesserungen nach dem Training nicht wesentlich beeinträchtigt.Meta-CEO Mark Zuckerberg, OpenAI-CEO Sam Altman und andere KI CEOs von KI-Entwicklern haben ebenfalls öffentlich erklärt, dass die traditionellen Grenzen des Skalierungsgesetzes noch nicht erreicht sind und dass sie immer noch teure Datenzentren entwickeln, um die Leistung von vortrainierten Modellen zu verbessern.

Peter Welinder, VP of Products bei OpenAI, erklärte in den sozialen Medien, dass "die Macht der Testzeitberechnung unterschätzt wird". Test-Time-Computation (TTC) ist ein Konzept des maschinellen Lernens, das sich auf die Berechnungen bezieht, die stattfinden, wenn ein Modell eingesetzt wird, um Schlussfolgerungen oder Vorhersagen über neue Eingabedaten zu machen, und die von den Berechnungen getrennt sind, die während des Trainings stattfinden. Die Trainingsphase ist der Prozess, in dem das Modell Datenmuster lernt, während die Testphase der Prozess ist, in dem das Modell auf reale Aufgaben angewendet wird.

Herkömmliche Modelle für maschinelles Lernen sagen in der Regel neue Dateninstanzen ohne zusätzliche Berechnungen voraus, sobald sie trainiert und eingesetzt wurden. Einige komplexere Modelle, wie z. B. bestimmte Arten von Deep-Learning-Modellen, können jedoch zusätzliche Berechnungen zum Testzeitpunkt (Inferenzzeit) erfordern. Das von OpenAI entwickelte Modell "o1" verwendet diese Art von Inferenzmuster. Die KI-Branche insgesamt verlagert ihren Schwerpunkt auf die Optimierungsphase des Modells, sobald das anfängliche Training abgeschlossen ist.

Peter Welinder

Ilya Sutskever, einer der Mitbegründer von OpenAI, räumte kürzlich in einem Interview mit Reuters ein, dass die Verbesserung der Effektivität der Pre-Training-Phase, in der große Mengen unmarkierter Daten verwendet werden, um KI-Modelle für das Verständnis sprachlicher Muster und Strukturen zu trainieren, auf einem Plateau angelangt ist. "Die 2010er Jahre waren die Ära der Expansion, und jetzt sind wir wieder in der Ära der Erforschung und Entdeckung angekommen", sagte er. Er stellte außerdem fest: "Die Verbesserung der Genauigkeit ist wichtiger denn je."

Der Start von Orion ist für 2025 geplant, und OpenAI hat es "Orion" statt "GPT-5" genannt, was vielleicht auf eine ganz neue Revolution hindeutet. Obwohl es aufgrund theoretischer Beschränkungen derzeit "schwer zu produzieren" ist, wird erwartet, dass dieses neu benannte "Neugeborene" eine transformative Gelegenheit für die KI-Makromodellierung bieten wird.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...