OpenAI-o3 und Monte-Carlo-Ideen

o3 ist hier, um einige persönliche Einblicke zu geben. Über Testzeit Skalierungsgesetz Fortschritte, viel schneller als wir dachten. Aber ich würde sagen, dass der Weg tatsächlich ein wenig verworren ist - es ist OpenAIs Art und Weise, einen Kurvenball in seinem Streben nach AGI zu nehmen.

Intensives Lernen und Abkürzungsdenken

Warum ist das so? Lassen Sie uns dies anhand von zwei Beispielen untersuchen.

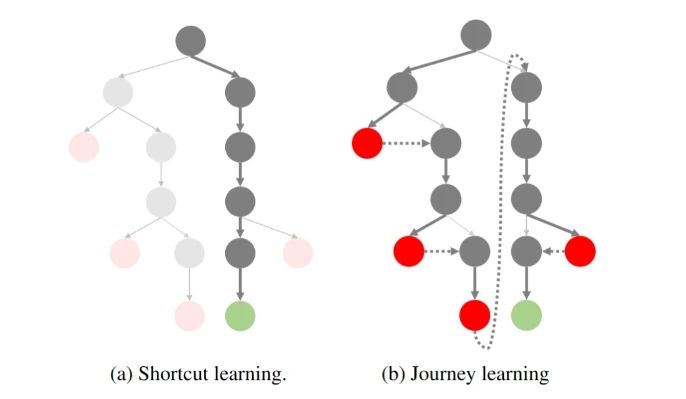

Das erste Beispiel stammt aus dem Verstärkungslernen. Beim Verstärkungslernen spielt der Abzinsungsfaktor eine wichtige Rolle, was bedeutet, dass die erzielte Belohnung allmählich abnimmt, je weiter die Entscheidungsschritte fortschreiten. Daher besteht das Ziel des Verstärkungslernens in der Regel darin, die Belohnung in der kürzest möglichen Zeit und in den wenigsten Schritten zu maximieren. Der Schwerpunkt dieser Strategie liegt auf "Abkürzungen", d. h. darauf, die Belohnung so schnell wie möglich zu erhalten.

Das zweite Beispiel ist der Prozess der Feinabstimmung großer Modelle. Ein vorab trainiertes Modell, das nicht feinabgestimmt wurde, hat oft keine klare Richtung oder Kontrolle. Wenn wir das Modell fragen: "Wo ist die Hauptstadt von China?" kann es zunächst sagen: "Das ist eine gute Frage" und dann in eine andere Richtung gehen, bevor es schließlich die Antwort "Peking" gibt. Wird dieselbe Frage jedoch einem fein abgestimmten Modell gestellt, ist die Antwort klar und deutlich: "Peking".

Dieses fein abgestimmte Modell zeigt einen Weg auf, um durch eine Optimierungsstrategie - ähnlich der evolutionären Reise des Menschen - Abkürzungen zu erhalten, wobei stets der geringste Energieverbrauch und der kürzeste Weg angestrebt werden.

Warum Reasoning?

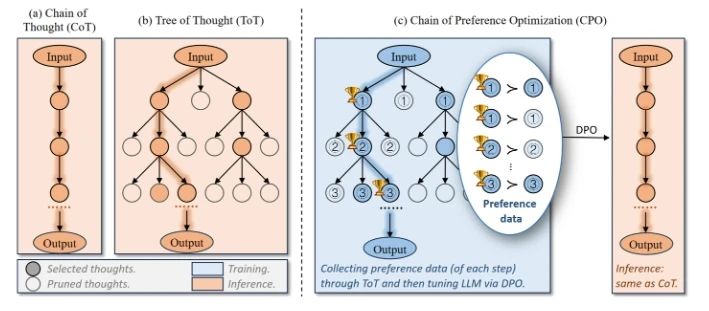

Stellen Sie sich den Reasoning-Stichprobenprozess wie einen Baum vor:

O1 Replikationsreise: Teil 1

Auf der linken Seite ist die Abkürzung zu sehen, die wir in der Vergangenheit verfolgt haben: die geringste Anzahl von Schritten, um zum richtigen Ergebnis zu gelangen. Auf der rechten Seite ist das "reflektierende, retrospektive" Paradigma zu sehen, das von OpenAI o1 vertreten wird.

Wir wissen, dass das Modell bei der Suche von o1 ständig reflektiert und zurückverfolgt wird, und dieser Prozess ist oft mit zusätzlichem Overhead verbunden. Das Problem ist, wer will schon Zeit und Geld für eine komplexe Suche ausgeben, wenn das Modell tatsächlich immer wieder die richtige Antwort geben kann?OpenAI ist nicht dumm, und wir alle wissen, dass Abkürzungen besser sind!

Je schwieriger das Problem ist, desto breiter ist der potenzielle Ideenbaum, desto mehr Suchraum gibt es bei jedem Schritt, und desto unwahrscheinlicher ist es, dass eine Abkürzung zur richtigen Antwort führt. Was ist also zu tun? Ein intuitiver Weg, darüber nachzudenken, besteht darin, den Baum zu beschneiden! Man schneidet die Baumknoten ab, bei denen es unwahrscheinlich ist, dass sie den Endpunkt vorzeitig erreichen, wodurch der Suchraum komprimiert und der Baum wieder schmaler wird. Das ist es, was viele derzeitige Bemühungen versuchen, zum Beispiel:

Optimierung der Präferenzkette (CPO)

Bei der Optimierung der Präferenzkette geht es darum, auf natürliche Weise Präferenzdaten aus dem Denkbaum zu konstruieren und diese dann mithilfe von DPO so zu optimieren, dass das Modell eine höhere Wahrscheinlichkeit hat, den Baumknoten auszuwählen, der den Endpunkt erreicht.

Ergebnisüberwachte Wertmodelle (OVM)

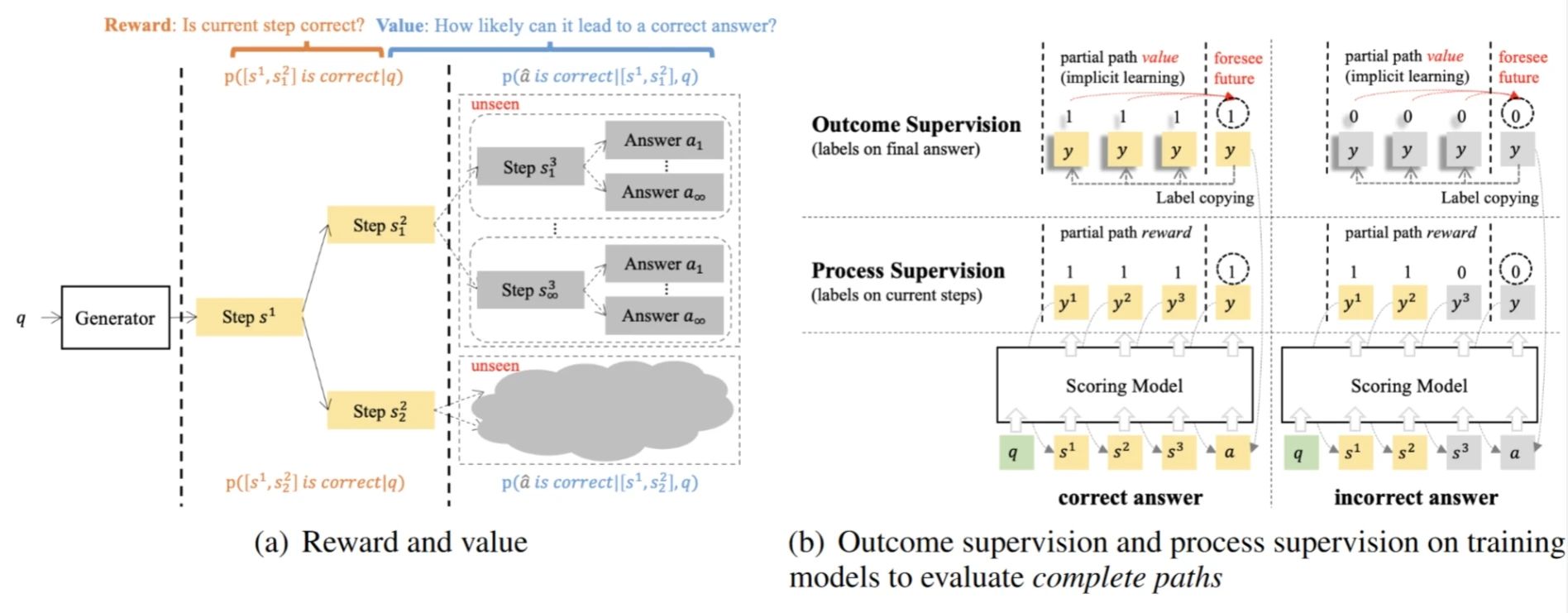

Outcome-supervised Value Models ist die Modellierung von Reasoning als MDP-Prozess, bei dem die Wahrscheinlichkeit, im aktuellen Schritt die richtige Antwort zu erhalten (Value), zur Steuerung der Strategieoptimierung verwendet wird.

Warum hat sich OpenAI dafür entschieden, sich von den traditionellen Abkürzungen zu lösen?

Zurück zu o1: Warum haben Sie sich entschieden, mit der traditionellen Abkürzung zu brechen und den "Umweg" der Baumsuche zu wählen?

Wenn wir in der Vergangenheit dazu tendiert haben, die grundlegenden Fähigkeiten von (Exploit-)Modellen auszunutzen, könnte man davon ausgehen, dass die bestehenden GPT-4-Modelle in der Lage waren, die meisten Anforderungen an Dialoge und einfache Schlussfolgerungen zu erfüllen. Und diese Aufgaben können gut abgetastet, Präferenzen bewertet und iterativ optimiert werden.

Diese Sichtweise ignoriert jedoch den Bedarf an komplexeren Aufgaben - wie mathematisches Denken (AIME, Frontier Math), Codegenerierung (SWE-Bench, CodeForce) usw., die häufig kurzfristig schwer zu belohnen sind. -Ihre Belohnungen sind sehr spärlich, und die Belohnungen werden erst sichtbar, wenn die richtige Antwort endlich erreicht ist.

Folglich ist das traditionelle Lernen mit Abkürzungen nicht mehr geeignet, um diese Art von komplexer Aufgabe zu bewältigen: Wie kann man davon sprechen, die Wahrscheinlichkeit zu optimieren, dass das Modell den richtigen Weg wählt, wenn man nicht einmal einen richtigen Weg abtasten kann?

Wenn wir auf die "Monte-Carlo-Idee" im Titel dieses Papiers zurückkommen, sehen wir, dass es sich eigentlich um dasselbe handelt: Der Kern des Monte-Carlo-Ansatzes beim Reinforcement Learning besteht darin, den Wert einer Strategie durch mehrfache Stichproben zu schätzen und so das Modell zu optimieren. Dieser Ansatz hat jedoch eine natürliche Einschränkung: Wenn die abgetasteten Strategien nicht die optimalen Pfade abtasten können, dann wird die Modelloptimierung immer mit einem lokalen Optimum enden. Aus diesem Grund entscheiden wir uns beim MC-Lernen für eine eher explorative Strategie.

Daher entschied sich OpenAI, die Maßstäbe des Verstärkungslernens zu durchbrechen, indem es sich von der traditionellen Abkürzungsmentalität zugunsten der Verstärkungsexploration (Explore) entfernte.

o1 Durchbrüche: von der Exploration zur Optimierung

In diesem Zusammenhang hat OpenAI das o1-Paradigma vorgeschlagen. Diese Änderung ermöglicht es dem Modell, bei komplexen Aufgaben nach und nach spärliche Belohnungen zu erhalten! Und durch diese Belohnungen kann die Strategie kontinuierlich optimiert werden. Obwohl dieser Erkundungsprozess mühsam und ineffizient erscheinen mag, legt er die Grundlage für eine weitere Optimierung des Modells.

Woher kommt das o1 also? In letzter Zeit wurde auch viel an der Replikation von o1 gearbeitet, was machen sie? Wenn die für die Exploration verwendete Verhaltenspolitik der On-Policy-Ansatz ist, wird mit dem aktuellen Modell (z. B. GPT-4o), das immer noch zu ineffizient ist, probiert.

Also entschieden sich die Jungs einstimmig für die Off-Policy-Methode:

OpenAI gibt eine Menge Geld aus, um Doktoranden für die Annotation von Long CoT-Daten einzustellen; kein Geld? Was können wir tun, wenn wir das Geld nicht haben? Dann können wir mit Menschen und Maschinen zusammenarbeiten, um die Daten zu annotieren (o1 manuell destillieren) und die Anforderungen an Annotatoren zu reduzieren; Wir haben nicht einmal das Geld, um Annotatoren zu finden? Dann müssen wir R1 / QwQ destillieren oder andere Wege finden (Critique, PRM, etc.). Ich möchte auch die großen Hersteller und Labors, die aktiv o1 reproduzieren, daran erinnern, dass das ultimative Ziel der Erforschung immer noch die Optimierung ist!

插一句题外话,虽然大家都在骂 o1 隐藏了真正的思维链,只展示 Summary 的捷径版本。殊不知这个 Summary 才是优化策略的关键数据!但 OpenAI 并不害怕其他人蒸馏这些 Summary,因为蒸馏这些数据还有一个前提——基础模型的能力足够强大,不然步子迈太大还容易闪了腰。

并且 OpenAI 还将探索的成本转嫁给了用户。虽然在初期花很多钱来标注探索型数据,但现在有了 o1 后,用户使用的过程中又无形地为他标注了更多数据。OpenAI 再次实现了伟大的数据飞轮!

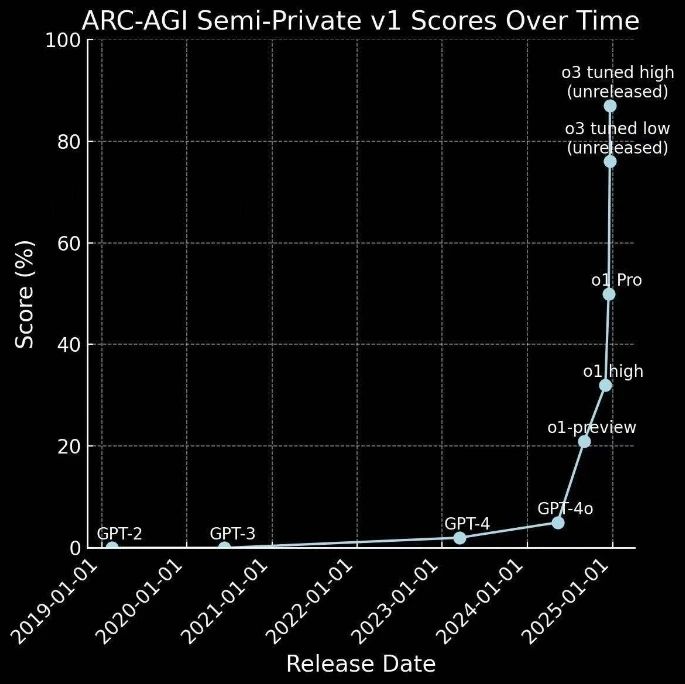

Schnelle Entwicklung von o1 zu o3

Das o1 wurde erst vor ein paar Monaten auf den Markt gebracht, und jetzt kommt schon das o3.

Damit wird die vorherige Vermutung umgangen: Wenn GPT-4 eine Progression von 0 bis 1 darstellt - d. h. von einfachen Aufgaben bis zum Erhalt von Belohnungen -, dann stellt o1 einen Sprung von 1 bis 10 dar - durch die Erkundung komplexer Aufgaben und den Erhalt seltener Belohnungen, was eine noch nie dagewesene Menge an hochwertigen Daten für die weitere Strategieoptimierung liefert.

Sie hat sich also schneller entwickelt als erwartet:

Dies ist nicht nur eine erfolgreiche Anwendung der Explorationsstrategie, sondern auch ein wichtiger Schritt für die KI-Technologie in Richtung AGI.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...