Einführung in das OpenAI o1-mini-Makromodell

Förderung kosteneffizienter Argumentationstechniken.

Wir haben OpenAI o1-mini auf den Markt gebracht, ein kosteneffizientes Inferenzmodell. o1-mini zeichnet sich in MINT-Fächern, insbesondere in Mathematik und Programmierung, durch eine Leistung aus, die fast so gut ist wie die des OpenAI o1 vergleichbare Leistung bei Benchmark-Tests wie AIME und Codeforces. Wir gehen davon aus, dass o1-mini eine schnellere und erschwinglichere Option für Anwendungsszenarien sein wird, die logisches Denken erfordern, aber nicht auf umfangreiches Weltwissen angewiesen sind.

Heute bieten wir das OpenAI o1-preview für 80% billiger an als das OpenAI o1-preview. Tier 5 API-Benutzer (öffnet in einem neuen Fenster) Einführung von o1-mini. ChatGPT Plus-, Team-, Enterprise- und Edu-Benutzer können o1-mini als Alternative zu o1-preview verwenden und profitieren von höheren Nutzungsgrenzen und niedrigeren Latenzzeiten, siehe [Model Speed.

Optimiert für MINT-Denken

Große Sprachmodelle wie o1 werden in der Regel auf großen Textdatensätzen vortrainiert. Trotz ihres umfangreichen Weltwissens können diese Modelle mit hoher Kapazität in realen Anwendungen teuer und langsam sein. Im Gegensatz dazu ist o1-mini ein kleines Modell, das in der Pre-Trainingsphase speziell für MINT-Fragen optimiert wurde. Nachdem es mit der gleichen rechenintensiven Reinforcement Learning (RL)-Pipeline wie o1 trainiert wurde, erbringt o1-mini vergleichbare Leistungen bei vielen praktischen Argumentationsaufgaben und ist dabei deutlich kostengünstiger.

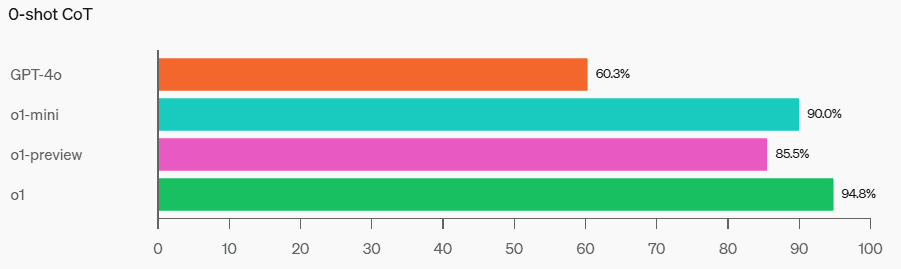

In Benchmark-Tests, die Intelligenz und logisches Denken erfordern, schneidet o1-mini besser ab als o1-preview und o1. o1-mini schneidet jedoch schlecht ab, wenn es um Aufgaben geht, die Faktenwissen außerhalb des MINT-Bereichs erfordern, siehe [Einschränkungen].

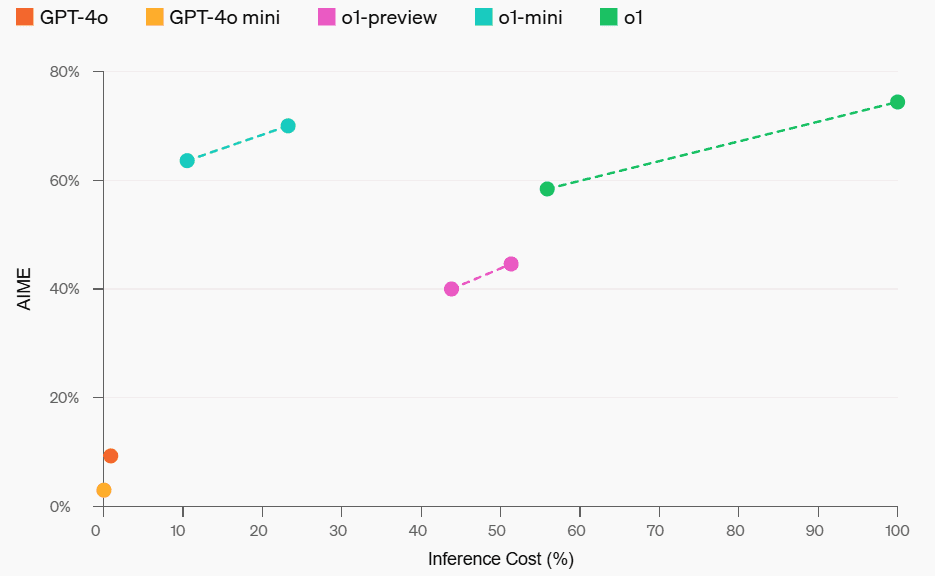

Mathematische Leistung und Kosten für das logische Denken

Mathe: In der High School AIME Maths Competition schnitt der o1-mini (70,0%) genauso gut wie der o1 (74,4%) - und deutlich günstiger - und besser als der o1-preview ( 44,6%). Mit seinen Ergebnissen (etwa 15 von 11 Fragen wurden richtig beantwortet) gehört der o1-mini ungefähr zu den 500 besten Schülern an amerikanischen High Schools.

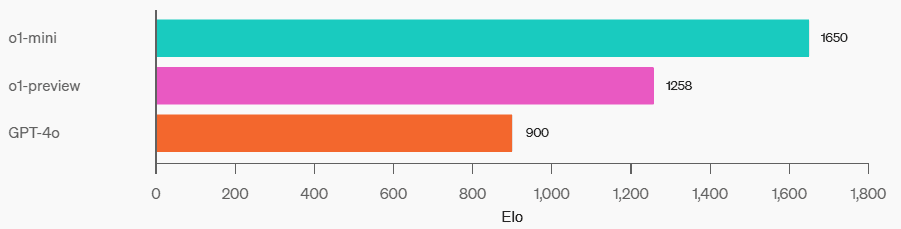

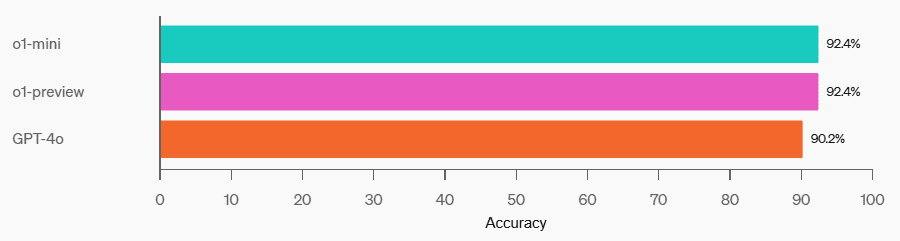

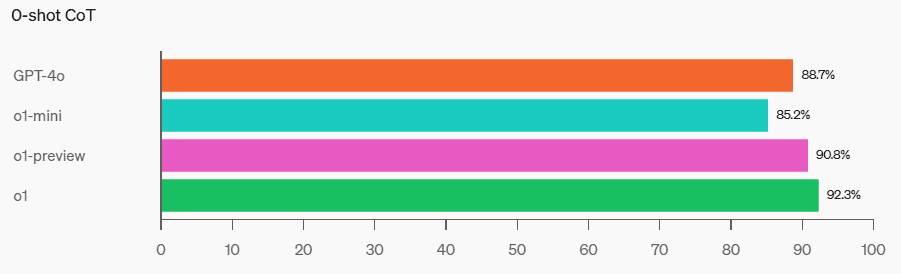

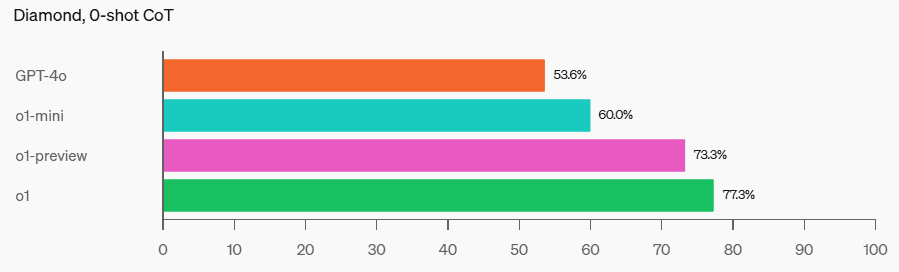

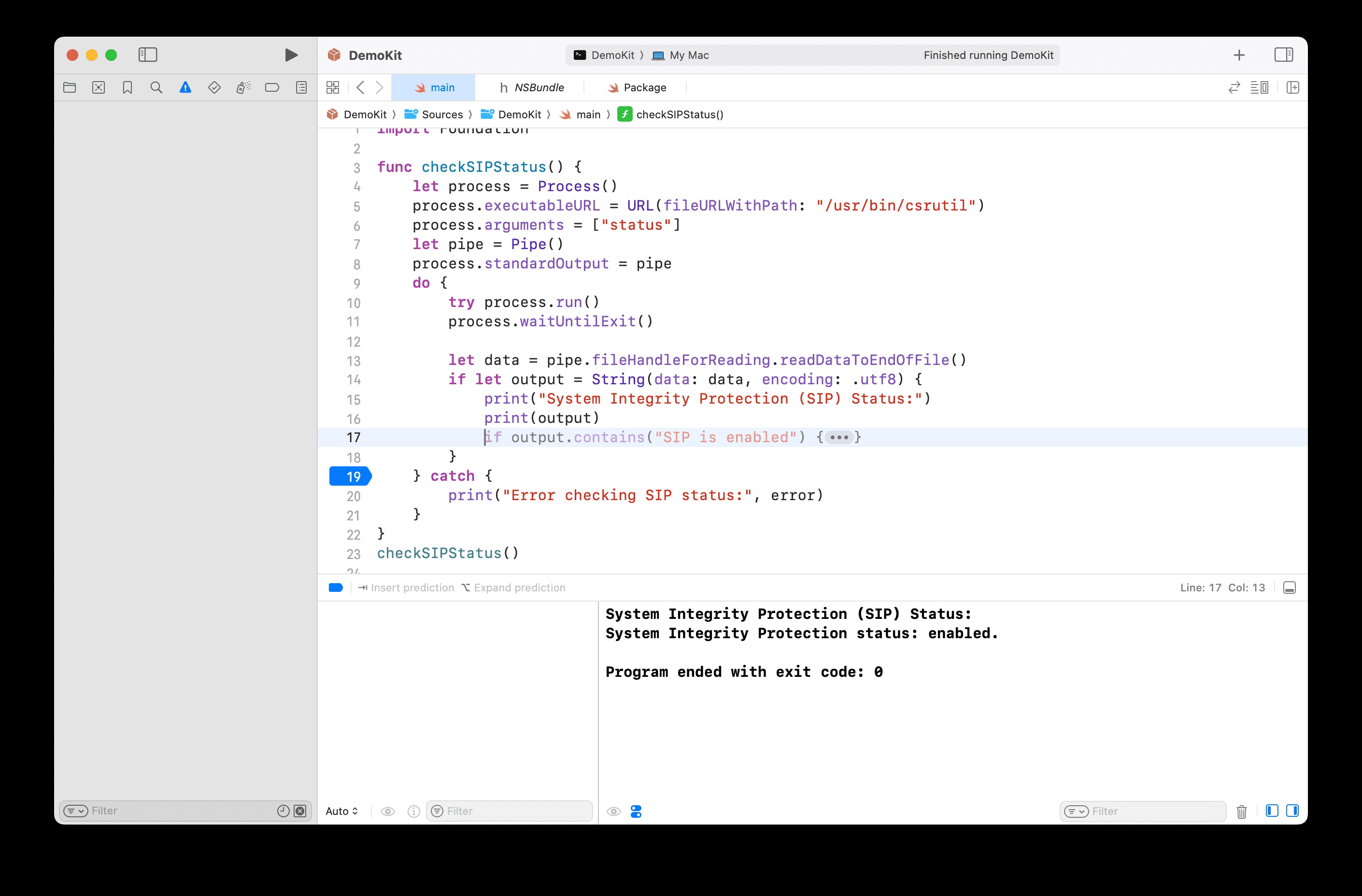

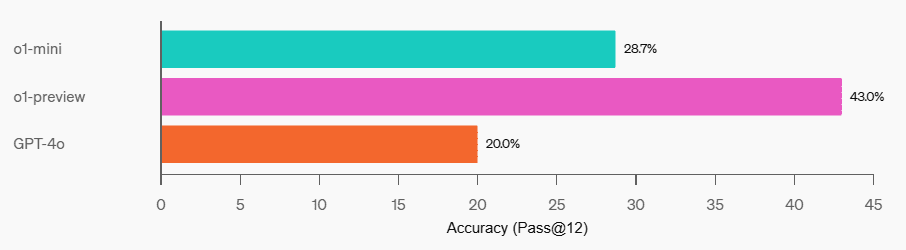

Programmierung: Auf der Codeforces-Wettbewerbswebsite hat o1-mini eine Elo-Punktzahl von 1650, was vergleichbar mit o1 (1673) und höher als o1-preview (1258) ist. Mit dieser Elo-Punktzahl liegt o1-mini im oberen 86. Perzentil der Programmierer auf der Codeforces-Plattform. o1-mini schnitt auch bei den HumanEval-Programmier-Benchmarks und den Cybersecurity Capture the Flag Challenges (CTFs) auf Highschool-Niveau sehr gut ab.

Codeforces

HumanEval

Cybersecurity CTFs

MINT: Bei einigen akademischen Tests, die logisches Denken erfordern, wie dem GPQA (Naturwissenschaften) und dem MATH-500, übertrifft o1-mini den GPT-4o. o1-mini schneidet bei der MMLU-Aufgabe nicht so gut ab wie der GPT-4o und bleibt beim GPQA hinter o1-preview zurück, da ihm ein umfangreiches Weltwissen fehlt.

MMLU

GPQA

MATH-500

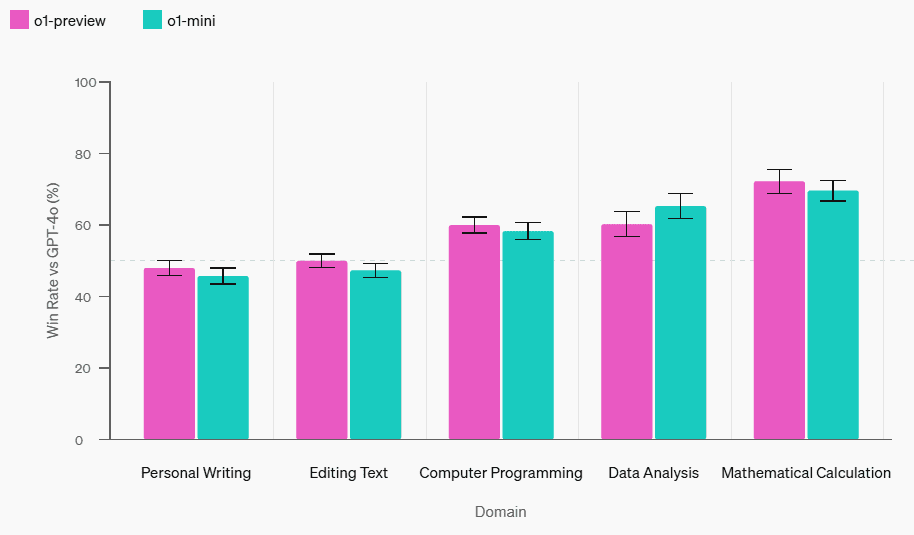

Bewertung der menschlichen Präferenzen: Wir haben Bewerter gebeten, o1-mini mit GPT-4o bei offenen Rätseln in einer Reihe von Bereichen zu vergleichen, wobei wir dieselbe Methodik wie in [o1-preview compared to GPT-4o](https://openai.com/index/learning-to-reason-with-llms/) angewandt haben. Ähnlich wie o1-preview ist o1-mini beliebter als GPT-4o in Bereichen, die logisches Denken erfordern, aber weniger beliebt als GPT-4o in Bereichen, die auf Sprache ausgerichtet sind.

Bewertung der menschlichen Präferenzen im Vergleich zu chatgpt-4o-latest

Modellgeschwindigkeit

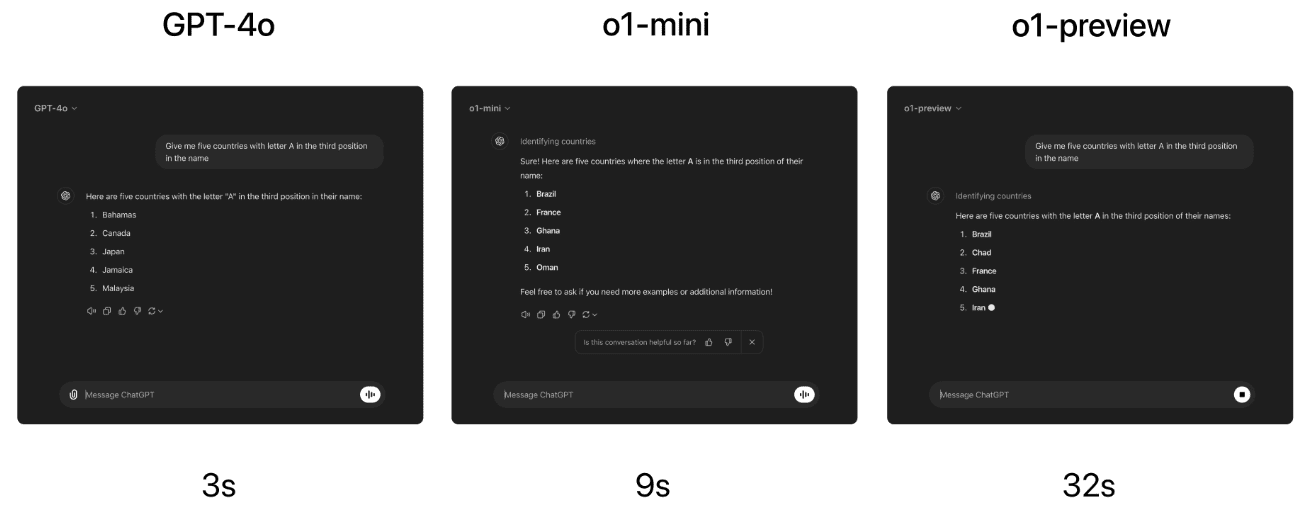

Als konkretes Beispiel vergleichen wir die Antworten von GPT-4o, o1-mini und o1-preview auf ein Problem des lexikalischen Denkens. Während GPT-4o eine falsche Antwort gab, gaben sowohl o1-mini als auch o1-preview die richtige Antwort, wobei o1-mini etwa 3-5 mal schneller antwortete.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...