OneCAT - Multimodales Open-Source-Modell für Meituan und die Shanghai Jiaotong Universität

Was ist OneCAT?

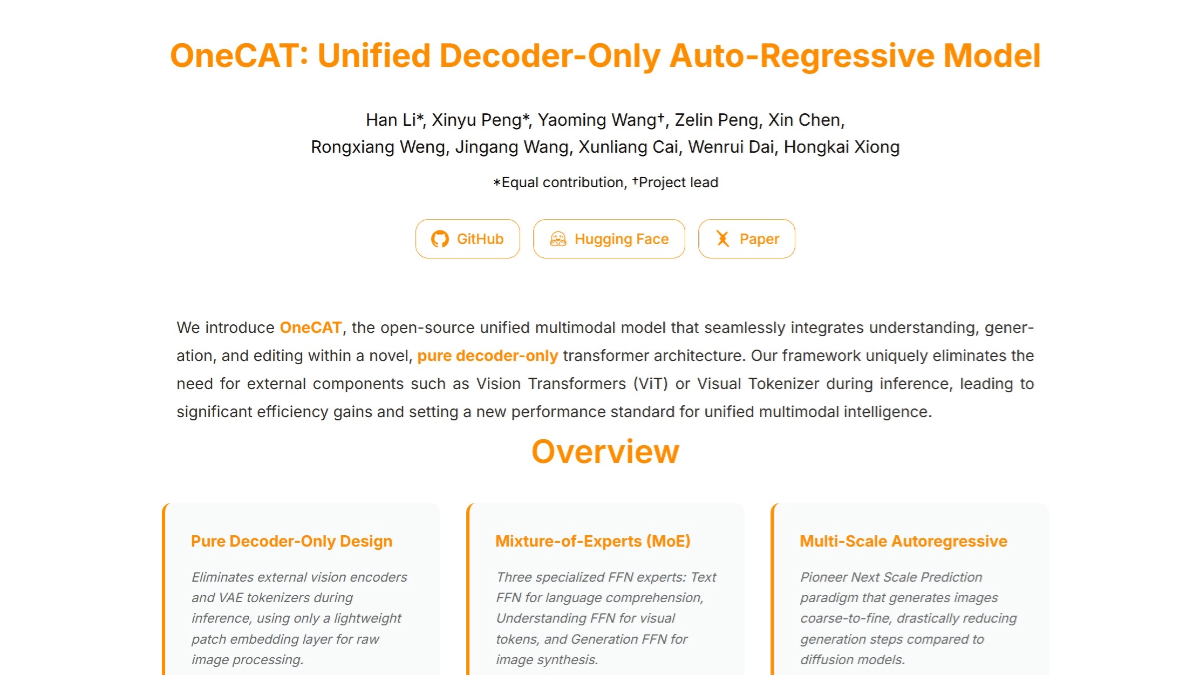

OneCAT ist ein neues vereinheitlichtes multimodales Modell, das von Meituan in Zusammenarbeit mit der Shanghai Jiaotong University eingeführt wurde. Es verwendet eine reine Decoder-Architektur und kann nahtlos multimodales Verstehen, Text-zu-Bild-Generierung und Bildbearbeitungsfunktionen integrieren. Das Modell gibt das Design traditioneller multimodaler Modelle auf, die auf externe visuelle Kodierer und Disambiguatoren angewiesen sind, und erreicht eine effiziente multimodale Verarbeitung durch eine modalitätsspezifische Mixed of Experts (MoE)-Architektur und einen multiskaligen autoregressiven Mechanismus.OneCATs Hauptstärken liegen in seiner übersichtlichen Architektur und einer deutlich verbesserten Inferenz-Effizienz, insbesondere bei hochauflösenden Bildeingaben und -ausgaben. Durch innovative skalenbewusste Adapter und multimodale multifunktionale Aufmerksamkeitsmechanismen werden die visuellen Generierungsfähigkeiten und der cross-modale Abgleich weiter verbessert. OneCAT hat in mehreren Benchmark-Tests für multimodales Verstehen, Text-zu-Bild-Generierung und Bildbearbeitung eine hervorragende Leistung gezeigt und damit einen neuen Standard für die Entwicklung einer einheitlichen multimodalen Intelligenz gesetzt.

Merkmale von OneCAT

- Effiziente multimodale VerarbeitungDie reine Decoderarchitektur, die externe visuelle Kodierer oder Wortteiler überflüssig macht, vereinfacht die Modellstruktur erheblich und reduziert den Rechenaufwand, insbesondere bei der Verarbeitung hochauflösender Eingaben.

- Leistungsstarke generative FähigkeitenDer autoregressive Multi-Skalen-Mechanismus kann schrittweise qualitativ hochwertige Bilder von grob bis fein generieren, die sich für die Text-Bild-Generierung und die Bildbearbeitung mit hervorragenden Ergebnissen eignen.

- Flexible BildbearbeitungUnterstützt die befehlsbasierte Bildbearbeitung mit präzisen lokalen und globalen Anpassungen von Bildern auf der Grundlage von Benutzerbefehlen und ermöglicht leistungsstarke Funktionen für die bedingte Generierung ohne zusätzliche Architekturänderungen.

- Modalübergreifende AnpassungsfähigkeitVerbesserter Abgleich zwischen verschiedenen Modalitäten und verbesserte Modellleistung bei multimodalen Aufgaben durch modalitätsspezifische Mixing of Experts (MoE)-Strukturen und gemeinsame QKV- und Aufmerksamkeitsebenen.

- Unterstützung dynamischer AuflösungenNative Unterstützung der dynamischen Auflösung, die sich an unterschiedliche Größen der Eingaben anpassen kann, was die Flexibilität und Anwendbarkeit des Modells verbessert.

Die wichtigsten Vorteile von OneCAT

- Einfache und effiziente ArchitekturDurch die Verwendung einer reinen Decoder-Architektur ohne externen visuellen Coder oder Wortsplitter wird die Modellstruktur erheblich vereinfacht, der Rechenaufwand reduziert und die Inferenz-Effizienz dramatisch verbessert, insbesondere bei hochauflösenden Eingaben.

- Starke multimodale FusionsfähigkeitDurch die modalitätsspezifische Mixing of Experts (MoE)-Struktur können Texte, Bilder und andere multimodale Daten nahtlos verarbeitet werden, um effiziente multimodale Verstehens-, Generierungs- und Bearbeitungsfunktionen zu erreichen, was die Tiefe und Effizienz der cross-modalen Informationsfusion erhöht.

- Hervorragende ErzeugungsleistungDie innovative Einführung eines visuellen autoregressiven Mechanismus mit mehreren Skalen, um Bilder schrittweise von grob nach fein zu generieren, reduziert die Anzahl der Dekodierungsschritte drastisch, während die hohe Qualität der visuellen Ausgabe beibehalten wird, und zeigt eine robuste Leistung bei der Text-zu-Bild-Generierung und bei Bildbearbeitungsaufgaben.

- Ausgeprägte BefehlstreueZeigt bei multimodalen Generierungs- und Bearbeitungsaufgaben eine ausgezeichnete Befehlstreue, versteht und führt Benutzerbefehle genau aus und generiert konforme Bildinhalte, die das Benutzererlebnis verbessern.

- Unterstützung dynamischer AuflösungenNative Unterstützung für dynamische Auflösung und die Fähigkeit, sich an unterschiedlich große Eingaben anzupassen, verbessert die Flexibilität und Anwendbarkeit des Modells für eine breite Palette von Anwendungsszenarien.

Was ist die offizielle Website von OneCAT?

- Projekt-Website:: https://onecat-ai.github.io/

- Github-Repositorien:: https://github.com/onecat-ai/onecat

- HuggingFace-Modellbibliothek:: https://huggingface.co/onecat-ai/OneCAT-3B

- arXiv Technisches Papier:: https://arxiv.org/pdf/2509.03498

Für wen OneCAT gedacht ist

- Forscher im Bereich der künstlichen IntelligenzOneCAT, als ein neuartiges multimodales Modell, bietet Forschern neue Forschungsrichtungen und experimentelle Plattformen, die genutzt werden können, um modernste Technologien für multimodales Verstehen, Generieren und Bearbeiten zu erforschen.

- Datenwissenschaftler und IngenieureIn Projekten, die mit multimodalen Daten umgehen müssen, kann OneCAT helfen, Funktionen wie Text-zu-Bild-Generierung, Bildbearbeitung usw. schnell zu implementieren und die Entwicklungseffizienz zu verbessern.

- Kreative Designer und KünstlerOneCAT generiert qualitativ hochwertige Bilder auf der Grundlage von Textbeschreibungen, die Inspiration und Material für kreatives Design und künstlerisches Schaffen liefern und dabei helfen, kreative Ideen schnell umzusetzen.

- ErzieherinIm Bildungsbereich kann OneCAT Bilder erzeugen, die sich auf den Lehrinhalt beziehen, den Schülern helfen, das Wissen besser zu verstehen und zu behalten, und die Lehrmittel bereichern.

- Ersteller von Inhalten und MedienschaffendeOneCAT kann zur Erstellung und Bearbeitung von Bildinhalten verwendet werden, um die Erstellung von Anzeigen, Videos, Inhalten für soziale Medien und mehr zu unterstützen und die Effizienz und Qualität der Inhaltserstellung zu verbessern.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...