OmAgent: ein intelligenter Körperrahmen für den Aufbau multimodaler intelligenter Geräte

Allgemeine Einführung

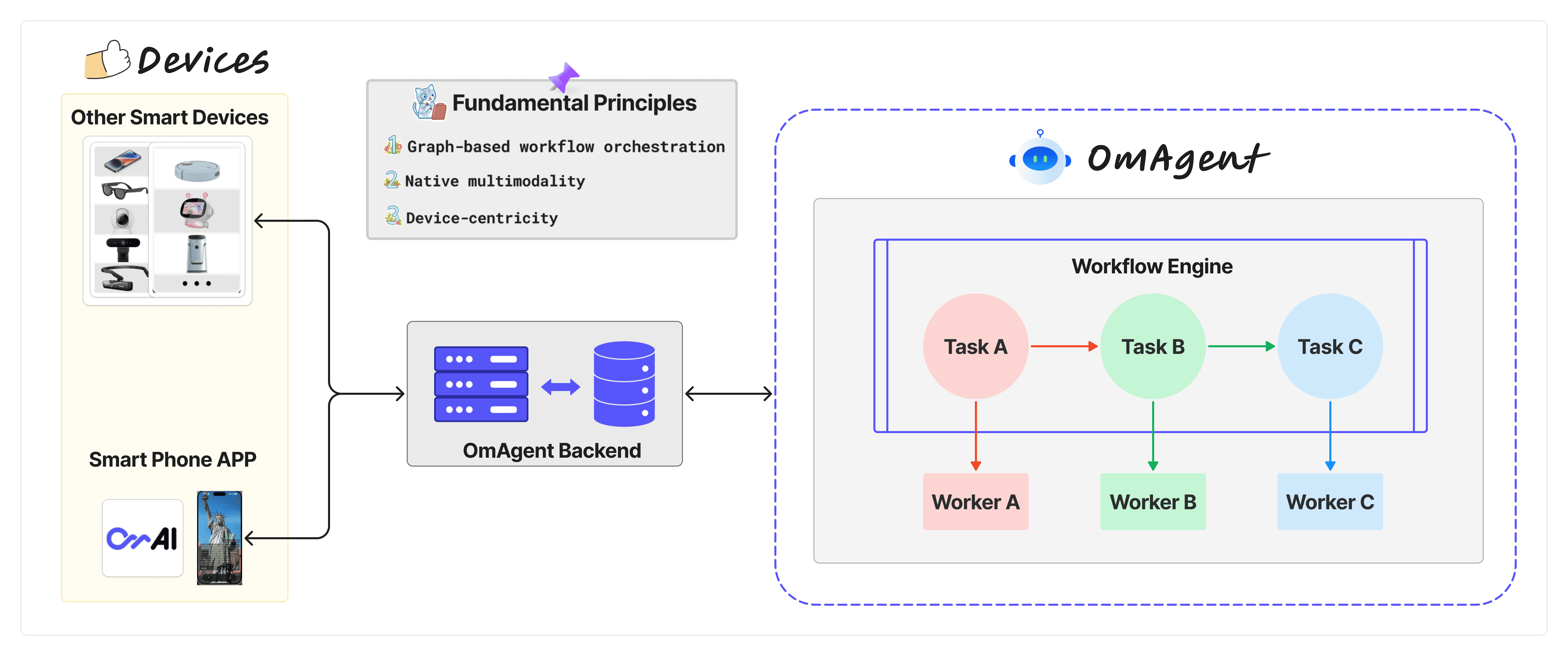

OmAgent ist ein multimodales intelligentes Körper-Framework, das vom Om AI Lab entwickelt wurde und darauf abzielt, leistungsstarke KI-gestützte Funktionen für intelligente Geräte bereitzustellen. Das Projekt ermöglicht es Entwicklern, durch die Integration modernster multimodaler Basismodelle und intelligenter Körperalgorithmen effiziente interaktive Erlebnisse in Echtzeit auf einer Vielzahl von intelligenten Geräten zu schaffen.OmAgent unterstützt nicht nur Text- und Bildverarbeitung, sondern auch komplexes Videoverständnis für eine Vielzahl von Szenarien, die von Smartphones bis zu zukünftigen Robotern reichen. Im Kern optimiert es die End-to-End-Berechnungen, um natürliche und reibungslose Interaktionen zwischen Nutzern und Geräten zu gewährleisten.

Funktionsliste

- Multimodale ModellunterstützungIntegration kommerzieller und quelloffener multimodaler Basismodelle zur Bereitstellung leistungsstarker KI-Unterstützung.

- Vereinfachte GerätekonnektivitätVereinfacht die Verbindung mit physischen Geräten wie Mobiltelefonen, Brillen usw. und unterstützt Entwickler bei der Erstellung von Anwendungen, die auf dem Gerät laufen.

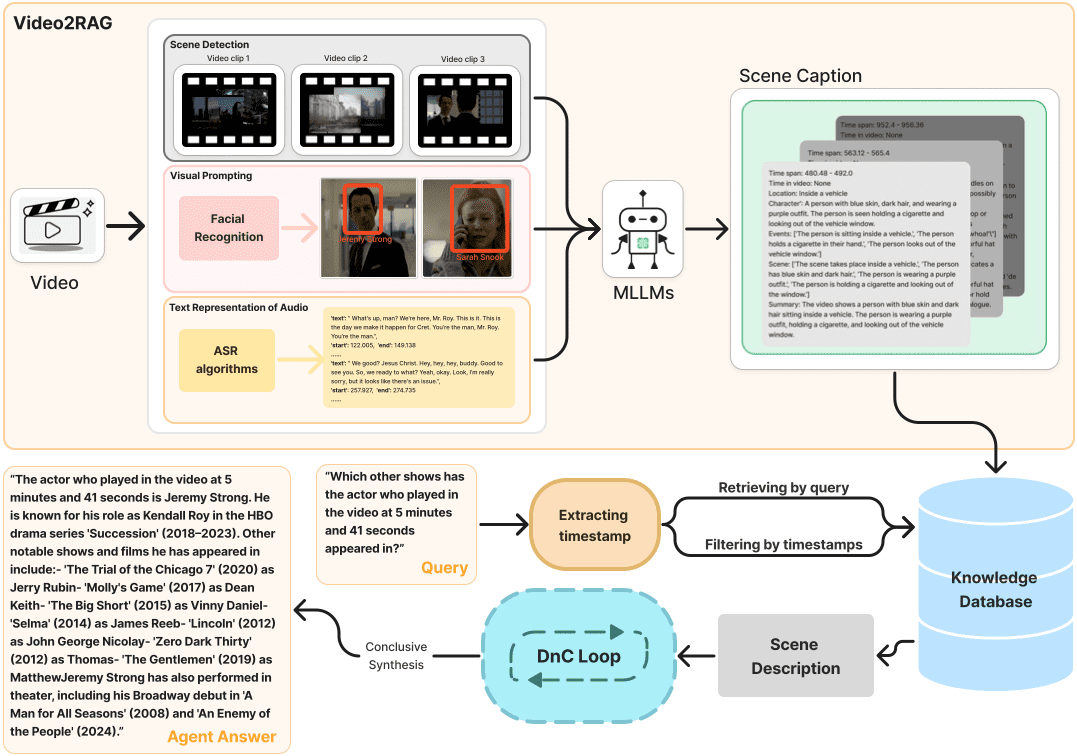

- Komplexes Video-VerständnisBietet tiefgehendes Parsing und Verständnis von Videoinhalten durch Divide-and-Conquer-Algorithmen.

- Workflow-OrchestrierungNutzung der Conductor Workflow Engine zur Unterstützung komplexer Orchestrierungslogik wie Schleifen und Verzweigungen.

- Verwaltung von Aufgaben und MitarbeiternLogische Choreographie und Knotenausführung in Workflows durch Task- und Worker-Konzepte.

- Hocheffiziente Audio- und VideoverarbeitungOptimieren Sie die Audio- und Videoverarbeitung, um ein interaktives Erlebnis in Echtzeit zu gewährleisten.

Hilfe verwenden

Einbauverfahren

OmAgent ist ein Open-Source-Projekt, das auf GitHub gehostet wird, und der Installationsprozess ist wie folgt:

- Klon-Lager::

- Öffnen Sie ein Terminal und führen Sie den folgenden Befehl aus, um das GitHub-Repository von OmAgent zu klonen:

git clone https://github.com/om-ai-lab/OmAgent.git - Wechseln Sie in das geklonte Verzeichnis:

cd OmAgent

- Öffnen Sie ein Terminal und führen Sie den folgenden Befehl aus, um das GitHub-Repository von OmAgent zu klonen:

- Umgebung Konfiguration::

- Erstellen und aktivieren Sie eine Python-Umgebung (conda wird empfohlen):

conda create -n omagent python=3.10 conda activate omagent - Installieren Sie die erforderlichen Abhängigkeiten:

pip install -r requirements.txt - Wenn eine bestimmte Konfiguration erforderlich ist (z. B. bing search API), ändern Sie die

configs/tools/websearch.ymlDatei, fügen Sie Ihrebing_api_key.

- Erstellen und aktivieren Sie eine Python-Umgebung (conda wird empfohlen):

Anleitungen

Entwicklung von intelligenten Körpern

- Intelligentsia schaffen::

- Sie kann über die

examplesSuchen Sie das Beispielprojekt in dem Verzeichnis, z. B.step1_simpleVQAlernen Sie, wie Sie eine einfache multimodale visuelle Quizintelligenz aufbauen können. - Folgen Sie den Schritten im Beispiel, um Ihre eigene intelligente Körperlogik zu schreiben.

- Sie kann über die

- angeschlossenes Gerät::

- Mit dem OmAgent App Backend Service können Intelligenzen auf Geräten bereitgestellt werden. Siehe

app使用文档Der Abschnitt über die Gerätekonnektivität stellt sicher, dass die Kommunikation zwischen Geräten und Intelligenzen nahtlos verläuft.

- Mit dem OmAgent App Backend Service können Intelligenzen auf Geräten bereitgestellt werden. Siehe

- Video-Verständnis::

- ausnutzen

video_understandingBeispielprojekte zum Verständnis, wie OmAgent zur Verarbeitung und zum Verständnis von Videoinhalten eingesetzt werden kann. Besonderes Augenmerk wird auf die Verwendung einer Divide-and-Conquer-Strategie (Divide-and-Conquer-Schleife) für intelligente Videoabfragen und -analysen gelegt.

- ausnutzen

- Verwaltung des Arbeitsablaufs::

- Durch die Erstellung und Bearbeitung

container.yamlDatei, um Ihren Workflow zu konfigurieren. Jeder Workflow kann mehrere Knoten enthalten, von denen jeder eine separate Aufgabe oder ein komplexer logischer Zweig sein kann. - Verwendet Conductor als Workflow-Engine und unterstützt die

switch-caseundfork-joinunddo-whileund andere komplexe Vorgänge.

- Durch die Erstellung und Bearbeitung

- Aufgaben und Arbeitnehmer::

- Definieren Sie während der Entwicklung die

Taskzur Verwaltung der Workflow-Logik.Workerführt dann die spezifische Operationslogik aus. JedeSimpleTaskGegenstückWorkerAuf diese Weise ist es möglich, die Funktionalität von Intelligenzen flexibel aufzubauen und zu erweitern.

- Definieren Sie während der Entwicklung die

Laufende Intelligenz

- laufendes Beispiel::

- Führen Sie das Beispielskript im geklonten Projektverzeichnis wie folgt aus:

python run_demo.py - Die Ergebnisse werden in der Datei

./outputsOrdner.

- Führen Sie das Beispielskript im geklonten Projektverzeichnis wie folgt aus:

- Fehlersuche und Tests::

- Verwenden Sie GitHub Actions für automatisierte Tests und die Bereitstellung, um sicherzustellen, dass Ihre Intelligenzen in verschiedenen Umgebungen stabil sind.

eingehende Studie

- Dokument anzeigenOmAgent: Die ausführliche API-Dokumentation und die Anwendungs-Tutorials helfen Ihnen, das Framework besser zu verstehen und zu nutzen.

- Unterstützung der Gemeinschaft: Treten Sie der Om AI Lab-Community bei, um an Diskussionen teilzunehmen, Unterstützung zu erhalten und Ihre Arbeit zu teilen.

Indem sie diese Schritte befolgen, können Entwickler von der breiten Palette an Fähigkeiten von OmAgent profitieren, um hochentwickelte KI-Intelligenzen zu schaffen, die auf einer Vielzahl von intelligenten Geräten ausgeführt werden können und Lösungen für eine breite Palette von Aufgaben bieten, von einfachen Fragen und Antworten bis hin zu komplexen Videoanalysen.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...