Ollama: Native Ein-Klick-Bereitstellung von Open Source Big Language-Modellen

Ollama Allgemeine Einführung

ollama ist ein leichtgewichtiges Framework für die Ausführung von nativen Sprachmodellen, mit dem Benutzer problemlos große Sprachmodelle erstellen und ausführen können. Es bietet mehrere Schnellstart- und Installationsoptionen, unterstützt Docker und enthält eine Vielzahl von Bibliotheken, aus denen die Benutzer auswählen können. Es ist einfach zu bedienen, bietet eine REST-API und verfügt über eine Vielzahl von Plugins und Erweiterungen, die sich in die Community integrieren lassen.

ollama ist ein reines Befehlszeilentool für PCs, das für die Bereitstellung lokaler Chat-Schnittstellen empfohlen wird, wie z. B. Open WebUI, Lobe Chat, NextChat.

Ändern Sie das Standard-Installationsverzeichnis: https://github.com/ollama/ollama/issues/2859

Ollama Funktionsliste

Große Sprachmodelle schnell zum Laufen bringen

Unterstützt macOS, Windows, Linux System

Stellt Bibliotheken wie ollama-python, ollama-js, etc. zur Verfügung.

Einschließlich Llama 2. MistralGemma et al. Vorkonstruiertes Modell

Unterstützt sowohl lokale als auch Docker-Installationen

Bereitstellung maßgeschneiderter Modellfunktionen

Unterstützung für die Konvertierung von Modellen aus GGUF und PyTorch

Bereitstellung einer CLI-Bedienungsanleitung

REST-API-Unterstützung bereitstellen

Häufig verwendete ollama-Befehle

Pull-Modell: ollama pull llama3.1

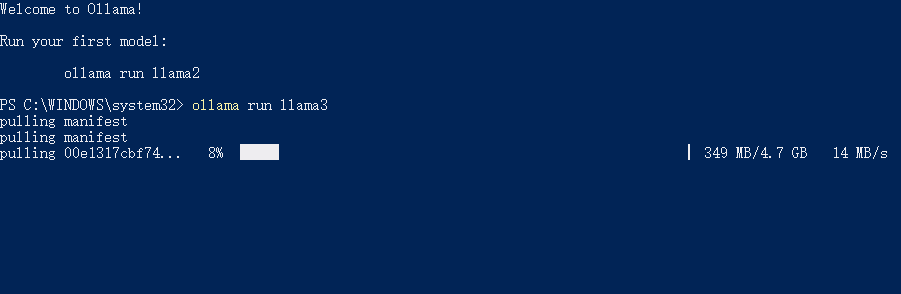

Laufendes Modell: llama run llama3.1

Modell löschen: llama rm llama3.1

Liste aller verfügbaren Modelle: ollama list

Abfrage der API-Dienstadresse: ollama serve (Standard http://localhost:11434/)

Ollama Hilfe

Installationsskripte und Anleitungen sind über die ollama-Website und die GitHub-Seite verfügbar

Installation mit dem mitgelieferten Docker-Image

Erstellen, Ziehen, Entfernen und Kopieren von Modellen über CLI-Operationen

Initialisierung und Ausführung eines lokalen Builds

Das Modell ausführen und mit ihm interagieren

Einige der von Ollama unterstützten Modelle

| Modell | Parameter | Größe | Herunterladen |

|---|---|---|---|

| Lama 2 | 7B | 3,8 GB | ollama run llama2 |

| Mistral | 7B | 4,1 GB | ollama run mistral |

| Delfin Phi | 2.7B | 1,6 GB | ollama run dolphin-phi |

| Phi-2 | 2.7B | 1,7 GB | ollama run phi |

| Neural Chat | 7B | 4,1 GB | ollama run neural-chat |

| Starling | 7B | 4,1 GB | ollama run starling-lm |

| Code Llama | 7B | 3,8 GB | ollama run codellama |

| Llama 2 Unzensiert | 7B | 3,8 GB | ollama run llama2-uncensored |

| Llama 2 13B | 13B | 7,3 GB | ollama run llama2:13b |

| Llama 2 70B | 70B | 39GB | ollama run llama2:70b |

| Orca Mini | 3B | 1,9 GB | ollama run orca-mini |

| Vicuna | 7B | 3,8 GB | ollama run vicuna |

| LLaVA | 7B | 4,5 GB | ollama run llava |

| Gemma | 2B | 1,4 GB | ollama run gemma:2b |

| Gemma | 7B | 4,8 GB | ollama run gemma:7b |

Ollama herunterladen

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...