Neu: Die Leistungsfähigkeit von OctoAI: Nahtlose Integration verschiedener Open-Source-Sprachmodelle

Heute werden wir in die Welt der Open-Source-Sprachmodelle (LLMs) eintauchen und etwas über diesen innovativen neuen Konkurrenten erfahren - Code Llama 70B mit OctoAI.

Für Entwickler ist es oft schwierig, fortschrittliche KI-Modelle wie das Code Llama 70B von Meta effektiv in ihren Arbeitsablauf zu integrieren.

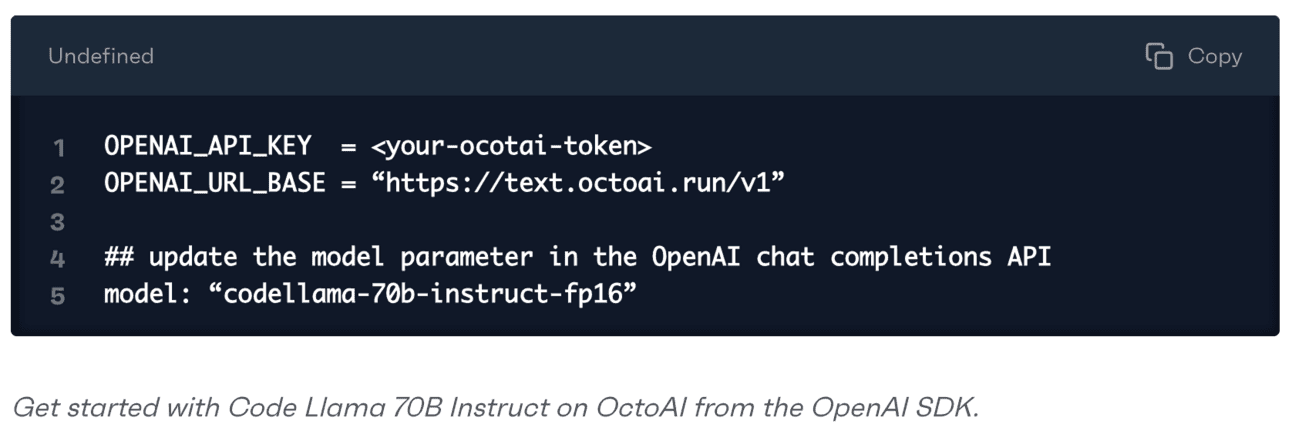

OctoAI vereinfacht diesen Prozess, indem es die nahtlose Integration des Code Llama 70B mit nur drei Zeilen Code ermöglicht.

In diesem tiefen Tauchgang erfahren Sie, wie Sie dieses leistungsstarke KI-Modell in OctoAI nutzen können. Fangen wir an: 👇

Am kommenden Sonntag werden wir die Welt der Open-Source-Sprachmodelle (LLMs) genauer unter die Lupe nehmen und diesen brandneuen Anwärter, das von OctoAI betriebene Code Llama 70B, näher beleuchten.

Für Entwickler ist es oft schwierig, fortschrittliche KI-Modelle wie das Code Llama 70B von Meta effizient in ihren Arbeitsablauf einzubinden.

OctoAI hingegen konnte diesen Prozess durch die nahtlose Integration von Code Llama 70B mit nur drei Codezeilen vereinfachen.

In diesem Deep Dive erfahren Sie, wie Sie dieses leistungsstarke KI-Modell in OctoAI nutzen können. Fangen wir an:👇

Vielleicht erinnern Sie sich an Mixtral 8-7B, das Open-Source-Sprachmodell, das im letzten Monat in der Branche für Furore sorgte.

Jetzt kommt das Debüt von Code Llama 70B, das das Potenzial hat, eine schnellere und kosteneffektivere Leistung auf OctoAI zu liefern als beliebte Closed-Source-Modelle wie GPT-3.5-Turbo und GPT-4, während es seinen Open-Source-Charakter behält.

Für Nutzer, die sich derzeit auf Closed-Source-Sprachmodelle wie OpenAI verlassen, mag der Wechsel zu Open-Source-Alternativen etwas schwierig erscheinen.

Glücklicherweise bietet OctoAI eine benutzerfreundliche Lösung, die verschiedene Sprachmodelle wie Mixtral und Code Llama mit nur wenigen einfachen Codezeilen nahtlos integriert.

Mit dieser Integration können Sie ganz einfach verschiedene LLMs testen und vergleichen, um herauszufinden, welches Ihren Anforderungen am besten entspricht.

Auf diese Weise können Sie fundierte Entscheidungen darüber treffen, welche KI-Tools Sie in Ihren Arbeitsablauf integrieren möchten.

Möchten Sie das Mixtral-8-7B oder das neue Code Llama 70B in Ihrer Szene ausprobieren?

Mit OctoAI können Sie mehrere Modelle gleichzeitig ausprobieren und deren Qualität und Eignung innerhalb weniger Minuten bewerten. OctoAI übernimmt die gesamte komplexe Arbeit des maschinellen Lernens hinter den Kulissen für Sie, sodass Sie sich mehr auf die Entwicklung konzentrieren können.

Dank ihres Fachwissens im Bereich der Optimierung des maschinellen Lernens wird jedes von Ihnen gewählte Modell schneller, effizienter und kostengünstiger laufen, als wenn Sie es selbst erstellen. Beispiel:

5-10 mal schnellere Reaktionszeit

Bis zu dreifache Kosteneinsparungen durch erhöhte Effizienz

Problemlose Bearbeitung von Abfragen von 1 pro Tag bis zu über 100k Abfragen

Mit OctoAI haben Sie mehr Auswahl. Anstatt an einen einzigen Anbieter gebunden zu sein, haben Sie die Freiheit, Komponenten wie Datenprozessoren, Modelle und Feinabstimmungstechniken zu mischen und zu kombinieren, um eine Lösung zu schaffen, die genau auf Sie zugeschnitten ist.

Aufrechterhaltung der künftigen Kompatibilität mit den raschen Fortschritten bei der Open-Source-Sprachmodellierung

Die rasante Entwicklung von Open-Source-Sprachmodellen bedeutet, dass die einzige Konstante jetzt der Wandel ist.

Wenn Sie sich auf eine geschlossene, starre Lösung beschränken, entgehen Ihnen möglicherweise neue Funktionen, die regelmäßig entwickelt werden.

Die flexible Architektur von OctoAI für maschinelles Lernen stellt sicher, dass Ihre Anwendungen von Anfang an zukunftssicher sind. Wenn bessere Open-Source-Modelle auftauchen, können Sie einfach zu ihnen wechseln und bleiben so wettbewerbsfähig.

Sie übernimmt die gesamte komplexe Modellintegration, Optimierung und Infrastrukturarbeit, so dass Sie sich nur auf die Einfachheit der API konzentrieren müssen und sich auf die Entwicklung großartiger Produkte konzentrieren können.

Nehmen wir an, Ihr Team verwendet Code Llama 70B für die Codesuche und die Generierung von Codeschnipseln. Sechs Monate später, wenn Meta oder ein anderer Deep Modeller ein effizienteres Modell herausbringt, können Sie es mit nur wenigen Zeilen Codeänderung ersetzen.

Führen Sie sofort ein Upgrade durch und profitieren Sie von Qualitätsverbesserungen, ohne monatelang für ein Reengineering zu brauchen.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...