o3 Praktische Demonstration der Überlegenheit von generischen Inferenzmodellen gegenüber spezialisierten Programmiermodellen im Bereich der Programmierung

Ursprünglicher Text:Eine Studie zur Kompetenz im Programmierwettbewerb auf der Grundlage eines Big-Reasoning-ModellsIm Folgenden finden Sie eine kurze Zusammenfassung, um das Lesen zu erleichtern.

1. einleitung

1.1 Hintergrund und Motivation

In den letzten Jahren haben große Sprachmodelle (Large Language Models, LLMs) erhebliche Fortschritte bei der Programmerstellung und bei komplexen Schlussfolgerungsaufgaben gemacht. Programmierwettbewerbe, insbesondere Plattformen wie die Internationale Informatik-Olympiade (IOI) und CodeForces, sind aufgrund ihrer strengen Anforderungen an logisches Denken und Problemlösungsfähigkeiten ideale Testumgebungen für die Bewertung der Denkfähigkeiten von KI-Systemen.

1.2 Zielsetzung der Studie

Mit dieser Studie sollen die folgenden Fragen untersucht werden:

- Leistungsvergleich von generischen und bereichsspezifischen Reasoning-ModellenVergleich der Leistung von Allzweck-Inferenzmodellen (z.B. o1 und o3 von OpenAI) mit domänenspezifischen Modellen, die speziell für IOI-Wettbewerbe entwickelt wurden (z.B. o1-ioi).

- Die Rolle des Verstärkungslernens bei der Verbesserung der Fähigkeiten zum Modellieren von ArgumentenBewertung der Leistung von großen Inferenzmodellen, die durch Verstärkungslernen (RL) in komplexen Programmieraufgaben trainiert wurden.

- Die Entstehung modellautonomer ArgumentationsstrategienBeobachten Sie, ob das Modell ohne menschliches Zutun eigenständig effektive Argumentationsstrategien entwickeln kann.

2. die Methodik

2.1 Einführung in das Modell

2.1.1 OpenAI o1

OpenAI o1 ist ein umfangreiches Sprachmodell, das durch Reinforcement Learning trainiert wird, um Code zu erzeugen und auszuführen. Es löst Probleme schrittweise, indem es interne Inferenzketten erzeugt und diese mit RL optimiert.

2.1.2 OpenAI o1-ioi

o1-ioi ist eine verbesserte Version von o1, die speziell auf den IOI-Wettbewerb abgestimmt ist. Es verwendet eine Testzeitstrategie ähnlich dem AlphaCode-System, die darin besteht, eine große Anzahl von Lösungsvorschlägen für jede Teilaufgabe zu generieren und die beste Einreichung durch Clustern und Umordnen auszuwählen.

2.1.3 OpenAI o3

o3 ist der Nachfolger von o1 und verbessert die Inferenzfähigkeit des Modells weiter. Im Gegensatz zu o1-ioi verlässt sich o3 nicht auf manuell entworfene Testzeit-Strategien, sondern entwickelt eigenständig komplexe Inferenzstrategien durch End-to-End-RL-Training.

2.2 Methodik der Bewertung

2.2.1 CodeForces-Simulationswettbewerbe

Wir simulierten die CodeForces-Wettbewerbsumgebung, indem wir die vollständige Testsuite verwendeten und angemessene Zeit- und Speicherbeschränkungen auferlegten, um die Leistung des Modells zu bewerten.

2.2.2 IOI 2024 Live-Wettbewerb

o1-ioi nahm am IOI-Wettbewerb 2024 teil und trat unter den gleichen Bedingungen wie die menschlichen Konkurrenten an.

2.2.3 Bewertung von Softwareentwicklungsaufgaben

Außerdem haben wir die Leistung des Modells mit den Datensätzen HackerRank Astra und SWE-bench Verified bewertet, um seine Fähigkeiten bei realen Softwareentwicklungsaufgaben zu testen.

3. die Entdeckung

3.1 Allgemeine vs. domänenspezifische Modelle

- o1-ioi im Rahmen des IOI-WettbewerbsBeim IOI-Wettbewerb 2024 erzielte o1-ioi 213 Punkte und lag auf Platz 49%. Nach Lockerung der Einreichungsbeschränkungen verbesserte sich seine Punktzahl auf 362,14 Punkte, was über der Goldmedaillengrenze liegt.

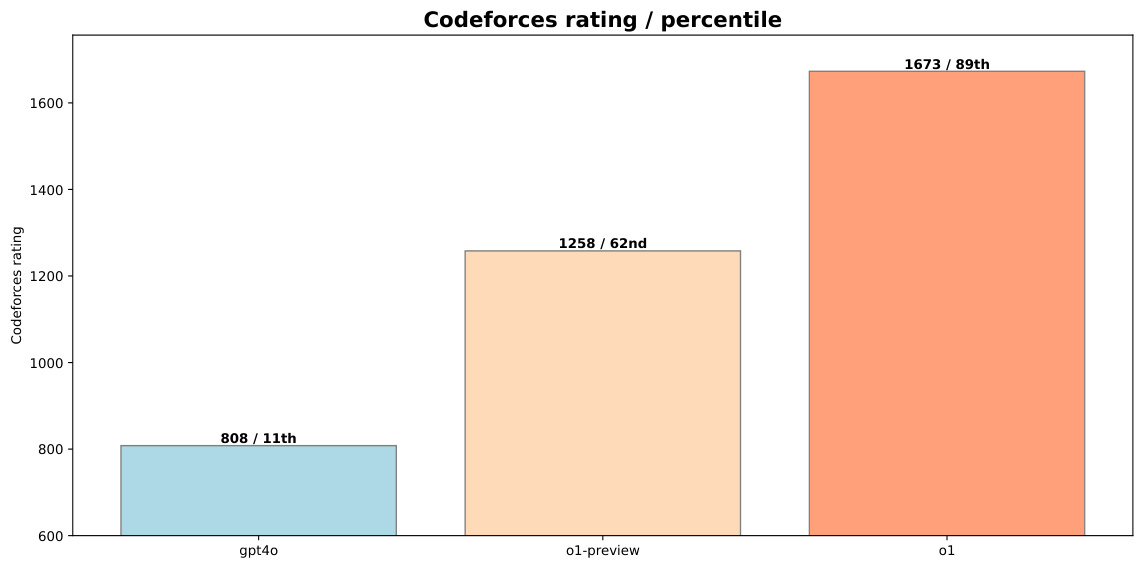

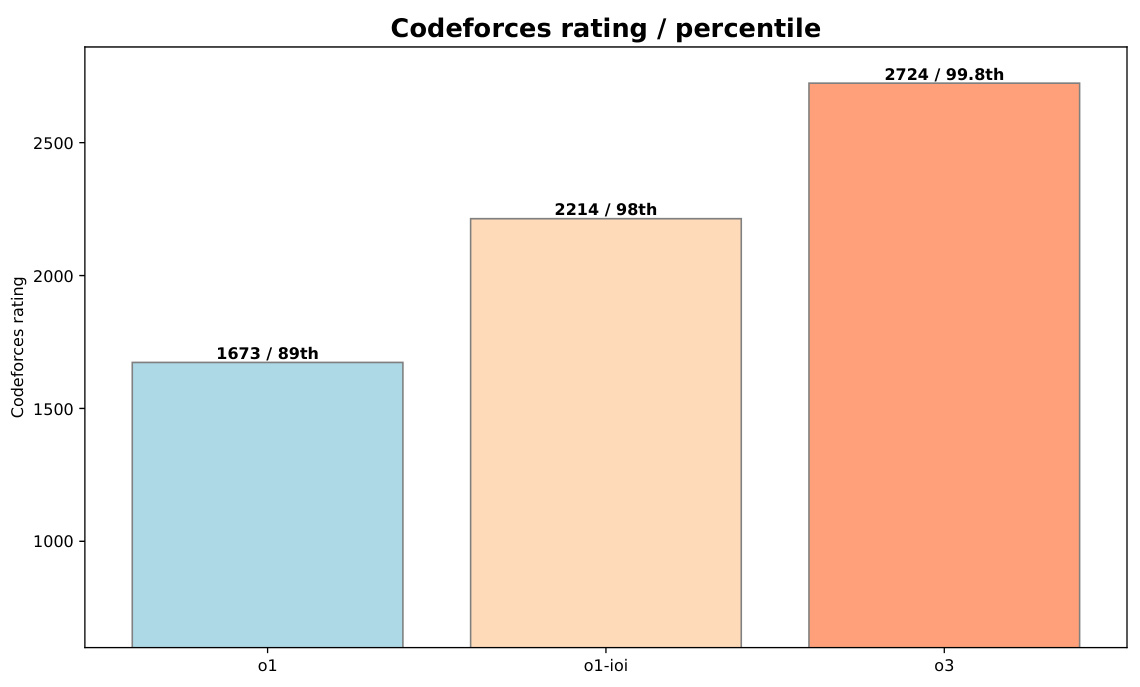

- o3-Exzellenzo3 schnitt im CodeForces-Benchmark mit einer Bewertung von 2724 (99,8 Perzentil) gut ab, deutlich besser als o1-ioi (2214, 98 Perzentil). Im IOI-2024-Benchmark erreichte o3 ebenfalls eine Punktzahl von 395,64 und übertraf damit die Goldmedaillengrenze, wobei die Zahl der Einreichungen auf 50 beschränkt war.

Abbildung 1: Vergleich der Leistung von o1-preview und o1 mit gpt-4o bei CodeForces

3.2 Aufwertung der Rolle des Lernens

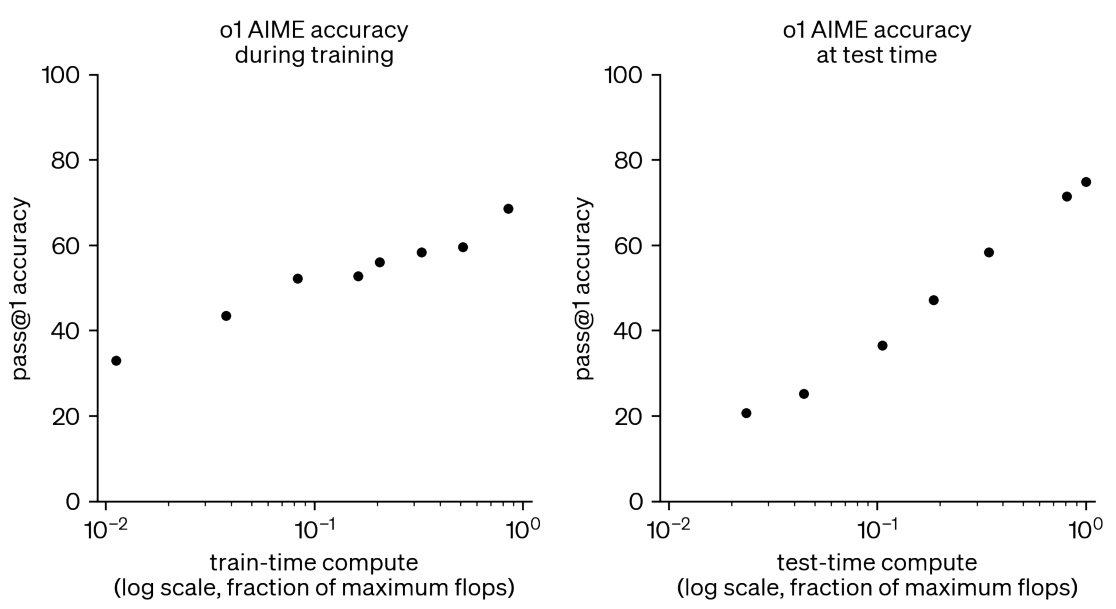

- Erhöhter Rechenaufwand beim RL-Training und -TestWie in Abb. 2 gezeigt, kann eine Erhöhung der Rechenressourcen während des RL-Trainings und -Tests die Leistung des Modells bei wettbewerbsfähigen mathematischen Aufgaben erheblich verbessern.

Abbildung 2: Zusätzliches RL-Training und zusätzliche Berechnungen zur Testzeit verbessern die Leistung bei wettbewerbsfähigen Matheaufgaben

3.3 Entstehung von modellautonomen Argumentationsstrategien

- Autonome Argumentationsstrategien für o3o3 zeigt bei Tests komplexere und durchdachtere Argumentationsketten. Bei Problemen, die einer Überprüfung bedürfen, generiert es beispielsweise einfache Brute-Force-Lösungen und vergleicht dann seine Ausgabe mit einer optimierten Implementierung des Algorithmus, um mögliche Fehler zu erkennen.

Abbildung 3: Die o3-Testlösung selbst, die eine Teilimplementierung der von o1-ioi in IOI 2024 verwendeten Testzeitstrategie darstellt

4. schlussfolgerung

4.1 Wichtigste Ergebnisse

- Überlegenheit der verallgemeinerten ModelleWährend domänenspezifische Modelle (z.B. o1-ioi) bei bestimmten Aufgaben gut abschneiden, sind allgemeine Modelle (z.B. o3), die in groß angelegten RL trainiert wurden, in der Lage, diese Ergebnisse zu übertreffen, ohne auf manuell entwickelte Inferenzheuristiken angewiesen zu sein.

- Effektivität der RL-AusbildungDas Hinzufügen von RL-Trainings- und Testzeit-Rechenressourcen kann die Leistung des Modells kontinuierlich verbessern und es näher an die der weltbesten menschlichen Spieler heranbringen.

- Modellierung der Fähigkeit zur autonomen Entwicklung komplexer Strategieno3 zeigt, dass das Modell in der Lage ist, selbständig komplexe Inferenzstrategien zu entwickeln, so dass keine manuellen Teststrategien mehr erforderlich sind.

4.2 Zukunftsperspektiven

Die Ergebnisse dieser Studie zeigen, dass das groß angelegte RL-Training einen robusten Weg darstellt, um den neuesten Stand der Künstlichen Intelligenz (KI) in logischen Domänen wie der wettbewerbsorientierten Programmierung zu erreichen. Es wird erwartet, dass große Inferenzmodelle in Zukunft viele neue Anwendungsszenarien in einer Vielzahl von Bereichen wie Wissenschaft, Codierung und Mathematik erschließen werden.

5 Beispiele

5.1 Beispiele für Lösungen aus dem Wettbewerb IOI 2024

5.1.1 Das Nil-Problem

o1-ioi hat bei der Nil-Aufgabe die volle Punktzahl erreicht, hier ist der Beispielcode für die Lösung:

#include "nile.h"

#include <bits/stdc++.h>

using namespace std;

// ... (代码省略,详见附录C.1)

5.1.2 Nachrichtenproblem

o1-ioi erzielte 79,64 Punkte für die Aufgabe "Message" und hier ist der Beispielcode für die Lösung:

#include "message.h"

#include <bits/stdc++.h>

using namespace std;

// ... (代码省略,详见附录C.2)

5.2 Beispiele für Lösungen bei Softwareentwicklungsaufgaben

5.2.1 HackerRank Astra-Datensatz

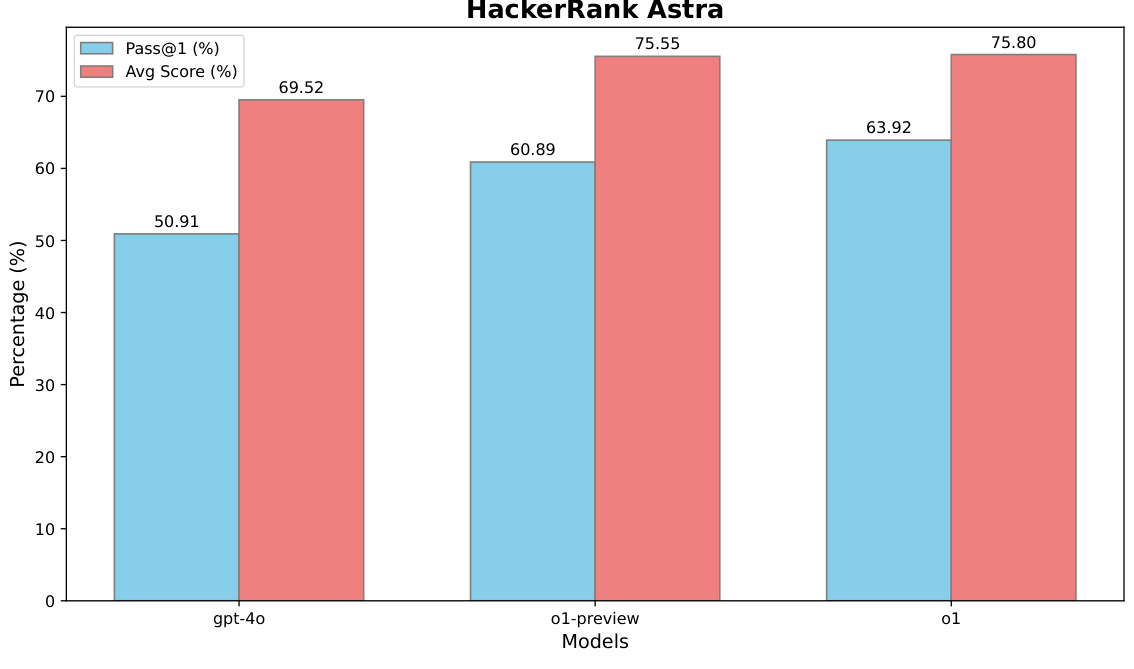

o1 auf dem HackerRank-Astra-Datensatz:

Abbildung 4: Leistung von o1 auf dem HackerRank-Astra-Datensatz

5.2.2 SWE-Bench Geprüfter Datensatz

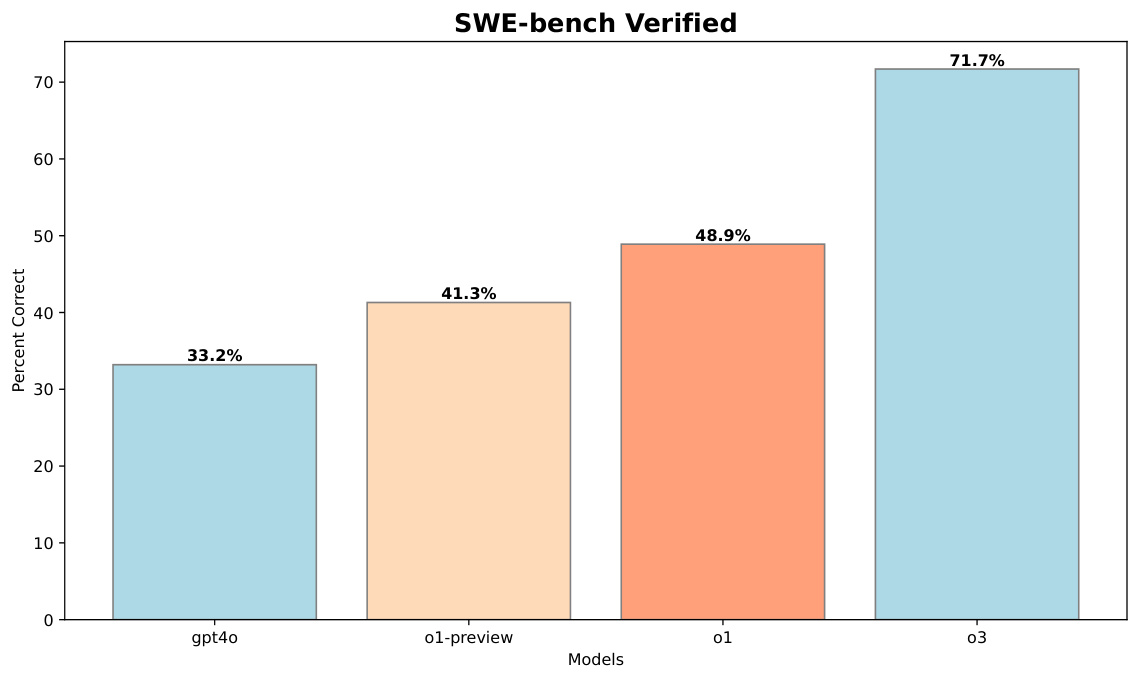

o3 auf dem SWE-bench Verified-Datensatz:

Abbildung 5: Leistung von o3 im SWE-Bench Verified Dataset

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...