muAgent: ein neues Agenten-Orchestrierungs-Framework auf der Grundlage von LLM und EKG (Branchenwissen)

Allgemeine Einführung

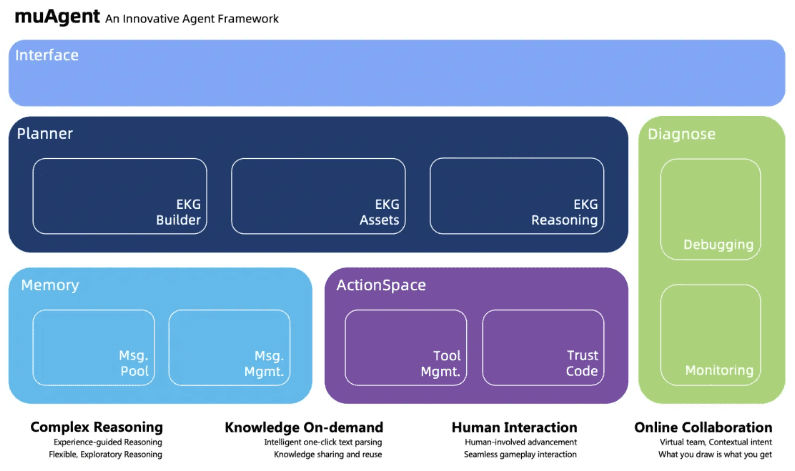

muAgent ist ein innovatives, von der Ant Group entwickeltes Multi-Intelligentsia-Framework. Das Framework unterstützt Benutzer bei der Ausführung verschiedener komplexer Standard Operating Procedures (SOPs) unter menschlicher Anleitung durch Canvas-Drag-and-Drop und einfaches Schreiben von Text, in Zusammenarbeit mit Multiintelligenzien, Funktionsaufrufen, Code-Interpretern und anderen Technologien. Derzeit wurde das Framework in mehreren komplexen DevOps-Szenarien der Ant Group validiert.

Bietet Ein-Klick-Bereitstellungsfunktionen, einschließlich KG-basierter Agent-Orchestrierung, Java-basierter Tool-/Agent-Registrierung und -Verwaltung sowie per Drag-and-Drop bearbeitbarer Front-End-Produkt-UI.

Dies ist jetzt eine Beta-Version. Sobald die Version v1.0+ verbessert ist, werden wir das v1.0+ Image zum Download freigeben.

Um Ihnen das Verständnis der gesamten CoAgent-Kette zu erleichtern, erläutern wir in Form eines Flusses im Detail, wie ein CoAgent durch Konfiguration aufgebaut wird.

Funktionsliste

- komplexe InferenzUnterstützt mehrstufige Argumentationsfähigkeiten für die Ausführung komplexer Aufgaben.

- Online-ZusammenarbeitOnline-Zusammenarbeitsfunktionen zur Unterstützung der Interaktion zwischen Teammitgliedern in Echtzeit bereitstellen.

- menschliche InteraktionVerbesserung der Genauigkeit und Effizienz der Aufgabenausführung durch Mensch-Computer-Interaktion.

- Wissen für den EinsatzEin auf einem Wissensgraphen basierender Entwurf, der die sofortige Erfassung und Anwendung von Wissen ermöglicht.

Hilfe verwenden

Einbauverfahren

- Klonen der Codebasis: Verwendung

git cloneBefehl, um das GitHub-Repository von CodeFuse-muAgent zu klonen. - Zugang zum Katalog: Verwendung

cd CodeFuse-muAgentRufen Sie den Projektkatalog auf. - Erstellen eines Docker-Netzwerks: Lauf

docker network create ekg-netErstellen Sie ein Docker-Netzwerk. - Starten des Containerdienstes: Lauf

docker-compose up -dStarten Sie alle Containerdienste, was einige Zeit dauern kann. - ZugangsdienstIm Browser öffnen

https://localhost:8000Zugang zu Dienstleistungen.

Verwendungsprozess

- Konfigurieren von LLM- und EinbettungsmodellenKonfigurieren Sie das entsprechende große Sprachmodell und das Einbettungsmodell entsprechend dem Dokument.

- Virtuelle Teams bildenErstellen Sie virtuelle Teams und Szenarien durch Drag-and-Drop und Texterstellung auf der Leinwand.

- Implementierung von SOPsKomplexe SOP-Prozesse durch multi-intelligente Zusammenarbeit unter menschlicher Anleitung ausführen.

- Fehlersuche und OptimierungVisuelles Debugging: Verwenden Sie visuelle Debugging-Tools, um Fehler in Prozessen schnell zu finden und zu beheben.

- WissensmanagementVerwaltung und Abruf von Nachrichten, die für verschiedene Szenarien erforderlich sind, durch ein einheitliches Nachrichtenpool-Design.

Detaillierte Schritte

- Bildung eines virtuellen TeamsZiehen Sie relevante Knoten auf die Leinwand, um Szenenabsichten und semantische Knoten einzurichten.

- MandatsumsetzungWählen Sie die auszuführende Aufgabe aus, und das System führt sie automatisch gemäß dem voreingestellten Prozess aus.

- Optimierung der FehlersucheDebugging: Sehen Sie sich die Protokolle und Fehlermeldungen während der Ausführung in der Debugging-Schnittstelle an und nehmen Sie entsprechende Anpassungen vor.

- WissensabfrageDie integrierte Wissenssuche hilft Ihnen, relevante Wissenspunkte und Bedienungsanleitungen schnell zu finden.

Beschreibung des Projekts

Um die Leistung großer Modelle in Bezug auf die Inferenzgenauigkeit zu verbessern, sind in der Branche eine Reihe innovativer Vorgehensweisen für große Sprachmodelle (LLM) entstanden. Von den ersten CoT-, ToT- bis hin zu GoT-Ansätzen erweitern diese Ansätze weiterhin die Grenzen der LLM-Fähigkeiten. Bei der Bewältigung komplexer Probleme können wir ReAct Prozess zur Auswahl, zum Aufruf und zur Ausführung von Werkzeugrückmeldungen, wobei mehrere Runden des Werkzeugeinsatzes und die Ausführung mehrerer Schritte möglich sind.

Für komplexere Szenarien, wie die Entwicklung von komplexem Code, ist ein LLM-Agent mit nur einer Funktion jedoch eindeutig überfordert. Infolgedessen hat die Gemeinschaft begonnen, Multi-Agenten-Kombinationsspiele zu entwickeln, wie z.B. Projekte, die sich auf metaGPT, GPT-Engineer, chatDev und andere Entwicklungsbereiche konzentrieren, sowie Projekte, die sich auf die Automatisierung der Konstruktion von Agenten und Agentendialogen konzentrieren. AutoGen Projekt.

Nach einer eingehenden Analyse dieser Frameworks wird festgestellt, dass die meisten Agent-Frameworks ein hohes Maß an Gesamtkopplung aufweisen und ihre Benutzerfreundlichkeit und Erweiterbarkeit gering ist. Es ist schwierig, ein bestimmtes Szenario in einem vordefinierten Szenario zu implementieren, aber es ist schwierig, das Szenario zu erweitern.

Daher wollen wir ein erweiterbares und einfach zu bedienendes Multi-Agenten-Framework aufbauen, das ChatBot beim Zugriff auf die Wissensbasisinformationen unterstützt und gleichzeitig bei der täglichen Büroarbeit, der Datenanalyse, der Entwicklung, dem Betrieb und der Wartung sowie anderen allgemeinen Aufgaben hilft.

Der Mutli-Agent-Rahmen in diesem Projekt stützt sich auf das gute Design verschiedener Rahmenwerke, wie z. B. das metaGPT Nachrichtenpool im Autogen, Agentenselektor im Autogen und so weiter.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...