MoshiVis: ein Open-Source-Modell für Sprachdialog und Bildverständnis in Echtzeit

Allgemeine Einführung

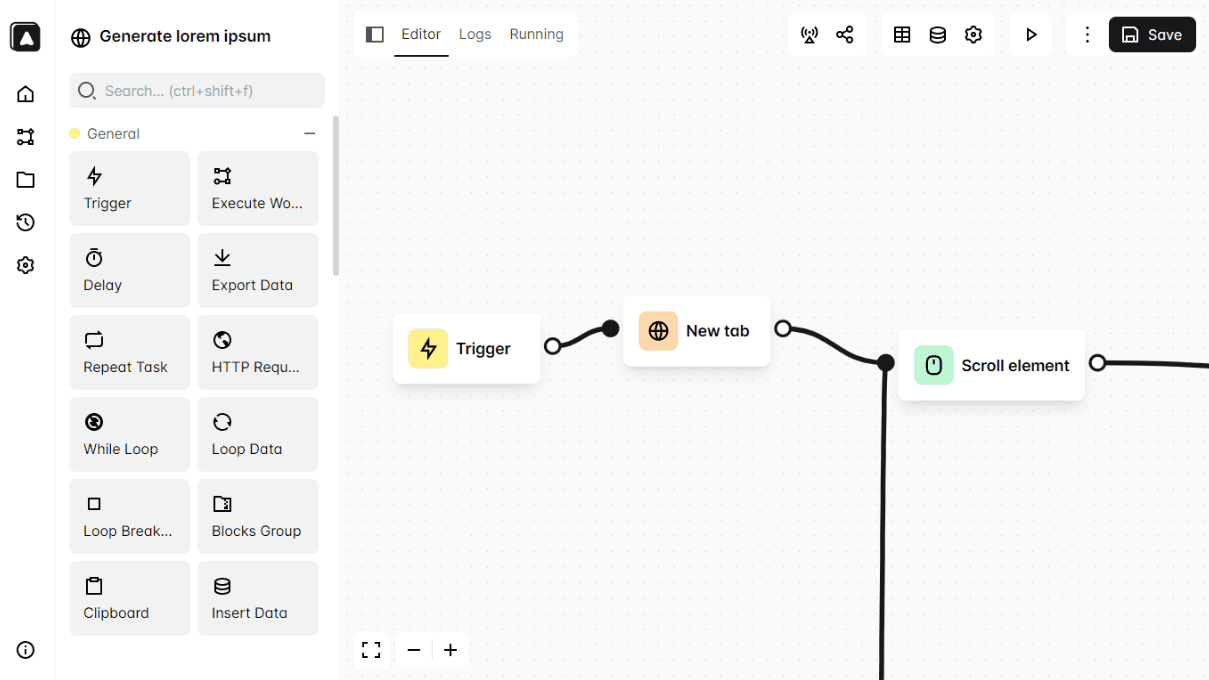

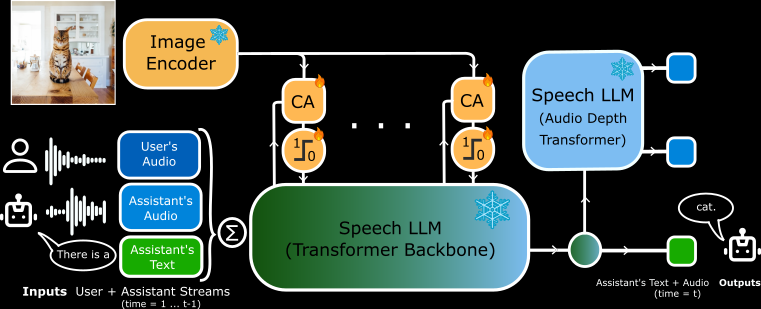

MoshiVis ist ein Open-Source-Projekt, das von Kyutai Labs entwickelt und auf GitHub gehostet wird. Es basiert auf dem Moshi-Sprache-zu-Text-Modell (7B-Parameter) mit etwa 206 Millionen neuen Anpassungsparametern und einem eingefrorenen PaliGemma2-Visual-Encoder (400M-Parameter), der es dem Modell ermöglicht, Bildinhalte mit dem Benutzer in Echtzeit per Sprache zu diskutieren.Die Hauptmerkmale von MoshiVis sind niedrige Latenz, natürliche Dialoge und Bildverstehensfähigkeiten. Es unterstützt PyTorch-, Rust- und MLX-Backends, und Benutzer können den Code und die Modellgewichte kostenlos herunterladen, um sie auf ihren lokalen Geräten auszuführen. Das Projekt richtet sich an Entwickler und Forscher und eignet sich für die Erforschung von KI-Interaktionen oder die Entwicklung neuer Anwendungen.

Funktionsliste

- Unterstützung von Spracheingabe und -ausgabe in Echtzeit, das Modell reagiert schnell, wenn der Benutzer spricht.

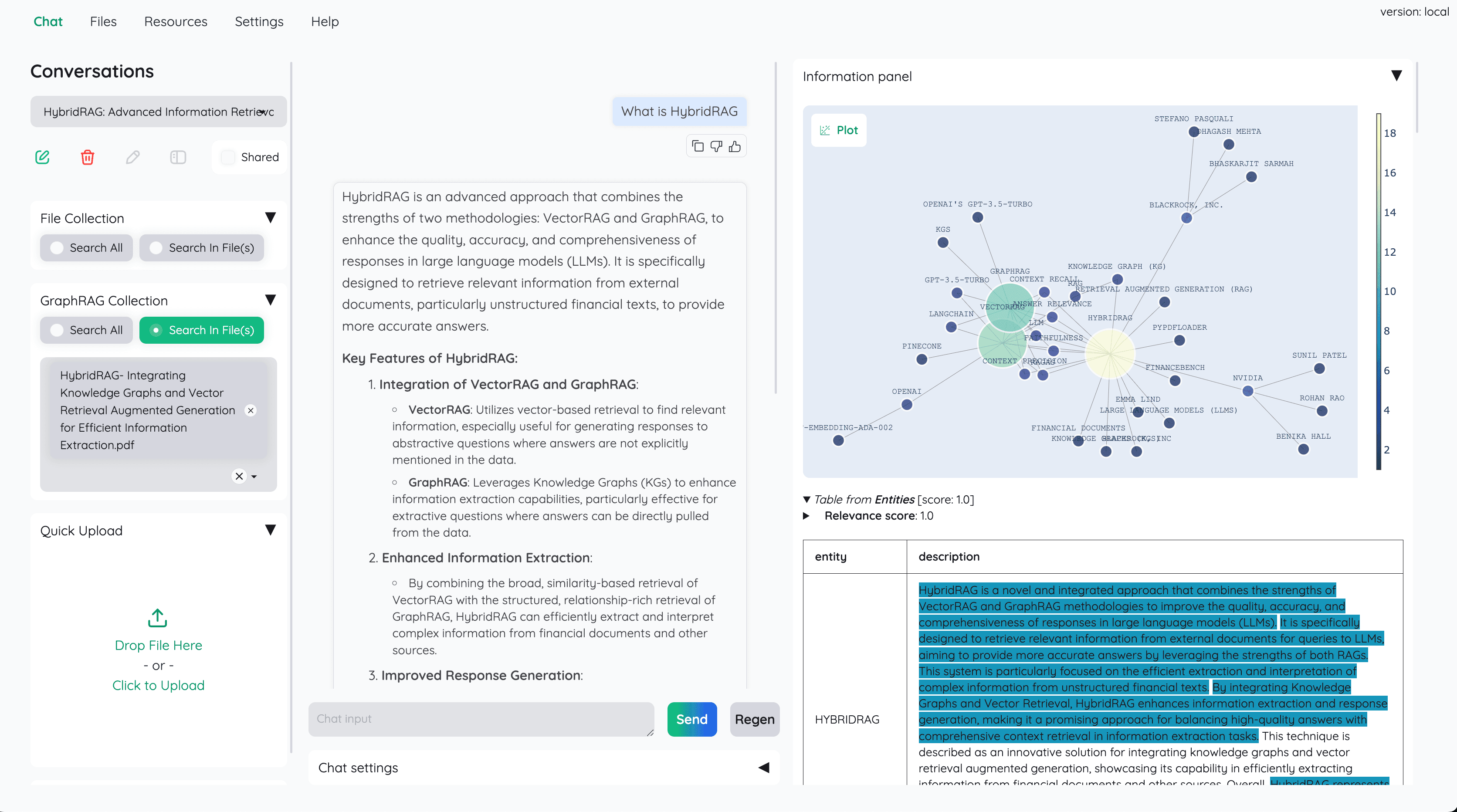

- Die Fähigkeit, den Inhalt eines Bildes zu analysieren und die Details des Bildes in Sprache oder Text zu beschreiben.

- PyTorch-, Rust- und MLX-Backends sind für unterschiedliche Hardware verfügbar.

- Open-Source-Code und Modellgewichte, die von den Nutzern frei verändert werden können.

- Design mit geringer Latenz für Echtzeit-Dialogszenarien.

- Unterstützt Quantisierungsformate (z. B. 4-Bit, 8-Bit) zur Optimierung von Speicher und Leistung.

- Eingebauter Cross-Attention-Mechanismus zur Verschmelzung von visuellen und sprachlichen Informationen.

Hilfe verwenden

Für die Installation und Verwendung von MoshiVis sind einige technische Kenntnisse erforderlich. Es wird eine ausführliche offizielle Anleitung zur Verfügung gestellt, und im Folgenden finden Sie eine vollständige Anleitung für die Installation und den Betrieb.

Einbauverfahren

MoshiVis unterstützt drei Backend-Läufe, so dass die Benutzer die für ihr Gerät geeignete Version auswählen können. Zu den Mindestanforderungen gehören Python 3.10+ und ausreichend RAM (für die PyTorch-Version wird ein 24-GB-Grafikprozessor empfohlen, und die MLX-Version ist für Macs geeignet).

PyTorch Backend-Installation

- Installieren Sie die Abhängigkeit:

pip install -U moshi

- Laden Sie die Modellgewichte herunter und starten Sie den Dienst:

cd kyuteye_pt

python -m moshi.server --hf-repo kyutai/moshika-vis-pytorch-bf16 --port 8088

- Interviews

https://localhost:8088rufen Sie die Webschnittstelle auf. - Wenn Sie das System aus der Ferne betreiben, müssen Sie SSH verwenden, um den Port weiterzuleiten:

ssh -L 8088:localhost:8088 user@remote

Rust Backend Installation

- Installieren Sie die Rust-Toolchain (über

rustup(Zugang). - Konfigurieren Sie die GPU-Unterstützung (Metal für Mac, CUDA für NVIDIA).

- Führen Sie den Dienst aus:

cd kyuteye_rs

cargo run --features metal --bin moshi-backend -r -- --config configs/config-moshika-vis.json standalone --vis

- Sobald Sie "standalone worker listening" sehen, besuchen Sie die

https://localhost:8088. - Optionale quantisierte Version:

cargo run --features metal --bin moshi-backend -r -- --config configs/config-moshika-vis-q8.json standalone --vis

MLX Backend-Installation (Mac empfohlen)

- Installieren Sie die MLX-Abhängigkeit:

pip install -U moshi_mlx

- Startup-Service (unterstützt mehrere Quantisierungsformate):

cd kyuteye_mlx

python -m moshi_mlx.server # 默认 BF16

python -m moshi_mlx.server -q 4 # 4 位量化

python -m moshi_mlx.server -q 8 # 8 位量化

- Interviews

http://localhost:8008Verwenden Sie die Webschnittstelle.

Front-End-Installation

- Laden Sie den vorgefertigten Client herunter:

pip install fire rich huggingface_hub

python scripts/get_static_client.py

- Erzeugen Sie ein SSL-Zertifikat (für HTTPS):

openssl req -x509 -nodes -days 365 -newkey rsa:2048 -keyout key.pem -out cert.pem

- Das Back-End bietet standardmäßig eine Webschnittstelle, für die keine zusätzlichen Operationen erforderlich sind.

Hauptfunktionen

Sprachdialog in Echtzeit (RTV)

- umziehenNach dem Start des Dienstes öffnen Sie die Weboberfläche (

https://localhost:8088vielleichthttp://localhost:8008). Klicken Sie auf das Mikrofonsymbol, um das Gespräch zu beginnen. - typisches BeispielSagen Sie "Hallo" und das Modell antwortet mit einer weiblichen Stimme (Moshika) "Hallo, wie kann ich Ihnen helfen?". .

- PunktLatenzzeit von nur wenigen Millisekunden, um sicherzustellen, dass die Mikrofonprivilegien aktiviert sind.

- anpassenDie Rust-Version unterstützt eine Befehlszeilenschnittstelle:

cd kyuteye_rs

cargo run --bin moshi-cli -r -- tui --host localhost

grafisches Verständnis

- umziehenUpload eines Bildes über die Weboberfläche oder Angabe eines Pfades über eine Befehlszeile:

python -m moshi_mlx.server -q 8 --image path/to/image.jpg

- RiggLaden Sie es hoch und sagen Sie: "Was ist das?" Das Modell wird es phonetisch beschreiben, z. B. "Es ist ein Bild von einem blauen Himmel mit weißen Wolken".

- CharakterisierungBasierend auf dem PaliGemma2-Encoder erkennt es Objekte, Farben und Szenen.

Modell-Anpassung

- umziehenDownload anderer Gewichte von Hugging Face (z.B.

kyutai/moshika-vis-mlx-bf16), ersetzen Sie den Pfad in der Konfigurationsdatei. - RiggModifikation

configs/moshika-vis.yamlvielleichtconfig-moshika-vis.jsonstarten Sie den Dienst neu. - verwenden.Einstellen des Sprachstils oder Optimieren der Leistung.

Vollständiger Betrieb Verfahren

- Backend auswählenWählen Sie PyTorch (GPU), Rust (plattformübergreifend) oder MLX (Mac), je nach Ihrem Gerät.

- InstallationsumgebungInstallieren Sie die Abhängigkeiten und Modelle gemäß dem obigen Befehl.

- Neue Dienste: Starten Sie das Backend und warten Sie, bis der Dienst bereit ist.

- Anschluss SchnittstelleZugriff auf den angegebenen Port mit Ihrem Browser.

- Test StimmeEinfache Sätze sagen und Antworten überprüfen.

- TestbilderBilder hochladen und Fragen per Stimme stellen.

- Optimierungseinstellungen: Anpassung der Quantisierungsparameter (

-q 4vielleicht-q 8) oder Portnummer.

caveat

- Für HTTPS ist ein SSL-Zertifikat erforderlich, andernfalls können die Browser den Mikrofonzugriff einschränken.

- Die Quantisierung wird in PyTorch nicht unterstützt und erfordert einen leistungsstarken Grafikprozessor.

- Die Kompilierung der Rust-Version nimmt einige Zeit in Anspruch, daher sollten Sie beim ersten Start etwas Geduld haben.

- MLX-Version stabil getestet auf M3 MacBook Pro, empfohlen für Mac-Benutzer.

Anwendungsszenario

- Pädagogische Unterstützung

Die Schülerinnen und Schüler laden Bilder aus dem Lehrbuch hoch und MoshiVis erklärt den Inhalt mit Hilfe von Audiodateien, z. B. "Dies ist ein Diagramm einer Zellstruktur, das den Zellkern und die Mitochondrien zeigt." - Hilfe bei der Erreichbarkeit

Sehbehinderte Nutzerinnen und Nutzer luden täglich Fotos von Modellen hoch, die beschreiben, dass dies ein Supermarktregal voller Milch und Brot ist". - Entwicklungsexperiment

Entwickler nutzen es, um Sprachassistenten zu entwickeln, die in intelligente Geräte zur Bildinteraktion integriert werden.

QA

- Unterstützt MoshiVis die Offline-Nutzung?

Ja. Nach der Installation werden alle Funktionen lokal ausgeführt, ohne dass eine Internetverbindung erforderlich ist. - Unterstützt Voice mehrere Sprachen?

Derzeit werden hauptsächlich englische Dialoge und Beschreibungen unterstützt, mit eingeschränkter Funktionalität in anderen Sprachen. - Funktioniert ein Low-Profile-Computer?

Die MLX-Version läuft auf einem normalen Mac, und die PyTorch-Version benötigt 24 GB GPU-Speicher.

© urheberrechtliche Erklärung

Artikel Copyright AI-Austauschkreis Alle, bitte nicht ohne Erlaubnis vervielfältigen.

Ähnliche Artikel

Keine Kommentare...